Google dévoile une nouvelle puce pour réduire le coût d'IA caché majeur

À l'événement Google Cloud Next 25, Google a dévoilé la dernière version de son unité de traitement tensoriel (TPU), nommée Ironwood. Cette nouvelle puce marque un changement significatif pour Google, mettant l'accent sur l'inférence plutôt que sur l'entraînement. Traditionnellement, les TPU étaient utilisées pour entraîner des réseaux neuronaux, un processus dominé par les spécialistes de l'IA et les data scientists. Cependant, avec Ironwood, Google cible désormais les besoins de prédiction en temps réel de millions, voire de milliards d'utilisateurs.

TPU Ironwood

Le lancement de la TPU Ironwood intervient à un moment crucial dans l'industrie de l'IA, où l'accent passe des projets expérimentaux aux applications pratiques des modèles d'IA par les entreprises. L'émergence de modèles d'IA avancés comme Gemini de Google, qui améliorent les capacités de raisonnement, a accru la demande de puissance de calcul pour l'inférence. Ce changement augmente les coûts, comme Google l'a souligné dans sa description d'Ironwood : « le raisonnement et l'inférence multi-étapes déplacent la demande croissante de calcul — et donc de coût — de l'entraînement vers le temps d'inférence (échelle de test). » Ironwood représente l'engagement de Google à optimiser les performances et l'efficacité, en particulier dans le domaine de plus en plus coûteux de l'inférence.

Une puce d'inférence

Le parcours de Google avec les TPU s'étend sur plus d'une décennie, avec six générations précédant Ironwood. Alors que les puces d'entraînement sont produites en plus faibles volumes, les puces d'inférence s'adressent à un public plus large ayant besoin de prédictions quotidiennes à partir de modèles entraînés, ce qui en fait un marché à fort volume. Auparavant, la TPU de sixième génération de Google, Trillium, était présentée comme capable à la fois d'entraînement et d'inférence. Cependant, l'accent principal d'Ironwood sur l'inférence marque un changement notable par rapport à cette approche à double usage.

Investissement nécessaire

Ce changement de focus pourrait signaler une modification de la dépendance de Google envers des fabricants de puces externes comme Intel, AMD et Nvidia. Historiquement, ces fournisseurs ont dominé les opérations d'informatique en nuage de Google, représentant 99 % des processeurs utilisés, selon KeyBanc Capital Markets. En investissant dans ses propres TPU, Google pourrait chercher à réduire sa dépendance envers ces fournisseurs et potentiellement économiser sur les coûts croissants de l'infrastructure IA. Les analystes boursiers, comme Gil Luria de DA Davidson, ont estimé que si Google vendait des TPU directement aux clients de Nvidia, il aurait pu générer jusqu'à 24 milliards de dollars de revenus l'année dernière.

Ironwood vs Trillium

Google a présenté la supériorité technique d'Ironwood par rapport à Trillium lors de l'événement. Ironwood offre deux fois plus de performance par watt, atteignant 29,3 trillions d'opérations en virgule flottante par seconde. Elle dispose également de 192 Go de mémoire à large bande passante (HBM), six fois plus que Trillium, et d'une bande passante mémoire de 7,2 térabits par seconde, soit 4,5 fois supérieure. Ces améliorations sont conçues pour faciliter un plus grand mouvement de données et réduire la latence sur la puce lors des manipulations de tenseurs, comme Google l'a déclaré : « Ironwood est conçu pour minimiser le mouvement de données et la latence sur la puce tout en effectuant des manipulations massives de tenseurs. »

Expansion de l'infrastructure IA

Les avancées en matière de mémoire et de bande passante sont au cœur de la stratégie de Google pour développer son infrastructure IA. La mise à l'échelle implique l'utilisation efficace de puces groupées pour résoudre des problèmes en parallèle, améliorant les performances et l'utilisation. Cela est crucial pour des raisons économiques, car une utilisation plus élevée signifie moins de gaspillage de ressources coûteuses. Google a précédemment mis en avant la capacité de Trillium à s'étendre à des centaines de milliers de puces, et de manière similaire, ils ont souligné la capacité d'Ironwood à composer « des centaines de milliers de puces Ironwood pour faire progresser rapidement les frontières du calcul GenAI. »

Parallèlement à l'annonce matérielle, Google a également présenté Pathways on Cloud, une solution logicielle qui répartit les tâches de calcul IA sur différentes machines. Auparavant utilisée en interne, ce logiciel est désormais accessible au public, renforçant encore les capacités de l'infrastructure IA de Google.

Article connexe

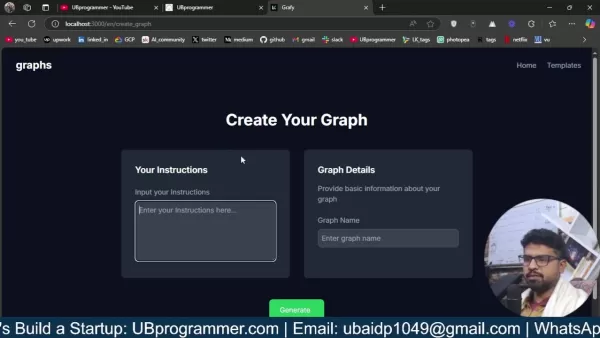

Générer facilement des graphiques et des visualisations alimentés par l'IA pour une meilleure compréhension des données

L'analyse moderne des données exige une visualisation intuitive des informations complexes. Les solutions de génération de graphiques alimentées par l'IA sont devenues des atouts indispensables, révol

Générer facilement des graphiques et des visualisations alimentés par l'IA pour une meilleure compréhension des données

L'analyse moderne des données exige une visualisation intuitive des informations complexes. Les solutions de génération de graphiques alimentées par l'IA sont devenues des atouts indispensables, révol

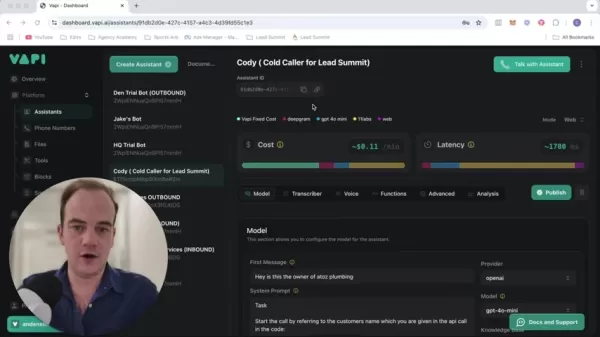

Transformez votre stratégie de vente : La technologie AI Cold Calling développée par Vapi

Les entreprises modernes fonctionnent à la vitesse de l'éclair et exigent des solutions innovantes pour rester compétitives. Imaginez que vous puissiez révolutionner le travail d'approche de votre age

Transformez votre stratégie de vente : La technologie AI Cold Calling développée par Vapi

Les entreprises modernes fonctionnent à la vitesse de l'éclair et exigent des solutions innovantes pour rester compétitives. Imaginez que vous puissiez révolutionner le travail d'approche de votre age

Les meilleurs outils d'IA pour créer des infographies éducatives - Conseils et techniques de conception

Dans le paysage éducatif actuel, dominé par le numérique, les infographies se sont imposées comme un moyen de communication transformateur qui convertit des informations complexes en formats visuellem

commentaires (18)

0/200

Les meilleurs outils d'IA pour créer des infographies éducatives - Conseils et techniques de conception

Dans le paysage éducatif actuel, dominé par le numérique, les infographies se sont imposées comme un moyen de communication transformateur qui convertit des informations complexes en formats visuellem

commentaires (18)

0/200

![JustinKing]() JustinKing

JustinKing

28 août 2025 03:01:29 UTC+02:00

28 août 2025 03:01:29 UTC+02:00

Wow, Google's Ironwood TPU sounds like a game-changer for AI inference! Focusing on efficiency could really shake up the cost dynamics. Curious how this stacks against NVIDIA’s offerings—any bets on who’ll dominate the market? 😎

0

0

![EllaJohnson]() EllaJohnson

EllaJohnson

15 août 2025 23:00:59 UTC+02:00

15 août 2025 23:00:59 UTC+02:00

Whoa, Google's Ironwood TPU sounds like a game-changer for AI inference! Cutting costs like that could really shake up the cloud market. Anyone else curious how this stacks up against Nvidia’s gear? 🤔

0

0

![RalphSanchez]() RalphSanchez

RalphSanchez

15 août 2025 01:01:00 UTC+02:00

15 août 2025 01:01:00 UTC+02:00

Google's new Ironwood chip sounds like a game-changer for AI inference! 🚀 Excited to see how it cuts costs and boosts efficiency.

0

0

![GaryGonzalez]() GaryGonzalez

GaryGonzalez

24 avril 2025 09:26:40 UTC+02:00

24 avril 2025 09:26:40 UTC+02:00

Googleの新しいIronwood TPUはAIコストを変えるものですね!今は推論に重点を置いているのがかっこいいけど、トレーニングの側面も気になります。でも、隠れたコストを削減できるなら賛成です。トレーニング部分も改善し続けてほしいですね!🤞

0

0

![WalterWalker]() WalterWalker

WalterWalker

24 avril 2025 06:26:10 UTC+02:00

24 avril 2025 06:26:10 UTC+02:00

Googleの新しいTPU、Ironwoodは推論タスクに革命をもたらす!効率化に焦点を当てるのは素晴らしいですね。ただ、古いモデルと互換性がないのがちょっと残念。将来のAI開発に期待しています!🤖

0

0

![ChristopherAllen]() ChristopherAllen

ChristopherAllen

24 avril 2025 03:03:04 UTC+02:00

24 avril 2025 03:03:04 UTC+02:00

La nueva TPU de Google, Ironwood, es increíble para tareas de inferencia. ¡Me encanta que se estén enfocando en la eficiencia! Aunque me molesta un poco que no sea compatible con modelos anteriores. ¡Espero ver más avances pronto! 🚀

0

0

À l'événement Google Cloud Next 25, Google a dévoilé la dernière version de son unité de traitement tensoriel (TPU), nommée Ironwood. Cette nouvelle puce marque un changement significatif pour Google, mettant l'accent sur l'inférence plutôt que sur l'entraînement. Traditionnellement, les TPU étaient utilisées pour entraîner des réseaux neuronaux, un processus dominé par les spécialistes de l'IA et les data scientists. Cependant, avec Ironwood, Google cible désormais les besoins de prédiction en temps réel de millions, voire de milliards d'utilisateurs.

TPU Ironwood

Le lancement de la TPU Ironwood intervient à un moment crucial dans l'industrie de l'IA, où l'accent passe des projets expérimentaux aux applications pratiques des modèles d'IA par les entreprises. L'émergence de modèles d'IA avancés comme Gemini de Google, qui améliorent les capacités de raisonnement, a accru la demande de puissance de calcul pour l'inférence. Ce changement augmente les coûts, comme Google l'a souligné dans sa description d'Ironwood : « le raisonnement et l'inférence multi-étapes déplacent la demande croissante de calcul — et donc de coût — de l'entraînement vers le temps d'inférence (échelle de test). » Ironwood représente l'engagement de Google à optimiser les performances et l'efficacité, en particulier dans le domaine de plus en plus coûteux de l'inférence.

Une puce d'inférence

Le parcours de Google avec les TPU s'étend sur plus d'une décennie, avec six générations précédant Ironwood. Alors que les puces d'entraînement sont produites en plus faibles volumes, les puces d'inférence s'adressent à un public plus large ayant besoin de prédictions quotidiennes à partir de modèles entraînés, ce qui en fait un marché à fort volume. Auparavant, la TPU de sixième génération de Google, Trillium, était présentée comme capable à la fois d'entraînement et d'inférence. Cependant, l'accent principal d'Ironwood sur l'inférence marque un changement notable par rapport à cette approche à double usage.

Investissement nécessaire

Ce changement de focus pourrait signaler une modification de la dépendance de Google envers des fabricants de puces externes comme Intel, AMD et Nvidia. Historiquement, ces fournisseurs ont dominé les opérations d'informatique en nuage de Google, représentant 99 % des processeurs utilisés, selon KeyBanc Capital Markets. En investissant dans ses propres TPU, Google pourrait chercher à réduire sa dépendance envers ces fournisseurs et potentiellement économiser sur les coûts croissants de l'infrastructure IA. Les analystes boursiers, comme Gil Luria de DA Davidson, ont estimé que si Google vendait des TPU directement aux clients de Nvidia, il aurait pu générer jusqu'à 24 milliards de dollars de revenus l'année dernière.

Ironwood vs Trillium

Google a présenté la supériorité technique d'Ironwood par rapport à Trillium lors de l'événement. Ironwood offre deux fois plus de performance par watt, atteignant 29,3 trillions d'opérations en virgule flottante par seconde. Elle dispose également de 192 Go de mémoire à large bande passante (HBM), six fois plus que Trillium, et d'une bande passante mémoire de 7,2 térabits par seconde, soit 4,5 fois supérieure. Ces améliorations sont conçues pour faciliter un plus grand mouvement de données et réduire la latence sur la puce lors des manipulations de tenseurs, comme Google l'a déclaré : « Ironwood est conçu pour minimiser le mouvement de données et la latence sur la puce tout en effectuant des manipulations massives de tenseurs. »

Expansion de l'infrastructure IA

Les avancées en matière de mémoire et de bande passante sont au cœur de la stratégie de Google pour développer son infrastructure IA. La mise à l'échelle implique l'utilisation efficace de puces groupées pour résoudre des problèmes en parallèle, améliorant les performances et l'utilisation. Cela est crucial pour des raisons économiques, car une utilisation plus élevée signifie moins de gaspillage de ressources coûteuses. Google a précédemment mis en avant la capacité de Trillium à s'étendre à des centaines de milliers de puces, et de manière similaire, ils ont souligné la capacité d'Ironwood à composer « des centaines de milliers de puces Ironwood pour faire progresser rapidement les frontières du calcul GenAI. »

Parallèlement à l'annonce matérielle, Google a également présenté Pathways on Cloud, une solution logicielle qui répartit les tâches de calcul IA sur différentes machines. Auparavant utilisée en interne, ce logiciel est désormais accessible au public, renforçant encore les capacités de l'infrastructure IA de Google.

Générer facilement des graphiques et des visualisations alimentés par l'IA pour une meilleure compréhension des données

L'analyse moderne des données exige une visualisation intuitive des informations complexes. Les solutions de génération de graphiques alimentées par l'IA sont devenues des atouts indispensables, révol

Générer facilement des graphiques et des visualisations alimentés par l'IA pour une meilleure compréhension des données

L'analyse moderne des données exige une visualisation intuitive des informations complexes. Les solutions de génération de graphiques alimentées par l'IA sont devenues des atouts indispensables, révol

Transformez votre stratégie de vente : La technologie AI Cold Calling développée par Vapi

Les entreprises modernes fonctionnent à la vitesse de l'éclair et exigent des solutions innovantes pour rester compétitives. Imaginez que vous puissiez révolutionner le travail d'approche de votre age

Transformez votre stratégie de vente : La technologie AI Cold Calling développée par Vapi

Les entreprises modernes fonctionnent à la vitesse de l'éclair et exigent des solutions innovantes pour rester compétitives. Imaginez que vous puissiez révolutionner le travail d'approche de votre age

Les meilleurs outils d'IA pour créer des infographies éducatives - Conseils et techniques de conception

Dans le paysage éducatif actuel, dominé par le numérique, les infographies se sont imposées comme un moyen de communication transformateur qui convertit des informations complexes en formats visuellem

Les meilleurs outils d'IA pour créer des infographies éducatives - Conseils et techniques de conception

Dans le paysage éducatif actuel, dominé par le numérique, les infographies se sont imposées comme un moyen de communication transformateur qui convertit des informations complexes en formats visuellem

28 août 2025 03:01:29 UTC+02:00

28 août 2025 03:01:29 UTC+02:00

Wow, Google's Ironwood TPU sounds like a game-changer for AI inference! Focusing on efficiency could really shake up the cost dynamics. Curious how this stacks against NVIDIA’s offerings—any bets on who’ll dominate the market? 😎

0

0

15 août 2025 23:00:59 UTC+02:00

15 août 2025 23:00:59 UTC+02:00

Whoa, Google's Ironwood TPU sounds like a game-changer for AI inference! Cutting costs like that could really shake up the cloud market. Anyone else curious how this stacks up against Nvidia’s gear? 🤔

0

0

15 août 2025 01:01:00 UTC+02:00

15 août 2025 01:01:00 UTC+02:00

Google's new Ironwood chip sounds like a game-changer for AI inference! 🚀 Excited to see how it cuts costs and boosts efficiency.

0

0

24 avril 2025 09:26:40 UTC+02:00

24 avril 2025 09:26:40 UTC+02:00

Googleの新しいIronwood TPUはAIコストを変えるものですね!今は推論に重点を置いているのがかっこいいけど、トレーニングの側面も気になります。でも、隠れたコストを削減できるなら賛成です。トレーニング部分も改善し続けてほしいですね!🤞

0

0

24 avril 2025 06:26:10 UTC+02:00

24 avril 2025 06:26:10 UTC+02:00

Googleの新しいTPU、Ironwoodは推論タスクに革命をもたらす!効率化に焦点を当てるのは素晴らしいですね。ただ、古いモデルと互換性がないのがちょっと残念。将来のAI開発に期待しています!🤖

0

0

24 avril 2025 03:03:04 UTC+02:00

24 avril 2025 03:03:04 UTC+02:00

La nueva TPU de Google, Ironwood, es increíble para tareas de inferencia. ¡Me encanta que se estén enfocando en la eficiencia! Aunque me molesta un poco que no sea compatible con modelos anteriores. ¡Espero ver más avances pronto! 🚀

0

0