Google presenta un nuevo chip para cortar el costo de IA oculto mayor

En el evento Google Cloud Next 25, Google presentó la última iteración de su Unidad de Procesamiento de Tensores (TPU), llamada Ironwood. Este nuevo chip marca un cambio significativo en el enfoque de Google, enfatizando su uso para inferencia en lugar de entrenamiento. Tradicionalmente, las TPUs se han utilizado para entrenar redes neuronales, un proceso dominado por especialistas en AI y científicos de datos. Sin embargo, con Ironwood, Google ahora apunta a las necesidades de predicción en tiempo real de millones, si no miles de millones, de usuarios.

TPU Ironwood

El lanzamiento del TPU Ironwood llega en un momento crucial en la industria de la AI, donde el enfoque está cambiando de proyectos experimentales a aplicaciones prácticas de modelos de AI por parte de las empresas. La aparición de modelos de AI avanzados como Gemini de Google, que mejoran las capacidades de razonamiento, ha aumentado la demanda de potencia computacional durante la inferencia. Este cambio está elevando los costos, como destacó Google en su descripción de Ironwood: "el razonamiento y la inferencia en múltiples pasos están trasladando la demanda incremental de computación —y, por lo tanto, el costo— del entrenamiento al tiempo de inferencia (escalado en tiempo de prueba)." Ironwood representa el compromiso de Google con optimizar el rendimiento y la eficiencia, particularmente en el dominio cada vez más costoso de la inferencia.

Un chip de inferencia

El recorrido de Google con las TPUs abarca más de una década, con seis generaciones anteriores a Ironwood. Mientras que los chips de entrenamiento se producen en volúmenes más bajos, los chips de inferencia atienden a una audiencia más amplia que necesita predicciones diarias de modelos entrenados, lo que lo convierte en un mercado de alto volumen. Anteriormente, la TPU de sexta generación de Google, Trillium, se posicionó como capaz de realizar tanto entrenamiento como inferencia. Sin embargo, el enfoque principal de Ironwood en la inferencia marca una notable desviación de este enfoque de doble propósito.

Inversión necesaria

Este cambio de enfoque podría indicar un cambio en la dependencia de Google de fabricantes de chips externos como Intel, AMD y Nvidia. Históricamente, estos proveedores han dominado las operaciones de computación en la nube de Google, representando el 99% de los procesadores utilizados, según KeyBanc Capital Markets. Al invertir en sus propias TPUs, Google podría estar buscando reducir su dependencia de estos proveedores y potencialmente ahorrar en los crecientes costos de la infraestructura de AI. Analistas de bolsa, como Gil Luria de DA Davidson, han estimado que si Google vendiera TPUs directamente a los clientes de Nvidia, podría haber generado hasta $24 mil millones en ingresos el año pasado.

Ironwood vs. Trillium

Google destacó la superioridad técnica de Ironwood sobre Trillium en el evento. Ironwood cuenta con el doble de rendimiento por vatio, logrando 29.3 billones de operaciones de punto flotante por segundo. También cuenta con 192GB de memoria de alto ancho de banda (HBM), seis veces más que Trillium, y un ancho de banda de memoria de 7.2 terabits por segundo, que es 4.5 veces mayor. Estas mejoras están diseñadas para facilitar un mayor movimiento de datos y reducir la latencia en el chip durante las manipulaciones de tensores, como afirmó Google, "Ironwood está diseñado para minimizar el movimiento de datos y la latencia en el chip mientras realiza manipulaciones masivas de tensores."

Escalando la infraestructura de AI

Los avances en memoria y ancho de banda son centrales en la estrategia de Google para escalar su infraestructura de AI. Escalar implica utilizar eficientemente chips agrupados para resolver problemas en paralelo, mejorando el rendimiento y la utilización. Esto es crucial por razones económicas, ya que una mayor utilización significa menos desperdicio de recursos costosos. Google previamente destacó la capacidad de Trillium para escalar a cientos de miles de chips, y de manera similar, enfatizaron la capacidad de Ironwood para componer "cientos de miles de chips Ironwood para avanzar rápidamente en las fronteras de la computación GenAI."

Junto con el anuncio de hardware, Google también presentó Pathways on Cloud, una solución de software que distribuye tareas de computación de AI en diferentes máquinas. Anteriormente utilizada internamente, este software ahora está disponible para el público, mejorando aún más las capacidades de la infraestructura de AI de Google.

Artículo relacionado

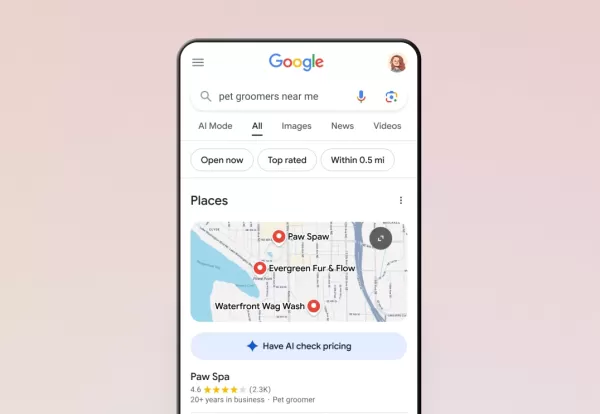

La IA de Google ya gestiona las llamadas telefónicas por ti

Google ha ampliado a todos los usuarios de EE.UU. su función de llamadas con inteligencia artificial a través de la Búsqueda, lo que permite a los clientes consultar precios y disponibilidad con empre

La IA de Google ya gestiona las llamadas telefónicas por ti

Google ha ampliado a todos los usuarios de EE.UU. su función de llamadas con inteligencia artificial a través de la Búsqueda, lo que permite a los clientes consultar precios y disponibilidad con empre

Trump exime a smartphones, ordenadores y chips de la subida de aranceles

La administración Trump ha concedido exclusiones para smartphones, ordenadores y diversos dispositivos electrónicos de las recientes subidas de aranceles, incluso cuando se importan de China, según in

Trump exime a smartphones, ordenadores y chips de la subida de aranceles

La administración Trump ha concedido exclusiones para smartphones, ordenadores y diversos dispositivos electrónicos de las recientes subidas de aranceles, incluso cuando se importan de China, según in

La IA reimagina a Michael Jackson en el metaverso con asombrosas transformaciones digitales

La inteligencia artificial está cambiando radicalmente nuestra forma de entender la creatividad, el entretenimiento y el legado cultural. Esta exploración de las interpretaciones de Michael Jackson ge

comentario (18)

0/200

La IA reimagina a Michael Jackson en el metaverso con asombrosas transformaciones digitales

La inteligencia artificial está cambiando radicalmente nuestra forma de entender la creatividad, el entretenimiento y el legado cultural. Esta exploración de las interpretaciones de Michael Jackson ge

comentario (18)

0/200

![JustinKing]() JustinKing

JustinKing

28 de agosto de 2025 03:01:29 GMT+02:00

28 de agosto de 2025 03:01:29 GMT+02:00

Wow, Google's Ironwood TPU sounds like a game-changer for AI inference! Focusing on efficiency could really shake up the cost dynamics. Curious how this stacks against NVIDIA’s offerings—any bets on who’ll dominate the market? 😎

0

0

![EllaJohnson]() EllaJohnson

EllaJohnson

15 de agosto de 2025 23:00:59 GMT+02:00

15 de agosto de 2025 23:00:59 GMT+02:00

Whoa, Google's Ironwood TPU sounds like a game-changer for AI inference! Cutting costs like that could really shake up the cloud market. Anyone else curious how this stacks up against Nvidia’s gear? 🤔

0

0

![RalphSanchez]() RalphSanchez

RalphSanchez

15 de agosto de 2025 01:01:00 GMT+02:00

15 de agosto de 2025 01:01:00 GMT+02:00

Google's new Ironwood chip sounds like a game-changer for AI inference! 🚀 Excited to see how it cuts costs and boosts efficiency.

0

0

![GaryGonzalez]() GaryGonzalez

GaryGonzalez

24 de abril de 2025 09:26:40 GMT+02:00

24 de abril de 2025 09:26:40 GMT+02:00

Googleの新しいIronwood TPUはAIコストを変えるものですね!今は推論に重点を置いているのがかっこいいけど、トレーニングの側面も気になります。でも、隠れたコストを削減できるなら賛成です。トレーニング部分も改善し続けてほしいですね!🤞

0

0

![WalterWalker]() WalterWalker

WalterWalker

24 de abril de 2025 06:26:10 GMT+02:00

24 de abril de 2025 06:26:10 GMT+02:00

Googleの新しいTPU、Ironwoodは推論タスクに革命をもたらす!効率化に焦点を当てるのは素晴らしいですね。ただ、古いモデルと互換性がないのがちょっと残念。将来のAI開発に期待しています!🤖

0

0

![ChristopherAllen]() ChristopherAllen

ChristopherAllen

24 de abril de 2025 03:03:04 GMT+02:00

24 de abril de 2025 03:03:04 GMT+02:00

La nueva TPU de Google, Ironwood, es increíble para tareas de inferencia. ¡Me encanta que se estén enfocando en la eficiencia! Aunque me molesta un poco que no sea compatible con modelos anteriores. ¡Espero ver más avances pronto! 🚀

0

0

En el evento Google Cloud Next 25, Google presentó la última iteración de su Unidad de Procesamiento de Tensores (TPU), llamada Ironwood. Este nuevo chip marca un cambio significativo en el enfoque de Google, enfatizando su uso para inferencia en lugar de entrenamiento. Tradicionalmente, las TPUs se han utilizado para entrenar redes neuronales, un proceso dominado por especialistas en AI y científicos de datos. Sin embargo, con Ironwood, Google ahora apunta a las necesidades de predicción en tiempo real de millones, si no miles de millones, de usuarios.

TPU Ironwood

El lanzamiento del TPU Ironwood llega en un momento crucial en la industria de la AI, donde el enfoque está cambiando de proyectos experimentales a aplicaciones prácticas de modelos de AI por parte de las empresas. La aparición de modelos de AI avanzados como Gemini de Google, que mejoran las capacidades de razonamiento, ha aumentado la demanda de potencia computacional durante la inferencia. Este cambio está elevando los costos, como destacó Google en su descripción de Ironwood: "el razonamiento y la inferencia en múltiples pasos están trasladando la demanda incremental de computación —y, por lo tanto, el costo— del entrenamiento al tiempo de inferencia (escalado en tiempo de prueba)." Ironwood representa el compromiso de Google con optimizar el rendimiento y la eficiencia, particularmente en el dominio cada vez más costoso de la inferencia.

Un chip de inferencia

El recorrido de Google con las TPUs abarca más de una década, con seis generaciones anteriores a Ironwood. Mientras que los chips de entrenamiento se producen en volúmenes más bajos, los chips de inferencia atienden a una audiencia más amplia que necesita predicciones diarias de modelos entrenados, lo que lo convierte en un mercado de alto volumen. Anteriormente, la TPU de sexta generación de Google, Trillium, se posicionó como capaz de realizar tanto entrenamiento como inferencia. Sin embargo, el enfoque principal de Ironwood en la inferencia marca una notable desviación de este enfoque de doble propósito.

Inversión necesaria

Este cambio de enfoque podría indicar un cambio en la dependencia de Google de fabricantes de chips externos como Intel, AMD y Nvidia. Históricamente, estos proveedores han dominado las operaciones de computación en la nube de Google, representando el 99% de los procesadores utilizados, según KeyBanc Capital Markets. Al invertir en sus propias TPUs, Google podría estar buscando reducir su dependencia de estos proveedores y potencialmente ahorrar en los crecientes costos de la infraestructura de AI. Analistas de bolsa, como Gil Luria de DA Davidson, han estimado que si Google vendiera TPUs directamente a los clientes de Nvidia, podría haber generado hasta $24 mil millones en ingresos el año pasado.

Ironwood vs. Trillium

Google destacó la superioridad técnica de Ironwood sobre Trillium en el evento. Ironwood cuenta con el doble de rendimiento por vatio, logrando 29.3 billones de operaciones de punto flotante por segundo. También cuenta con 192GB de memoria de alto ancho de banda (HBM), seis veces más que Trillium, y un ancho de banda de memoria de 7.2 terabits por segundo, que es 4.5 veces mayor. Estas mejoras están diseñadas para facilitar un mayor movimiento de datos y reducir la latencia en el chip durante las manipulaciones de tensores, como afirmó Google, "Ironwood está diseñado para minimizar el movimiento de datos y la latencia en el chip mientras realiza manipulaciones masivas de tensores."

Escalando la infraestructura de AI

Los avances en memoria y ancho de banda son centrales en la estrategia de Google para escalar su infraestructura de AI. Escalar implica utilizar eficientemente chips agrupados para resolver problemas en paralelo, mejorando el rendimiento y la utilización. Esto es crucial por razones económicas, ya que una mayor utilización significa menos desperdicio de recursos costosos. Google previamente destacó la capacidad de Trillium para escalar a cientos de miles de chips, y de manera similar, enfatizaron la capacidad de Ironwood para componer "cientos de miles de chips Ironwood para avanzar rápidamente en las fronteras de la computación GenAI."

Junto con el anuncio de hardware, Google también presentó Pathways on Cloud, una solución de software que distribuye tareas de computación de AI en diferentes máquinas. Anteriormente utilizada internamente, este software ahora está disponible para el público, mejorando aún más las capacidades de la infraestructura de AI de Google.

La IA de Google ya gestiona las llamadas telefónicas por ti

Google ha ampliado a todos los usuarios de EE.UU. su función de llamadas con inteligencia artificial a través de la Búsqueda, lo que permite a los clientes consultar precios y disponibilidad con empre

La IA de Google ya gestiona las llamadas telefónicas por ti

Google ha ampliado a todos los usuarios de EE.UU. su función de llamadas con inteligencia artificial a través de la Búsqueda, lo que permite a los clientes consultar precios y disponibilidad con empre

Trump exime a smartphones, ordenadores y chips de la subida de aranceles

La administración Trump ha concedido exclusiones para smartphones, ordenadores y diversos dispositivos electrónicos de las recientes subidas de aranceles, incluso cuando se importan de China, según in

Trump exime a smartphones, ordenadores y chips de la subida de aranceles

La administración Trump ha concedido exclusiones para smartphones, ordenadores y diversos dispositivos electrónicos de las recientes subidas de aranceles, incluso cuando se importan de China, según in

La IA reimagina a Michael Jackson en el metaverso con asombrosas transformaciones digitales

La inteligencia artificial está cambiando radicalmente nuestra forma de entender la creatividad, el entretenimiento y el legado cultural. Esta exploración de las interpretaciones de Michael Jackson ge

La IA reimagina a Michael Jackson en el metaverso con asombrosas transformaciones digitales

La inteligencia artificial está cambiando radicalmente nuestra forma de entender la creatividad, el entretenimiento y el legado cultural. Esta exploración de las interpretaciones de Michael Jackson ge

28 de agosto de 2025 03:01:29 GMT+02:00

28 de agosto de 2025 03:01:29 GMT+02:00

Wow, Google's Ironwood TPU sounds like a game-changer for AI inference! Focusing on efficiency could really shake up the cost dynamics. Curious how this stacks against NVIDIA’s offerings—any bets on who’ll dominate the market? 😎

0

0

15 de agosto de 2025 23:00:59 GMT+02:00

15 de agosto de 2025 23:00:59 GMT+02:00

Whoa, Google's Ironwood TPU sounds like a game-changer for AI inference! Cutting costs like that could really shake up the cloud market. Anyone else curious how this stacks up against Nvidia’s gear? 🤔

0

0

15 de agosto de 2025 01:01:00 GMT+02:00

15 de agosto de 2025 01:01:00 GMT+02:00

Google's new Ironwood chip sounds like a game-changer for AI inference! 🚀 Excited to see how it cuts costs and boosts efficiency.

0

0

24 de abril de 2025 09:26:40 GMT+02:00

24 de abril de 2025 09:26:40 GMT+02:00

Googleの新しいIronwood TPUはAIコストを変えるものですね!今は推論に重点を置いているのがかっこいいけど、トレーニングの側面も気になります。でも、隠れたコストを削減できるなら賛成です。トレーニング部分も改善し続けてほしいですね!🤞

0

0

24 de abril de 2025 06:26:10 GMT+02:00

24 de abril de 2025 06:26:10 GMT+02:00

Googleの新しいTPU、Ironwoodは推論タスクに革命をもたらす!効率化に焦点を当てるのは素晴らしいですね。ただ、古いモデルと互換性がないのがちょっと残念。将来のAI開発に期待しています!🤖

0

0

24 de abril de 2025 03:03:04 GMT+02:00

24 de abril de 2025 03:03:04 GMT+02:00

La nueva TPU de Google, Ironwood, es increíble para tareas de inferencia. ¡Me encanta que se estén enfocando en la eficiencia! Aunque me molesta un poco que no sea compatible con modelos anteriores. ¡Espero ver más avances pronto! 🚀

0

0