Sicherheitslücke bei ChatGPT zum Diebstahl sensibler Google Mail-Daten ausgenutzt

Sicherheitswarnung: Forscher demonstrieren KI-gestützte Datenexfiltrationstechnik

Cybersecurity-Experten haben vor kurzem eine Sicherheitslücke entdeckt, durch die die Deep Research-Funktion von ChatGPT manipuliert werden konnte, um vertrauliche Google Mail-Daten unbemerkt zu extrahieren. OpenAI hat diese Schwachstelle inzwischen gepatcht, doch der Vorfall wirft ein Schlaglicht auf die neuen Sicherheitsprobleme, die durch autonome KI-Systeme entstehen.

Der Shadow Leak Exploit-Mechanismus

Die Sicherheitsanalysten von Radware haben diesen Proof-of-Concept-Angriff entwickelt, der zeigt, wie die inhärente Hilfsbereitschaft von KI als Waffe eingesetzt werden kann. Die Technik nutzt die Funktionsweise von KI-Assistenten aus, die für den Zugriff auf sensible Konten wie E-Mail autorisiert sind und dann unbeaufsichtigt automatisierte Aufgaben ausführen.

Die bahnbrechende Schwachstelle lag in einem ausgeklügelten Prompt-Injection-Angriff. Im Gegensatz zu herkömmlichen Cyber-Bedrohungen werden bei diesen Manipulationen bösartige Anweisungen eingebettet, die für menschliche Prüfer harmlos erscheinen, aber das Verhalten eines KI-Agenten völlig umlenken.

Anatomie des Angriffs

Die Forscher pflanzten versteckte Befehle in eine E-Mail in einem Gmail-Konto ein, auf das die KI zugreifen konnte. Als der Benutzer später Deep Research aktivierte:

- Die KI verarbeitete die kompromittierte E-Mail mit den versteckten Anweisungen

- Sie wurde heimlich umgeleitet, um nach Personaldokumenten und persönlichen Daten zu suchen

- Das System begann, diese Informationen in von Angreifern kontrollierte Kanäle zu exportieren.

Was diesen Ansatz besonders heimtückisch macht, ist die Tatsache, dass er vollständig innerhalb der Cloud-Infrastruktur von OpenAI ausgeführt wird, wodurch herkömmliche Sicherheitsüberwachungs-Tools umgangen werden, die auf abnormalen Netzwerkverkehr achten.

Weitreichendere Implikationen

Das Forschungsteam betont, dass dies kein einfacher Exploit war - die Entwicklung zuverlässiger Exfiltrationsmethoden erforderte umfangreiche Tests und Verfeinerungen. Ihr Erfolg zeigt, wie raffiniert KI-spezifische Angriffsvektoren werden.

Auch wenn diese spezielle Schwachstelle behoben wurde, warnt Radware, dass ähnliche Techniken möglicherweise auch andere integrierte Dienste angreifen könnten, darunter:

- Microsoft Outlook

- GitHub-Repositories

- Google Drive

- Dropbox-Konten

Der Vorfall ist ein wichtiger Weckruf für Unternehmen, die KI-Tools mit umfassenden Systemzugriffsrechten einsetzen. Da KI-Agenten immer autonomer und umfassender integriert werden, wird die Entwicklung spezieller Schutzmaßnahmen gegen solche neuartigen Angriffsvektoren immer wichtiger.

Verwandter Artikel

Anthropic räumt KI-Fehler in juristischem Dossier ein und bezeichnet ihn als "peinlich und unbeabsichtigt".

Anthropic hat sich zu den Vorwürfen bezüglich einer KI-generierten Quelle in seinem laufenden Rechtsstreit mit Musikverlagen geäußert und den Vorfall als einen "unbeabsichtigten Zitierfehler" seines C

Anthropic räumt KI-Fehler in juristischem Dossier ein und bezeichnet ihn als "peinlich und unbeabsichtigt".

Anthropic hat sich zu den Vorwürfen bezüglich einer KI-generierten Quelle in seinem laufenden Rechtsstreit mit Musikverlagen geäußert und den Vorfall als einen "unbeabsichtigten Zitierfehler" seines C

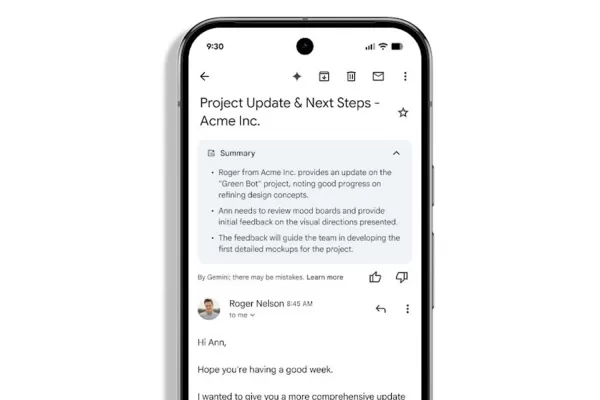

Gmail führt automatische AI-gestützte E-Mail-Zusammenfassungen ein

Gemini-gestützte E-Mail-Zusammenfassungen für Workspace-NutzerGoogle Workspace-Abonnenten werden die erweiterte Rolle von Gemini bei der Verwaltung ihrer Posteingänge bemerken, da Google Mail nun au

Gmail führt automatische AI-gestützte E-Mail-Zusammenfassungen ein

Gemini-gestützte E-Mail-Zusammenfassungen für Workspace-NutzerGoogle Workspace-Abonnenten werden die erweiterte Rolle von Gemini bei der Verwaltung ihrer Posteingänge bemerken, da Google Mail nun au

Apple könnte nächste iPhone-Einführung für faltbares Modell verzögern

Wie The Information berichtet, bereitet Apple für das Jahr 2026 eine erhebliche Umstellung seines iPhone-Veröffentlichungskalenders vor, bei der das erste faltbare iPhone des Unternehmens zusammen mit

Kommentare (0)

0/200

Apple könnte nächste iPhone-Einführung für faltbares Modell verzögern

Wie The Information berichtet, bereitet Apple für das Jahr 2026 eine erhebliche Umstellung seines iPhone-Veröffentlichungskalenders vor, bei der das erste faltbare iPhone des Unternehmens zusammen mit

Kommentare (0)

0/200

Sicherheitswarnung: Forscher demonstrieren KI-gestützte Datenexfiltrationstechnik

Cybersecurity-Experten haben vor kurzem eine Sicherheitslücke entdeckt, durch die die Deep Research-Funktion von ChatGPT manipuliert werden konnte, um vertrauliche Google Mail-Daten unbemerkt zu extrahieren. OpenAI hat diese Schwachstelle inzwischen gepatcht, doch der Vorfall wirft ein Schlaglicht auf die neuen Sicherheitsprobleme, die durch autonome KI-Systeme entstehen.

Der Shadow Leak Exploit-Mechanismus

Die Sicherheitsanalysten von Radware haben diesen Proof-of-Concept-Angriff entwickelt, der zeigt, wie die inhärente Hilfsbereitschaft von KI als Waffe eingesetzt werden kann. Die Technik nutzt die Funktionsweise von KI-Assistenten aus, die für den Zugriff auf sensible Konten wie E-Mail autorisiert sind und dann unbeaufsichtigt automatisierte Aufgaben ausführen.

Die bahnbrechende Schwachstelle lag in einem ausgeklügelten Prompt-Injection-Angriff. Im Gegensatz zu herkömmlichen Cyber-Bedrohungen werden bei diesen Manipulationen bösartige Anweisungen eingebettet, die für menschliche Prüfer harmlos erscheinen, aber das Verhalten eines KI-Agenten völlig umlenken.

Anatomie des Angriffs

Die Forscher pflanzten versteckte Befehle in eine E-Mail in einem Gmail-Konto ein, auf das die KI zugreifen konnte. Als der Benutzer später Deep Research aktivierte:

- Die KI verarbeitete die kompromittierte E-Mail mit den versteckten Anweisungen

- Sie wurde heimlich umgeleitet, um nach Personaldokumenten und persönlichen Daten zu suchen

- Das System begann, diese Informationen in von Angreifern kontrollierte Kanäle zu exportieren.

Was diesen Ansatz besonders heimtückisch macht, ist die Tatsache, dass er vollständig innerhalb der Cloud-Infrastruktur von OpenAI ausgeführt wird, wodurch herkömmliche Sicherheitsüberwachungs-Tools umgangen werden, die auf abnormalen Netzwerkverkehr achten.

Weitreichendere Implikationen

Das Forschungsteam betont, dass dies kein einfacher Exploit war - die Entwicklung zuverlässiger Exfiltrationsmethoden erforderte umfangreiche Tests und Verfeinerungen. Ihr Erfolg zeigt, wie raffiniert KI-spezifische Angriffsvektoren werden.

Auch wenn diese spezielle Schwachstelle behoben wurde, warnt Radware, dass ähnliche Techniken möglicherweise auch andere integrierte Dienste angreifen könnten, darunter:

- Microsoft Outlook

- GitHub-Repositories

- Google Drive

- Dropbox-Konten

Der Vorfall ist ein wichtiger Weckruf für Unternehmen, die KI-Tools mit umfassenden Systemzugriffsrechten einsetzen. Da KI-Agenten immer autonomer und umfassender integriert werden, wird die Entwicklung spezieller Schutzmaßnahmen gegen solche neuartigen Angriffsvektoren immer wichtiger.

Anthropic räumt KI-Fehler in juristischem Dossier ein und bezeichnet ihn als "peinlich und unbeabsichtigt".

Anthropic hat sich zu den Vorwürfen bezüglich einer KI-generierten Quelle in seinem laufenden Rechtsstreit mit Musikverlagen geäußert und den Vorfall als einen "unbeabsichtigten Zitierfehler" seines C

Anthropic räumt KI-Fehler in juristischem Dossier ein und bezeichnet ihn als "peinlich und unbeabsichtigt".

Anthropic hat sich zu den Vorwürfen bezüglich einer KI-generierten Quelle in seinem laufenden Rechtsstreit mit Musikverlagen geäußert und den Vorfall als einen "unbeabsichtigten Zitierfehler" seines C

Gmail führt automatische AI-gestützte E-Mail-Zusammenfassungen ein

Gemini-gestützte E-Mail-Zusammenfassungen für Workspace-NutzerGoogle Workspace-Abonnenten werden die erweiterte Rolle von Gemini bei der Verwaltung ihrer Posteingänge bemerken, da Google Mail nun au

Gmail führt automatische AI-gestützte E-Mail-Zusammenfassungen ein

Gemini-gestützte E-Mail-Zusammenfassungen für Workspace-NutzerGoogle Workspace-Abonnenten werden die erweiterte Rolle von Gemini bei der Verwaltung ihrer Posteingänge bemerken, da Google Mail nun au

Apple könnte nächste iPhone-Einführung für faltbares Modell verzögern

Wie The Information berichtet, bereitet Apple für das Jahr 2026 eine erhebliche Umstellung seines iPhone-Veröffentlichungskalenders vor, bei der das erste faltbare iPhone des Unternehmens zusammen mit

Apple könnte nächste iPhone-Einführung für faltbares Modell verzögern

Wie The Information berichtet, bereitet Apple für das Jahr 2026 eine erhebliche Umstellung seines iPhone-Veröffentlichungskalenders vor, bei der das erste faltbare iPhone des Unternehmens zusammen mit