KI-Agenten gegen große Modelle: Teamarbeit übertrifft größere Systeme allein

Die Ära der immer größer werdenden Sprachmodelle könnte einen Wendepunkt erreichen. Die Vergrößerung von LLMs hat zwar beeindruckende Fähigkeiten hervorgebracht, vom technischen Schreiben bis zum kreativen Geschichtenerzählen, aber das Paradigma verschiebt sich in Richtung nachhaltigerer und effizienterer Ansätze.

Probleme mit großen Modellen

Die versteckten Kosten der Vergrößerung

Das exponentielle Wachstum von LLMs bringt erhebliche Nachteile mit sich. Abgesehen von den finanziellen Ausgaben werfen die Umweltauswirkungen massiver Rechenressourcen dringende Fragen zur Nachhaltigkeit auf. Diese riesigen Modelle verschlingen während des Trainings Strom in der Größenordnung von Kleinstädten.

Leistungsplateaus

Entgegen den anfänglichen Hoffnungen ist die Aufstockung der Ressourcen für die Modelle keine Garantie für bessere Ergebnisse. Die Forschung zeigt, dass es eine Effizienzgrenze gibt, bei der zusätzliche Parameter nur minimale Verbesserungen bringen, während die Kosten weiter in die Höhe schnellen. Einige kompakte Modelle zeigen jetzt, dass die Qualität der Trainingsdaten oft die schiere Modellgröße übertrumpft.

Bedenken hinsichtlich der Zuverlässigkeit

Selbst die fortschrittlichsten LLMs werden von anhaltenden Problemen geplagt. Ihre undurchsichtigen Entscheidungsprozesse und ihre Tendenz zu ungenauen Ergebnissen ("Halluzinationen") machen sie zu einer bedenklichen Wahl für Anwendungen, bei denen viel auf dem Spiel steht. Ohne Einblick in ihr Innenleben wird die Überprüfung der Ergebnisse zu einer besonderen Herausforderung.

Datenknappheit in der Zukunft

Die Datenpipeline, die diese Modelle stützt, weist besorgniserregende Risse auf. Angesichts potenzieller Einschränkungen bei öffentlich zugänglichen Trainingsdaten und zunehmender Datenschutzbestimmungen könnte der grundlegende Treibstoff für immer größere Modelle bald ausgehen.

KI-Agenten verstehen

Mehr als nur Textgenerierung

Die heutigen spezialisierten Agenten stellen eine grundlegende Weiterentwicklung der einfachen LLMs dar. Diese dynamischen Systeme reagieren nicht nur auf Aufforderungen, sondern nehmen ihre digitale Umgebung aktiv wahr, analysieren sie und interagieren mit ihr über kontinuierliche Feedbackschleifen.

Wichtige Unterscheidungsfaktoren

- Zielgerichtete Autonomie: Agenten agieren unabhängig und verfolgen definierte Ziele

- Kontextabhängige Anpassungsfähigkeit: Sie passen ihre Vorgehensweise an sich ändernde Bedingungen an.

- Werkzeug-Integration: Agenten verbinden sich mit externen Systemen, um Daten zu sammeln und Maßnahmen zu ergreifen

- Entwickelndes Gedächtnis: Erfahrung informiert zukünftige Entscheidungen durch hochentwickeltes Abrufen

- Strategische Überlegungen: Fortgeschrittene Planung ersetzt die einfache Mustererkennung

Warum Teams besser arbeiten als einzelne Agenten

Der Synergievorteil

Multi-Agenten-Systeme spiegeln leistungsstarke Organisationen wider, in denen Spezialisten ihre Stärken gegenseitig ergänzen. Diese Arbeitsteilung ermöglicht sowohl konzentriertes Fachwissen als auch die Ausfallsicherheit des Systems - wenn eine Komponente ausfällt, halten die anderen die Funktionalität aufrecht.

Wichtige Systemvorteile

- Spezialisierung schafft tiefes Fachwissen in jedem Bereich

- Modularer Aufbau ermöglicht flexible Skalierung

- Verteilte Intelligenz verhindert einzelne Fehlerquellen

- Gemeinsame Problemlösung führt zu innovativen Lösungen

- Anpassungsfähigkeit als Antwort auf sich entwickelnde Herausforderungen

Koordinationsrahmen

Effektive teambasierte KI erfordert Kommunikationsprotokolle, die mit menschlichen Organisationen vergleichbar sind. Die Forscher entwickeln:

- Peer-to-Peer-Informationsnetzwerke

- Zentralisierte Überwachungssysteme

- Hybride Organisationsstrukturen

- Mechanismen zur Lösung von Konflikten

Herausforderungen und Zukunftschancen

Operative Komplexität

Die Verwaltung von Multiagentensystemen stellt neue Herausforderungen an die Organisationsgestaltung und die Ressourcenzuweisung. Teams müssen abwägen:

- Computereffizienz versus Koordinationsbedarf

- Verteilte Autonomie versus Systemkohärenz

- Skalierbarkeit versus Spezialisierungstiefe

Aufkommende Lösungen

Das Feld geht diese Probleme an durch:

- Selbst-optimierende Agentenarchitekturen

- Dynamische Lastausgleichstechniken

- Adaptive schlussfolgernde Rahmenwerke

- Prädiktive Koordinationsalgorithmen

Die Quintessenz

Die KI-Revolution tritt in ihre nächste Phase ein - weg von der rohen Skalierung hin zur intelligenten Zusammenarbeit. Teambasierte Systeme sind vielversprechend:

- Nachhaltige Rechenkapazitäten

- Spezialisierte Problemlösung

- Verlässliche verteilte Intelligenz

- Praktische Anpassungsfähigkeit in der realen Welt

Da die Forschung sich mit den aktuellen Koordinationsherausforderungen befasst, könnte dieses kollaborative Paradigma die bisher einflussreichste Entwicklung der KI darstellen - wo kollektive künstliche Intelligenz das erreicht, was kein einzelnes Modell könnte.

Verwandter Artikel

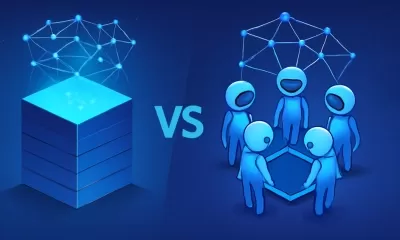

Google Startet Projekt Mariner, Seinen KI-Gestützten Web-Browsing-Agenten

Googles Projekt Mariner KI-Agent Erweitert sich mit Großen UpgradesBei Google I/O 2025 kündigte der Technologieriese bedeutende Updates für Projekt Mariner an, seinen experimentellen KI-Agenten, der e

Google Startet Projekt Mariner, Seinen KI-Gestützten Web-Browsing-Agenten

Googles Projekt Mariner KI-Agent Erweitert sich mit Großen UpgradesBei Google I/O 2025 kündigte der Technologieriese bedeutende Updates für Projekt Mariner an, seinen experimentellen KI-Agenten, der e

Airbnb führt in den USA leise einen KI-Kundenservice-Bot ein

Airbnb hebt KI-gestützten Kundenservice auf neue HöhenLetzten Monat kündigte CEO Brian Chesky während des Ergebnisberichts für das erste Quartal von Airbnb an, dass das Unternehmen in den USA mit der

Airbnb führt in den USA leise einen KI-Kundenservice-Bot ein

Airbnb hebt KI-gestützten Kundenservice auf neue HöhenLetzten Monat kündigte CEO Brian Chesky während des Ergebnisberichts für das erste Quartal von Airbnb an, dass das Unternehmen in den USA mit der

Das neue Unternehmen von Manny Medina: AI -Agenten können Erträge erzielen

Während sich die Ära der AI -Agenten entfaltet, ist ein neuer Trend, an Traktion zu gewinnen: Start -ups entstehen die wesentlichen Tools, die Unternehmen helfen, eine Belegschaft von Bots zu erstellen und zu verwalten. Manny Medina, bekannt für Gründung und früher führende Outreach, hat ein Vertriebsautomatisierungsunternehmen im Wert von 4,4 Milliarden US -Dollar.

Kommentare (0)

0/200

Das neue Unternehmen von Manny Medina: AI -Agenten können Erträge erzielen

Während sich die Ära der AI -Agenten entfaltet, ist ein neuer Trend, an Traktion zu gewinnen: Start -ups entstehen die wesentlichen Tools, die Unternehmen helfen, eine Belegschaft von Bots zu erstellen und zu verwalten. Manny Medina, bekannt für Gründung und früher führende Outreach, hat ein Vertriebsautomatisierungsunternehmen im Wert von 4,4 Milliarden US -Dollar.

Kommentare (0)

0/200

Die Ära der immer größer werdenden Sprachmodelle könnte einen Wendepunkt erreichen. Die Vergrößerung von LLMs hat zwar beeindruckende Fähigkeiten hervorgebracht, vom technischen Schreiben bis zum kreativen Geschichtenerzählen, aber das Paradigma verschiebt sich in Richtung nachhaltigerer und effizienterer Ansätze.

Probleme mit großen Modellen

Die versteckten Kosten der Vergrößerung

Das exponentielle Wachstum von LLMs bringt erhebliche Nachteile mit sich. Abgesehen von den finanziellen Ausgaben werfen die Umweltauswirkungen massiver Rechenressourcen dringende Fragen zur Nachhaltigkeit auf. Diese riesigen Modelle verschlingen während des Trainings Strom in der Größenordnung von Kleinstädten.

Leistungsplateaus

Entgegen den anfänglichen Hoffnungen ist die Aufstockung der Ressourcen für die Modelle keine Garantie für bessere Ergebnisse. Die Forschung zeigt, dass es eine Effizienzgrenze gibt, bei der zusätzliche Parameter nur minimale Verbesserungen bringen, während die Kosten weiter in die Höhe schnellen. Einige kompakte Modelle zeigen jetzt, dass die Qualität der Trainingsdaten oft die schiere Modellgröße übertrumpft.

Bedenken hinsichtlich der Zuverlässigkeit

Selbst die fortschrittlichsten LLMs werden von anhaltenden Problemen geplagt. Ihre undurchsichtigen Entscheidungsprozesse und ihre Tendenz zu ungenauen Ergebnissen ("Halluzinationen") machen sie zu einer bedenklichen Wahl für Anwendungen, bei denen viel auf dem Spiel steht. Ohne Einblick in ihr Innenleben wird die Überprüfung der Ergebnisse zu einer besonderen Herausforderung.

Datenknappheit in der Zukunft

Die Datenpipeline, die diese Modelle stützt, weist besorgniserregende Risse auf. Angesichts potenzieller Einschränkungen bei öffentlich zugänglichen Trainingsdaten und zunehmender Datenschutzbestimmungen könnte der grundlegende Treibstoff für immer größere Modelle bald ausgehen.

KI-Agenten verstehen

Mehr als nur Textgenerierung

Die heutigen spezialisierten Agenten stellen eine grundlegende Weiterentwicklung der einfachen LLMs dar. Diese dynamischen Systeme reagieren nicht nur auf Aufforderungen, sondern nehmen ihre digitale Umgebung aktiv wahr, analysieren sie und interagieren mit ihr über kontinuierliche Feedbackschleifen.

Wichtige Unterscheidungsfaktoren

- Zielgerichtete Autonomie: Agenten agieren unabhängig und verfolgen definierte Ziele

- Kontextabhängige Anpassungsfähigkeit: Sie passen ihre Vorgehensweise an sich ändernde Bedingungen an.

- Werkzeug-Integration: Agenten verbinden sich mit externen Systemen, um Daten zu sammeln und Maßnahmen zu ergreifen

- Entwickelndes Gedächtnis: Erfahrung informiert zukünftige Entscheidungen durch hochentwickeltes Abrufen

- Strategische Überlegungen: Fortgeschrittene Planung ersetzt die einfache Mustererkennung

Warum Teams besser arbeiten als einzelne Agenten

Der Synergievorteil

Multi-Agenten-Systeme spiegeln leistungsstarke Organisationen wider, in denen Spezialisten ihre Stärken gegenseitig ergänzen. Diese Arbeitsteilung ermöglicht sowohl konzentriertes Fachwissen als auch die Ausfallsicherheit des Systems - wenn eine Komponente ausfällt, halten die anderen die Funktionalität aufrecht.

Wichtige Systemvorteile

- Spezialisierung schafft tiefes Fachwissen in jedem Bereich

- Modularer Aufbau ermöglicht flexible Skalierung

- Verteilte Intelligenz verhindert einzelne Fehlerquellen

- Gemeinsame Problemlösung führt zu innovativen Lösungen

- Anpassungsfähigkeit als Antwort auf sich entwickelnde Herausforderungen

Koordinationsrahmen

Effektive teambasierte KI erfordert Kommunikationsprotokolle, die mit menschlichen Organisationen vergleichbar sind. Die Forscher entwickeln:

- Peer-to-Peer-Informationsnetzwerke

- Zentralisierte Überwachungssysteme

- Hybride Organisationsstrukturen

- Mechanismen zur Lösung von Konflikten

Herausforderungen und Zukunftschancen

Operative Komplexität

Die Verwaltung von Multiagentensystemen stellt neue Herausforderungen an die Organisationsgestaltung und die Ressourcenzuweisung. Teams müssen abwägen:

- Computereffizienz versus Koordinationsbedarf

- Verteilte Autonomie versus Systemkohärenz

- Skalierbarkeit versus Spezialisierungstiefe

Aufkommende Lösungen

Das Feld geht diese Probleme an durch:

- Selbst-optimierende Agentenarchitekturen

- Dynamische Lastausgleichstechniken

- Adaptive schlussfolgernde Rahmenwerke

- Prädiktive Koordinationsalgorithmen

Die Quintessenz

Die KI-Revolution tritt in ihre nächste Phase ein - weg von der rohen Skalierung hin zur intelligenten Zusammenarbeit. Teambasierte Systeme sind vielversprechend:

- Nachhaltige Rechenkapazitäten

- Spezialisierte Problemlösung

- Verlässliche verteilte Intelligenz

- Praktische Anpassungsfähigkeit in der realen Welt

Da die Forschung sich mit den aktuellen Koordinationsherausforderungen befasst, könnte dieses kollaborative Paradigma die bisher einflussreichste Entwicklung der KI darstellen - wo kollektive künstliche Intelligenz das erreicht, was kein einzelnes Modell könnte.

Google Startet Projekt Mariner, Seinen KI-Gestützten Web-Browsing-Agenten

Googles Projekt Mariner KI-Agent Erweitert sich mit Großen UpgradesBei Google I/O 2025 kündigte der Technologieriese bedeutende Updates für Projekt Mariner an, seinen experimentellen KI-Agenten, der e

Google Startet Projekt Mariner, Seinen KI-Gestützten Web-Browsing-Agenten

Googles Projekt Mariner KI-Agent Erweitert sich mit Großen UpgradesBei Google I/O 2025 kündigte der Technologieriese bedeutende Updates für Projekt Mariner an, seinen experimentellen KI-Agenten, der e

Airbnb führt in den USA leise einen KI-Kundenservice-Bot ein

Airbnb hebt KI-gestützten Kundenservice auf neue HöhenLetzten Monat kündigte CEO Brian Chesky während des Ergebnisberichts für das erste Quartal von Airbnb an, dass das Unternehmen in den USA mit der

Airbnb führt in den USA leise einen KI-Kundenservice-Bot ein

Airbnb hebt KI-gestützten Kundenservice auf neue HöhenLetzten Monat kündigte CEO Brian Chesky während des Ergebnisberichts für das erste Quartal von Airbnb an, dass das Unternehmen in den USA mit der

Das neue Unternehmen von Manny Medina: AI -Agenten können Erträge erzielen

Während sich die Ära der AI -Agenten entfaltet, ist ein neuer Trend, an Traktion zu gewinnen: Start -ups entstehen die wesentlichen Tools, die Unternehmen helfen, eine Belegschaft von Bots zu erstellen und zu verwalten. Manny Medina, bekannt für Gründung und früher führende Outreach, hat ein Vertriebsautomatisierungsunternehmen im Wert von 4,4 Milliarden US -Dollar.

Das neue Unternehmen von Manny Medina: AI -Agenten können Erträge erzielen

Während sich die Ära der AI -Agenten entfaltet, ist ein neuer Trend, an Traktion zu gewinnen: Start -ups entstehen die wesentlichen Tools, die Unternehmen helfen, eine Belegschaft von Bots zu erstellen und zu verwalten. Manny Medina, bekannt für Gründung und früher führende Outreach, hat ein Vertriebsautomatisierungsunternehmen im Wert von 4,4 Milliarden US -Dollar.