微软研究发现更多人工智能代币会增加推理错误

关于 LLM 推理效率的新见解

微软的最新研究表明,大型语言模型中的高级推理技术并不能在不同的人工智能系统中产生统一的改进。他们的突破性研究分析了九个领先的基础模型在推理过程中对各种扩展方法的反应。

评估推理时间扩展方法

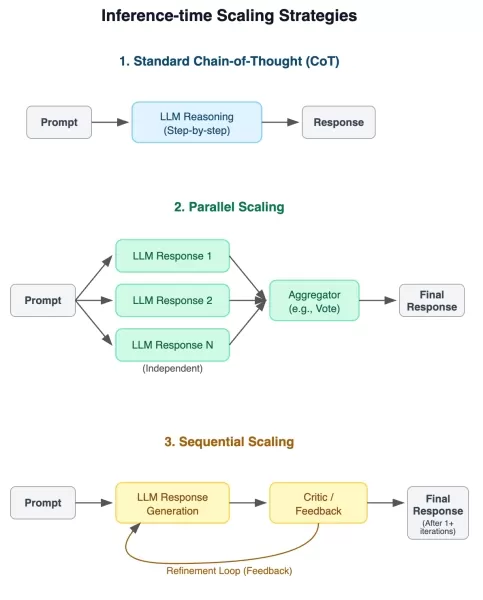

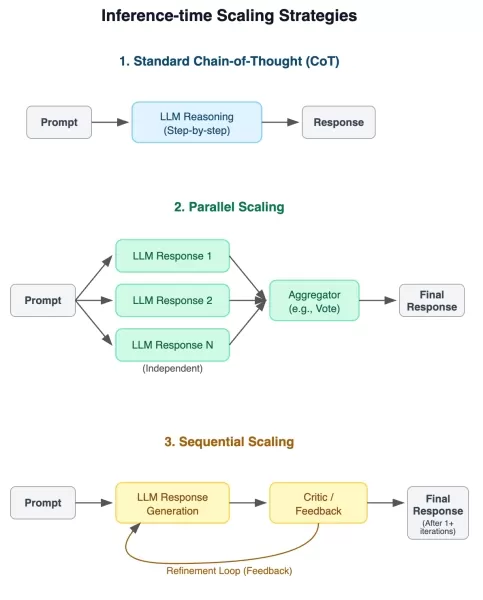

研究团队对三种不同的缩放技术实施了严格的测试方法:

- 传统的思维链提示

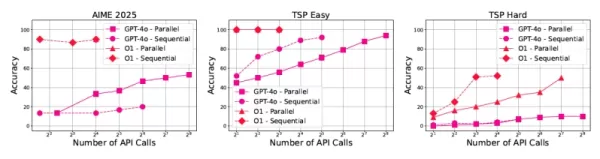

- 并行答案生成与汇总

- 通过反馈环路进行顺序改进

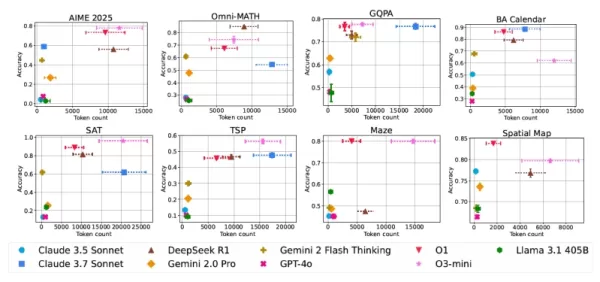

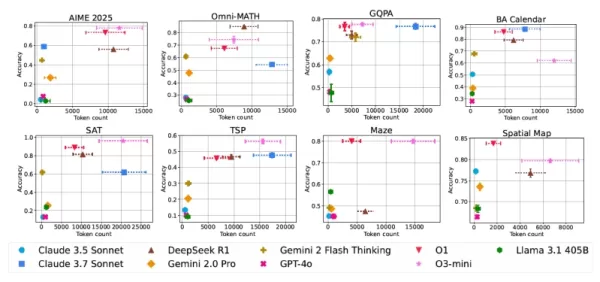

评估推理性能的实验框架 八项综合基准提供了跨学科的挑战性测试场景,包括数学、科学推理、复杂问题解决和空间分析。有几项评估采用了难度分级的方法,以考察成绩如何随问题复杂程度的变化而变化。

关于推理能力的重要发现

综合评估为人工智能从业人员提供了一些重要启示:

- 模型架构和任务领域不同,扩展技术带来的性能提升也大相径庭

- 更长的响应时间并不总是与更好的解决方案相关联

- 即使是相同的查询,计算成本也会出现不可预测的波动

- 通过广泛的扩展,传统模型有时可以与专门的推理模型相匹配

- 验证机制有望提高效率

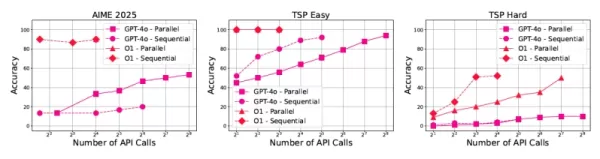

不同模型和任务的性能与计算成本对比 对人工智能发展的实际影响

这些发现对企业实施人工智能具有重要意义:

成本可预测性是一大挑战,即使是正确答案,令牌的使用也会出现很大差异。"微软研究员贝斯米拉-努希(Besmira Nushi)指出:"开发人员需要具有一致计算模式的模型。

研究还发现,响应长度也是衡量模型可信度的一个潜在指标,过长的响应往往意味着超过某些阈值后的解决方案是不正确的。

GPT-4o 性能中的推理缩放模式 高效推理系统的未来

该研究强调了未来发展的多个前景广阔的方向:

"Nushi 解释说:"验证机制可以改变我们处理推理问题的方式。这种整合将允许自然语言界面利用专门的验证逻辑。

这项研究强调,随着人工智能系统承担越来越复杂的现实世界任务,人们越来越需要能在推理准确性与可预测计算成本之间取得平衡的解决方案。

相关文章

法学硕士为何无视指示以及如何有效解决这一问题

了解大型语言模型跳过指令的原因大型语言模型(LLM)改变了我们与人工智能的交互方式,使从对话界面到自动内容生成和编程辅助等各种高级应用成为可能。然而,用户经常会遇到一个令人沮丧的限制:这些模型偶尔会忽略特定指令,尤其是在复杂或冗长的提示中。这种任务执行不完整的问题不仅会影响输出质量,还会降低用户对这些系统的信心。研究这种行为背后的根本原因,可以为优化 LLM 交互提供有价值的见解。LLM 处

法学硕士为何无视指示以及如何有效解决这一问题

了解大型语言模型跳过指令的原因大型语言模型(LLM)改变了我们与人工智能的交互方式,使从对话界面到自动内容生成和编程辅助等各种高级应用成为可能。然而,用户经常会遇到一个令人沮丧的限制:这些模型偶尔会忽略特定指令,尤其是在复杂或冗长的提示中。这种任务执行不完整的问题不仅会影响输出质量,还会降低用户对这些系统的信心。研究这种行为背后的根本原因,可以为优化 LLM 交互提供有价值的见解。LLM 处

谷歌双子座应用新增实时人工智能视频、深度研究和新功能 (120 字符)

谷歌在 2025 年 I/O 开发者大会上发布了 Gemini AI 的重大增强功能,扩展了多模态功能,引入了下一代 AI 模型,并加强了整个产品组合的生态系统集成。Gemini Live 的主要推出谷歌已正式向所有 iOS 和 Android 用户推出 Gemini Live 的视觉识别功能。该更新由最先进的 Project Astra 技术提供支持,结合来自设备摄像头或屏幕共享的实时视频分析,

谷歌双子座应用新增实时人工智能视频、深度研究和新功能 (120 字符)

谷歌在 2025 年 I/O 开发者大会上发布了 Gemini AI 的重大增强功能,扩展了多模态功能,引入了下一代 AI 模型,并加强了整个产品组合的生态系统集成。Gemini Live 的主要推出谷歌已正式向所有 iOS 和 Android 用户推出 Gemini Live 的视觉识别功能。该更新由最先进的 Project Astra 技术提供支持,结合来自设备摄像头或屏幕共享的实时视频分析,

谷歌云为科学研究和发现的突破提供动力

数字革命正在通过前所未有的计算能力改变科学方法。现在,尖端技术增强了理论框架和实验室实验,通过复杂的模拟和大数据分析推动了各学科的突破。通过对基础研究、可扩展云架构和人工智能开发的战略性投资,我们建立了一个加速科学进步的生态系统。我们在制药研究、气候建模和纳米技术等领域做出了突破性创新,并辅之以世界一流的计算基础设施、云原生软件解决方案和新一代生成式人工智能平台。谷歌 DeepMind 的研究实力

评论 (0)

0/200

谷歌云为科学研究和发现的突破提供动力

数字革命正在通过前所未有的计算能力改变科学方法。现在,尖端技术增强了理论框架和实验室实验,通过复杂的模拟和大数据分析推动了各学科的突破。通过对基础研究、可扩展云架构和人工智能开发的战略性投资,我们建立了一个加速科学进步的生态系统。我们在制药研究、气候建模和纳米技术等领域做出了突破性创新,并辅之以世界一流的计算基础设施、云原生软件解决方案和新一代生成式人工智能平台。谷歌 DeepMind 的研究实力

评论 (0)

0/200

关于 LLM 推理效率的新见解

微软的最新研究表明,大型语言模型中的高级推理技术并不能在不同的人工智能系统中产生统一的改进。他们的突破性研究分析了九个领先的基础模型在推理过程中对各种扩展方法的反应。

评估推理时间扩展方法

研究团队对三种不同的缩放技术实施了严格的测试方法:

- 传统的思维链提示

- 并行答案生成与汇总

- 通过反馈环路进行顺序改进

八项综合基准提供了跨学科的挑战性测试场景,包括数学、科学推理、复杂问题解决和空间分析。有几项评估采用了难度分级的方法,以考察成绩如何随问题复杂程度的变化而变化。

关于推理能力的重要发现

综合评估为人工智能从业人员提供了一些重要启示:

- 模型架构和任务领域不同,扩展技术带来的性能提升也大相径庭

- 更长的响应时间并不总是与更好的解决方案相关联

- 即使是相同的查询,计算成本也会出现不可预测的波动

- 通过广泛的扩展,传统模型有时可以与专门的推理模型相匹配

- 验证机制有望提高效率

对人工智能发展的实际影响

这些发现对企业实施人工智能具有重要意义:

成本可预测性是一大挑战,即使是正确答案,令牌的使用也会出现很大差异。"微软研究员贝斯米拉-努希(Besmira Nushi)指出:"开发人员需要具有一致计算模式的模型。

研究还发现,响应长度也是衡量模型可信度的一个潜在指标,过长的响应往往意味着超过某些阈值后的解决方案是不正确的。

高效推理系统的未来

该研究强调了未来发展的多个前景广阔的方向:

"Nushi 解释说:"验证机制可以改变我们处理推理问题的方式。这种整合将允许自然语言界面利用专门的验证逻辑。

这项研究强调,随着人工智能系统承担越来越复杂的现实世界任务,人们越来越需要能在推理准确性与可预测计算成本之间取得平衡的解决方案。

法学硕士为何无视指示以及如何有效解决这一问题

了解大型语言模型跳过指令的原因大型语言模型(LLM)改变了我们与人工智能的交互方式,使从对话界面到自动内容生成和编程辅助等各种高级应用成为可能。然而,用户经常会遇到一个令人沮丧的限制:这些模型偶尔会忽略特定指令,尤其是在复杂或冗长的提示中。这种任务执行不完整的问题不仅会影响输出质量,还会降低用户对这些系统的信心。研究这种行为背后的根本原因,可以为优化 LLM 交互提供有价值的见解。LLM 处

法学硕士为何无视指示以及如何有效解决这一问题

了解大型语言模型跳过指令的原因大型语言模型(LLM)改变了我们与人工智能的交互方式,使从对话界面到自动内容生成和编程辅助等各种高级应用成为可能。然而,用户经常会遇到一个令人沮丧的限制:这些模型偶尔会忽略特定指令,尤其是在复杂或冗长的提示中。这种任务执行不完整的问题不仅会影响输出质量,还会降低用户对这些系统的信心。研究这种行为背后的根本原因,可以为优化 LLM 交互提供有价值的见解。LLM 处

谷歌云为科学研究和发现的突破提供动力

数字革命正在通过前所未有的计算能力改变科学方法。现在,尖端技术增强了理论框架和实验室实验,通过复杂的模拟和大数据分析推动了各学科的突破。通过对基础研究、可扩展云架构和人工智能开发的战略性投资,我们建立了一个加速科学进步的生态系统。我们在制药研究、气候建模和纳米技术等领域做出了突破性创新,并辅之以世界一流的计算基础设施、云原生软件解决方案和新一代生成式人工智能平台。谷歌 DeepMind 的研究实力

谷歌云为科学研究和发现的突破提供动力

数字革命正在通过前所未有的计算能力改变科学方法。现在,尖端技术增强了理论框架和实验室实验,通过复杂的模拟和大数据分析推动了各学科的突破。通过对基础研究、可扩展云架构和人工智能开发的战略性投资,我们建立了一个加速科学进步的生态系统。我们在制药研究、气候建模和纳米技术等领域做出了突破性创新,并辅之以世界一流的计算基础设施、云原生软件解决方案和新一代生成式人工智能平台。谷歌 DeepMind 的研究实力