使用GPT-4的遞歸摘要:詳細概述

在當今快節奏的世界中,資訊豐富,濃縮長篇文章成簡潔摘要的技能比以往任何時候都更有價值。本篇部落格深入探討使用 GPT-4 進行遞迴摘要的迷人世界,提供如何有效縮短冗長文本而不失核心的詳細指南。無論你是學生、研究者,或只是喜歡保持資訊更新的人,你都會發現這種方法非常有用。讓我們一起來探索如何利用 GPT-4 的力量進行有效的文本摘要。

重點

- 遞迴摘要涉及將文本分解為較小的片段,並迭代地摘要這些片段以創建簡潔的概述。

- GPT-4 的廣泛上下文窗口有助於生成更準確且連貫的摘要。

- 詞元限制可能是一個障礙,需要策略性分割文本。

- 撰寫有效的提示詞對於引導 GPT-4 提取最相關的資訊至關重要。

- 此技術在摘要研究論文、法律文件和新聞文章中具有實際應用。

理解遞迴摘要

什麼是遞迴摘要?

遞迴摘要就像是一種濃縮長文本的魔法技巧。它涉及將冗長的文件分解成較小、易於消化的片段,摘要每個片段,然後將這些摘要合併成更高層次的概述。這個過程可以重複多次,直到達到所需的長度。想像處理一份100頁的報告;通過遞迴摘要,你可以創建一個易於管理的摘要,捕捉所有重點,而不會迷失在細節中。

當你處理的文檔超過語言模型(如 GPT-4)的詞元限制時,這種方法尤為出色。通過將任務分割成較小的步驟,你可以確保摘要過程既高效又準確。這就像解決一個大拼圖,逐片拼湊,確保最終圖像中包含每個重要細節。

為什麼使用 GPT-4 進行摘要?

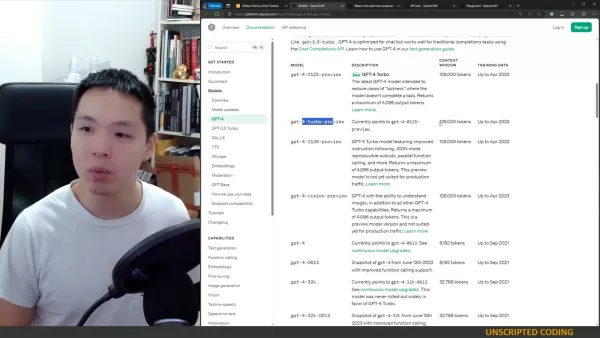

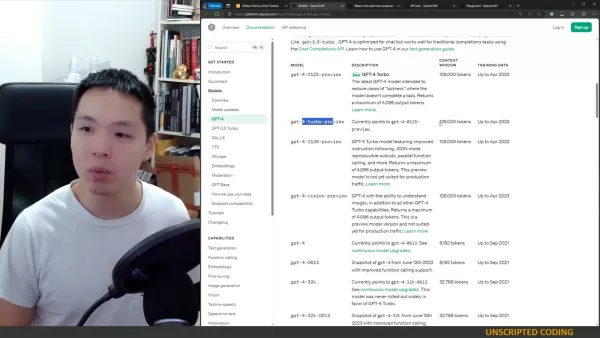

由 OpenAI 開發的 GPT-4 在文本摘要方面是一款強大的工具。得益於其廣大的上下文窗口,它可以處理並保留輸入文本的大量資訊,從而生成更準確且連貫的摘要。它不僅僅是理解文本;GPT-4 能遵循指令並提取最相關的資訊,使其非常適合遞迴摘要的精確任務。

GPT-4 的魅力在於它適應不同寫作風格並處理複雜文本的能力。無論是科學論文還是法律文件,GPT-4 都能篩選內容並提取最重要的細節。有了最新的 GPT-4 Turbo 模型,你可以享受最多4096個輸出詞元,減少模型無法完成任務的可能性。

克服詞元限制

詞元限制的挑戰

使用像 GPT-4 這樣的語言模型進行摘要的最大障礙之一是詞元限制。這些模型一次只能處理一定數量的詞元,當處理非常大的文檔時,這可能是一個真正的挑戰。如果你的文檔超過詞元限制,你需要將其分解成較小、易於管理的片段。

將文本分割成可管理的片段

為了充分利用 GPT-4 進行摘要,你需要將文本分割成適合詞元限制的可管理片段。以下是幫助你做到這一點的逐步方法:

- 確定詞元限制:找出你使用的 GPT-4 模型的最大詞元限制。

- 分割文本:根據段落、章節或篇章將文件分解成較小的部分。

- 對每個片段進行詞元計數:使用分詞器計算每個片段的詞元數量。

- 調整片段大小:如果某個片段超過詞元限制,進一步分割直到所有片段都在可接受範圍內。

通過遵循這些步驟,你可以確保每個片段都在 GPT-4 的詞元限制內,從而實現有效的遞迴摘要。無論是按段落、章節還是篇章分割,目標是保持連貫性同時遵守詞元限制。

有效摘要的策略

有效摘要的重點在於從每個文本片段中提取最相關的資訊,同時保持在詞元限制內。一個有效的策略是專注於識別和保留概括主要觀點和支持論點的關鍵句子。你也可以使用提取式摘要技術,直接從原始文本中複製重要的短語和句子。這對於技術性或學術性內容尤其有用,因為精確的語言至關重要。

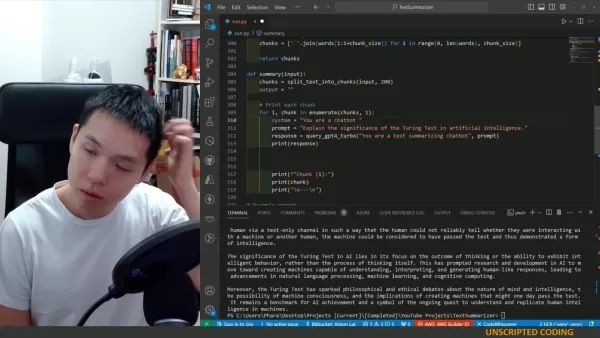

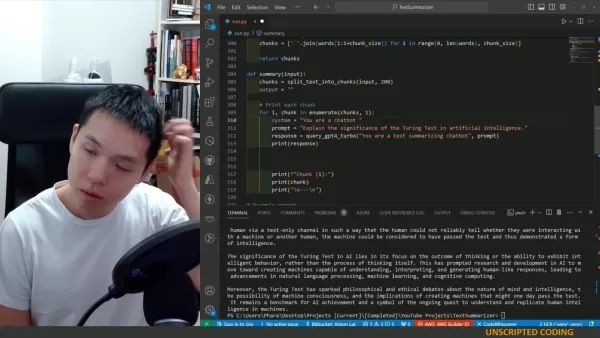

以下是一個簡單的 Python 函數,幫助你將文本分割成片段:

textdef split_text_into_chunks(text, chunk_size=800):

words = text.split()

chunks = [' '.join(words[i:i+chunk_size]) for i in range(0, len(words), chunk_size)]

return chunks

此函數按單詞分割文本,但如果文本中有可用的章節或篇章,你也可以使用這些來分割。

使用 GPT-4 進行遞迴摘要的逐步指南

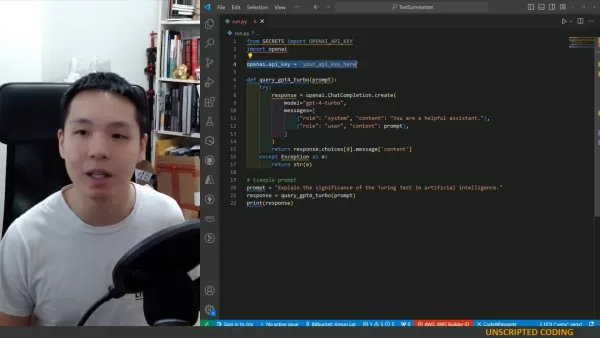

設置環境

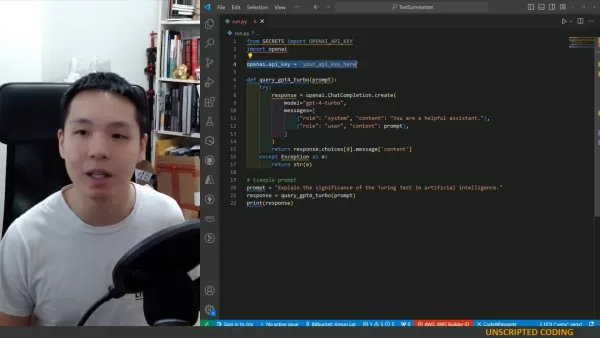

在開始遞迴摘要之前,確保你有權訪問 OpenAI API 和 GPT-4 模型。你需要一個 API 密鑰和 OpenAI Python 庫。

以下是如何設置環境的步驟:

- 安裝 OpenAI 庫:使用 pip install openai 安裝 OpenAI 庫。

- 導入必要模組:導入 openai 和其他文本處理所需的模組。

- 使用 OpenAI 進行身份驗證:設置你的 API 密鑰以進行 OpenAI API 身份驗證。

編寫遞迴摘要函數

現在,讓我們創建一個函數,用於遞迴摘要文本片段。以下是一個示例函數:

textdef summary(input_text):

chunks = split_text_into_chunks(input_text, 800)

output = ""

for i, chunk in enumerate(chunks, 1):

system = "你是一個遞迴摘要文本的聊天機器人。你將處理一篇長篇文章,並逐段摘要。請考慮你已經摘要的內容,以創建一個具有統一風格的連貫摘要。你目前正在處理第 " + str(i) + " 段。到目前為止,你的摘要是:" + output

prompt = "請為文章的以下段落添加摘要:" + chunk

response = query_gpt4_turbo(system, prompt)

output = output + " " + response

print(response)

return output

測試與迭代

實現該函數後,使用各種文章進行測試,檢視其表現如何。你可能需要迭代提示詞和片段大小以優化結果。始終評估摘要的連貫性、準確性和相關性。測試和迭代是完善遞迴摘要過程的關鍵步驟,確保摘要滿足你的需求。

遞迴摘要的優點與缺點

優點

- 可處理超過詞元限制的超大文檔。

- 通過迭代摘要保持連貫性。

- 提供調整摘要長度的靈活性。

缺點

- 需要仔細規劃和提示工程。

- 對於極長的文本可能耗時。

- 與全文分析相比,可能失去一些細微差別。

常見問題 (FAQ)

最大詞元長度是多少?

GPT-4 Turbo 最多返回4096個詞元。

哪些模型可用於遞迴摘要?

GPT-4 和其他具有大上下文窗口的模型適合用於遞迴摘要。

遞迴摘要是什麼意思?

它意味著每個摘要都會考慮後續摘要,確保在單一風格提示下的一致性。

如果文本超過128,000個詞元怎麼辦?

使用此方法和代碼將文本分解成片段,逐步進行摘要。

相關問題

如何提升 GPT-4 摘要的質量?

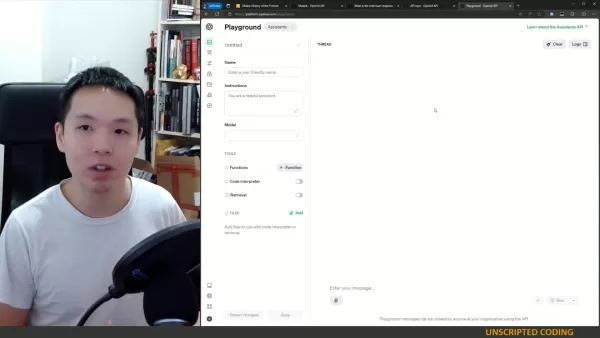

要提升 GPT-4 摘要的質量,專注於優化提示詞和片段大小。清晰、具體的提示詞引導 GPT-4 提取相關資訊,而適當的片段大小確保模型能有效處理每個文本片段。在編輯器中實現之前,先在試驗場測試也有助益。優化你的提示詞和片段大小,並使用代碼編輯器高效實現和測試系統。記住,測試是關鍵!

相關文章

Apple 的 Craig Federighi 承認人工智慧 Siri 早期階段有嚴重缺陷

蘋果高層解釋 Siri 升級延遲的原因在 WWDC 2024 期間,Apple 原本承諾會大幅提升 Siri 功能,包括個人化情境感知和應用程式自動化功能。然而,該公司最近證實這些功能的交付將會延遲。高級副總裁 Craig Federighi (軟體工程) 與 Greg Joswiak (全球行銷) 在接受《華爾街日報》的 Joanna Stern 獨家專訪時,談到這些延遲的問題。Fede

Apple 的 Craig Federighi 承認人工智慧 Siri 早期階段有嚴重缺陷

蘋果高層解釋 Siri 升級延遲的原因在 WWDC 2024 期間,Apple 原本承諾會大幅提升 Siri 功能,包括個人化情境感知和應用程式自動化功能。然而,該公司最近證實這些功能的交付將會延遲。高級副總裁 Craig Federighi (軟體工程) 與 Greg Joswiak (全球行銷) 在接受《華爾街日報》的 Joanna Stern 獨家專訪時,談到這些延遲的問題。Fede

掌握 AI Inpainting 技術:無懈可擊的圖像編輯中途指南

探索 Midjourney 的 AI Inpainting 技術的變革能力,這項革命性的功能可讓創作者以外科手術般的精準度,精緻和完善 AI 所產生的作品。這本權威指南揭示了如何運用這項強大工具來提升您的創意專案的專業技巧,無論您是要進行微妙的改進或戲劇性的構圖變化 - 一切都在 Midjourney 的直覺式平台中進行。重點Midjourney 的內繪工具可透過選擇性編輯,對影像進行有針對性的修

掌握 AI Inpainting 技術:無懈可擊的圖像編輯中途指南

探索 Midjourney 的 AI Inpainting 技術的變革能力,這項革命性的功能可讓創作者以外科手術般的精準度,精緻和完善 AI 所產生的作品。這本權威指南揭示了如何運用這項強大工具來提升您的創意專案的專業技巧,無論您是要進行微妙的改進或戲劇性的構圖變化 - 一切都在 Midjourney 的直覺式平台中進行。重點Midjourney 的內繪工具可透過選擇性編輯,對影像進行有針對性的修

Manus 推出「Wide Research」AI 工具,內含 100 多個網頁搜刮代理程式

中國 AI 創新企業 Manus 之前因其開創的多代理協調平台(multi-agent orchestration platform)而備受矚目,該平台同時滿足消費者和專業用戶的需求,日前 Manus 公佈了其技術的突破性應用,挑戰傳統的 AI 研究方法。重新思考人工智能驅動的研究與 OpenAI、Google 和 xAI 等競爭對手所開發的專門「深度研究」(Deep Research)代理程式不

評論 (17)

0/200

Manus 推出「Wide Research」AI 工具,內含 100 多個網頁搜刮代理程式

中國 AI 創新企業 Manus 之前因其開創的多代理協調平台(multi-agent orchestration platform)而備受矚目,該平台同時滿足消費者和專業用戶的需求,日前 Manus 公佈了其技術的突破性應用,挑戰傳統的 AI 研究方法。重新思考人工智能驅動的研究與 OpenAI、Google 和 xAI 等競爭對手所開發的專門「深度研究」(Deep Research)代理程式不

評論 (17)

0/200

![RonaldHernández]() RonaldHernández

RonaldHernández

2025-08-15 14:00:59

2025-08-15 14:00:59

This recursive summarization stuff with GPT-4 is wild! It’s like teaching a super-smart robot to shrink novels into tweets. I wonder how it handles super technical papers though? 🤔

0

0

![JohnRoberts]() JohnRoberts

JohnRoberts

2025-08-06 19:00:59

2025-08-06 19:00:59

This recursive summarization thing with GPT-4 sounds like a game-changer! I love how it can boil down massive articles into bite-sized nuggets. Makes me wonder if I’ll ever read a full article again 😂. Anyone tried this in their workflow yet?

0

0

![GeorgeTaylor]() GeorgeTaylor

GeorgeTaylor

2025-05-10 13:52:31

2025-05-10 13:52:31

A Sumarização Recursiva com GPT-4 é incrível! É como mágica como ele consegue pegar um artigo longo e reduzi-lo ao essencial. Usei no trabalho e economizou muito tempo. Só queria que fosse um pouco mais amigável, a interface pode ser confusa. Ainda assim, é uma ferramenta revolucionária! 🌟

0

0

![FrankSmith]() FrankSmith

FrankSmith

2025-05-10 07:51:23

2025-05-10 07:51:23

¡La Sumarización Recursiva con GPT-4 es impresionante! Es muy útil para condensar artículos largos, aunque a veces las summaries pierden un poco del sabor original. Aún así, es una gran herramienta para quien necesita captar rápidamente la esencia de textos extensos. ¡Pruébalo! 📚

0

0

![MatthewGonzalez]() MatthewGonzalez

MatthewGonzalez

2025-05-10 06:18:08

2025-05-10 06:18:08

A Sumarização Recursiva com GPT-4 é incrível! É super útil para condensar artigos longos, mas às vezes os resumos perdem um pouco do sabor original. Ainda assim, é uma ótima ferramenta para quem precisa captar rapidamente a essência de textos extensos. Experimente! 📚

0

0

![StevenNelson]() StevenNelson

StevenNelson

2025-05-10 05:29:07

2025-05-10 05:29:07

GPT-4を使った再帰的要約は驚くべきものです!長い記事を要約するのにとても役立ちますが、時々オリジナルの風味が少し失われることがあります。それでも、長いテキストの要点を素早く把握したい人にとっては素晴らしいツールです。試してみてください!📚

0

0

在當今快節奏的世界中,資訊豐富,濃縮長篇文章成簡潔摘要的技能比以往任何時候都更有價值。本篇部落格深入探討使用 GPT-4 進行遞迴摘要的迷人世界,提供如何有效縮短冗長文本而不失核心的詳細指南。無論你是學生、研究者,或只是喜歡保持資訊更新的人,你都會發現這種方法非常有用。讓我們一起來探索如何利用 GPT-4 的力量進行有效的文本摘要。

重點

- 遞迴摘要涉及將文本分解為較小的片段,並迭代地摘要這些片段以創建簡潔的概述。

- GPT-4 的廣泛上下文窗口有助於生成更準確且連貫的摘要。

- 詞元限制可能是一個障礙,需要策略性分割文本。

- 撰寫有效的提示詞對於引導 GPT-4 提取最相關的資訊至關重要。

- 此技術在摘要研究論文、法律文件和新聞文章中具有實際應用。

理解遞迴摘要

什麼是遞迴摘要?

遞迴摘要就像是一種濃縮長文本的魔法技巧。它涉及將冗長的文件分解成較小、易於消化的片段,摘要每個片段,然後將這些摘要合併成更高層次的概述。這個過程可以重複多次,直到達到所需的長度。想像處理一份100頁的報告;通過遞迴摘要,你可以創建一個易於管理的摘要,捕捉所有重點,而不會迷失在細節中。

當你處理的文檔超過語言模型(如 GPT-4)的詞元限制時,這種方法尤為出色。通過將任務分割成較小的步驟,你可以確保摘要過程既高效又準確。這就像解決一個大拼圖,逐片拼湊,確保最終圖像中包含每個重要細節。

為什麼使用 GPT-4 進行摘要?

由 OpenAI 開發的 GPT-4 在文本摘要方面是一款強大的工具。得益於其廣大的上下文窗口,它可以處理並保留輸入文本的大量資訊,從而生成更準確且連貫的摘要。它不僅僅是理解文本;GPT-4 能遵循指令並提取最相關的資訊,使其非常適合遞迴摘要的精確任務。

GPT-4 的魅力在於它適應不同寫作風格並處理複雜文本的能力。無論是科學論文還是法律文件,GPT-4 都能篩選內容並提取最重要的細節。有了最新的 GPT-4 Turbo 模型,你可以享受最多4096個輸出詞元,減少模型無法完成任務的可能性。

克服詞元限制

詞元限制的挑戰

使用像 GPT-4 這樣的語言模型進行摘要的最大障礙之一是詞元限制。這些模型一次只能處理一定數量的詞元,當處理非常大的文檔時,這可能是一個真正的挑戰。如果你的文檔超過詞元限制,你需要將其分解成較小、易於管理的片段。

將文本分割成可管理的片段

為了充分利用 GPT-4 進行摘要,你需要將文本分割成適合詞元限制的可管理片段。以下是幫助你做到這一點的逐步方法:

- 確定詞元限制:找出你使用的 GPT-4 模型的最大詞元限制。

- 分割文本:根據段落、章節或篇章將文件分解成較小的部分。

- 對每個片段進行詞元計數:使用分詞器計算每個片段的詞元數量。

- 調整片段大小:如果某個片段超過詞元限制,進一步分割直到所有片段都在可接受範圍內。

通過遵循這些步驟,你可以確保每個片段都在 GPT-4 的詞元限制內,從而實現有效的遞迴摘要。無論是按段落、章節還是篇章分割,目標是保持連貫性同時遵守詞元限制。

有效摘要的策略

有效摘要的重點在於從每個文本片段中提取最相關的資訊,同時保持在詞元限制內。一個有效的策略是專注於識別和保留概括主要觀點和支持論點的關鍵句子。你也可以使用提取式摘要技術,直接從原始文本中複製重要的短語和句子。這對於技術性或學術性內容尤其有用,因為精確的語言至關重要。

以下是一個簡單的 Python 函數,幫助你將文本分割成片段:

def split_text_into_chunks(text, chunk_size=800):

words = text.split()

chunks = [' '.join(words[i:i+chunk_size]) for i in range(0, len(words), chunk_size)]

return chunks此函數按單詞分割文本,但如果文本中有可用的章節或篇章,你也可以使用這些來分割。

使用 GPT-4 進行遞迴摘要的逐步指南

設置環境

在開始遞迴摘要之前,確保你有權訪問 OpenAI API 和 GPT-4 模型。你需要一個 API 密鑰和 OpenAI Python 庫。

以下是如何設置環境的步驟:

- 安裝 OpenAI 庫:使用 pip install openai 安裝 OpenAI 庫。

- 導入必要模組:導入 openai 和其他文本處理所需的模組。

- 使用 OpenAI 進行身份驗證:設置你的 API 密鑰以進行 OpenAI API 身份驗證。

編寫遞迴摘要函數

現在,讓我們創建一個函數,用於遞迴摘要文本片段。以下是一個示例函數:

def summary(input_text):

chunks = split_text_into_chunks(input_text, 800)

output = ""

for i, chunk in enumerate(chunks, 1):

system = "你是一個遞迴摘要文本的聊天機器人。你將處理一篇長篇文章,並逐段摘要。請考慮你已經摘要的內容,以創建一個具有統一風格的連貫摘要。你目前正在處理第 " + str(i) + " 段。到目前為止,你的摘要是:" + output

prompt = "請為文章的以下段落添加摘要:" + chunk

response = query_gpt4_turbo(system, prompt)

output = output + " " + response

print(response)

return output測試與迭代

實現該函數後,使用各種文章進行測試,檢視其表現如何。你可能需要迭代提示詞和片段大小以優化結果。始終評估摘要的連貫性、準確性和相關性。測試和迭代是完善遞迴摘要過程的關鍵步驟,確保摘要滿足你的需求。

遞迴摘要的優點與缺點

優點

- 可處理超過詞元限制的超大文檔。

- 通過迭代摘要保持連貫性。

- 提供調整摘要長度的靈活性。

缺點

- 需要仔細規劃和提示工程。

- 對於極長的文本可能耗時。

- 與全文分析相比,可能失去一些細微差別。

常見問題 (FAQ)

最大詞元長度是多少?

GPT-4 Turbo 最多返回4096個詞元。

哪些模型可用於遞迴摘要?

GPT-4 和其他具有大上下文窗口的模型適合用於遞迴摘要。

遞迴摘要是什麼意思?

它意味著每個摘要都會考慮後續摘要,確保在單一風格提示下的一致性。

如果文本超過128,000個詞元怎麼辦?

使用此方法和代碼將文本分解成片段,逐步進行摘要。

相關問題

如何提升 GPT-4 摘要的質量?

要提升 GPT-4 摘要的質量,專注於優化提示詞和片段大小。清晰、具體的提示詞引導 GPT-4 提取相關資訊,而適當的片段大小確保模型能有效處理每個文本片段。在編輯器中實現之前,先在試驗場測試也有助益。優化你的提示詞和片段大小,並使用代碼編輯器高效實現和測試系統。記住,測試是關鍵!

Apple 的 Craig Federighi 承認人工智慧 Siri 早期階段有嚴重缺陷

蘋果高層解釋 Siri 升級延遲的原因在 WWDC 2024 期間,Apple 原本承諾會大幅提升 Siri 功能,包括個人化情境感知和應用程式自動化功能。然而,該公司最近證實這些功能的交付將會延遲。高級副總裁 Craig Federighi (軟體工程) 與 Greg Joswiak (全球行銷) 在接受《華爾街日報》的 Joanna Stern 獨家專訪時,談到這些延遲的問題。Fede

Apple 的 Craig Federighi 承認人工智慧 Siri 早期階段有嚴重缺陷

蘋果高層解釋 Siri 升級延遲的原因在 WWDC 2024 期間,Apple 原本承諾會大幅提升 Siri 功能,包括個人化情境感知和應用程式自動化功能。然而,該公司最近證實這些功能的交付將會延遲。高級副總裁 Craig Federighi (軟體工程) 與 Greg Joswiak (全球行銷) 在接受《華爾街日報》的 Joanna Stern 獨家專訪時,談到這些延遲的問題。Fede

掌握 AI Inpainting 技術:無懈可擊的圖像編輯中途指南

探索 Midjourney 的 AI Inpainting 技術的變革能力,這項革命性的功能可讓創作者以外科手術般的精準度,精緻和完善 AI 所產生的作品。這本權威指南揭示了如何運用這項強大工具來提升您的創意專案的專業技巧,無論您是要進行微妙的改進或戲劇性的構圖變化 - 一切都在 Midjourney 的直覺式平台中進行。重點Midjourney 的內繪工具可透過選擇性編輯,對影像進行有針對性的修

掌握 AI Inpainting 技術:無懈可擊的圖像編輯中途指南

探索 Midjourney 的 AI Inpainting 技術的變革能力,這項革命性的功能可讓創作者以外科手術般的精準度,精緻和完善 AI 所產生的作品。這本權威指南揭示了如何運用這項強大工具來提升您的創意專案的專業技巧,無論您是要進行微妙的改進或戲劇性的構圖變化 - 一切都在 Midjourney 的直覺式平台中進行。重點Midjourney 的內繪工具可透過選擇性編輯,對影像進行有針對性的修

Manus 推出「Wide Research」AI 工具,內含 100 多個網頁搜刮代理程式

中國 AI 創新企業 Manus 之前因其開創的多代理協調平台(multi-agent orchestration platform)而備受矚目,該平台同時滿足消費者和專業用戶的需求,日前 Manus 公佈了其技術的突破性應用,挑戰傳統的 AI 研究方法。重新思考人工智能驅動的研究與 OpenAI、Google 和 xAI 等競爭對手所開發的專門「深度研究」(Deep Research)代理程式不

Manus 推出「Wide Research」AI 工具,內含 100 多個網頁搜刮代理程式

中國 AI 創新企業 Manus 之前因其開創的多代理協調平台(multi-agent orchestration platform)而備受矚目,該平台同時滿足消費者和專業用戶的需求,日前 Manus 公佈了其技術的突破性應用,挑戰傳統的 AI 研究方法。重新思考人工智能驅動的研究與 OpenAI、Google 和 xAI 等競爭對手所開發的專門「深度研究」(Deep Research)代理程式不

2025-08-15 14:00:59

2025-08-15 14:00:59

This recursive summarization stuff with GPT-4 is wild! It’s like teaching a super-smart robot to shrink novels into tweets. I wonder how it handles super technical papers though? 🤔

0

0

2025-08-06 19:00:59

2025-08-06 19:00:59

This recursive summarization thing with GPT-4 sounds like a game-changer! I love how it can boil down massive articles into bite-sized nuggets. Makes me wonder if I’ll ever read a full article again 😂. Anyone tried this in their workflow yet?

0

0

2025-05-10 13:52:31

2025-05-10 13:52:31

A Sumarização Recursiva com GPT-4 é incrível! É como mágica como ele consegue pegar um artigo longo e reduzi-lo ao essencial. Usei no trabalho e economizou muito tempo. Só queria que fosse um pouco mais amigável, a interface pode ser confusa. Ainda assim, é uma ferramenta revolucionária! 🌟

0

0

2025-05-10 07:51:23

2025-05-10 07:51:23

¡La Sumarización Recursiva con GPT-4 es impresionante! Es muy útil para condensar artículos largos, aunque a veces las summaries pierden un poco del sabor original. Aún así, es una gran herramienta para quien necesita captar rápidamente la esencia de textos extensos. ¡Pruébalo! 📚

0

0

2025-05-10 06:18:08

2025-05-10 06:18:08

A Sumarização Recursiva com GPT-4 é incrível! É super útil para condensar artigos longos, mas às vezes os resumos perdem um pouco do sabor original. Ainda assim, é uma ótima ferramenta para quem precisa captar rapidamente a essência de textos extensos. Experimente! 📚

0

0

2025-05-10 05:29:07

2025-05-10 05:29:07

GPT-4を使った再帰的要約は驚くべきものです!長い記事を要約するのにとても役立ちますが、時々オリジナルの風味が少し失われることがあります。それでも、長いテキストの要点を素早く把握したい人にとっては素晴らしいツールです。試してみてください!📚

0

0