Coloquei o GPT -4O nos meus testes de codificação e ele os atendi - exceto por um resultado estranho

Se você tem acompanhado o mundo da tecnologia, provavelmente sabe que a OpenAI acabou de lançar seu mais recente modelo de linguagem de grande escala, o GPT-4o, onde o "o" significa "omni". Este novo modelo promete versatilidade em texto, gráficos e voz, e eu não podia esperar para testá-lo com meu conjunto padrão de testes de codificação. Esses testes foram executados contra uma ampla gama de modelos de IA, gerando resultados bastante fascinantes. Fique comigo até o final, porque há uma reviravolta que você não vai querer perder.

Se você está interessado em realizar seus próprios experimentos, confira este guia: Como eu testo a capacidade de codificação de um chatbot de IA - e você também pode. Ele descreve todos os testes que utilizo, juntamente com explicações detalhadas de como eles funcionam e o que procurar nos resultados.

Agora, vamos mergulhar nos resultados de cada teste e ver como o GPT-4o se compara aos concorrentes anteriores, como Microsoft Copilot, Meta AI, Meta Code Llama, Google Gemini Advanced e as versões anteriores do ChatGPT.

1. Escrevendo um Plugin para WordPress

Aqui está um vislumbre da interface do usuário do GPT-4o:

Curiosamente, o GPT-4o tomou a liberdade de incluir um arquivo JavaScript, que atualiza dinamicamente a contagem de linhas em ambos os campos. Embora o prompt não tenha explicitamente descartado o uso de JavaScript, essa abordagem criativa foi inesperada e eficaz. O JavaScript também aprimora a funcionalidade do botão Randomizar, permitindo múltiplos conjuntos de resultados sem a necessidade de recarregar a página inteira.

As linhas foram organizadas corretamente, e os duplicados foram devidamente separados conforme as especificações. É um código sólido, com apenas uma pequena ressalva: o botão Randomizar não foi colocado em sua própria linha, embora eu não tenha especificado isso no prompt, então não há penalidade por isso.

Aqui estão os resultados agregados para este e os testes anteriores:

- ChatGPT GPT-4o: Interface: boa, funcionalidade: boa

- Microsoft Copilot: Interface: adequada, funcionalidade: falhou

- Meta AI: Interface: adequada, funcionalidade: falhou

- Meta Code Llama: Falha completa

- Google Gemini Advanced: Interface: boa, funcionalidade: falhou

- ChatGPT 4: Interface: boa, funcionalidade: boa

- ChatGPT 3.5: Interface: boa, funcionalidade: boa

2. Reescrevendo uma Função de String

Este teste avalia a capacidade do modelo de lidar com conversões de dólares e centavos. O GPT-4o reescreveu com sucesso o código para rejeitar entradas que poderiam causar problemas nas linhas subsequentes, garantindo que apenas valores válidos de dólares e centavos sejam processados.

Fiquei um pouco desapontado por ele não ter adicionado automaticamente um zero à esquerda em valores como .75, convertendo-os para 0.75. No entanto, como não solicitei explicitamente esse recurso, não é uma falha da IA. Isso serve como um lembrete de que, mesmo quando uma IA entrega um código funcional, pode ser necessário refinar o prompt para obter exatamente o que você precisa.

Aqui estão os resultados agregados para este e os testes anteriores:

- ChatGPT GPT-4o: Sucesso

- Microsoft Copilot: Falhou

- Meta AI: Falhou

- Meta Code Llama: Sucesso

- Google Gemini Advanced: Falhou

- ChatGPT 4: Sucesso

- ChatGPT 3.5: Sucesso

3. Encontrando um Bug Irritante

Este teste é intrigante porque a solução não é imediatamente aparente. Fiquei inicialmente perplexo com esse erro durante minha própria codificação, então recorri ao primeiro modelo do ChatGPT para obter ajuda. Ele encontrou o erro instantaneamente, o que foi surpreendente na época.

Em contrapartida, três dos outros LLMs que testei não perceberam a distração neste problema. A mensagem de erro aponta para uma parte do código, mas o problema real está em outro lugar, exigindo um conhecimento profundo do framework WordPress para identificar.

Felizmente, o GPT-4o identificou corretamente o problema e descreveu a correção com precisão.

Aqui estão os resultados agregados para este e os testes anteriores:

- ChatGPT GPT-4o: Sucesso

- Microsoft Copilot: Falhou. Espetacularmente. Entusiasticamente. Com emojis.

- Meta AI: Sucesso

- Meta Code Llama: Falhou

- Google Gemini Advanced: Falhou

- ChatGPT 4: Sucesso

- ChatGPT 3.5: Sucesso

Até agora, o GPT-4o está com três acertos em três. Vamos ver como ele se sai no teste final.

4. Escrevendo um Script

Em resposta a este teste, o GPT-4o forneceu mais do que eu pedi. O teste envolve o uso da ferramenta de automação obscura para Mac, Keyboard Maestro, o AppleScript da Apple e o comportamento de script do Chrome. A propósito, o Keyboard Maestro é um divisor de águas para mim, tornando os Macs minha escolha para produtividade devido à sua capacidade de reprogramar o sistema operacional e os aplicativos.

Para passar, a IA precisa delinear corretamente uma solução usando uma combinação de código Keyboard Maestro, AppleScript e funcionalidade da API do Chrome.

Surpreendentemente, o GPT-4o me deu duas versões diferentes:

Ambas as versões interagiram corretamente com o Keyboard Maestro, mas diferiram no tratamento de sensibilidade a maiúsculas e minúsculas. A versão à esquerda estava incorreta porque o AppleScript não suporta "as lowercase". A versão à direita, que usava "contains" e era insensível a maiúsculas, funcionou bem.

Estou dando um passe ao GPT-4o, embora com cautela, porque ele entregou um código funcional. No entanto, retornar duas opções, uma das quais estava incorreta, me fez trabalhar extra para avaliar e escolher a correta. Isso poderia ter sido tão demorado quanto escrever o código eu mesmo.

Aqui estão os resultados agregados para este e os testes anteriores:

- ChatGPT GPT-4o: Sucesso, mas com ressalvas

- Microsoft Copilot: Falhou

- Meta AI: Falhou

- Meta Code Llama: Falhou

- Google Gemini Advanced: Sucesso

- ChatGPT 4: Sucesso

- ChatGPT 3.5: Falhou

Resultados Gerais

Aqui está como todos os modelos se saíram nos quatro testes:

- ChatGPT GPT-4o: 4 de 4 com sucesso, mas com aquela resposta estranha de dupla escolha

- Microsoft Copilot: 0 de 4 com sucesso

- Meta AI: 1 de 4 com sucesso

- Meta Code Llama: 1 de 4 com sucesso

- Google Gemini Advanced: 1 de 4 com sucesso

- ChatGPT 4: 4 de 4 com sucesso

- ChatGPT 3.5: 3 de 4 com sucesso

Até agora, o ChatGPT tem sido minha escolha para assistência em codificação. Ele sempre entregou (exceto quando não entregou). As outras IAs, em sua maioria, ficaram aquém nos meus testes. Mas o GPT-4o me surpreendeu com aquela resposta de dupla escolha no último teste. Isso me fez questionar o que está acontecendo dentro deste modelo que poderia causar tal contratempo.

Apesar disso, o GPT-4o continua sendo o melhor desempenho nos meus testes de codificação, então provavelmente continuarei usando-o e me familiarizando mais com suas peculiaridades. Alternativamente, posso voltar ao GPT-3.5 ou GPT-4 no ChatGPT Plus. Fique ligado; na próxima vez que o ChatGPT atualizar seu modelo, definitivamente repetirei esses testes para ver se ele consegue escolher consistentemente a resposta certa em todos os quatro testes.

Você já tentou codificar com algum desses modelos de IA? Qual foi sua experiência? Conte-nos nos comentários abaixo.

Artigo relacionado

A IA Stitch do Google simplifica o processo de design de aplicativos

Google revela a ferramenta de design de IA Stitch no I/O 2025O Google apresentou o Stitch, sua revolucionária ferramenta de design de interface baseada em IA, durante a apresentação no Google I/O 2025

A IA Stitch do Google simplifica o processo de design de aplicativos

Google revela a ferramenta de design de IA Stitch no I/O 2025O Google apresentou o Stitch, sua revolucionária ferramenta de design de interface baseada em IA, durante a apresentação no Google I/O 2025

Claude 4 A IA supera seus antecessores em tarefas de codificação e raciocínio lógico

A Anthropic revelou seus modelos de IA Claude de última geração - Claude Opus 4 e Claude Sonnet 4 - que representam grandes avanços nos recursos de raciocínio híbrido, especialmente para aplicativos d

Claude 4 A IA supera seus antecessores em tarefas de codificação e raciocínio lógico

A Anthropic revelou seus modelos de IA Claude de última geração - Claude Opus 4 e Claude Sonnet 4 - que representam grandes avanços nos recursos de raciocínio híbrido, especialmente para aplicativos d

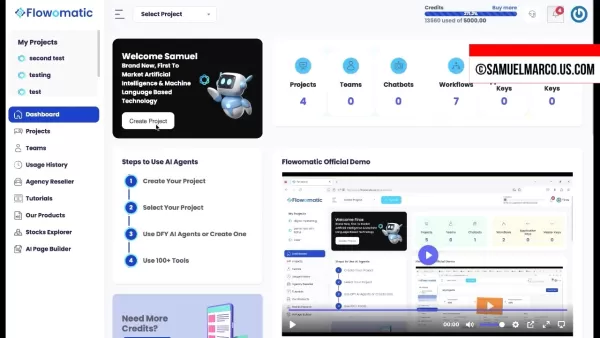

O Flowomatic AI Agents 2.0 transforma a automação comercial com tecnologia de ponta

No atual cenário competitivo dos negócios, a inteligência artificial se tornou a força motriz por trás da eficiência operacional e das estratégias de crescimento. O Flowomatic AI Agents 2.0 representa

Comentários (20)

0/200

O Flowomatic AI Agents 2.0 transforma a automação comercial com tecnologia de ponta

No atual cenário competitivo dos negócios, a inteligência artificial se tornou a força motriz por trás da eficiência operacional e das estratégias de crescimento. O Flowomatic AI Agents 2.0 representa

Comentários (20)

0/200

![JonathanAllen]() JonathanAllen

JonathanAllen

26 de Abril de 2025 à22 12:46:22 WEST

26 de Abril de 2025 à22 12:46:22 WEST

GPT-4o é impressionante, passando na maioria dos meus testes de codificação! Mas aquele resultado estranho me deixou confuso. Ainda assim, é versátil em texto, gráficos e voz. Se ao menos pudesse explicar aquele resultado estranho, seria perfeito! 🤔

0

0

![WillHarris]() WillHarris

WillHarris

25 de Abril de 2025 à39 19:21:39 WEST

25 de Abril de 2025 à39 19:21:39 WEST

GPT-4o thật ấn tượng, vượt qua hầu hết các bài kiểm tra mã hóa của tôi! Nhưng kết quả lạ đó làm tôi bối rối. Tuy nhiên, nó rất linh hoạt trong văn bản, đồ họa và giọng nói. Giá mà nó có thể giải thích kết quả lạ đó, thì sẽ hoàn hảo! 🤔

0

0

![DonaldGonzález]() DonaldGonzález

DonaldGonzález

24 de Abril de 2025 à59 12:41:59 WEST

24 de Abril de 2025 à59 12:41:59 WEST

GPT-4oは私のコードテストのほとんどを完璧にこなすので感動しました!しかし、その一つの奇妙な結果が気になりました。それでも、テキスト、グラフィック、音声での多様性は素晴らしいです。あの奇妙な結果を説明できれば完璧だったのに!🤔

0

0

![JustinAnderson]() JustinAnderson

JustinAnderson

23 de Abril de 2025 à28 06:12:28 WEST

23 de Abril de 2025 à28 06:12:28 WEST

¡El GPT-4o me impresionó con sus habilidades de codificación! Pasó todos mis tests excepto por un resultado extraño que me dejó pensando. Su versatilidad en texto, gráficos y voz es genial! Pero ese fallo, hay que arreglarlo, OpenAI! 😎

0

0

![NicholasClark]() NicholasClark

NicholasClark

23 de Abril de 2025 à49 03:12:49 WEST

23 de Abril de 2025 à49 03:12:49 WEST

GPT-4oのコードスキルには感心しました!私のテストをほぼ全てクリアしましたが、一つの奇妙な結果が気になります。テキスト、グラフィック、ボイスでの多才さは素晴らしい!でも、その一つのバグ、修正してほしいですね、OpenAI!😅

0

0

![DavidThomas]() DavidThomas

DavidThomas

22 de Abril de 2025 à24 18:04:24 WEST

22 de Abril de 2025 à24 18:04:24 WEST

GPT-4o is impressive, acing most of my coding tests! But that one weird result threw me off. Still, it's versatile across text, graphics, and voice. If only it could explain that odd outcome, it'd be perfect! 🤔

0

0

Se você tem acompanhado o mundo da tecnologia, provavelmente sabe que a OpenAI acabou de lançar seu mais recente modelo de linguagem de grande escala, o GPT-4o, onde o "o" significa "omni". Este novo modelo promete versatilidade em texto, gráficos e voz, e eu não podia esperar para testá-lo com meu conjunto padrão de testes de codificação. Esses testes foram executados contra uma ampla gama de modelos de IA, gerando resultados bastante fascinantes. Fique comigo até o final, porque há uma reviravolta que você não vai querer perder.

Se você está interessado em realizar seus próprios experimentos, confira este guia: Como eu testo a capacidade de codificação de um chatbot de IA - e você também pode. Ele descreve todos os testes que utilizo, juntamente com explicações detalhadas de como eles funcionam e o que procurar nos resultados.

Agora, vamos mergulhar nos resultados de cada teste e ver como o GPT-4o se compara aos concorrentes anteriores, como Microsoft Copilot, Meta AI, Meta Code Llama, Google Gemini Advanced e as versões anteriores do ChatGPT.

1. Escrevendo um Plugin para WordPress

Aqui está um vislumbre da interface do usuário do GPT-4o:

Curiosamente, o GPT-4o tomou a liberdade de incluir um arquivo JavaScript, que atualiza dinamicamente a contagem de linhas em ambos os campos. Embora o prompt não tenha explicitamente descartado o uso de JavaScript, essa abordagem criativa foi inesperada e eficaz. O JavaScript também aprimora a funcionalidade do botão Randomizar, permitindo múltiplos conjuntos de resultados sem a necessidade de recarregar a página inteira.

As linhas foram organizadas corretamente, e os duplicados foram devidamente separados conforme as especificações. É um código sólido, com apenas uma pequena ressalva: o botão Randomizar não foi colocado em sua própria linha, embora eu não tenha especificado isso no prompt, então não há penalidade por isso.

Aqui estão os resultados agregados para este e os testes anteriores:

- ChatGPT GPT-4o: Interface: boa, funcionalidade: boa

- Microsoft Copilot: Interface: adequada, funcionalidade: falhou

- Meta AI: Interface: adequada, funcionalidade: falhou

- Meta Code Llama: Falha completa

- Google Gemini Advanced: Interface: boa, funcionalidade: falhou

- ChatGPT 4: Interface: boa, funcionalidade: boa

- ChatGPT 3.5: Interface: boa, funcionalidade: boa

2. Reescrevendo uma Função de String

Este teste avalia a capacidade do modelo de lidar com conversões de dólares e centavos. O GPT-4o reescreveu com sucesso o código para rejeitar entradas que poderiam causar problemas nas linhas subsequentes, garantindo que apenas valores válidos de dólares e centavos sejam processados.

Fiquei um pouco desapontado por ele não ter adicionado automaticamente um zero à esquerda em valores como .75, convertendo-os para 0.75. No entanto, como não solicitei explicitamente esse recurso, não é uma falha da IA. Isso serve como um lembrete de que, mesmo quando uma IA entrega um código funcional, pode ser necessário refinar o prompt para obter exatamente o que você precisa.

Aqui estão os resultados agregados para este e os testes anteriores:

- ChatGPT GPT-4o: Sucesso

- Microsoft Copilot: Falhou

- Meta AI: Falhou

- Meta Code Llama: Sucesso

- Google Gemini Advanced: Falhou

- ChatGPT 4: Sucesso

- ChatGPT 3.5: Sucesso

3. Encontrando um Bug Irritante

Este teste é intrigante porque a solução não é imediatamente aparente. Fiquei inicialmente perplexo com esse erro durante minha própria codificação, então recorri ao primeiro modelo do ChatGPT para obter ajuda. Ele encontrou o erro instantaneamente, o que foi surpreendente na época.

Em contrapartida, três dos outros LLMs que testei não perceberam a distração neste problema. A mensagem de erro aponta para uma parte do código, mas o problema real está em outro lugar, exigindo um conhecimento profundo do framework WordPress para identificar.

Felizmente, o GPT-4o identificou corretamente o problema e descreveu a correção com precisão.

Aqui estão os resultados agregados para este e os testes anteriores:

- ChatGPT GPT-4o: Sucesso

- Microsoft Copilot: Falhou. Espetacularmente. Entusiasticamente. Com emojis.

- Meta AI: Sucesso

- Meta Code Llama: Falhou

- Google Gemini Advanced: Falhou

- ChatGPT 4: Sucesso

- ChatGPT 3.5: Sucesso

Até agora, o GPT-4o está com três acertos em três. Vamos ver como ele se sai no teste final.

4. Escrevendo um Script

Em resposta a este teste, o GPT-4o forneceu mais do que eu pedi. O teste envolve o uso da ferramenta de automação obscura para Mac, Keyboard Maestro, o AppleScript da Apple e o comportamento de script do Chrome. A propósito, o Keyboard Maestro é um divisor de águas para mim, tornando os Macs minha escolha para produtividade devido à sua capacidade de reprogramar o sistema operacional e os aplicativos.

Para passar, a IA precisa delinear corretamente uma solução usando uma combinação de código Keyboard Maestro, AppleScript e funcionalidade da API do Chrome.

Surpreendentemente, o GPT-4o me deu duas versões diferentes:

Ambas as versões interagiram corretamente com o Keyboard Maestro, mas diferiram no tratamento de sensibilidade a maiúsculas e minúsculas. A versão à esquerda estava incorreta porque o AppleScript não suporta "as lowercase". A versão à direita, que usava "contains" e era insensível a maiúsculas, funcionou bem.

Estou dando um passe ao GPT-4o, embora com cautela, porque ele entregou um código funcional. No entanto, retornar duas opções, uma das quais estava incorreta, me fez trabalhar extra para avaliar e escolher a correta. Isso poderia ter sido tão demorado quanto escrever o código eu mesmo.

Aqui estão os resultados agregados para este e os testes anteriores:

- ChatGPT GPT-4o: Sucesso, mas com ressalvas

- Microsoft Copilot: Falhou

- Meta AI: Falhou

- Meta Code Llama: Falhou

- Google Gemini Advanced: Sucesso

- ChatGPT 4: Sucesso

- ChatGPT 3.5: Falhou

Resultados Gerais

Aqui está como todos os modelos se saíram nos quatro testes:

- ChatGPT GPT-4o: 4 de 4 com sucesso, mas com aquela resposta estranha de dupla escolha

- Microsoft Copilot: 0 de 4 com sucesso

- Meta AI: 1 de 4 com sucesso

- Meta Code Llama: 1 de 4 com sucesso

- Google Gemini Advanced: 1 de 4 com sucesso

- ChatGPT 4: 4 de 4 com sucesso

- ChatGPT 3.5: 3 de 4 com sucesso

Até agora, o ChatGPT tem sido minha escolha para assistência em codificação. Ele sempre entregou (exceto quando não entregou). As outras IAs, em sua maioria, ficaram aquém nos meus testes. Mas o GPT-4o me surpreendeu com aquela resposta de dupla escolha no último teste. Isso me fez questionar o que está acontecendo dentro deste modelo que poderia causar tal contratempo.

Apesar disso, o GPT-4o continua sendo o melhor desempenho nos meus testes de codificação, então provavelmente continuarei usando-o e me familiarizando mais com suas peculiaridades. Alternativamente, posso voltar ao GPT-3.5 ou GPT-4 no ChatGPT Plus. Fique ligado; na próxima vez que o ChatGPT atualizar seu modelo, definitivamente repetirei esses testes para ver se ele consegue escolher consistentemente a resposta certa em todos os quatro testes.

Você já tentou codificar com algum desses modelos de IA? Qual foi sua experiência? Conte-nos nos comentários abaixo.

A IA Stitch do Google simplifica o processo de design de aplicativos

Google revela a ferramenta de design de IA Stitch no I/O 2025O Google apresentou o Stitch, sua revolucionária ferramenta de design de interface baseada em IA, durante a apresentação no Google I/O 2025

A IA Stitch do Google simplifica o processo de design de aplicativos

Google revela a ferramenta de design de IA Stitch no I/O 2025O Google apresentou o Stitch, sua revolucionária ferramenta de design de interface baseada em IA, durante a apresentação no Google I/O 2025

Claude 4 A IA supera seus antecessores em tarefas de codificação e raciocínio lógico

A Anthropic revelou seus modelos de IA Claude de última geração - Claude Opus 4 e Claude Sonnet 4 - que representam grandes avanços nos recursos de raciocínio híbrido, especialmente para aplicativos d

Claude 4 A IA supera seus antecessores em tarefas de codificação e raciocínio lógico

A Anthropic revelou seus modelos de IA Claude de última geração - Claude Opus 4 e Claude Sonnet 4 - que representam grandes avanços nos recursos de raciocínio híbrido, especialmente para aplicativos d

O Flowomatic AI Agents 2.0 transforma a automação comercial com tecnologia de ponta

No atual cenário competitivo dos negócios, a inteligência artificial se tornou a força motriz por trás da eficiência operacional e das estratégias de crescimento. O Flowomatic AI Agents 2.0 representa

O Flowomatic AI Agents 2.0 transforma a automação comercial com tecnologia de ponta

No atual cenário competitivo dos negócios, a inteligência artificial se tornou a força motriz por trás da eficiência operacional e das estratégias de crescimento. O Flowomatic AI Agents 2.0 representa

26 de Abril de 2025 à22 12:46:22 WEST

26 de Abril de 2025 à22 12:46:22 WEST

GPT-4o é impressionante, passando na maioria dos meus testes de codificação! Mas aquele resultado estranho me deixou confuso. Ainda assim, é versátil em texto, gráficos e voz. Se ao menos pudesse explicar aquele resultado estranho, seria perfeito! 🤔

0

0

25 de Abril de 2025 à39 19:21:39 WEST

25 de Abril de 2025 à39 19:21:39 WEST

GPT-4o thật ấn tượng, vượt qua hầu hết các bài kiểm tra mã hóa của tôi! Nhưng kết quả lạ đó làm tôi bối rối. Tuy nhiên, nó rất linh hoạt trong văn bản, đồ họa và giọng nói. Giá mà nó có thể giải thích kết quả lạ đó, thì sẽ hoàn hảo! 🤔

0

0

24 de Abril de 2025 à59 12:41:59 WEST

24 de Abril de 2025 à59 12:41:59 WEST

GPT-4oは私のコードテストのほとんどを完璧にこなすので感動しました!しかし、その一つの奇妙な結果が気になりました。それでも、テキスト、グラフィック、音声での多様性は素晴らしいです。あの奇妙な結果を説明できれば完璧だったのに!🤔

0

0

23 de Abril de 2025 à28 06:12:28 WEST

23 de Abril de 2025 à28 06:12:28 WEST

¡El GPT-4o me impresionó con sus habilidades de codificación! Pasó todos mis tests excepto por un resultado extraño que me dejó pensando. Su versatilidad en texto, gráficos y voz es genial! Pero ese fallo, hay que arreglarlo, OpenAI! 😎

0

0

23 de Abril de 2025 à49 03:12:49 WEST

23 de Abril de 2025 à49 03:12:49 WEST

GPT-4oのコードスキルには感心しました!私のテストをほぼ全てクリアしましたが、一つの奇妙な結果が気になります。テキスト、グラフィック、ボイスでの多才さは素晴らしい!でも、その一つのバグ、修正してほしいですね、OpenAI!😅

0

0

22 de Abril de 2025 à24 18:04:24 WEST

22 de Abril de 2025 à24 18:04:24 WEST

GPT-4o is impressive, acing most of my coding tests! But that one weird result threw me off. Still, it's versatile across text, graphics, and voice. If only it could explain that odd outcome, it'd be perfect! 🤔

0

0