人類は静かにビーデン時代の責任あるAIの誓約をウェブサイトから除去します

Anthropic、バイデン時代のAI安全コミットメントをウェブサイトから削除

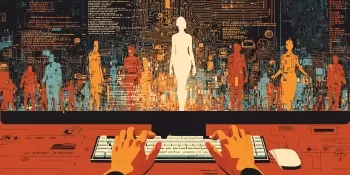

AI業界の主要企業であるAnthropicが、先週、透明性ハブからバイデン時代の安全なAI開発に関するコミットメントを静かに削除し、注目を集めています。この変更は、AI監視団体であるThe Midas Projectによって最初に発見され、バイアスを含むAIリスクに関する情報や研究を政府と共有すると約束していた文言がなくなっていることが指摘されました。

これらのコミットメントは、Anthropicが2023年7月にOpenAI、Google、Metaなどの他のテック大手とともに結んだ自主的な合意の一部でした。この合意は、バイデン政権が責任あるAI開発を推進するための礎であり、その多くの側面が後にバイデンのAI大統領令に盛り込まれました。参加企業は、モデル公開前のセキュリティテストの実施、AI生成コンテンツへの透かし導入、堅牢なデータプライバシー基盤の構築といった特定の基準を遵守することを約束していました。

さらに、Anthropicは、バイデンの大統領令に基づいて設立されたAI Safety Instituteと協力し、これらの優先事項を推進することに同意していました。しかし、トランプ政権がこの研究所を解散する可能性が高いため、これらの取り組みの将来は不透明です。

興味深いことに、Anthropicはこれらのコミットメントをウェブサイトから削除したことについて公表していません。同社は、現在の責任あるAIに関する立場は、バイデン時代の合意とは無関係であるか、またはそれ以前のものだと主張しています。

トランプ政権下での広範な影響

この動きは、トランプ政権下でのAI政策と規制のより大きな変化の一部です。就任初日、トランプはバイデンのAIに関する大統領令を覆し、複数のAI専門家を政府の役職から解任し、研究資金を削減しました。これらの行動により、主要なAI企業間でトーンの顕著な変化が見られ、一部の企業は政府との契約を拡大し、トランプ政権下で進化しつつあるAI政策の風景に影響を与えようとしています。

例えば、Googleのような企業は、責任あるAIの定義を再構築しており、すでにそれほど厳格ではなかった基準を緩和する可能性があります。バイデン政権時に確立された限定的なAI規制の多くが解体されるリスクにさらされており、企業は自己規制や第三者による監督を受ける外部のインセンティブがさらに少なくなる可能性があります。

注目すべきは、AIシステムにおけるバイアスや差別の安全チェックに関する議論が、トランプのAIに関する公の発言で顕著に欠如していることであり、これらの優先事項からの潜在的なシフトを示唆しています。

関連記事

AIインペイントテクニックをマスターしよう:完璧な画像編集のための中間ガイド

MidjourneyのAIインペインティング・テクノロジーは、クリエイターがAIで生成されたアートワークを精密かつ完璧に仕上げるための画期的な機能です。この決定版ガイドでは、この強力なツールを活用して、微妙な改良から劇的な構図の変更まで、Midjourneyの直感的なプラットフォームでクリエイティブなプロジェクトを向上させるための専門的なテクニックを紹介します。キーポイントMidjourneyのイ

AIインペイントテクニックをマスターしよう:完璧な画像編集のための中間ガイド

MidjourneyのAIインペインティング・テクノロジーは、クリエイターがAIで生成されたアートワークを精密かつ完璧に仕上げるための画期的な機能です。この決定版ガイドでは、この強力なツールを活用して、微妙な改良から劇的な構図の変更まで、Midjourneyの直感的なプラットフォームでクリエイティブなプロジェクトを向上させるための専門的なテクニックを紹介します。キーポイントMidjourneyのイ

Manus、ウェブスクレイピングのための100以上のエージェントを備えたAIツール「Wide Research」を発表

中国のAIイノベーターであるManusは、コンシューマーとプロフェッショナルの両方に対応する先駆的なマルチエージェント・オーケストレーション・プラットフォームで注目を集めたが、従来のAI研究アプローチに挑戦する同社の技術の画期的なアプリケーションを発表した。AIを活用した研究の再考OpenAI、Google、xAIのような競合他社は、詳細なレポートを作成するために何時間も調査を行うことができる特別

Manus、ウェブスクレイピングのための100以上のエージェントを備えたAIツール「Wide Research」を発表

中国のAIイノベーターであるManusは、コンシューマーとプロフェッショナルの両方に対応する先駆的なマルチエージェント・オーケストレーション・プラットフォームで注目を集めたが、従来のAI研究アプローチに挑戦する同社の技術の画期的なアプリケーションを発表した。AIを活用した研究の再考OpenAI、Google、xAIのような競合他社は、詳細なレポートを作成するために何時間も調査を行うことができる特別

LLMが指示を無視する理由と効果的な修正方法

大規模言語モデルが指示をスキップする理由を理解する大規模言語モデル(LLM)は、会話インターフェースからコンテンツの自動生成やプログラミング支援に至るまで、高度なアプリケーションを可能にし、AIとの対話方法を一変させました。しかし、ユーザーはしばしばフラストレーションのたまる制限に遭遇します。これらのモデルは、特に複雑で長いプロンプトにおいて、特定の指示を見落とすことがあるのです。この不完全なタ

コメント (4)

0/200

LLMが指示を無視する理由と効果的な修正方法

大規模言語モデルが指示をスキップする理由を理解する大規模言語モデル(LLM)は、会話インターフェースからコンテンツの自動生成やプログラミング支援に至るまで、高度なアプリケーションを可能にし、AIとの対話方法を一変させました。しかし、ユーザーはしばしばフラストレーションのたまる制限に遭遇します。これらのモデルは、特に複雑で長いプロンプトにおいて、特定の指示を見落とすことがあるのです。この不完全なタ

コメント (4)

0/200

![AlbertMiller]() AlbertMiller

AlbertMiller

2025年8月25日 14:33:49 JST

2025年8月25日 14:33:49 JST

Wow, Anthropic pulling that AI safety pledge is wild! 🤯 Makes you wonder if they're dodging accountability or just streamlining their site. Either way, it’s a bold move in today’s AI race!

0

0

![PaulTaylor]() PaulTaylor

PaulTaylor

2025年8月17日 6:00:59 JST

2025年8月17日 6:00:59 JST

Wow, Anthropic pulling those AI safety pledges is shady! 🤔 Makes you wonder what’s cooking behind closed doors—less transparency in AI dev is a bold move, and not the good kind.

0

0

![JuanLewis]() JuanLewis

JuanLewis

2025年8月4日 15:01:00 JST

2025年8月4日 15:01:00 JST

Interesting move by Anthropic, but kinda shady to just erase those AI safety promises. Makes you wonder what’s cooking behind the scenes. 🧐

0

0

![PaulHill]() PaulHill

PaulHill

2025年7月28日 10:20:54 JST

2025年7月28日 10:20:54 JST

I was shocked to see Anthropic pull those AI safety pledges! 🤯 It makes you wonder if they're dodging accountability or just cleaning up their site. Either way, it’s a bold move in today’s AI race.

0

0

Anthropic、バイデン時代のAI安全コミットメントをウェブサイトから削除

AI業界の主要企業であるAnthropicが、先週、透明性ハブからバイデン時代の安全なAI開発に関するコミットメントを静かに削除し、注目を集めています。この変更は、AI監視団体であるThe Midas Projectによって最初に発見され、バイアスを含むAIリスクに関する情報や研究を政府と共有すると約束していた文言がなくなっていることが指摘されました。

これらのコミットメントは、Anthropicが2023年7月にOpenAI、Google、Metaなどの他のテック大手とともに結んだ自主的な合意の一部でした。この合意は、バイデン政権が責任あるAI開発を推進するための礎であり、その多くの側面が後にバイデンのAI大統領令に盛り込まれました。参加企業は、モデル公開前のセキュリティテストの実施、AI生成コンテンツへの透かし導入、堅牢なデータプライバシー基盤の構築といった特定の基準を遵守することを約束していました。

さらに、Anthropicは、バイデンの大統領令に基づいて設立されたAI Safety Instituteと協力し、これらの優先事項を推進することに同意していました。しかし、トランプ政権がこの研究所を解散する可能性が高いため、これらの取り組みの将来は不透明です。

興味深いことに、Anthropicはこれらのコミットメントをウェブサイトから削除したことについて公表していません。同社は、現在の責任あるAIに関する立場は、バイデン時代の合意とは無関係であるか、またはそれ以前のものだと主張しています。

トランプ政権下での広範な影響

この動きは、トランプ政権下でのAI政策と規制のより大きな変化の一部です。就任初日、トランプはバイデンのAIに関する大統領令を覆し、複数のAI専門家を政府の役職から解任し、研究資金を削減しました。これらの行動により、主要なAI企業間でトーンの顕著な変化が見られ、一部の企業は政府との契約を拡大し、トランプ政権下で進化しつつあるAI政策の風景に影響を与えようとしています。

例えば、Googleのような企業は、責任あるAIの定義を再構築しており、すでにそれほど厳格ではなかった基準を緩和する可能性があります。バイデン政権時に確立された限定的なAI規制の多くが解体されるリスクにさらされており、企業は自己規制や第三者による監督を受ける外部のインセンティブがさらに少なくなる可能性があります。

注目すべきは、AIシステムにおけるバイアスや差別の安全チェックに関する議論が、トランプのAIに関する公の発言で顕著に欠如していることであり、これらの優先事項からの潜在的なシフトを示唆しています。

AIインペイントテクニックをマスターしよう:完璧な画像編集のための中間ガイド

MidjourneyのAIインペインティング・テクノロジーは、クリエイターがAIで生成されたアートワークを精密かつ完璧に仕上げるための画期的な機能です。この決定版ガイドでは、この強力なツールを活用して、微妙な改良から劇的な構図の変更まで、Midjourneyの直感的なプラットフォームでクリエイティブなプロジェクトを向上させるための専門的なテクニックを紹介します。キーポイントMidjourneyのイ

AIインペイントテクニックをマスターしよう:完璧な画像編集のための中間ガイド

MidjourneyのAIインペインティング・テクノロジーは、クリエイターがAIで生成されたアートワークを精密かつ完璧に仕上げるための画期的な機能です。この決定版ガイドでは、この強力なツールを活用して、微妙な改良から劇的な構図の変更まで、Midjourneyの直感的なプラットフォームでクリエイティブなプロジェクトを向上させるための専門的なテクニックを紹介します。キーポイントMidjourneyのイ

Manus、ウェブスクレイピングのための100以上のエージェントを備えたAIツール「Wide Research」を発表

中国のAIイノベーターであるManusは、コンシューマーとプロフェッショナルの両方に対応する先駆的なマルチエージェント・オーケストレーション・プラットフォームで注目を集めたが、従来のAI研究アプローチに挑戦する同社の技術の画期的なアプリケーションを発表した。AIを活用した研究の再考OpenAI、Google、xAIのような競合他社は、詳細なレポートを作成するために何時間も調査を行うことができる特別

Manus、ウェブスクレイピングのための100以上のエージェントを備えたAIツール「Wide Research」を発表

中国のAIイノベーターであるManusは、コンシューマーとプロフェッショナルの両方に対応する先駆的なマルチエージェント・オーケストレーション・プラットフォームで注目を集めたが、従来のAI研究アプローチに挑戦する同社の技術の画期的なアプリケーションを発表した。AIを活用した研究の再考OpenAI、Google、xAIのような競合他社は、詳細なレポートを作成するために何時間も調査を行うことができる特別

LLMが指示を無視する理由と効果的な修正方法

大規模言語モデルが指示をスキップする理由を理解する大規模言語モデル(LLM)は、会話インターフェースからコンテンツの自動生成やプログラミング支援に至るまで、高度なアプリケーションを可能にし、AIとの対話方法を一変させました。しかし、ユーザーはしばしばフラストレーションのたまる制限に遭遇します。これらのモデルは、特に複雑で長いプロンプトにおいて、特定の指示を見落とすことがあるのです。この不完全なタ

LLMが指示を無視する理由と効果的な修正方法

大規模言語モデルが指示をスキップする理由を理解する大規模言語モデル(LLM)は、会話インターフェースからコンテンツの自動生成やプログラミング支援に至るまで、高度なアプリケーションを可能にし、AIとの対話方法を一変させました。しかし、ユーザーはしばしばフラストレーションのたまる制限に遭遇します。これらのモデルは、特に複雑で長いプロンプトにおいて、特定の指示を見落とすことがあるのです。この不完全なタ

2025年8月25日 14:33:49 JST

2025年8月25日 14:33:49 JST

Wow, Anthropic pulling that AI safety pledge is wild! 🤯 Makes you wonder if they're dodging accountability or just streamlining their site. Either way, it’s a bold move in today’s AI race!

0

0

2025年8月17日 6:00:59 JST

2025年8月17日 6:00:59 JST

Wow, Anthropic pulling those AI safety pledges is shady! 🤔 Makes you wonder what’s cooking behind closed doors—less transparency in AI dev is a bold move, and not the good kind.

0

0

2025年8月4日 15:01:00 JST

2025年8月4日 15:01:00 JST

Interesting move by Anthropic, but kinda shady to just erase those AI safety promises. Makes you wonder what’s cooking behind the scenes. 🧐

0

0

2025年7月28日 10:20:54 JST

2025年7月28日 10:20:54 JST

I was shocked to see Anthropic pull those AI safety pledges! 🤯 It makes you wonder if they're dodging accountability or just cleaning up their site. Either way, it’s a bold move in today’s AI race.

0

0