人類默默地默默地刪除了拜登時代的負責人AI承諾

Anthropic 從網站移除拜登時代的 AI 安全承諾

在一項引人注目的舉動中,AI 行業的領軍企業 Anthropic 上週悄悄地從其透明度中心移除拜登時代關於安全 AI 開發的承諾。這一變化首先由 AI 監察團體 The Midas Project 發現,該團體注意到原本承諾與政府分享有關 AI 風險(包括偏見)資訊和研究的語言已不復存在。

這些承諾是 Anthropic 於 2023 年 7 月與其他科技巨頭如 OpenAI、Google 和 Meta 共同簽署的自願協議的一部分。該協議是拜登政府推動負責任 AI 開發的基石,其中許多內容後來被納入拜登的 AI 行政命令。參與公司承諾遵守特定標準,例如在模型發布前進行安全測試、為 AI 生成的內容添加水印,以及開發穩健的數據隱私基礎設施。

此外,Anthropic 曾同意與拜登行政命令下成立的 AI 安全研究所合作,以推進這些優先事項。然而,隨著川普政府可能解散該研究所,這些舉措的未來充滿不確定性。

有趣的是,Anthropic 並未公開宣布從其網站移除這些承諾。該公司堅稱,其當前關於負責任 AI 的立場與拜登時代的協議無關或早於該協議。

川普政府下的更廣泛影響

這一發展是川普政府下 AI 政策與監管更廣泛轉變的一部分。川普在就職第一天即撤銷了拜登的 AI 行政命令,並已將數名 AI 專家從政府職位中撤職並削減研究資金。這些行動為主要 AI 公司的語氣變化奠定了基礎,其中一些公司現在正尋求擴大其政府合同並影響川普政府下仍在演變的 AI 政策格局。

例如,Google 等公司正在重新定義什麼是負責任的 AI,可能放寬本就不太嚴格的標準。隨著拜登政府期間建立的有限 AI 監管面臨被拆除的風險,公司可能發現自我監管或接受第三方監督的外部激勵更少。

值得注意的是,川普在 AI 的公開聲明中明顯缺乏關於 AI 系統偏見和歧視安全檢查的討論,這表明這些優先事項可能會發生轉變。

相關文章

美國政府投資 Intel 以提升國內半導體產量

川普政府已將建立美國在人工智慧領域的領導地位視為首要任務,而半導體生產的重組則是其中一項基石策略。最近的政策舉措,包括建議的關稅和財務獎勵措施,都顯示出加強國內晶片製造能力的決心。八月,政府將現有的半導體製造補助轉換為英特爾公司 10% 的股權,成為頭條新聞。這項獨特的協議包含了一些條款,如果英特爾在其晶圓代工業務(為全球客戶生產客製化晶片)的所有權在五年內低於多數控制權,聯邦政府將獲得額外的

美國政府投資 Intel 以提升國內半導體產量

川普政府已將建立美國在人工智慧領域的領導地位視為首要任務,而半導體生產的重組則是其中一項基石策略。最近的政策舉措,包括建議的關稅和財務獎勵措施,都顯示出加強國內晶片製造能力的決心。八月,政府將現有的半導體製造補助轉換為英特爾公司 10% 的股權,成為頭條新聞。這項獨特的協議包含了一些條款,如果英特爾在其晶圓代工業務(為全球客戶生產客製化晶片)的所有權在五年內低於多數控制權,聯邦政府將獲得額外的

Apple 的 Craig Federighi 承認人工智慧 Siri 早期階段有嚴重缺陷

蘋果高層解釋 Siri 升級延遲的原因在 WWDC 2024 期間,Apple 原本承諾會大幅提升 Siri 功能,包括個人化情境感知和應用程式自動化功能。然而,該公司最近證實這些功能的交付將會延遲。高級副總裁 Craig Federighi (軟體工程) 與 Greg Joswiak (全球行銷) 在接受《華爾街日報》的 Joanna Stern 獨家專訪時,談到這些延遲的問題。Fede

Apple 的 Craig Federighi 承認人工智慧 Siri 早期階段有嚴重缺陷

蘋果高層解釋 Siri 升級延遲的原因在 WWDC 2024 期間,Apple 原本承諾會大幅提升 Siri 功能,包括個人化情境感知和應用程式自動化功能。然而,該公司最近證實這些功能的交付將會延遲。高級副總裁 Craig Federighi (軟體工程) 與 Greg Joswiak (全球行銷) 在接受《華爾街日報》的 Joanna Stern 獨家專訪時,談到這些延遲的問題。Fede

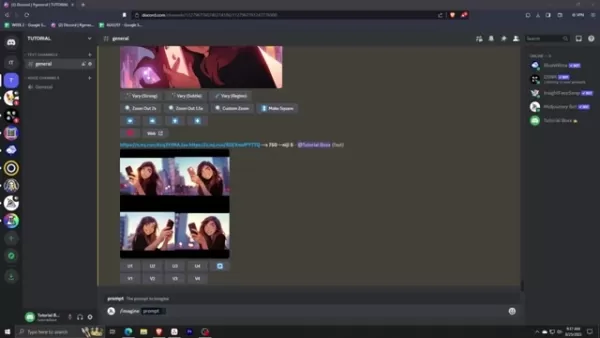

掌握 AI Inpainting 技術:無懈可擊的圖像編輯中途指南

探索 Midjourney 的 AI Inpainting 技術的變革能力,這項革命性的功能可讓創作者以外科手術般的精準度,精緻和完善 AI 所產生的作品。這本權威指南揭示了如何運用這項強大工具來提升您的創意專案的專業技巧,無論您是要進行微妙的改進或戲劇性的構圖變化 - 一切都在 Midjourney 的直覺式平台中進行。重點Midjourney 的內繪工具可透過選擇性編輯,對影像進行有針對性的修

評論 (4)

0/200

掌握 AI Inpainting 技術:無懈可擊的圖像編輯中途指南

探索 Midjourney 的 AI Inpainting 技術的變革能力,這項革命性的功能可讓創作者以外科手術般的精準度,精緻和完善 AI 所產生的作品。這本權威指南揭示了如何運用這項強大工具來提升您的創意專案的專業技巧,無論您是要進行微妙的改進或戲劇性的構圖變化 - 一切都在 Midjourney 的直覺式平台中進行。重點Midjourney 的內繪工具可透過選擇性編輯,對影像進行有針對性的修

評論 (4)

0/200

![AlbertMiller]() AlbertMiller

AlbertMiller

2025-08-25 13:33:49

2025-08-25 13:33:49

Wow, Anthropic pulling that AI safety pledge is wild! 🤯 Makes you wonder if they're dodging accountability or just streamlining their site. Either way, it’s a bold move in today’s AI race!

0

0

![PaulTaylor]() PaulTaylor

PaulTaylor

2025-08-17 05:00:59

2025-08-17 05:00:59

Wow, Anthropic pulling those AI safety pledges is shady! 🤔 Makes you wonder what’s cooking behind closed doors—less transparency in AI dev is a bold move, and not the good kind.

0

0

![JuanLewis]() JuanLewis

JuanLewis

2025-08-04 14:01:00

2025-08-04 14:01:00

Interesting move by Anthropic, but kinda shady to just erase those AI safety promises. Makes you wonder what’s cooking behind the scenes. 🧐

0

0

![PaulHill]() PaulHill

PaulHill

2025-07-28 09:20:54

2025-07-28 09:20:54

I was shocked to see Anthropic pull those AI safety pledges! 🤯 It makes you wonder if they're dodging accountability or just cleaning up their site. Either way, it’s a bold move in today’s AI race.

0

0

Anthropic 從網站移除拜登時代的 AI 安全承諾

在一項引人注目的舉動中,AI 行業的領軍企業 Anthropic 上週悄悄地從其透明度中心移除拜登時代關於安全 AI 開發的承諾。這一變化首先由 AI 監察團體 The Midas Project 發現,該團體注意到原本承諾與政府分享有關 AI 風險(包括偏見)資訊和研究的語言已不復存在。

這些承諾是 Anthropic 於 2023 年 7 月與其他科技巨頭如 OpenAI、Google 和 Meta 共同簽署的自願協議的一部分。該協議是拜登政府推動負責任 AI 開發的基石,其中許多內容後來被納入拜登的 AI 行政命令。參與公司承諾遵守特定標準,例如在模型發布前進行安全測試、為 AI 生成的內容添加水印,以及開發穩健的數據隱私基礎設施。

此外,Anthropic 曾同意與拜登行政命令下成立的 AI 安全研究所合作,以推進這些優先事項。然而,隨著川普政府可能解散該研究所,這些舉措的未來充滿不確定性。

有趣的是,Anthropic 並未公開宣布從其網站移除這些承諾。該公司堅稱,其當前關於負責任 AI 的立場與拜登時代的協議無關或早於該協議。

川普政府下的更廣泛影響

這一發展是川普政府下 AI 政策與監管更廣泛轉變的一部分。川普在就職第一天即撤銷了拜登的 AI 行政命令,並已將數名 AI 專家從政府職位中撤職並削減研究資金。這些行動為主要 AI 公司的語氣變化奠定了基礎,其中一些公司現在正尋求擴大其政府合同並影響川普政府下仍在演變的 AI 政策格局。

例如,Google 等公司正在重新定義什麼是負責任的 AI,可能放寬本就不太嚴格的標準。隨著拜登政府期間建立的有限 AI 監管面臨被拆除的風險,公司可能發現自我監管或接受第三方監督的外部激勵更少。

值得注意的是,川普在 AI 的公開聲明中明顯缺乏關於 AI 系統偏見和歧視安全檢查的討論,這表明這些優先事項可能會發生轉變。

美國政府投資 Intel 以提升國內半導體產量

川普政府已將建立美國在人工智慧領域的領導地位視為首要任務,而半導體生產的重組則是其中一項基石策略。最近的政策舉措,包括建議的關稅和財務獎勵措施,都顯示出加強國內晶片製造能力的決心。八月,政府將現有的半導體製造補助轉換為英特爾公司 10% 的股權,成為頭條新聞。這項獨特的協議包含了一些條款,如果英特爾在其晶圓代工業務(為全球客戶生產客製化晶片)的所有權在五年內低於多數控制權,聯邦政府將獲得額外的

美國政府投資 Intel 以提升國內半導體產量

川普政府已將建立美國在人工智慧領域的領導地位視為首要任務,而半導體生產的重組則是其中一項基石策略。最近的政策舉措,包括建議的關稅和財務獎勵措施,都顯示出加強國內晶片製造能力的決心。八月,政府將現有的半導體製造補助轉換為英特爾公司 10% 的股權,成為頭條新聞。這項獨特的協議包含了一些條款,如果英特爾在其晶圓代工業務(為全球客戶生產客製化晶片)的所有權在五年內低於多數控制權,聯邦政府將獲得額外的

Apple 的 Craig Federighi 承認人工智慧 Siri 早期階段有嚴重缺陷

蘋果高層解釋 Siri 升級延遲的原因在 WWDC 2024 期間,Apple 原本承諾會大幅提升 Siri 功能,包括個人化情境感知和應用程式自動化功能。然而,該公司最近證實這些功能的交付將會延遲。高級副總裁 Craig Federighi (軟體工程) 與 Greg Joswiak (全球行銷) 在接受《華爾街日報》的 Joanna Stern 獨家專訪時,談到這些延遲的問題。Fede

Apple 的 Craig Federighi 承認人工智慧 Siri 早期階段有嚴重缺陷

蘋果高層解釋 Siri 升級延遲的原因在 WWDC 2024 期間,Apple 原本承諾會大幅提升 Siri 功能,包括個人化情境感知和應用程式自動化功能。然而,該公司最近證實這些功能的交付將會延遲。高級副總裁 Craig Federighi (軟體工程) 與 Greg Joswiak (全球行銷) 在接受《華爾街日報》的 Joanna Stern 獨家專訪時,談到這些延遲的問題。Fede

掌握 AI Inpainting 技術:無懈可擊的圖像編輯中途指南

探索 Midjourney 的 AI Inpainting 技術的變革能力,這項革命性的功能可讓創作者以外科手術般的精準度,精緻和完善 AI 所產生的作品。這本權威指南揭示了如何運用這項強大工具來提升您的創意專案的專業技巧,無論您是要進行微妙的改進或戲劇性的構圖變化 - 一切都在 Midjourney 的直覺式平台中進行。重點Midjourney 的內繪工具可透過選擇性編輯,對影像進行有針對性的修

掌握 AI Inpainting 技術:無懈可擊的圖像編輯中途指南

探索 Midjourney 的 AI Inpainting 技術的變革能力,這項革命性的功能可讓創作者以外科手術般的精準度,精緻和完善 AI 所產生的作品。這本權威指南揭示了如何運用這項強大工具來提升您的創意專案的專業技巧,無論您是要進行微妙的改進或戲劇性的構圖變化 - 一切都在 Midjourney 的直覺式平台中進行。重點Midjourney 的內繪工具可透過選擇性編輯,對影像進行有針對性的修

2025-08-25 13:33:49

2025-08-25 13:33:49

Wow, Anthropic pulling that AI safety pledge is wild! 🤯 Makes you wonder if they're dodging accountability or just streamlining their site. Either way, it’s a bold move in today’s AI race!

0

0

2025-08-17 05:00:59

2025-08-17 05:00:59

Wow, Anthropic pulling those AI safety pledges is shady! 🤔 Makes you wonder what’s cooking behind closed doors—less transparency in AI dev is a bold move, and not the good kind.

0

0

2025-08-04 14:01:00

2025-08-04 14:01:00

Interesting move by Anthropic, but kinda shady to just erase those AI safety promises. Makes you wonder what’s cooking behind the scenes. 🧐

0

0

2025-07-28 09:20:54

2025-07-28 09:20:54

I was shocked to see Anthropic pull those AI safety pledges! 🤯 It makes you wonder if they're dodging accountability or just cleaning up their site. Either way, it’s a bold move in today’s AI race.

0

0