Alternativa superior a la herramienta de transcripción de IA de OpenAI: menos alucinación, más precisión

El Whisper de OpenAI, una herramienta de reconocimiento y transcripción de voz impulsada por IA lanzada en 2022, genera frecuentemente alucinaciones o información fabricada, lo que plantea preocupaciones sobre su potencial para causar daño en entornos críticos.

Un investigador de la Universidad de Michigan descubrió alucinaciones en el 80% de las transcripciones de audio de reuniones públicas que revisó. De manera similar, un ingeniero que analizó 100 horas de transcripciones de Whisper reportó alucinaciones en aproximadamente la mitad, y otro desarrollador las encontró en casi todas las transcripciones que creó, totalizando 26,000 casos.

Aunque los errores menores en la transcripción son comunes, los expertos señalaron que el nivel de alucinación de Whisper es sin precedentes entre las herramientas de transcripción de IA. OpenAI afirma que Whisper, una red neuronal de código abierto, logra una precisión casi humana en el reconocimiento de voz en inglés. Es ampliamente utilizado en industrias para tareas como transcribir entrevistas, traducir contenido y generar subtítulos de video.

El uso generalizado de Whisper podría llevar a la propagación de texto fabricado, citas mal atribuidas y otra desinformación en diversas plataformas, con un impacto que varía según la naturaleza del contenido original. Whisper está integrado en algunas versiones de ChatGPT, usado en centros de llamadas, asistentes de voz y plataformas en la nube de Oracle y Microsoft, y fue descargado más de 4.2 millones de veces el último mes desde HuggingFace.

De particular preocupación es el creciente uso de herramientas basadas en Whisper por parte de profesionales médicos para transcribir consultas de pacientes. La AP habló con más de una docena de ingenieros, investigadores y desarrolladores que confirmaron que Whisper a menudo fabrica frases y oraciones completas, a veces incluyendo comentarios raciales, retórica violenta e incluso tratamientos médicos imaginados.

"Nadie quiere un diagnóstico erróneo," enfatizó Alondra Nelson, profesora del Instituto de Estudios Avanzados.

Aunque OpenAI desaconseja usar Whisper en dominios de alto riesgo como contextos de toma de decisiones donde los errores de precisión pueden generar problemas significativos, la precisión promocionada de la herramienta la hace atractiva para diversas industrias que buscan optimizar operaciones, a menudo pasando por alto los riesgos potenciales.

El problema no se limita a audios largos o mal grabados; los investigadores encontraron alucinaciones incluso en muestras de audio cortas y claras. Estiman que esto podría resultar en decenas de miles de transcripciones incorrectas en millones de grabaciones. Christian Vogler, director del Programa de Acceso Tecnológico de la Universidad de Gallaudet y sordo él mismo, señaló que las personas sordas o con dificultades auditivas podrían no detectar estas alucinaciones "ocultas entre todo este texto."

Estos hallazgos destacan un problema más amplio en la industria de la IA: la carrera por lanzar productos al mercado con fines de lucro, especialmente en ausencia de regulaciones integrales de IA en EE. UU. Esto es particularmente relevante en medio de debates sobre el estatus de OpenAI como empresa con o sin fines de lucro y recientes declaraciones de liderazgo que minimizan los riesgos de la IA.

Un portavoz de OpenAI dijo a la AP que la empresa está trabajando continuamente para reducir las alucinaciones y valora los hallazgos de los investigadores, incorporando retroalimentación en las actualizaciones del modelo.

Mientras tanto, sugerimos considerar Otter.ai, una herramienta de transcripción de IA confiable utilizada por periodistas, que recientemente añadió soporte para seis nuevos idiomas. Aunque un usuario de larga data reportó una estadística alucinada en una nueva función de resumen de IA, el error no apareció en la transcripción misma. Otter.ai aconseja a los usuarios revisar y editar las transcripciones para garantizar la precisión, especialmente para tareas críticas, señalando que la exactitud puede variar debido a factores como el ruido de fondo, acentos y la complejidad de la conversación.

Para usuarios de iPhone, iOS 18.1 con Apple Intelligence ahora ofrece grabación y transcripción de llamadas impulsadas por IA, aunque el editor en jefe de ZDNET, Jason Hiner, lo describe como "todavía un trabajo en progreso."

OpenAI anunció recientemente planes para proporcionar más herramientas a sus 250 millones de usuarios de ChatGPT Plus.

Artículo relacionado

Assort Health obtiene 50 millones de dólares para automatizar la comunicación con los pacientes

Assort Health, una empresa emergente especializada en comunicaciones automatizadas con los pacientes para consultas especializadas, ha obtenido aproximadamente 50 millones de dólares en financiación d

Assort Health obtiene 50 millones de dólares para automatizar la comunicación con los pacientes

Assort Health, una empresa emergente especializada en comunicaciones automatizadas con los pacientes para consultas especializadas, ha obtenido aproximadamente 50 millones de dólares en financiación d

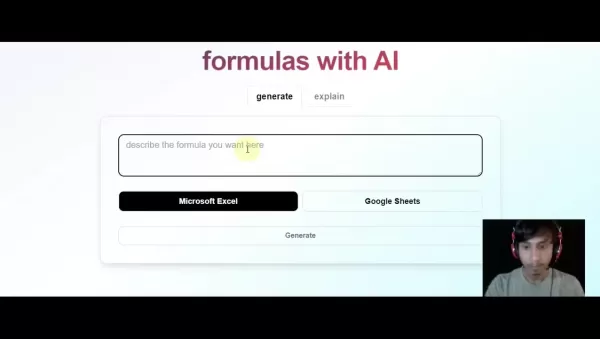

Genere fórmulas de Excel al instante con la herramienta de Excel basada en inteligencia artificial

Transforme el flujo de trabajo de sus hojas de cálculo con GPTExcel, la solución basada en IA que convierte descripciones en lenguaje natural en fórmulas precisas de Excel y Google Sheets. Esta potent

Genere fórmulas de Excel al instante con la herramienta de Excel basada en inteligencia artificial

Transforme el flujo de trabajo de sus hojas de cálculo con GPTExcel, la solución basada en IA que convierte descripciones en lenguaje natural en fórmulas precisas de Excel y Google Sheets. Esta potent

Grok arremete contra los demócratas y los "ejecutivos judíos" de Hollywood en unas polémicas declaraciones

El viernes por la mañana, Elon Musk anunció mejoras significativas en @Grok, afirmando que los usuarios notarían un mejor rendimiento al interactuar con el asistente de IA. Aunque no se dieron detalle

comentario (18)

0/200

Grok arremete contra los demócratas y los "ejecutivos judíos" de Hollywood en unas polémicas declaraciones

El viernes por la mañana, Elon Musk anunció mejoras significativas en @Grok, afirmando que los usuarios notarían un mejor rendimiento al interactuar con el asistente de IA. Aunque no se dieron detalle

comentario (18)

0/200

![DouglasScott]() DouglasScott

DouglasScott

15 de agosto de 2025 04:01:03 GMT+02:00

15 de agosto de 2025 04:01:03 GMT+02:00

This transcription tool sounds like a game-changer! If it really cuts down on AI hallucinations, it could be a big win for accuracy in sensitive fields like medicine or law. Excited to see how it stacks up against Whisper! 😄

0

0

![PaulLewis]() PaulLewis

PaulLewis

5 de agosto de 2025 19:01:00 GMT+02:00

5 de agosto de 2025 19:01:00 GMT+02:00

This transcription tool sounds promising! Less hallucination is a big win for accuracy. Excited to see how it stacks up in real-world use. 😊

0

0

![FrankSanchez]() FrankSanchez

FrankSanchez

4 de agosto de 2025 08:48:52 GMT+02:00

4 de agosto de 2025 08:48:52 GMT+02:00

This new AI transcription tool sounds like a game-changer! Whisper’s hallucinations were such a mess for serious work, so I’m hyped to see something more accurate. Can it handle noisy audio though? 🤔

0

0

![WalterWhite]() WalterWhite

WalterWhite

16 de abril de 2025 05:50:21 GMT+02:00

16 de abril de 2025 05:50:21 GMT+02:00

このツールは本当に助かる!AIが勝手に作り出す幻覚がなく、非常に正確です。もう少し早く動いてくれると嬉しいけど、正確さが最優先だからね!😊

0

0

![HaroldLopez]() HaroldLopez

HaroldLopez

15 de abril de 2025 20:21:19 GMT+02:00

15 de abril de 2025 20:21:19 GMT+02:00

이 도구는 정말 구세주예요! AI가 내 녹취록에 허구를 만들어내는 걱정은 이제 안 해요. 정말 정확하고, 짜증나는 환각도 줄어들었어요. 조금만 더 빨라지면 좋겠지만, 정확성이 더 중요하죠! 😊

0

0

![JimmyGarcia]() JimmyGarcia

JimmyGarcia

15 de abril de 2025 20:19:21 GMT+02:00

15 de abril de 2025 20:19:21 GMT+02:00

Essa ferramenta é um salva-vidas! Não preciso mais me preocupar com a IA inventando coisas nas minhas transcrições. É super precisa e realmente reduz aquelas alucinações irritantes. Só gostaria que fosse um pouco mais rápida, mas, né, precisão acima de velocidade qualquer dia! 😊

0

0

El Whisper de OpenAI, una herramienta de reconocimiento y transcripción de voz impulsada por IA lanzada en 2022, genera frecuentemente alucinaciones o información fabricada, lo que plantea preocupaciones sobre su potencial para causar daño en entornos críticos.

Un investigador de la Universidad de Michigan descubrió alucinaciones en el 80% de las transcripciones de audio de reuniones públicas que revisó. De manera similar, un ingeniero que analizó 100 horas de transcripciones de Whisper reportó alucinaciones en aproximadamente la mitad, y otro desarrollador las encontró en casi todas las transcripciones que creó, totalizando 26,000 casos.

Aunque los errores menores en la transcripción son comunes, los expertos señalaron que el nivel de alucinación de Whisper es sin precedentes entre las herramientas de transcripción de IA. OpenAI afirma que Whisper, una red neuronal de código abierto, logra una precisión casi humana en el reconocimiento de voz en inglés. Es ampliamente utilizado en industrias para tareas como transcribir entrevistas, traducir contenido y generar subtítulos de video.

El uso generalizado de Whisper podría llevar a la propagación de texto fabricado, citas mal atribuidas y otra desinformación en diversas plataformas, con un impacto que varía según la naturaleza del contenido original. Whisper está integrado en algunas versiones de ChatGPT, usado en centros de llamadas, asistentes de voz y plataformas en la nube de Oracle y Microsoft, y fue descargado más de 4.2 millones de veces el último mes desde HuggingFace.

De particular preocupación es el creciente uso de herramientas basadas en Whisper por parte de profesionales médicos para transcribir consultas de pacientes. La AP habló con más de una docena de ingenieros, investigadores y desarrolladores que confirmaron que Whisper a menudo fabrica frases y oraciones completas, a veces incluyendo comentarios raciales, retórica violenta e incluso tratamientos médicos imaginados.

"Nadie quiere un diagnóstico erróneo," enfatizó Alondra Nelson, profesora del Instituto de Estudios Avanzados.

Aunque OpenAI desaconseja usar Whisper en dominios de alto riesgo como contextos de toma de decisiones donde los errores de precisión pueden generar problemas significativos, la precisión promocionada de la herramienta la hace atractiva para diversas industrias que buscan optimizar operaciones, a menudo pasando por alto los riesgos potenciales.

El problema no se limita a audios largos o mal grabados; los investigadores encontraron alucinaciones incluso en muestras de audio cortas y claras. Estiman que esto podría resultar en decenas de miles de transcripciones incorrectas en millones de grabaciones. Christian Vogler, director del Programa de Acceso Tecnológico de la Universidad de Gallaudet y sordo él mismo, señaló que las personas sordas o con dificultades auditivas podrían no detectar estas alucinaciones "ocultas entre todo este texto."

Estos hallazgos destacan un problema más amplio en la industria de la IA: la carrera por lanzar productos al mercado con fines de lucro, especialmente en ausencia de regulaciones integrales de IA en EE. UU. Esto es particularmente relevante en medio de debates sobre el estatus de OpenAI como empresa con o sin fines de lucro y recientes declaraciones de liderazgo que minimizan los riesgos de la IA.

Un portavoz de OpenAI dijo a la AP que la empresa está trabajando continuamente para reducir las alucinaciones y valora los hallazgos de los investigadores, incorporando retroalimentación en las actualizaciones del modelo.

Mientras tanto, sugerimos considerar Otter.ai, una herramienta de transcripción de IA confiable utilizada por periodistas, que recientemente añadió soporte para seis nuevos idiomas. Aunque un usuario de larga data reportó una estadística alucinada en una nueva función de resumen de IA, el error no apareció en la transcripción misma. Otter.ai aconseja a los usuarios revisar y editar las transcripciones para garantizar la precisión, especialmente para tareas críticas, señalando que la exactitud puede variar debido a factores como el ruido de fondo, acentos y la complejidad de la conversación.

Para usuarios de iPhone, iOS 18.1 con Apple Intelligence ahora ofrece grabación y transcripción de llamadas impulsadas por IA, aunque el editor en jefe de ZDNET, Jason Hiner, lo describe como "todavía un trabajo en progreso."

OpenAI anunció recientemente planes para proporcionar más herramientas a sus 250 millones de usuarios de ChatGPT Plus.

Assort Health obtiene 50 millones de dólares para automatizar la comunicación con los pacientes

Assort Health, una empresa emergente especializada en comunicaciones automatizadas con los pacientes para consultas especializadas, ha obtenido aproximadamente 50 millones de dólares en financiación d

Assort Health obtiene 50 millones de dólares para automatizar la comunicación con los pacientes

Assort Health, una empresa emergente especializada en comunicaciones automatizadas con los pacientes para consultas especializadas, ha obtenido aproximadamente 50 millones de dólares en financiación d

Genere fórmulas de Excel al instante con la herramienta de Excel basada en inteligencia artificial

Transforme el flujo de trabajo de sus hojas de cálculo con GPTExcel, la solución basada en IA que convierte descripciones en lenguaje natural en fórmulas precisas de Excel y Google Sheets. Esta potent

Genere fórmulas de Excel al instante con la herramienta de Excel basada en inteligencia artificial

Transforme el flujo de trabajo de sus hojas de cálculo con GPTExcel, la solución basada en IA que convierte descripciones en lenguaje natural en fórmulas precisas de Excel y Google Sheets. Esta potent

Grok arremete contra los demócratas y los "ejecutivos judíos" de Hollywood en unas polémicas declaraciones

El viernes por la mañana, Elon Musk anunció mejoras significativas en @Grok, afirmando que los usuarios notarían un mejor rendimiento al interactuar con el asistente de IA. Aunque no se dieron detalle

Grok arremete contra los demócratas y los "ejecutivos judíos" de Hollywood en unas polémicas declaraciones

El viernes por la mañana, Elon Musk anunció mejoras significativas en @Grok, afirmando que los usuarios notarían un mejor rendimiento al interactuar con el asistente de IA. Aunque no se dieron detalle

15 de agosto de 2025 04:01:03 GMT+02:00

15 de agosto de 2025 04:01:03 GMT+02:00

This transcription tool sounds like a game-changer! If it really cuts down on AI hallucinations, it could be a big win for accuracy in sensitive fields like medicine or law. Excited to see how it stacks up against Whisper! 😄

0

0

5 de agosto de 2025 19:01:00 GMT+02:00

5 de agosto de 2025 19:01:00 GMT+02:00

This transcription tool sounds promising! Less hallucination is a big win for accuracy. Excited to see how it stacks up in real-world use. 😊

0

0

4 de agosto de 2025 08:48:52 GMT+02:00

4 de agosto de 2025 08:48:52 GMT+02:00

This new AI transcription tool sounds like a game-changer! Whisper’s hallucinations were such a mess for serious work, so I’m hyped to see something more accurate. Can it handle noisy audio though? 🤔

0

0

16 de abril de 2025 05:50:21 GMT+02:00

16 de abril de 2025 05:50:21 GMT+02:00

このツールは本当に助かる!AIが勝手に作り出す幻覚がなく、非常に正確です。もう少し早く動いてくれると嬉しいけど、正確さが最優先だからね!😊

0

0

15 de abril de 2025 20:21:19 GMT+02:00

15 de abril de 2025 20:21:19 GMT+02:00

이 도구는 정말 구세주예요! AI가 내 녹취록에 허구를 만들어내는 걱정은 이제 안 해요. 정말 정확하고, 짜증나는 환각도 줄어들었어요. 조금만 더 빨라지면 좋겠지만, 정확성이 더 중요하죠! 😊

0

0

15 de abril de 2025 20:19:21 GMT+02:00

15 de abril de 2025 20:19:21 GMT+02:00

Essa ferramenta é um salva-vidas! Não preciso mais me preocupar com a IA inventando coisas nas minhas transcrições. É super precisa e realmente reduz aquelas alucinações irritantes. Só gostaria que fosse um pouco mais rápida, mas, né, precisão acima de velocidade qualquer dia! 😊

0

0