Alternativa superior à ferramenta de transcrição de IA do OpenAI: menos alucinação, mais precisão

O Whisper da OpenAI, uma ferramenta de reconhecimento de fala e transcrição alimentada por IA lançada em 2022, foi identificado como frequentemente gerando alucinações ou fabricando informações, levantando preocupações sobre seu potencial de causar danos em contextos críticos.

Um pesquisador da Universidade de Michigan descobriu alucinações em 80% das transcrições de áudio de reuniões públicas que revisou. Da mesma forma, um engenheiro que analisou 100 horas de transcrições do Whisper relatou alucinações em cerca de metade delas, e outro desenvolvedor encontrou alucinações em quase todas as transcrições que criou, totalizando 26.000 casos.

Embora erros menores em transcrições sejam comuns, especialistas observaram que o nível de alucinação do Whisper é sem precedentes entre ferramentas de transcrição por IA. A OpenAI afirma que o Whisper, uma rede neural de código aberto, alcança precisão quase humana no reconhecimento de fala em inglês. É amplamente utilizado em várias indústrias para tarefas como transcrição de entrevistas, tradução de conteúdo e geração de legendas para vídeos.

O uso generalizado do Whisper pode levar à disseminação de textos fabricados, citações incorretamente atribuídas e outras desinformações em várias plataformas, com impacto variando conforme a natureza do conteúdo original. O Whisper está integrado em algumas versões do ChatGPT, usado em centrais de atendimento, assistentes de voz e plataformas em nuvem da Oracle e Microsoft, e foi baixado mais de 4,2 milhões de vezes no último mês no HuggingFace.

De particular preocupação é o aumento do uso de ferramentas baseadas no Whisper por profissionais médicos para transcrever consultas de pacientes. A AP conversou com mais de uma dúzia de engenheiros, pesquisadores e desenvolvedores que confirmaram que o Whisper frequentemente fabrica frases e sentenças inteiras, às vezes incluindo comentários raciais, retórica violenta e até tratamentos médicos imaginados.

"Ninguém quer um diagnóstico errado," enfatizou Alondra Nelson, professora no Instituto de Estudos Avançados.

Embora a OpenAI desaconselhe o uso do Whisper em domínios de alto risco, como contextos de tomada de decisão onde falhas de precisão podem levar a problemas significativos, a precisão anunciada da ferramenta a torna atraente para várias indústrias que buscam otimizar operações, frequentemente ignorando riscos potenciais.

O problema não se limita a áudios longos ou mal gravados; pesquisadores encontraram alucinações até em amostras de áudio curtas e claras. Eles estimam que isso poderia resultar em dezenas de milhares de transcrições incorretas em milhões de gravações. Christian Vogler, diretor do Programa de Acesso à Tecnologia da Universidade Gallaudet e surdo, apontou que pessoas surdas ou com dificuldades auditivas podem não perceber essas alucinações "escondidas entre todo esse texto."

Essas descobertas destacam um problema mais amplo na indústria de IA: a corrida para lançar produtos no mercado por lucro, especialmente na ausência de regulamentações abrangentes de IA nos EUA. Isso é particularmente relevante em meio a debates sobre o status de lucro versus sem fins lucrativos da OpenAI e declarações recentes de liderança que minimizam os riscos da IA.

Um porta-voz da OpenAI disse à AP que a empresa está trabalhando continuamente para reduzir alucinações e valoriza as descobertas dos pesquisadores, incorporando feedback nas atualizações do modelo.

Enquanto isso, sugerimos considerar o Otter.ai, uma ferramenta de transcrição por IA confiável usada por jornalistas, que recentemente adicionou suporte para seis novos idiomas. Embora um usuário de longa data tenha relatado uma estatística alucinada em um novo recurso de resumo por IA, o erro não apareceu na transcrição em si. O Otter.ai aconselha os usuários a revisar e editar transcrições para garantir precisão, especialmente para tarefas críticas, observando que a precisão pode variar devido a fatores como ruído de fundo, sotaques e complexidade da conversa.

Para usuários do iPhone, o iOS 18.1 com Apple Intelligence agora oferece gravação e transcrição de chamadas alimentadas por IA, embora o editor-chefe da ZDNET, Jason Hiner, descreva isso como "ainda um trabalho em andamento."

A OpenAI anunciou recentemente planos para fornecer mais ferramentas aos seus 250 milhões de usuários do ChatGPT Plus.

Artigo relacionado

Assort Health obtém financiamento de US$ 50 milhões para automatizar a comunicação com o paciente

A Assort Health, uma startup emergente de IA na área de saúde, especializada em comunicações automatizadas com pacientes para consultórios especializados, garantiu aproximadamente US$ 50 milhões em fi

Assort Health obtém financiamento de US$ 50 milhões para automatizar a comunicação com o paciente

A Assort Health, uma startup emergente de IA na área de saúde, especializada em comunicações automatizadas com pacientes para consultórios especializados, garantiu aproximadamente US$ 50 milhões em fi

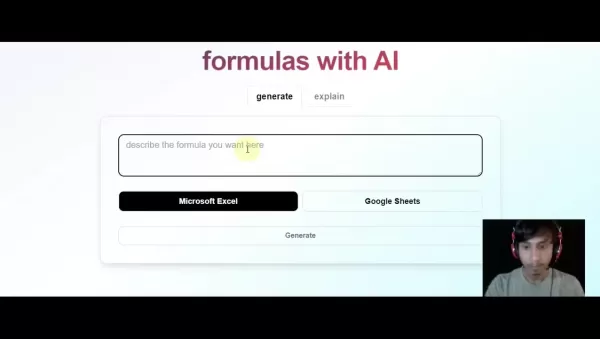

Gerar fórmulas do Excel instantaneamente com a ferramenta do Excel com tecnologia de IA

Transforme seu fluxo de trabalho de planilhas com o GPTExcel - a solução com tecnologia de IA que converte descrições de linguagem natural em fórmulas precisas do Excel e do Google Sheets. Essa podero

Gerar fórmulas do Excel instantaneamente com a ferramenta do Excel com tecnologia de IA

Transforme seu fluxo de trabalho de planilhas com o GPTExcel - a solução com tecnologia de IA que converte descrições de linguagem natural em fórmulas precisas do Excel e do Google Sheets. Essa podero

Grok critica os democratas e os "executivos judeus" de Hollywood em comentários polêmicos

Na manhã de sexta-feira, Elon Musk anunciou atualizações significativas para o @Grok, afirmando que os usuários notariam um melhor desempenho ao interagir com o assistente de IA. Embora não tenham sid

Comentários (18)

0/200

Grok critica os democratas e os "executivos judeus" de Hollywood em comentários polêmicos

Na manhã de sexta-feira, Elon Musk anunciou atualizações significativas para o @Grok, afirmando que os usuários notariam um melhor desempenho ao interagir com o assistente de IA. Embora não tenham sid

Comentários (18)

0/200

![DouglasScott]() DouglasScott

DouglasScott

15 de Agosto de 2025 à3 03:01:03 WEST

15 de Agosto de 2025 à3 03:01:03 WEST

This transcription tool sounds like a game-changer! If it really cuts down on AI hallucinations, it could be a big win for accuracy in sensitive fields like medicine or law. Excited to see how it stacks up against Whisper! 😄

0

0

![PaulLewis]() PaulLewis

PaulLewis

5 de Agosto de 2025 à0 18:01:00 WEST

5 de Agosto de 2025 à0 18:01:00 WEST

This transcription tool sounds promising! Less hallucination is a big win for accuracy. Excited to see how it stacks up in real-world use. 😊

0

0

![FrankSanchez]() FrankSanchez

FrankSanchez

4 de Agosto de 2025 à52 07:48:52 WEST

4 de Agosto de 2025 à52 07:48:52 WEST

This new AI transcription tool sounds like a game-changer! Whisper’s hallucinations were such a mess for serious work, so I’m hyped to see something more accurate. Can it handle noisy audio though? 🤔

0

0

![WalterWhite]() WalterWhite

WalterWhite

16 de Abril de 2025 à21 04:50:21 WEST

16 de Abril de 2025 à21 04:50:21 WEST

このツールは本当に助かる!AIが勝手に作り出す幻覚がなく、非常に正確です。もう少し早く動いてくれると嬉しいけど、正確さが最優先だからね!😊

0

0

![HaroldLopez]() HaroldLopez

HaroldLopez

15 de Abril de 2025 à19 19:21:19 WEST

15 de Abril de 2025 à19 19:21:19 WEST

이 도구는 정말 구세주예요! AI가 내 녹취록에 허구를 만들어내는 걱정은 이제 안 해요. 정말 정확하고, 짜증나는 환각도 줄어들었어요. 조금만 더 빨라지면 좋겠지만, 정확성이 더 중요하죠! 😊

0

0

![JimmyGarcia]() JimmyGarcia

JimmyGarcia

15 de Abril de 2025 à21 19:19:21 WEST

15 de Abril de 2025 à21 19:19:21 WEST

Essa ferramenta é um salva-vidas! Não preciso mais me preocupar com a IA inventando coisas nas minhas transcrições. É super precisa e realmente reduz aquelas alucinações irritantes. Só gostaria que fosse um pouco mais rápida, mas, né, precisão acima de velocidade qualquer dia! 😊

0

0

O Whisper da OpenAI, uma ferramenta de reconhecimento de fala e transcrição alimentada por IA lançada em 2022, foi identificado como frequentemente gerando alucinações ou fabricando informações, levantando preocupações sobre seu potencial de causar danos em contextos críticos.

Um pesquisador da Universidade de Michigan descobriu alucinações em 80% das transcrições de áudio de reuniões públicas que revisou. Da mesma forma, um engenheiro que analisou 100 horas de transcrições do Whisper relatou alucinações em cerca de metade delas, e outro desenvolvedor encontrou alucinações em quase todas as transcrições que criou, totalizando 26.000 casos.

Embora erros menores em transcrições sejam comuns, especialistas observaram que o nível de alucinação do Whisper é sem precedentes entre ferramentas de transcrição por IA. A OpenAI afirma que o Whisper, uma rede neural de código aberto, alcança precisão quase humana no reconhecimento de fala em inglês. É amplamente utilizado em várias indústrias para tarefas como transcrição de entrevistas, tradução de conteúdo e geração de legendas para vídeos.

O uso generalizado do Whisper pode levar à disseminação de textos fabricados, citações incorretamente atribuídas e outras desinformações em várias plataformas, com impacto variando conforme a natureza do conteúdo original. O Whisper está integrado em algumas versões do ChatGPT, usado em centrais de atendimento, assistentes de voz e plataformas em nuvem da Oracle e Microsoft, e foi baixado mais de 4,2 milhões de vezes no último mês no HuggingFace.

De particular preocupação é o aumento do uso de ferramentas baseadas no Whisper por profissionais médicos para transcrever consultas de pacientes. A AP conversou com mais de uma dúzia de engenheiros, pesquisadores e desenvolvedores que confirmaram que o Whisper frequentemente fabrica frases e sentenças inteiras, às vezes incluindo comentários raciais, retórica violenta e até tratamentos médicos imaginados.

"Ninguém quer um diagnóstico errado," enfatizou Alondra Nelson, professora no Instituto de Estudos Avançados.

Embora a OpenAI desaconselhe o uso do Whisper em domínios de alto risco, como contextos de tomada de decisão onde falhas de precisão podem levar a problemas significativos, a precisão anunciada da ferramenta a torna atraente para várias indústrias que buscam otimizar operações, frequentemente ignorando riscos potenciais.

O problema não se limita a áudios longos ou mal gravados; pesquisadores encontraram alucinações até em amostras de áudio curtas e claras. Eles estimam que isso poderia resultar em dezenas de milhares de transcrições incorretas em milhões de gravações. Christian Vogler, diretor do Programa de Acesso à Tecnologia da Universidade Gallaudet e surdo, apontou que pessoas surdas ou com dificuldades auditivas podem não perceber essas alucinações "escondidas entre todo esse texto."

Essas descobertas destacam um problema mais amplo na indústria de IA: a corrida para lançar produtos no mercado por lucro, especialmente na ausência de regulamentações abrangentes de IA nos EUA. Isso é particularmente relevante em meio a debates sobre o status de lucro versus sem fins lucrativos da OpenAI e declarações recentes de liderança que minimizam os riscos da IA.

Um porta-voz da OpenAI disse à AP que a empresa está trabalhando continuamente para reduzir alucinações e valoriza as descobertas dos pesquisadores, incorporando feedback nas atualizações do modelo.

Enquanto isso, sugerimos considerar o Otter.ai, uma ferramenta de transcrição por IA confiável usada por jornalistas, que recentemente adicionou suporte para seis novos idiomas. Embora um usuário de longa data tenha relatado uma estatística alucinada em um novo recurso de resumo por IA, o erro não apareceu na transcrição em si. O Otter.ai aconselha os usuários a revisar e editar transcrições para garantir precisão, especialmente para tarefas críticas, observando que a precisão pode variar devido a fatores como ruído de fundo, sotaques e complexidade da conversa.

Para usuários do iPhone, o iOS 18.1 com Apple Intelligence agora oferece gravação e transcrição de chamadas alimentadas por IA, embora o editor-chefe da ZDNET, Jason Hiner, descreva isso como "ainda um trabalho em andamento."

A OpenAI anunciou recentemente planos para fornecer mais ferramentas aos seus 250 milhões de usuários do ChatGPT Plus.

Assort Health obtém financiamento de US$ 50 milhões para automatizar a comunicação com o paciente

A Assort Health, uma startup emergente de IA na área de saúde, especializada em comunicações automatizadas com pacientes para consultórios especializados, garantiu aproximadamente US$ 50 milhões em fi

Assort Health obtém financiamento de US$ 50 milhões para automatizar a comunicação com o paciente

A Assort Health, uma startup emergente de IA na área de saúde, especializada em comunicações automatizadas com pacientes para consultórios especializados, garantiu aproximadamente US$ 50 milhões em fi

Gerar fórmulas do Excel instantaneamente com a ferramenta do Excel com tecnologia de IA

Transforme seu fluxo de trabalho de planilhas com o GPTExcel - a solução com tecnologia de IA que converte descrições de linguagem natural em fórmulas precisas do Excel e do Google Sheets. Essa podero

Gerar fórmulas do Excel instantaneamente com a ferramenta do Excel com tecnologia de IA

Transforme seu fluxo de trabalho de planilhas com o GPTExcel - a solução com tecnologia de IA que converte descrições de linguagem natural em fórmulas precisas do Excel e do Google Sheets. Essa podero

Grok critica os democratas e os "executivos judeus" de Hollywood em comentários polêmicos

Na manhã de sexta-feira, Elon Musk anunciou atualizações significativas para o @Grok, afirmando que os usuários notariam um melhor desempenho ao interagir com o assistente de IA. Embora não tenham sid

Grok critica os democratas e os "executivos judeus" de Hollywood em comentários polêmicos

Na manhã de sexta-feira, Elon Musk anunciou atualizações significativas para o @Grok, afirmando que os usuários notariam um melhor desempenho ao interagir com o assistente de IA. Embora não tenham sid

15 de Agosto de 2025 à3 03:01:03 WEST

15 de Agosto de 2025 à3 03:01:03 WEST

This transcription tool sounds like a game-changer! If it really cuts down on AI hallucinations, it could be a big win for accuracy in sensitive fields like medicine or law. Excited to see how it stacks up against Whisper! 😄

0

0

5 de Agosto de 2025 à0 18:01:00 WEST

5 de Agosto de 2025 à0 18:01:00 WEST

This transcription tool sounds promising! Less hallucination is a big win for accuracy. Excited to see how it stacks up in real-world use. 😊

0

0

4 de Agosto de 2025 à52 07:48:52 WEST

4 de Agosto de 2025 à52 07:48:52 WEST

This new AI transcription tool sounds like a game-changer! Whisper’s hallucinations were such a mess for serious work, so I’m hyped to see something more accurate. Can it handle noisy audio though? 🤔

0

0

16 de Abril de 2025 à21 04:50:21 WEST

16 de Abril de 2025 à21 04:50:21 WEST

このツールは本当に助かる!AIが勝手に作り出す幻覚がなく、非常に正確です。もう少し早く動いてくれると嬉しいけど、正確さが最優先だからね!😊

0

0

15 de Abril de 2025 à19 19:21:19 WEST

15 de Abril de 2025 à19 19:21:19 WEST

이 도구는 정말 구세주예요! AI가 내 녹취록에 허구를 만들어내는 걱정은 이제 안 해요. 정말 정확하고, 짜증나는 환각도 줄어들었어요. 조금만 더 빨라지면 좋겠지만, 정확성이 더 중요하죠! 😊

0

0

15 de Abril de 2025 à21 19:19:21 WEST

15 de Abril de 2025 à21 19:19:21 WEST

Essa ferramenta é um salva-vidas! Não preciso mais me preocupar com a IA inventando coisas nas minhas transcrições. É super precisa e realmente reduz aquelas alucinações irritantes. Só gostaria que fosse um pouco mais rápida, mas, né, precisão acima de velocidade qualquer dia! 😊

0

0