LGGM: KI-Transformation mit großen generativen Graphenmodellen

Künstliche Intelligenz befindet sich in einem ständigen Entwicklungsprozess, wobei ständig neue Modelle und Techniken entstehen. Einer der faszinierendsten Fortschritte ist das Aufkommen von Großen Generativen Graphmodellen (LGGMs). Diese Modelle bauen auf den Fähigkeiten von Großen Sprachmodellen (LLMs) und Vision-Sprachmodellen (VLMs) auf, indem sie in die Welt der Graphdaten vordringen. Dies ermöglicht neue Wege zur Analyse, Generierung und Verständnis von Daten. Lassen Sie uns in die LGGMs eintauchen und ihre Struktur, Methoden und ihr Potenzial zur Revolutionierung verschiedener Branchen erkunden.

Wichtige Punkte

- LGGM ist ein neuer Typ generativer KI-Modelle, der die Stärken von LLMs und VLMs mit Graph-Neuralen-Netzwerken (GNNs) kombiniert.

- Sie werden auf umfangreichen Datensätzen von Graphen aus verschiedenen Bereichen vortrainiert, was ihre Generalisierungsfähigkeit verbessert.

- LGGMs können Graphen aus Textvorgaben erstellen, was eine detaillierte Kontrolle über die Graphgenerierung ermöglicht.

- Sie haben potenzielle Anwendungen in der Wirkstoffforschung, Materialdesign, Analyse sozialer Netzwerke und Cybersicherheit.

- Diskretes Denoising Diffusion spielt eine zentrale Rolle im LGGM-Training und hilft, qualitativ hochwertige Graphstrukturen zu erzeugen.

Große Generative Graphmodelle (LGGMs) verstehen

Die Evolution von KI-Modellen: Von LLMs und VLMs zu LGGMs

KI-Modelle haben einen langen Weg zurückgelegt. Große Sprachmodelle (LLMs) haben die natürliche Sprachverarbeitung revolutioniert und Aufgaben wie Textgenerierung, Übersetzung und Beantwortung von Fragen gemeistert. Dann kamen Vision-Sprachmodelle (VLMs), die durch die Integration visueller Daten einen Schritt weiter gingen und sowohl Text als auch Bilder verarbeiten konnten.

Nun stoßen Große Generative Graphmodelle (LGGMs) die Grenzen noch weiter voran. Sie kombinieren die Fähigkeiten von LLMs und VLMs mit Graph-Neuralen-Netzwerken (GNNs), was die Arbeit mit graphstrukturierten Daten ermöglicht. Das ist bedeutend, da viele reale Datensätze, von sozialen Netzwerken bis hin zu biologischen Netzwerken und Wissensgraphen, als Graphen dargestellt werden können. Die Fähigkeit, diese Graphen zu generieren und zu analysieren, eröffnet eine völlig neue Welt von Erkenntnissen und Anwendungen.

Wichtige Vorteile von LGGMs:

- Bessere Generalisierung durch Vortraining auf vielfältigen Graphdatensätzen.

- Detaillierte Kontrolle über die Graphgenerierung mittels Textvorgaben.

- Anwendungen in verschiedenen Bereichen, einschließlich Wirkstoffforschung und Cybersicherheit.

Was ist die LGGM-Modellarchitektur?

Die Architektur eines LGGM umfasst typischerweise mehrere zentrale Komponenten:

- Text-Encoder: Dieser verarbeitet die eingegebene Textvorgabe unter Verwendung von Techniken aus LLMs.

- Graph-Neurales-Netzwerk (GNN): Es lernt Darstellungen bestehender Graphen und generiert neue Graphstrukturen.

- Diffusionsprozess: Dieser nutzt einen Denoising-Diffusionsprozess, um Graphen Rauschen hinzuzufügen und dieses dann umzukehren, um realistische Graphstrukturen zu generieren. Diese Technologie, bekannt als Diskretes Denoising Diffusion, ist entscheidend für die Fähigkeit von LGGMs, qualitativ hochwertige Graphstrukturen zu generieren.

- Text-zu-Graph-Generierung: Es integriert Wissen aus zugrunde liegenden Sprachmodellen, um eine detaillierte Kontrolle über die Graphgenerierung basierend auf Textvorgaben zu ermöglichen.

Die Kombination dieser Komponenten ermöglicht es dem LGGM, textuelle Anweisungen in komplexe, strukturierte Graphen zu übersetzen, was es zu einem mächtigen Werkzeug für verschiedene Aufgaben macht.

Die Bedeutung von Multi-Domänen-Vortraining für LGGMs

Multi-Domänen-Vortraining ist ein entscheidender Aspekt der LGGM-Entwicklung. Im Gegensatz zu früheren Modellen, die auf Datensätzen einzelner Domänen trainiert wurden, werden LGGMs auf einem Korpus von über 5000 Graphen aus 13 verschiedenen Domänen vortrainiert. Dieser Ansatz hilft dem LGGM, generalisierbarere Muster und Beziehungen zu lernen, was seine Leistung bei vielfältigen Aufgaben verbessert.

Diese Vortraining-Strategie verbessert die Fähigkeit des Modells, sich an neue Domänen und Aufgaben anzupassen, und behebt Einschränkungen früherer Modelle. Die vielfältigen Trainingsdaten ermöglichen es dem LGGM, eine breite Palette von Graphmustern und -strukturen zu erfassen.

Vorteile des Multi-Domänen-Trainings:

- Verbesserte Generalisierung.

- Erhöhte Anpassungsfähigkeit.

- Robuste Leistung bei vielfältigen Datensätzen.

Tiefer eintauchen: Techniken in LGGMs

Diskretes Denoising Diffusion: Generierung hochwertiger Graphen

Diskretes Denoising Diffusion ist eine Schlüsseltechnologie im LGGM-Training.

Dieser Prozess umfasst zwei Hauptschritte:

- Vorwärtsprozess: Fügt bestehenden Graphen Rauschen hinzu, wodurch ihre Struktur allmählich abgebaut wird.

- Rückwärtsprozess: Trainiert das Modell, die Rauschzugabe umzukehren, die Graphen zu entstören und neue, realistische Graphstrukturen zu generieren.

Diese Methode verbessert die Fähigkeit des Modells, qualitativ hochwertige Graphstrukturen zu generieren, indem es lernt, Graphen aus verrauschten Versionen zu rekonstruieren. Es handelt sich um eine Technik, die aus der Bildgenerierung adaptiert wurde, wo Diffusionsmodelle hochmoderne Ergebnisse erzielt haben.

Spezifizierung von Graph-Eigenschaften durch Textvorgaben

Eine der einzigartigen Eigenschaften von LGGMs ist die Fähigkeit, Graph-Eigenschaften durch Textvorgaben zu spezifizieren. Diese Funktion ermöglicht es Nutzern, verschiedene Merkmale der generierten Graphen zu kontrollieren, wie zum Beispiel:

- Durchschnittlicher Grad.

- Clustering-Koeffizient.

Durch die Angabe dieser Eigenschaften in der Textvorgabe können Nutzer den Graphgenerierungsprozess steuern und Graphen erstellen, die ihren spezifischen Anforderungen entsprechen. Dieses Maß an Kontrolle ist bei traditionellen GNNs nicht verfügbar.

Erste Schritte mit Großen Generativen Graphmodellen: Ein grundlegender Leitfaden

Schritte zur Implementierung eines Großen Generativen Graphmodells

Die direkte Implementierung eines LGGMs von Grund auf kann komplex sein, hier ist eine vereinfachte Übersicht der beteiligten Schritte:

- Datenaufbereitung: Sammeln eines großen Korpus von Graphdaten aus verschiedenen Domänen.

- Modellarchitektur: Erstellen einer LGGM-Architektur, die einen Text-Encoder, GNN und Diffusionsprozess kombiniert.

- Vortraining: Vortrainieren des Modells auf dem Graphkorpus unter Verwendung eines diskreten Denoising-Diffusionsprozesses.

- Feinabstimmung: Feinabstimmung des Modells auf spezifische Zieldomänen, um die Leistung zu verbessern.

- Text-zu-Graph-Generierung: Implementierung eines Text-zu-Graph-Generierungsmoduls, das Textvorgaben in Graphstrukturen übersetzt.

Hinweis: Dieser Prozess erfordert ein tiefes Verständnis von Deep Learning, Graph-Neuralen-Netzwerken und Diffusionsmodellen.

LGGM-Preise

LGGM-Preise

Derzeit sind LGGMs hauptsächlich Forschungsmodelle, und direkte kommerzielle Preise sind nicht anwendbar. Berücksichtigen Sie jedoch die potenziellen Kosten für:

- Rechenressourcen: Training und Einsatz großer Modelle erfordern erhebliche Rechenleistung.

- Datenerfassung: Zugang und Aufbereitung großer Graphdatensätze können Kosten verursachen.

- Software und Tools: Nutzung geeigneter Deep-Learning-Frameworks und Bibliotheken.

Mit der Reifung von LGGMs könnten spezialisierte Dienste und Tools entstehen, die verschiedene Preismodelle basierend auf Nutzung oder Abonnement anbieten.

LGGMs: Vor- und Nachteile

Vorteile

- Fähigkeit, neue, realistische Graphstrukturen zu generieren.

- Feinkörnige Kontrolle über Graph-Eigenschaften durch Textvorgaben.

- Potenzial für Anwendungen in verschiedenen Domänen.

- Multi-Domänen-Training führt zu besserer Generalisierung.

Nachteile

- Hohe Rechenkosten für Training und Einsatz.

- Erfordernis großer und vielfältiger Trainingsdatensätze.

- Komplexität in Modellarchitektur und Implementierung.

- Bedarf an spezialisiertem Fachwissen für effektives Design und Nutzung.

Kernfunktionen von LGGMs

Wichtige Funktionalitäten des Großen Generativen Graphmodells

Hier sind die Kernfunktionalitäten, die das LGGM-Modell definieren:

- Text-zu-Graph-Generierung: LGGMs übersetzen Textvorgaben in strukturierte Graphen, was eine benutzergesteuerte Erstellung von Graphdaten ermöglicht.

- Multi-Domänen-Lernen: Durch Vortraining auf vielfältigen Datensätzen generalisieren LGGMs und funktionieren gut in verschiedenen Anwendungen.

- Anpassbare Graph-Eigenschaften: Nutzer können Graphmerkmale (z. B. durchschnittlicher Grad, Clustering-Koeffizient) über Textvorgaben spezifizieren.

- Wirkstoffforschung: Identifizierung potenzieller Wirkstoffkandidaten durch Generierung und Analyse molekularer Graphen mit gewünschten Eigenschaften.

- Daten-Augmentation: Verbesserung bestehender Graphdatensätze durch Generierung synthetischer Daten für verbessertes Modelltraining.

Vielfältige Anwendungsfälle für Große Generative Graphmodelle

Reale Anwendungen des LGGM-Modells

LGGMs haben Potenzial in einer Vielzahl von Branchen:

- Wirkstoffforschung: Generierung molekularer Graphen mit spezifischen Eigenschaften, um potenzielle Wirkstoffkandidaten zu identifizieren. LGGMs haben die Fähigkeit, molekulare Graphen mit gewünschten Eigenschaften zu generieren.

- Materialdesign: Erstellung von Graphen, die verschiedene Materialstrukturen darstellen, und Vorhersage ihrer Eigenschaften.

- Analyse sozialer Netzwerke: Generierung von sozialen Netzwerkgraphen mit gewünschten Gemeinschaftsstrukturen und Interaktionsmustern. Unterstützt auch die Generierung von sozialen Netzwerkgraphen mit gewünschten Eigenschaften.

- Cybersicherheit: Gestaltung von Netzwerkgraphen, die verschiedene Arten von Netzwerktopologien und Angriffsszenarien darstellen. Mit dieser spezifischen Graphgenerierung können Netzwerkgraphen generiert werden, um potenzielle Angriffsvektoren vorherzusagen.

Häufig gestellte Fragen (FAQ) zu LGGMs

Was ist der Unterschied zwischen LGGMs und traditionellen GNNs?

Traditionelle GNNs konzentrieren sich auf das Lernen von Einbettungen für bestehende Graphknoten, während LGGMs darauf ausgelegt sind, neue Graphen basierend auf Textvorgaben zu generieren. Es führt einen neuartigen generativen Ansatz ein, um großflächiges, Multi-Domänen-Training zu verbessern.

Was ist diskretes Denoising Diffusion, und warum ist es wichtig?

Diskretes Denoising Diffusion ist eine Technik, die das Modell trainiert, Graphen aus verrauschten Versionen zu rekonstruieren, was die Generierung hochwertiger Graphstrukturen ermöglicht.

Welche Eigenschaften in der Textvorgabe können durch das LGGM-Modell angepasst werden?

Durchschnittlicher Grad und Clustering-Koeffizient. Unterstützt auch domänenspezifische Merkmale, um gewünschte Graphmodelle zu erstellen.

Verwandte Fragen

Wie hängen Große Generative Graphmodelle mit anderen KI-Modellen wie LLMs und VLMs zusammen?

Große Generative Graphmodelle (LGGMs) repräsentieren einen evolutionären Schritt in der KI-Entwicklung und integrieren die Stärken verschiedener Architekturen, um komplexe Datenstrukturen zu handhaben. Während LLMs in der natürlichen Sprachverarbeitung glänzen und VLMs Text- und Bildverständnis kombinieren, erweitern LGGMs diese Fähigkeiten auf graphstrukturierte Daten. LLMs versorgen LGGMs mit der Fähigkeit, textuelle Beschreibungen zu verstehen und zu generieren, was die Verwendung natürlicher Sprachvorgaben zur Steuerung der Graphenerstellung ermöglicht. VLMs tragen Techniken zur Verarbeitung und Integration visueller Informationen bei, die relevant sein können, wenn Graphknoten oder -kanten mit visuellen Daten verbunden sind. Im Kern integrieren LGGMs Graph-Neurale-Netzwerke (GNNs), um Beziehungen und Abhängigkeiten innerhalb von Graphdaten zu modellieren. Durch die Nutzung von GNNs können LGGMs komplexe Muster erfassen und neue Graphstrukturen generieren, die spezifischen Eigenschaften und Einschränkungen entsprechen. Der Fokus liegt auf der Kodierung der Graphstruktur und der Knotenmerkmale in einen niedrigdimensionalen Raum, der die wesentlichen Muster und Beziehungen innerhalb des Graphen erfasst.

Verwandter Artikel

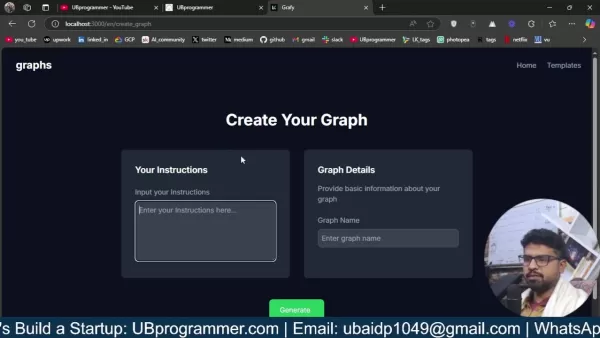

Einfaches Generieren von KI-gestützten Grafiken und Visualisierungen für bessere Dateneinblicke

Die moderne Datenanalyse erfordert eine intuitive Visualisierung komplexer Informationen. KI-gestützte Lösungen zur Diagrammerstellung haben sich als unverzichtbare Hilfsmittel erwiesen und revolution

Einfaches Generieren von KI-gestützten Grafiken und Visualisierungen für bessere Dateneinblicke

Die moderne Datenanalyse erfordert eine intuitive Visualisierung komplexer Informationen. KI-gestützte Lösungen zur Diagrammerstellung haben sich als unverzichtbare Hilfsmittel erwiesen und revolution

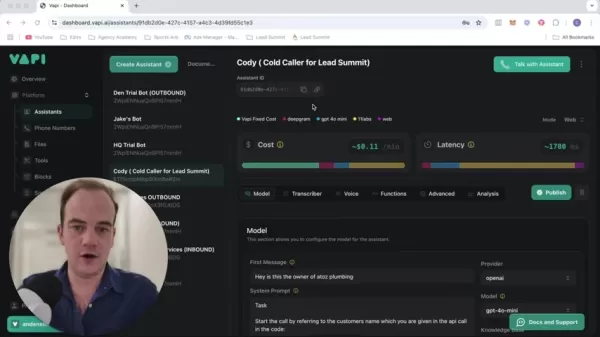

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Kommentare (1)

0/200

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Kommentare (1)

0/200

![WillieLee]() WillieLee

WillieLee

2. August 2025 17:07:14 MESZ

2. August 2025 17:07:14 MESZ

LGGMs sound like a game-changer for AI! I'm curious how they'll stack up against LLMs in real-world tasks. Anyone tried them yet? 🤔

0

0

Künstliche Intelligenz befindet sich in einem ständigen Entwicklungsprozess, wobei ständig neue Modelle und Techniken entstehen. Einer der faszinierendsten Fortschritte ist das Aufkommen von Großen Generativen Graphmodellen (LGGMs). Diese Modelle bauen auf den Fähigkeiten von Großen Sprachmodellen (LLMs) und Vision-Sprachmodellen (VLMs) auf, indem sie in die Welt der Graphdaten vordringen. Dies ermöglicht neue Wege zur Analyse, Generierung und Verständnis von Daten. Lassen Sie uns in die LGGMs eintauchen und ihre Struktur, Methoden und ihr Potenzial zur Revolutionierung verschiedener Branchen erkunden.

Wichtige Punkte

- LGGM ist ein neuer Typ generativer KI-Modelle, der die Stärken von LLMs und VLMs mit Graph-Neuralen-Netzwerken (GNNs) kombiniert.

- Sie werden auf umfangreichen Datensätzen von Graphen aus verschiedenen Bereichen vortrainiert, was ihre Generalisierungsfähigkeit verbessert.

- LGGMs können Graphen aus Textvorgaben erstellen, was eine detaillierte Kontrolle über die Graphgenerierung ermöglicht.

- Sie haben potenzielle Anwendungen in der Wirkstoffforschung, Materialdesign, Analyse sozialer Netzwerke und Cybersicherheit.

- Diskretes Denoising Diffusion spielt eine zentrale Rolle im LGGM-Training und hilft, qualitativ hochwertige Graphstrukturen zu erzeugen.

Große Generative Graphmodelle (LGGMs) verstehen

Die Evolution von KI-Modellen: Von LLMs und VLMs zu LGGMs

KI-Modelle haben einen langen Weg zurückgelegt. Große Sprachmodelle (LLMs) haben die natürliche Sprachverarbeitung revolutioniert und Aufgaben wie Textgenerierung, Übersetzung und Beantwortung von Fragen gemeistert. Dann kamen Vision-Sprachmodelle (VLMs), die durch die Integration visueller Daten einen Schritt weiter gingen und sowohl Text als auch Bilder verarbeiten konnten.

Nun stoßen Große Generative Graphmodelle (LGGMs) die Grenzen noch weiter voran. Sie kombinieren die Fähigkeiten von LLMs und VLMs mit Graph-Neuralen-Netzwerken (GNNs), was die Arbeit mit graphstrukturierten Daten ermöglicht. Das ist bedeutend, da viele reale Datensätze, von sozialen Netzwerken bis hin zu biologischen Netzwerken und Wissensgraphen, als Graphen dargestellt werden können. Die Fähigkeit, diese Graphen zu generieren und zu analysieren, eröffnet eine völlig neue Welt von Erkenntnissen und Anwendungen.

Wichtige Vorteile von LGGMs:

- Bessere Generalisierung durch Vortraining auf vielfältigen Graphdatensätzen.

- Detaillierte Kontrolle über die Graphgenerierung mittels Textvorgaben.

- Anwendungen in verschiedenen Bereichen, einschließlich Wirkstoffforschung und Cybersicherheit.

Was ist die LGGM-Modellarchitektur?

Die Architektur eines LGGM umfasst typischerweise mehrere zentrale Komponenten:

- Text-Encoder: Dieser verarbeitet die eingegebene Textvorgabe unter Verwendung von Techniken aus LLMs.

- Graph-Neurales-Netzwerk (GNN): Es lernt Darstellungen bestehender Graphen und generiert neue Graphstrukturen.

- Diffusionsprozess: Dieser nutzt einen Denoising-Diffusionsprozess, um Graphen Rauschen hinzuzufügen und dieses dann umzukehren, um realistische Graphstrukturen zu generieren. Diese Technologie, bekannt als Diskretes Denoising Diffusion, ist entscheidend für die Fähigkeit von LGGMs, qualitativ hochwertige Graphstrukturen zu generieren.

- Text-zu-Graph-Generierung: Es integriert Wissen aus zugrunde liegenden Sprachmodellen, um eine detaillierte Kontrolle über die Graphgenerierung basierend auf Textvorgaben zu ermöglichen.

Die Kombination dieser Komponenten ermöglicht es dem LGGM, textuelle Anweisungen in komplexe, strukturierte Graphen zu übersetzen, was es zu einem mächtigen Werkzeug für verschiedene Aufgaben macht.

Die Bedeutung von Multi-Domänen-Vortraining für LGGMs

Multi-Domänen-Vortraining ist ein entscheidender Aspekt der LGGM-Entwicklung. Im Gegensatz zu früheren Modellen, die auf Datensätzen einzelner Domänen trainiert wurden, werden LGGMs auf einem Korpus von über 5000 Graphen aus 13 verschiedenen Domänen vortrainiert. Dieser Ansatz hilft dem LGGM, generalisierbarere Muster und Beziehungen zu lernen, was seine Leistung bei vielfältigen Aufgaben verbessert.

Diese Vortraining-Strategie verbessert die Fähigkeit des Modells, sich an neue Domänen und Aufgaben anzupassen, und behebt Einschränkungen früherer Modelle. Die vielfältigen Trainingsdaten ermöglichen es dem LGGM, eine breite Palette von Graphmustern und -strukturen zu erfassen.

Vorteile des Multi-Domänen-Trainings:

- Verbesserte Generalisierung.

- Erhöhte Anpassungsfähigkeit.

- Robuste Leistung bei vielfältigen Datensätzen.

Tiefer eintauchen: Techniken in LGGMs

Diskretes Denoising Diffusion: Generierung hochwertiger Graphen

Diskretes Denoising Diffusion ist eine Schlüsseltechnologie im LGGM-Training.

Dieser Prozess umfasst zwei Hauptschritte:

- Vorwärtsprozess: Fügt bestehenden Graphen Rauschen hinzu, wodurch ihre Struktur allmählich abgebaut wird.

- Rückwärtsprozess: Trainiert das Modell, die Rauschzugabe umzukehren, die Graphen zu entstören und neue, realistische Graphstrukturen zu generieren.

Diese Methode verbessert die Fähigkeit des Modells, qualitativ hochwertige Graphstrukturen zu generieren, indem es lernt, Graphen aus verrauschten Versionen zu rekonstruieren. Es handelt sich um eine Technik, die aus der Bildgenerierung adaptiert wurde, wo Diffusionsmodelle hochmoderne Ergebnisse erzielt haben.

Spezifizierung von Graph-Eigenschaften durch Textvorgaben

Eine der einzigartigen Eigenschaften von LGGMs ist die Fähigkeit, Graph-Eigenschaften durch Textvorgaben zu spezifizieren. Diese Funktion ermöglicht es Nutzern, verschiedene Merkmale der generierten Graphen zu kontrollieren, wie zum Beispiel:

- Durchschnittlicher Grad.

- Clustering-Koeffizient.

Durch die Angabe dieser Eigenschaften in der Textvorgabe können Nutzer den Graphgenerierungsprozess steuern und Graphen erstellen, die ihren spezifischen Anforderungen entsprechen. Dieses Maß an Kontrolle ist bei traditionellen GNNs nicht verfügbar.

Erste Schritte mit Großen Generativen Graphmodellen: Ein grundlegender Leitfaden

Schritte zur Implementierung eines Großen Generativen Graphmodells

Die direkte Implementierung eines LGGMs von Grund auf kann komplex sein, hier ist eine vereinfachte Übersicht der beteiligten Schritte:

- Datenaufbereitung: Sammeln eines großen Korpus von Graphdaten aus verschiedenen Domänen.

- Modellarchitektur: Erstellen einer LGGM-Architektur, die einen Text-Encoder, GNN und Diffusionsprozess kombiniert.

- Vortraining: Vortrainieren des Modells auf dem Graphkorpus unter Verwendung eines diskreten Denoising-Diffusionsprozesses.

- Feinabstimmung: Feinabstimmung des Modells auf spezifische Zieldomänen, um die Leistung zu verbessern.

- Text-zu-Graph-Generierung: Implementierung eines Text-zu-Graph-Generierungsmoduls, das Textvorgaben in Graphstrukturen übersetzt.

Hinweis: Dieser Prozess erfordert ein tiefes Verständnis von Deep Learning, Graph-Neuralen-Netzwerken und Diffusionsmodellen.

LGGM-Preise

LGGM-Preise

Derzeit sind LGGMs hauptsächlich Forschungsmodelle, und direkte kommerzielle Preise sind nicht anwendbar. Berücksichtigen Sie jedoch die potenziellen Kosten für:

- Rechenressourcen: Training und Einsatz großer Modelle erfordern erhebliche Rechenleistung.

- Datenerfassung: Zugang und Aufbereitung großer Graphdatensätze können Kosten verursachen.

- Software und Tools: Nutzung geeigneter Deep-Learning-Frameworks und Bibliotheken.

Mit der Reifung von LGGMs könnten spezialisierte Dienste und Tools entstehen, die verschiedene Preismodelle basierend auf Nutzung oder Abonnement anbieten.

LGGMs: Vor- und Nachteile

Vorteile

- Fähigkeit, neue, realistische Graphstrukturen zu generieren.

- Feinkörnige Kontrolle über Graph-Eigenschaften durch Textvorgaben.

- Potenzial für Anwendungen in verschiedenen Domänen.

- Multi-Domänen-Training führt zu besserer Generalisierung.

Nachteile

- Hohe Rechenkosten für Training und Einsatz.

- Erfordernis großer und vielfältiger Trainingsdatensätze.

- Komplexität in Modellarchitektur und Implementierung.

- Bedarf an spezialisiertem Fachwissen für effektives Design und Nutzung.

Kernfunktionen von LGGMs

Wichtige Funktionalitäten des Großen Generativen Graphmodells

Hier sind die Kernfunktionalitäten, die das LGGM-Modell definieren:

- Text-zu-Graph-Generierung: LGGMs übersetzen Textvorgaben in strukturierte Graphen, was eine benutzergesteuerte Erstellung von Graphdaten ermöglicht.

- Multi-Domänen-Lernen: Durch Vortraining auf vielfältigen Datensätzen generalisieren LGGMs und funktionieren gut in verschiedenen Anwendungen.

- Anpassbare Graph-Eigenschaften: Nutzer können Graphmerkmale (z. B. durchschnittlicher Grad, Clustering-Koeffizient) über Textvorgaben spezifizieren.

- Wirkstoffforschung: Identifizierung potenzieller Wirkstoffkandidaten durch Generierung und Analyse molekularer Graphen mit gewünschten Eigenschaften.

- Daten-Augmentation: Verbesserung bestehender Graphdatensätze durch Generierung synthetischer Daten für verbessertes Modelltraining.

Vielfältige Anwendungsfälle für Große Generative Graphmodelle

Reale Anwendungen des LGGM-Modells

LGGMs haben Potenzial in einer Vielzahl von Branchen:

- Wirkstoffforschung: Generierung molekularer Graphen mit spezifischen Eigenschaften, um potenzielle Wirkstoffkandidaten zu identifizieren. LGGMs haben die Fähigkeit, molekulare Graphen mit gewünschten Eigenschaften zu generieren.

- Materialdesign: Erstellung von Graphen, die verschiedene Materialstrukturen darstellen, und Vorhersage ihrer Eigenschaften.

- Analyse sozialer Netzwerke: Generierung von sozialen Netzwerkgraphen mit gewünschten Gemeinschaftsstrukturen und Interaktionsmustern. Unterstützt auch die Generierung von sozialen Netzwerkgraphen mit gewünschten Eigenschaften.

- Cybersicherheit: Gestaltung von Netzwerkgraphen, die verschiedene Arten von Netzwerktopologien und Angriffsszenarien darstellen. Mit dieser spezifischen Graphgenerierung können Netzwerkgraphen generiert werden, um potenzielle Angriffsvektoren vorherzusagen.

Häufig gestellte Fragen (FAQ) zu LGGMs

Was ist der Unterschied zwischen LGGMs und traditionellen GNNs?

Traditionelle GNNs konzentrieren sich auf das Lernen von Einbettungen für bestehende Graphknoten, während LGGMs darauf ausgelegt sind, neue Graphen basierend auf Textvorgaben zu generieren. Es führt einen neuartigen generativen Ansatz ein, um großflächiges, Multi-Domänen-Training zu verbessern.

Was ist diskretes Denoising Diffusion, und warum ist es wichtig?

Diskretes Denoising Diffusion ist eine Technik, die das Modell trainiert, Graphen aus verrauschten Versionen zu rekonstruieren, was die Generierung hochwertiger Graphstrukturen ermöglicht.

Welche Eigenschaften in der Textvorgabe können durch das LGGM-Modell angepasst werden?

Durchschnittlicher Grad und Clustering-Koeffizient. Unterstützt auch domänenspezifische Merkmale, um gewünschte Graphmodelle zu erstellen.

Verwandte Fragen

Wie hängen Große Generative Graphmodelle mit anderen KI-Modellen wie LLMs und VLMs zusammen?

Große Generative Graphmodelle (LGGMs) repräsentieren einen evolutionären Schritt in der KI-Entwicklung und integrieren die Stärken verschiedener Architekturen, um komplexe Datenstrukturen zu handhaben. Während LLMs in der natürlichen Sprachverarbeitung glänzen und VLMs Text- und Bildverständnis kombinieren, erweitern LGGMs diese Fähigkeiten auf graphstrukturierte Daten. LLMs versorgen LGGMs mit der Fähigkeit, textuelle Beschreibungen zu verstehen und zu generieren, was die Verwendung natürlicher Sprachvorgaben zur Steuerung der Graphenerstellung ermöglicht. VLMs tragen Techniken zur Verarbeitung und Integration visueller Informationen bei, die relevant sein können, wenn Graphknoten oder -kanten mit visuellen Daten verbunden sind. Im Kern integrieren LGGMs Graph-Neurale-Netzwerke (GNNs), um Beziehungen und Abhängigkeiten innerhalb von Graphdaten zu modellieren. Durch die Nutzung von GNNs können LGGMs komplexe Muster erfassen und neue Graphstrukturen generieren, die spezifischen Eigenschaften und Einschränkungen entsprechen. Der Fokus liegt auf der Kodierung der Graphstruktur und der Knotenmerkmale in einen niedrigdimensionalen Raum, der die wesentlichen Muster und Beziehungen innerhalb des Graphen erfasst.

Einfaches Generieren von KI-gestützten Grafiken und Visualisierungen für bessere Dateneinblicke

Die moderne Datenanalyse erfordert eine intuitive Visualisierung komplexer Informationen. KI-gestützte Lösungen zur Diagrammerstellung haben sich als unverzichtbare Hilfsmittel erwiesen und revolution

Einfaches Generieren von KI-gestützten Grafiken und Visualisierungen für bessere Dateneinblicke

Die moderne Datenanalyse erfordert eine intuitive Visualisierung komplexer Informationen. KI-gestützte Lösungen zur Diagrammerstellung haben sich als unverzichtbare Hilfsmittel erwiesen und revolution

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

2. August 2025 17:07:14 MESZ

2. August 2025 17:07:14 MESZ

LGGMs sound like a game-changer for AI! I'm curious how they'll stack up against LLMs in real-world tasks. Anyone tried them yet? 🤔

0

0