Die KI von DeepMind übertrifft die IMO -Goldmedaillengewinner

Google DeepMinds neueste KI, AlphaGeometry2, hat Aufsehen erregt, indem sie den durchschnittlichen Goldmedaillengewinner bei der Lösung von Geometrieproblemen bei der Internationalen Mathematik-Olympiade (IMO) übertrifft. Diese verbesserte Version von AlphaGeometry, die erst im Januar vorgestellt wurde, löste Berichten zufolge 84 % der Geometrieprobleme der letzten 25 Jahre der IMO-Wettbewerbe.

Sie fragen sich vielleicht, warum DeepMind sich auf einen Mathematikwettbewerb für Schüler konzentriert. Nun, sie glauben, dass das Knacken dieser anspruchsvollen euklidischen Geometrieprobleme ein Sprungbrett sein könnte, um fortschrittlichere KI zu entwickeln. Das Lösen dieser Probleme erfordert sowohl logisches Denken als auch die Fähigkeit, verschiedene Lösungswege zu navigieren, Fähigkeiten, die für zukünftige universelle KI-Systeme entscheidend sein könnten.

Diesen Sommer stellte DeepMind ein System vor, das AlphaGeometry2 mit AlphaProof kombinierte, einem weiteren KI-Modell für formales mathematisches Denken. Zusammen lösten sie vier von sechs Problemen der IMO 2024. Dieser Ansatz könnte potenziell über die Geometrie hinaus auf andere Bereiche der Mathematik und Wissenschaft angewendet werden, wie komplexe technische Berechnungen.

AlphaGeometry2 wird von einigen Schlüsselkomponenten angetrieben, darunter ein Sprachmodell aus Googles Gemini-Familie und ein "symbolischer Motor". Das Gemini-Modell unterstützt den symbolischen Motor, der mathematische Regeln anwendet, um Lösungen zu finden, bei der Erstellung machbarer Beweise für Geometriesätze.

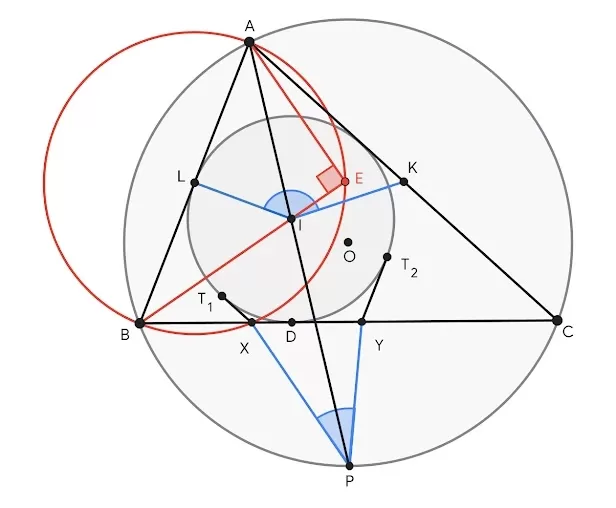

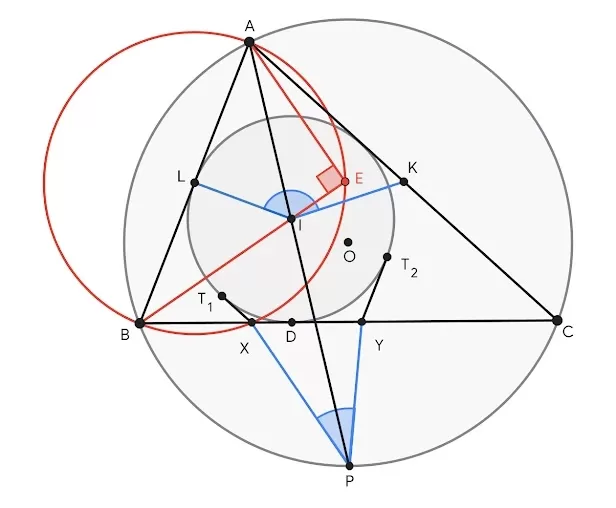

Ein typisches Geometrieproblem-Diagramm in einer IMO-Prüfung. Bildnachweis: Google (öffnet in einem neuen Fenster) In der IMO erfordern Geometrieprobleme oft das Hinzufügen von "Konstrukten" wie Punkten, Linien oder Kreisen zu Diagrammen, bevor sie gelöst werden. Das Gemini-Modell von AlphaGeometry2 sagt voraus, welche Konstrukte hilfreich sein könnten, und leitet den symbolischen Motor, um Schlussfolgerungen zu ziehen.

So funktioniert es: Das Gemini-Modell schlägt Schritte und Konstruktionen in einer formalen mathematischen Sprache vor, die der Motor dann auf logische Konsistenz überprüft. AlphaGeometry2 verwendet einen Suchalgorithmus, um mehrere Lösungswege gleichzeitig zu erkunden und speichert potenziell nützliche Erkenntnisse in einer gemeinsamen Wissensdatenbank.

Ein Problem gilt als "gelöst", wenn AlphaGeometry2 die Vorschläge des Gemini-Modells mit den bekannten Prinzipien des symbolischen Motors kombiniert, um einen vollständigen Beweis zu erstellen.

Aufgrund der Knappheit nutzbarer Geometrie-Trainingsdaten erstellte DeepMind synthetische Daten, um das Sprachmodell von AlphaGeometry2 zu trainieren, und generierte über 300 Millionen Theoreme und Beweise unterschiedlicher Komplexität.

Das DeepMind-Team testete AlphaGeometry2 an 45 Geometrieproblemen aus IMO-Wettbewerben von 2000 bis 2024, die sie auf 50 Probleme erweiterten. AlphaGeometry2 löste 42 davon und übertraf den durchschnittlichen Goldmedaillen-Score von 40,9.

Allerdings hat AlphaGeometry2 seine Gren Limitations. Es hat Schwierigkeiten mit Problemen, die eine variable Anzahl von Punkten, nichtlineare Gleichungen und Ungleichungen beinhalten. Obwohl es nicht die erste KI ist, die Goldmedaillen-Niveau in Geometrie erreicht, ist es die erste, die dies mit einem so großen Problemset erreicht.

Als sie mit einem schwierigeren Satz von 29 noch nicht in Wettbewerben erschienenen IMO-nominierten Problemen konfrontiert wurde, konnte AlphaGeometry2 nur 20 lösen.

Die Ergebnisse der Studie werden wahrscheinlich weitere Debatten über den besten Ansatz zum Bau von KI-Systemen auslösen. Sollten wir uns auf Symbolmanipulation konzentrieren, bei der KI Regeln verwendet, um Symbole zu manipulieren, die Wissen repräsentieren, oder auf neuronale Netze, die die Struktur des menschlichen Gehirns nachahmen und aus Daten lernen?

AlphaGeometry2 verfolgt einen hybriden Ansatz, der die neuronale Netzwerkarchitektur des Gemini-Modells mit dem regelbasierten symbolischen Motor kombiniert.

Befürworter neuronaler Netze argumentieren, dass intelligentes Verhalten aus großen Datenmengen und Rechenleistung entstehen kann. Im Gegensatz dazu glauben Befürworter symbolischer KI, dass sie besser geeignet ist, Wissen zu kodieren, durch komplexe Szenarien zu argumentieren und Lösungen zu erklären.

Vince Conitzer, ein Professor für Informatik an der Carnegie Mellon University, der sich auf KI spezialisiert hat, kommentierte den Kontrast zwischen den beeindruckenden Fortschritten bei Benchmarks wie der IMO und den anhaltenden Schwierigkeiten von Sprachmodellen mit einfachen Alltagsproblemen. Er betonte die Notwendigkeit, diese Systeme und die von ihnen ausgehenden Risiken besser zu verstehen.

AlphaGeometry2 deutet darauf hin–

System:

AlphaGeometry2 deutet darauf hin, dass die Kombination von Symbolmanipulation und neuronalen Netzen ein vielversprechender Weg für die Entwicklung generalisierbarer KI sein könnte. Interessanterweise stellte das DeepMind-Team fest, dass das Sprachmodell von AlphaGeometry2 Teillösungen für Probleme ohne die Hilfe des symbolischen Motors generieren konnte, was auf das Potenzial hinweist, dass Sprachmodelle in Zukunft eigenständig werden könnten.

Das Team stellte jedoch fest, dass solange die Geschwindigkeit von Sprachmodellen nicht verbessert wird und Halluzinationen behoben sind, Werkzeuge wie der symbolische Motor für mathematische Anwendungen unerlässlich bleiben werden.

Verwandter Artikel

Midjourney stellt hochmodernen AI-Video-Generator für kreative Inhalte vor

Midjourne's Durchbruch bei der KI-VideoerzeugungMidjourney hat sein erstes Tool zur Erzeugung von KI-Videos vorgestellt und damit seine bekannten Fähigkeiten zur Bilderstellung deutlich erweitert. Die

Midjourney stellt hochmodernen AI-Video-Generator für kreative Inhalte vor

Midjourne's Durchbruch bei der KI-VideoerzeugungMidjourney hat sein erstes Tool zur Erzeugung von KI-Videos vorgestellt und damit seine bekannten Fähigkeiten zur Bilderstellung deutlich erweitert. Die

Google stoppt Pixel 10-Leaks durch frühzeitige offizielle Enthüllung des Smartphones

Google lockt seine Fans mit einem frühen Blick auf das kommende Pixel 10-Smartphone und zeigt das offizielle Design nur wenige Wochen vor dem geplanten Launch-Event am 20. August.Ein Werbevideo auf de

Google stoppt Pixel 10-Leaks durch frühzeitige offizielle Enthüllung des Smartphones

Google lockt seine Fans mit einem frühen Blick auf das kommende Pixel 10-Smartphone und zeigt das offizielle Design nur wenige Wochen vor dem geplanten Launch-Event am 20. August.Ein Werbevideo auf de

Googles Gemini-App mit Echtzeit-KI-Video, Deep Research und neuen Funktionen (120 Zeichen)

Google hat auf seiner Entwicklerkonferenz I/O 2025 wichtige Verbesserungen für Gemini AI vorgestellt. Dabei wurden die multimodalen Funktionen erweitert, KI-Modelle der nächsten Generation eingeführt

Kommentare (31)

0/200

Googles Gemini-App mit Echtzeit-KI-Video, Deep Research und neuen Funktionen (120 Zeichen)

Google hat auf seiner Entwicklerkonferenz I/O 2025 wichtige Verbesserungen für Gemini AI vorgestellt. Dabei wurden die multimodalen Funktionen erweitert, KI-Modelle der nächsten Generation eingeführt

Kommentare (31)

0/200

![KevinBrown]() KevinBrown

KevinBrown

3. September 2025 14:30:33 MESZ

3. September 2025 14:30:33 MESZ

Impressionnant mais un peu flippant... Si une IA peut battre des médaillés d'or aux Olympiades, qu'est-ce qui nous reste comme domaines où les humains sont encore les meilleurs ? 😅 J'espère qu'on va pas tous devenir obsolètes !

0

0

![GregoryWalker]() GregoryWalker

GregoryWalker

20. August 2025 19:01:20 MESZ

20. August 2025 19:01:20 MESZ

This AI beating IMO champs is wild! 🧠 Geometry’s tough, but AlphaGeometry2’s out here crushing it. Makes me wonder if it’ll start tutoring kids soon! 😄

0

0

![AnthonyMoore]() AnthonyMoore

AnthonyMoore

19. August 2025 21:01:23 MESZ

19. August 2025 21:01:23 MESZ

Incroyable, AlphaGeometry2 dépasse les médaillés d'or de l'IMO en géométrie ! 😲 Ça montre à quel point l'IA avance vite, mais je me demande si elle pourrait un jour résoudre des problèmes plus... humains, comme gérer mes impôts !

0

0

![GaryThomas]() GaryThomas

GaryThomas

14. August 2025 03:00:59 MESZ

14. August 2025 03:00:59 MESZ

This AI beating IMO gold medalists is wild! 🤯 Geometry’s tough, but AlphaGeometry2’s out here making it look easy. Wonder how far it’ll go in other math fields?

0

0

![AlbertSmith]() AlbertSmith

AlbertSmith

9. August 2025 23:00:59 MESZ

9. August 2025 23:00:59 MESZ

Wow, AlphaGeometry2 is killing it at IMO geometry problems! Beating gold medalists is wild—makes me wonder if AI will soon design math contests instead of just solving them. 😮

0

0

![JackCarter]() JackCarter

JackCarter

28. Juli 2025 04:13:31 MESZ

28. Juli 2025 04:13:31 MESZ

This AI beating IMO champs is wild! 🤯 Makes me wonder if it could tutor me in math or just take over the world one proof at a time.

0

0

Google DeepMinds neueste KI, AlphaGeometry2, hat Aufsehen erregt, indem sie den durchschnittlichen Goldmedaillengewinner bei der Lösung von Geometrieproblemen bei der Internationalen Mathematik-Olympiade (IMO) übertrifft. Diese verbesserte Version von AlphaGeometry, die erst im Januar vorgestellt wurde, löste Berichten zufolge 84 % der Geometrieprobleme der letzten 25 Jahre der IMO-Wettbewerbe.

Sie fragen sich vielleicht, warum DeepMind sich auf einen Mathematikwettbewerb für Schüler konzentriert. Nun, sie glauben, dass das Knacken dieser anspruchsvollen euklidischen Geometrieprobleme ein Sprungbrett sein könnte, um fortschrittlichere KI zu entwickeln. Das Lösen dieser Probleme erfordert sowohl logisches Denken als auch die Fähigkeit, verschiedene Lösungswege zu navigieren, Fähigkeiten, die für zukünftige universelle KI-Systeme entscheidend sein könnten.

Diesen Sommer stellte DeepMind ein System vor, das AlphaGeometry2 mit AlphaProof kombinierte, einem weiteren KI-Modell für formales mathematisches Denken. Zusammen lösten sie vier von sechs Problemen der IMO 2024. Dieser Ansatz könnte potenziell über die Geometrie hinaus auf andere Bereiche der Mathematik und Wissenschaft angewendet werden, wie komplexe technische Berechnungen.

AlphaGeometry2 wird von einigen Schlüsselkomponenten angetrieben, darunter ein Sprachmodell aus Googles Gemini-Familie und ein "symbolischer Motor". Das Gemini-Modell unterstützt den symbolischen Motor, der mathematische Regeln anwendet, um Lösungen zu finden, bei der Erstellung machbarer Beweise für Geometriesätze.

In der IMO erfordern Geometrieprobleme oft das Hinzufügen von "Konstrukten" wie Punkten, Linien oder Kreisen zu Diagrammen, bevor sie gelöst werden. Das Gemini-Modell von AlphaGeometry2 sagt voraus, welche Konstrukte hilfreich sein könnten, und leitet den symbolischen Motor, um Schlussfolgerungen zu ziehen.

So funktioniert es: Das Gemini-Modell schlägt Schritte und Konstruktionen in einer formalen mathematischen Sprache vor, die der Motor dann auf logische Konsistenz überprüft. AlphaGeometry2 verwendet einen Suchalgorithmus, um mehrere Lösungswege gleichzeitig zu erkunden und speichert potenziell nützliche Erkenntnisse in einer gemeinsamen Wissensdatenbank.

Ein Problem gilt als "gelöst", wenn AlphaGeometry2 die Vorschläge des Gemini-Modells mit den bekannten Prinzipien des symbolischen Motors kombiniert, um einen vollständigen Beweis zu erstellen.

Aufgrund der Knappheit nutzbarer Geometrie-Trainingsdaten erstellte DeepMind synthetische Daten, um das Sprachmodell von AlphaGeometry2 zu trainieren, und generierte über 300 Millionen Theoreme und Beweise unterschiedlicher Komplexität.

Das DeepMind-Team testete AlphaGeometry2 an 45 Geometrieproblemen aus IMO-Wettbewerben von 2000 bis 2024, die sie auf 50 Probleme erweiterten. AlphaGeometry2 löste 42 davon und übertraf den durchschnittlichen Goldmedaillen-Score von 40,9.

Allerdings hat AlphaGeometry2 seine Gren Limitations. Es hat Schwierigkeiten mit Problemen, die eine variable Anzahl von Punkten, nichtlineare Gleichungen und Ungleichungen beinhalten. Obwohl es nicht die erste KI ist, die Goldmedaillen-Niveau in Geometrie erreicht, ist es die erste, die dies mit einem so großen Problemset erreicht.

Als sie mit einem schwierigeren Satz von 29 noch nicht in Wettbewerben erschienenen IMO-nominierten Problemen konfrontiert wurde, konnte AlphaGeometry2 nur 20 lösen.

Die Ergebnisse der Studie werden wahrscheinlich weitere Debatten über den besten Ansatz zum Bau von KI-Systemen auslösen. Sollten wir uns auf Symbolmanipulation konzentrieren, bei der KI Regeln verwendet, um Symbole zu manipulieren, die Wissen repräsentieren, oder auf neuronale Netze, die die Struktur des menschlichen Gehirns nachahmen und aus Daten lernen?

AlphaGeometry2 verfolgt einen hybriden Ansatz, der die neuronale Netzwerkarchitektur des Gemini-Modells mit dem regelbasierten symbolischen Motor kombiniert.

Befürworter neuronaler Netze argumentieren, dass intelligentes Verhalten aus großen Datenmengen und Rechenleistung entstehen kann. Im Gegensatz dazu glauben Befürworter symbolischer KI, dass sie besser geeignet ist, Wissen zu kodieren, durch komplexe Szenarien zu argumentieren und Lösungen zu erklären.

Vince Conitzer, ein Professor für Informatik an der Carnegie Mellon University, der sich auf KI spezialisiert hat, kommentierte den Kontrast zwischen den beeindruckenden Fortschritten bei Benchmarks wie der IMO und den anhaltenden Schwierigkeiten von Sprachmodellen mit einfachen Alltagsproblemen. Er betonte die Notwendigkeit, diese Systeme und die von ihnen ausgehenden Risiken besser zu verstehen.

AlphaGeometry2 deutet darauf hin–

System:

AlphaGeometry2 deutet darauf hin, dass die Kombination von Symbolmanipulation und neuronalen Netzen ein vielversprechender Weg für die Entwicklung generalisierbarer KI sein könnte. Interessanterweise stellte das DeepMind-Team fest, dass das Sprachmodell von AlphaGeometry2 Teillösungen für Probleme ohne die Hilfe des symbolischen Motors generieren konnte, was auf das Potenzial hinweist, dass Sprachmodelle in Zukunft eigenständig werden könnten.

Das Team stellte jedoch fest, dass solange die Geschwindigkeit von Sprachmodellen nicht verbessert wird und Halluzinationen behoben sind, Werkzeuge wie der symbolische Motor für mathematische Anwendungen unerlässlich bleiben werden.

Midjourney stellt hochmodernen AI-Video-Generator für kreative Inhalte vor

Midjourne's Durchbruch bei der KI-VideoerzeugungMidjourney hat sein erstes Tool zur Erzeugung von KI-Videos vorgestellt und damit seine bekannten Fähigkeiten zur Bilderstellung deutlich erweitert. Die

Midjourney stellt hochmodernen AI-Video-Generator für kreative Inhalte vor

Midjourne's Durchbruch bei der KI-VideoerzeugungMidjourney hat sein erstes Tool zur Erzeugung von KI-Videos vorgestellt und damit seine bekannten Fähigkeiten zur Bilderstellung deutlich erweitert. Die

Google stoppt Pixel 10-Leaks durch frühzeitige offizielle Enthüllung des Smartphones

Google lockt seine Fans mit einem frühen Blick auf das kommende Pixel 10-Smartphone und zeigt das offizielle Design nur wenige Wochen vor dem geplanten Launch-Event am 20. August.Ein Werbevideo auf de

Google stoppt Pixel 10-Leaks durch frühzeitige offizielle Enthüllung des Smartphones

Google lockt seine Fans mit einem frühen Blick auf das kommende Pixel 10-Smartphone und zeigt das offizielle Design nur wenige Wochen vor dem geplanten Launch-Event am 20. August.Ein Werbevideo auf de

3. September 2025 14:30:33 MESZ

3. September 2025 14:30:33 MESZ

Impressionnant mais un peu flippant... Si une IA peut battre des médaillés d'or aux Olympiades, qu'est-ce qui nous reste comme domaines où les humains sont encore les meilleurs ? 😅 J'espère qu'on va pas tous devenir obsolètes !

0

0

20. August 2025 19:01:20 MESZ

20. August 2025 19:01:20 MESZ

This AI beating IMO champs is wild! 🧠 Geometry’s tough, but AlphaGeometry2’s out here crushing it. Makes me wonder if it’ll start tutoring kids soon! 😄

0

0

19. August 2025 21:01:23 MESZ

19. August 2025 21:01:23 MESZ

Incroyable, AlphaGeometry2 dépasse les médaillés d'or de l'IMO en géométrie ! 😲 Ça montre à quel point l'IA avance vite, mais je me demande si elle pourrait un jour résoudre des problèmes plus... humains, comme gérer mes impôts !

0

0

14. August 2025 03:00:59 MESZ

14. August 2025 03:00:59 MESZ

This AI beating IMO gold medalists is wild! 🤯 Geometry’s tough, but AlphaGeometry2’s out here making it look easy. Wonder how far it’ll go in other math fields?

0

0

9. August 2025 23:00:59 MESZ

9. August 2025 23:00:59 MESZ

Wow, AlphaGeometry2 is killing it at IMO geometry problems! Beating gold medalists is wild—makes me wonder if AI will soon design math contests instead of just solving them. 😮

0

0

28. Juli 2025 04:13:31 MESZ

28. Juli 2025 04:13:31 MESZ

This AI beating IMO champs is wild! 🤯 Makes me wonder if it could tutor me in math or just take over the world one proof at a time.

0

0