Anthropisch enthüllt das KI -Modell mit anpassbarer Denkdauer

Anthropics neuester KI-Modell, Claude 3.7 Sonnet, sorgt für Aufsehen in der Welt der KI. Als das erste „hybride KI-Modell mit Schlussfolgerungsfähigkeit“ der Branche bezeichnet, ist es darauf ausgelegt, Ihnen sowohl schnelle Antworten als auch durchdachtere Reaktionen zu liefern, je nachdem, was Sie benötigen. Sie können sogar wählen, wie lange Claude über Ihre Fragen „nachdenken“ soll – ziemlich cool, oder?

Die Idee hinter Claude 3.7 Sonnet ist, die Nutzung von KI viel einfacher zu gestalten. Anstatt aus einer Vielzahl verschiedener Modelle wählen zu müssen, möchte Anthropic ein einziges Modell, das alles abdeckt. Ab Montag kann jeder Claude 3.7 Sonnet ausprobieren, aber wenn Sie die ausgefallenen Schlussfolgerungsfunktionen nutzen möchten, müssen Sie eines von Anthropics Premium-Plänen abonnieren. Kostenlose Nutzer erhalten immer noch eine solide Version des Modells, die laut Anthropic besser ist als das vorherige, Claude 3.5 Sonnet.

Nun zum Preis – Claude 3.7 Sonnet kostet 3 $ pro Million Eingabe-Token und 15 $ pro Million Ausgabe-Token. Das ist etwas teurer als einige andere Modelle da draußen, wie OpenAIs o3-mini und DeepSeeks R1, aber bedenken Sie, dass diese nur Schlussfolgerungsmodelle sind, keine Hybride wie Claude.

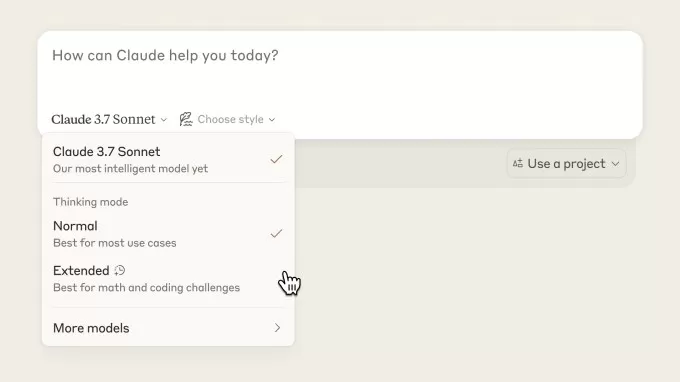

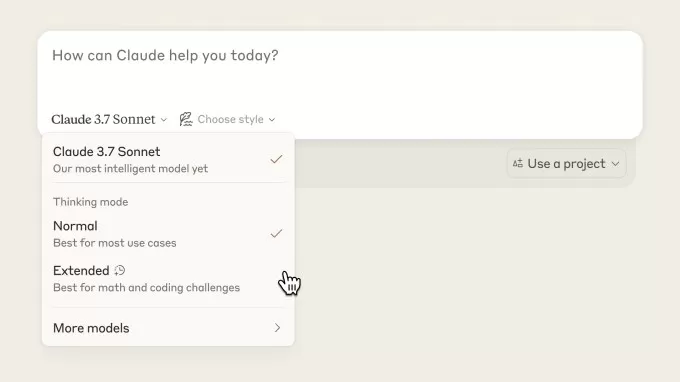

Anthropics neue Denkmodi Bildnachweis: Anthropic Claude 3.7 Sonnet ist Anthropics erstes Modell, das „schlussfolgern“ kann, was in der KI-Welt eine große Sache ist. Schlussfolgerungsmodelle benötigen etwas mehr Zeit und Rechenleistung, um Fragen zu beantworten, indem sie diese in kleinere Schritte zerlegen, um genauere Antworten zu liefern. Es ist nicht exakt wie menschliches Denken, aber es ist danach modelliert.Anthropic hat große Pläne für Claude. Langfristig wollen sie, dass es selbstständig entscheidet, wie lange es über Fragen „nachdenken“ sollte, ohne dass Sie es einstellen müssen. Dianne Penn, Anthropics Leiterin für Produkte und Forschung, sagte TechCrunch, dass sie Schlussfolgerung als nur eine von vielen Fähigkeiten betrachten, die ein Spitzenmodell in einem vereinen sollte.

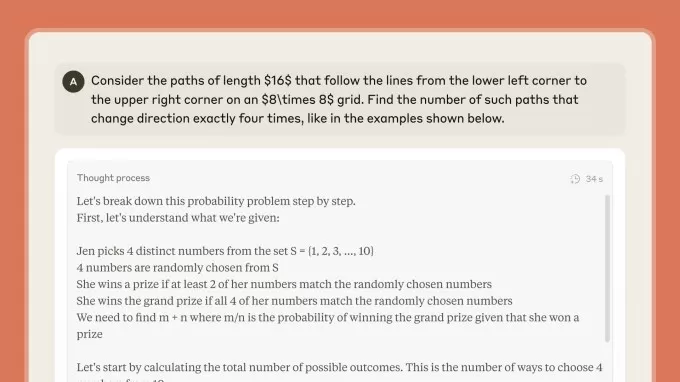

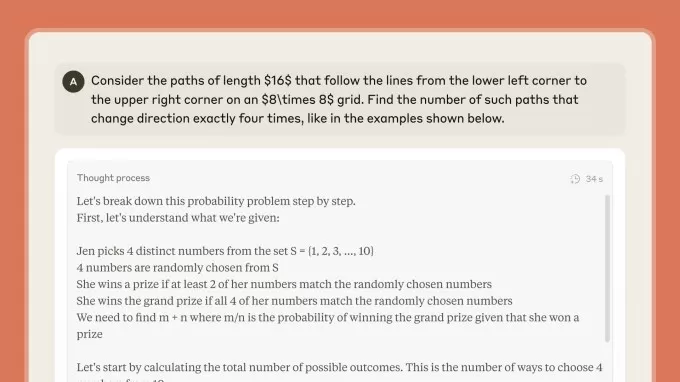

Mit Claude 3.7 Sonnet können Sie sogar sehen, wie es seine Antworten plant, durch einen „sichtbaren Notizzettel“. Meistens sehen Sie den gesamten Prozess, aber Anthropic könnte aus Sicherheitsgründen einige Teile schwärzen.

Claudes Denkprozess in der Claude-App Bildnachweis: Anthropic Anthropic sagt, sie haben Claudes Denkmodi für reale Aufgaben optimiert, wie knifflige Programmierprobleme oder Aufgaben, die etwas Autonomie erfordern. Wenn Sie ein Entwickler sind, der Anthropics API nutzt, können Sie sogar steuern, wie viel „Nachdenken“ Claude betreibt, um Geschwindigkeit und Kosten mit der Qualität der Antwort abzuwägen.In einigen Tests hat Claude 3.7 Sonnet gut abgeschnitten. Auf SWE-Bench, einem Test für reale Programmieraufgaben, erzielte es 62,3 %, besser als OpenAIs o3-mini mit 49,3 %. Und auf TAU-Bench, das misst, wie gut eine KI mit simulierten Nutzern und externen APIs in einem Einzelhandelsumfeld interagieren kann, erzielte Claude 3.7 Sonnet 81,2 %, verglichen mit OpenAIs o1-Modell, das 73,5 % erreichte.

Anthropic sagt auch, dass Claude 3.7 Sonnet weniger dazu neigen wird, Antworten zu verweigern, und feinere Unterschiede zwischen schädlichen und harmlosen Eingaben trifft. Sie haben unnötige Verweigerungen im Vergleich zu Claude 3.5 Sonnet um 45 % reduziert.

Zusammen mit Claude 3.7 Sonnet bringt Anthropic auch ein neues Tool namens Claude Code heraus. Es handelt sich um eine Forschungsvorschau, die Entwicklern ermöglicht, bestimmte Aufgaben direkt über Claude von ihrem Terminal aus auszuführen. In einer Demo zeigte Anthropic, wie Claude Code ein Programmierprojekt mit einem einfachen Befehl wie „Erkläre diese Projektstruktur“ analysieren kann. Sie können sogar einfaches Deutsch verwenden, um einen Codebestand zu ändern, und Claude Code beschreibt seine Änderungen währenddessen, prüft auf Fehler und schiebt das Projekt in ein GitHub-Repository.

Claude Code wird einer begrenzten Anzahl von Nutzern auf „Wer zuerst kommt, mahlt zuerst“-Basis zur Verfügung stehen.

Anthropic bringt Claude 3.7 Sonnet zu einer Zeit auf den Markt, in der KI-Labore neue Modelle am laufenden Band herausbringen. Während Anthropic normalerweise einen vorsichtigen, sicherheitsorientierten Ansatz verfolgt, wollen sie diesmal die Nase vorn haben. Aber wie lange sie die Führung behalten, ist ungewiss – besonders da OpenAIs CEO, Sam Altman, sagt, dass sie in „Monaten“ ein eigenes hybrides KI-Modell herausbringen.

Verwandter Artikel

Claude 4 Enthüllt: Next-Gen KI-Modelle steigern Programmier- und Agentenleistung

Anthropic hat seine Claude 4 Modellfamilie vorgestellt, die einen bedeutenden Fortschritt für Entwickler darstellt, die hochmoderne KI-Assistenten und Programmierlösungen entwickeln. Die Reihe umfasst

Claude 4 Enthüllt: Next-Gen KI-Modelle steigern Programmier- und Agentenleistung

Anthropic hat seine Claude 4 Modellfamilie vorgestellt, die einen bedeutenden Fortschritt für Entwickler darstellt, die hochmoderne KI-Assistenten und Programmierlösungen entwickeln. Die Reihe umfasst

Anthropic stellt App-Integrationen und erweiterte Forschungsfunktionen für Claude AI vor

Anthropic hat am Donnerstag einen neuen Ansatz für die Verknüpfung von Anwendungen und Tools mit seinem KI-Assistenten Claude sowie eine verbesserte Tiefenforschungsfunktion vorgestellt, mit der Claud

Anthropic stellt App-Integrationen und erweiterte Forschungsfunktionen für Claude AI vor

Anthropic hat am Donnerstag einen neuen Ansatz für die Verknüpfung von Anwendungen und Tools mit seinem KI-Assistenten Claude sowie eine verbesserte Tiefenforschungsfunktion vorgestellt, mit der Claud

Anthropic CEO: KI-Halluzinationsraten übertreffen menschliche Genauigkeit

Anthropic CEO Dario Amodei erklärte auf einer Pressekonferenz am Donnerstag auf der ersten Entwicklerkonferenz von Anthropic, Code with Claude, in San Francisco, dass aktuelle KI-Modelle weniger Erfin

Kommentare (54)

0/200

Anthropic CEO: KI-Halluzinationsraten übertreffen menschliche Genauigkeit

Anthropic CEO Dario Amodei erklärte auf einer Pressekonferenz am Donnerstag auf der ersten Entwicklerkonferenz von Anthropic, Code with Claude, in San Francisco, dass aktuelle KI-Modelle weniger Erfin

Kommentare (54)

0/200

![RaymondAdams]() RaymondAdams

RaymondAdams

11. August 2025 07:00:59 MESZ

11. August 2025 07:00:59 MESZ

This hybrid AI model sounds like a game-changer! Being able to tweak how long Claude thinks is super cool, like choosing between a quick coffee chat or a deep dive convo. Excited to see how this stacks up against other AI out there! 😎

0

0

![ChristopherDavis]() ChristopherDavis

ChristopherDavis

5. August 2025 21:00:59 MESZ

5. August 2025 21:00:59 MESZ

Claude 3.7 Sonnet a l'air incroyable ! Pouvoir choisir la durée de réflexion, c'est comme demander à un chef de cuisiner vite ou de prendre son temps pour un plat parfait. J'ai hâte de voir comment ça marche en pratique ! 😄

0

0

![WillieAdams]() WillieAdams

WillieAdams

1. August 2025 08:08:50 MESZ

1. August 2025 08:08:50 MESZ

Claude's customizable thinking duration sounds like a game-changer! I wonder how it balances speed and depth in real-world tasks. Excited to try it out! 😄

0

0

![ScarlettWhite]() ScarlettWhite

ScarlettWhite

23. Juli 2025 06:59:47 MESZ

23. Juli 2025 06:59:47 MESZ

Wow, Claude 3.7 sounds like a game-changer! Being able to tweak how long it thinks is such a cool feature. I’m curious how this will stack up against other AI models in real-world tasks. Anyone tried it yet? 😄

0

0

![CharlesRoberts]() CharlesRoberts

CharlesRoberts

23. April 2025 16:11:54 MESZ

23. April 2025 16:11:54 MESZ

O Claude 3.7 Sonnet é incrível! Adoro poder escolher a duração do pensamento. Às vezes preciso de respostas rápidas, outras vezes quero respostas mais pensadas. É como ter um amigo AI personalizável! Só desejo que fosse um pouco mais rápido às vezes. 😎

0

0

![RyanAnderson]() RyanAnderson

RyanAnderson

22. April 2025 16:04:41 MESZ

22. April 2025 16:04:41 MESZ

Claude 3.7 Sonnet is a game-changer! I love how I can choose the thinking duration. Sometimes I need quick answers, and other times I want a more thoughtful response. It's like having a customizable AI buddy! Only wish it was a bit faster at times. 🤓

0

0

Anthropics neuester KI-Modell, Claude 3.7 Sonnet, sorgt für Aufsehen in der Welt der KI. Als das erste „hybride KI-Modell mit Schlussfolgerungsfähigkeit“ der Branche bezeichnet, ist es darauf ausgelegt, Ihnen sowohl schnelle Antworten als auch durchdachtere Reaktionen zu liefern, je nachdem, was Sie benötigen. Sie können sogar wählen, wie lange Claude über Ihre Fragen „nachdenken“ soll – ziemlich cool, oder?

Die Idee hinter Claude 3.7 Sonnet ist, die Nutzung von KI viel einfacher zu gestalten. Anstatt aus einer Vielzahl verschiedener Modelle wählen zu müssen, möchte Anthropic ein einziges Modell, das alles abdeckt. Ab Montag kann jeder Claude 3.7 Sonnet ausprobieren, aber wenn Sie die ausgefallenen Schlussfolgerungsfunktionen nutzen möchten, müssen Sie eines von Anthropics Premium-Plänen abonnieren. Kostenlose Nutzer erhalten immer noch eine solide Version des Modells, die laut Anthropic besser ist als das vorherige, Claude 3.5 Sonnet.

Nun zum Preis – Claude 3.7 Sonnet kostet 3 $ pro Million Eingabe-Token und 15 $ pro Million Ausgabe-Token. Das ist etwas teurer als einige andere Modelle da draußen, wie OpenAIs o3-mini und DeepSeeks R1, aber bedenken Sie, dass diese nur Schlussfolgerungsmodelle sind, keine Hybride wie Claude.

Anthropic hat große Pläne für Claude. Langfristig wollen sie, dass es selbstständig entscheidet, wie lange es über Fragen „nachdenken“ sollte, ohne dass Sie es einstellen müssen. Dianne Penn, Anthropics Leiterin für Produkte und Forschung, sagte TechCrunch, dass sie Schlussfolgerung als nur eine von vielen Fähigkeiten betrachten, die ein Spitzenmodell in einem vereinen sollte.

Mit Claude 3.7 Sonnet können Sie sogar sehen, wie es seine Antworten plant, durch einen „sichtbaren Notizzettel“. Meistens sehen Sie den gesamten Prozess, aber Anthropic könnte aus Sicherheitsgründen einige Teile schwärzen.

In einigen Tests hat Claude 3.7 Sonnet gut abgeschnitten. Auf SWE-Bench, einem Test für reale Programmieraufgaben, erzielte es 62,3 %, besser als OpenAIs o3-mini mit 49,3 %. Und auf TAU-Bench, das misst, wie gut eine KI mit simulierten Nutzern und externen APIs in einem Einzelhandelsumfeld interagieren kann, erzielte Claude 3.7 Sonnet 81,2 %, verglichen mit OpenAIs o1-Modell, das 73,5 % erreichte.

Anthropic sagt auch, dass Claude 3.7 Sonnet weniger dazu neigen wird, Antworten zu verweigern, und feinere Unterschiede zwischen schädlichen und harmlosen Eingaben trifft. Sie haben unnötige Verweigerungen im Vergleich zu Claude 3.5 Sonnet um 45 % reduziert.

Zusammen mit Claude 3.7 Sonnet bringt Anthropic auch ein neues Tool namens Claude Code heraus. Es handelt sich um eine Forschungsvorschau, die Entwicklern ermöglicht, bestimmte Aufgaben direkt über Claude von ihrem Terminal aus auszuführen. In einer Demo zeigte Anthropic, wie Claude Code ein Programmierprojekt mit einem einfachen Befehl wie „Erkläre diese Projektstruktur“ analysieren kann. Sie können sogar einfaches Deutsch verwenden, um einen Codebestand zu ändern, und Claude Code beschreibt seine Änderungen währenddessen, prüft auf Fehler und schiebt das Projekt in ein GitHub-Repository.

Claude Code wird einer begrenzten Anzahl von Nutzern auf „Wer zuerst kommt, mahlt zuerst“-Basis zur Verfügung stehen.

Anthropic bringt Claude 3.7 Sonnet zu einer Zeit auf den Markt, in der KI-Labore neue Modelle am laufenden Band herausbringen. Während Anthropic normalerweise einen vorsichtigen, sicherheitsorientierten Ansatz verfolgt, wollen sie diesmal die Nase vorn haben. Aber wie lange sie die Führung behalten, ist ungewiss – besonders da OpenAIs CEO, Sam Altman, sagt, dass sie in „Monaten“ ein eigenes hybrides KI-Modell herausbringen.

Claude 4 Enthüllt: Next-Gen KI-Modelle steigern Programmier- und Agentenleistung

Anthropic hat seine Claude 4 Modellfamilie vorgestellt, die einen bedeutenden Fortschritt für Entwickler darstellt, die hochmoderne KI-Assistenten und Programmierlösungen entwickeln. Die Reihe umfasst

Claude 4 Enthüllt: Next-Gen KI-Modelle steigern Programmier- und Agentenleistung

Anthropic hat seine Claude 4 Modellfamilie vorgestellt, die einen bedeutenden Fortschritt für Entwickler darstellt, die hochmoderne KI-Assistenten und Programmierlösungen entwickeln. Die Reihe umfasst

Anthropic stellt App-Integrationen und erweiterte Forschungsfunktionen für Claude AI vor

Anthropic hat am Donnerstag einen neuen Ansatz für die Verknüpfung von Anwendungen und Tools mit seinem KI-Assistenten Claude sowie eine verbesserte Tiefenforschungsfunktion vorgestellt, mit der Claud

Anthropic stellt App-Integrationen und erweiterte Forschungsfunktionen für Claude AI vor

Anthropic hat am Donnerstag einen neuen Ansatz für die Verknüpfung von Anwendungen und Tools mit seinem KI-Assistenten Claude sowie eine verbesserte Tiefenforschungsfunktion vorgestellt, mit der Claud

Anthropic CEO: KI-Halluzinationsraten übertreffen menschliche Genauigkeit

Anthropic CEO Dario Amodei erklärte auf einer Pressekonferenz am Donnerstag auf der ersten Entwicklerkonferenz von Anthropic, Code with Claude, in San Francisco, dass aktuelle KI-Modelle weniger Erfin

Anthropic CEO: KI-Halluzinationsraten übertreffen menschliche Genauigkeit

Anthropic CEO Dario Amodei erklärte auf einer Pressekonferenz am Donnerstag auf der ersten Entwicklerkonferenz von Anthropic, Code with Claude, in San Francisco, dass aktuelle KI-Modelle weniger Erfin

11. August 2025 07:00:59 MESZ

11. August 2025 07:00:59 MESZ

This hybrid AI model sounds like a game-changer! Being able to tweak how long Claude thinks is super cool, like choosing between a quick coffee chat or a deep dive convo. Excited to see how this stacks up against other AI out there! 😎

0

0

5. August 2025 21:00:59 MESZ

5. August 2025 21:00:59 MESZ

Claude 3.7 Sonnet a l'air incroyable ! Pouvoir choisir la durée de réflexion, c'est comme demander à un chef de cuisiner vite ou de prendre son temps pour un plat parfait. J'ai hâte de voir comment ça marche en pratique ! 😄

0

0

1. August 2025 08:08:50 MESZ

1. August 2025 08:08:50 MESZ

Claude's customizable thinking duration sounds like a game-changer! I wonder how it balances speed and depth in real-world tasks. Excited to try it out! 😄

0

0

23. Juli 2025 06:59:47 MESZ

23. Juli 2025 06:59:47 MESZ

Wow, Claude 3.7 sounds like a game-changer! Being able to tweak how long it thinks is such a cool feature. I’m curious how this will stack up against other AI models in real-world tasks. Anyone tried it yet? 😄

0

0

23. April 2025 16:11:54 MESZ

23. April 2025 16:11:54 MESZ

O Claude 3.7 Sonnet é incrível! Adoro poder escolher a duração do pensamento. Às vezes preciso de respostas rápidas, outras vezes quero respostas mais pensadas. É como ter um amigo AI personalizável! Só desejo que fosse um pouco mais rápido às vezes. 😎

0

0

22. April 2025 16:04:41 MESZ

22. April 2025 16:04:41 MESZ

Claude 3.7 Sonnet is a game-changer! I love how I can choose the thinking duration. Sometimes I need quick answers, and other times I want a more thoughtful response. It's like having a customizable AI buddy! Only wish it was a bit faster at times. 🤓

0

0