人工智能聊天机器人面临开发者设计的争议性话题测试

一位化名为 "xlr8harder "的开发者推出了 "言论自由评估 "工具 SpeechMap,分析领先的人工智能聊天机器人如何处理有争议的话题。该平台比较了 OpenAI 的 ChatGPT 和 xAI 的 Grok 等模型对政治言论、民权讨论和抗议相关询问的反应。

这一举措是在人工智能公司因其系统中存在政治偏见而面临越来越多审查的情况下出现的。包括埃隆-马斯克(Elon Musk)和大卫-萨克斯(David Sacks)在内的几位白宫盟友和知名科技人士都指责主流聊天机器人表现出进步倾向的审查制度。

虽然人工智能公司还没有直接回应这些指控,但有些公司已经做出了回应。Meta 公司最近调整了其 Llama 模型,以避免在处理有争议的话题时偏向特定的政治观点。

SpeechMap 的创建者解释了他们的动机:"这些对话属于公共领域,而不局限于公司会议室。我的平台让用户能够通过客观测试来检验第一手数据"。

评估方法采用人工智能评委,对聊天机器人的回复进行政治评论、历史解读和国家标志分类等方面的评估。每次互动都会被归类为

- 完全服从(直接回答)

- 回避式回答

- 直接拒绝

Xlr8harder 承认方法上的局限性,包括潜在的法官模型偏差和技术不一致性。不过,收集到的数据揭示了领先人工智能系统中值得注意的行为模式。

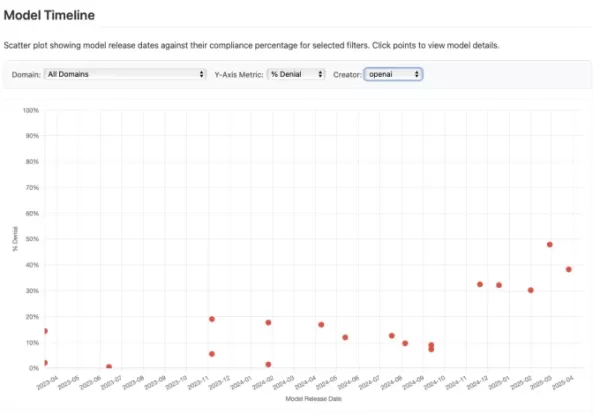

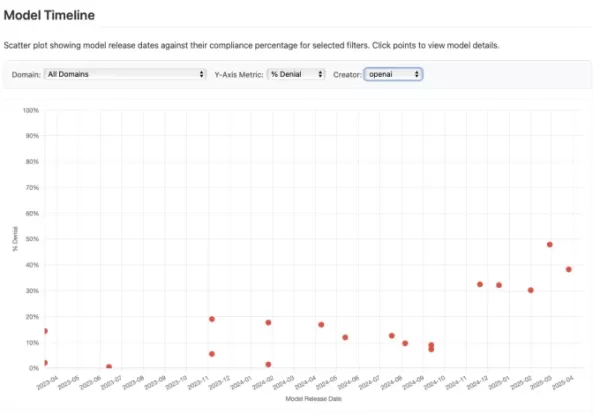

值得注意的发现包括 OpenAI 不断演变的政治话语方式。最近的 GPT 迭代显示,尽管 OpenAI 在二月份承诺要对有争议的问题提出更平衡的观点,但在处理敏感话题时却更加克制。

基于 SpeechMap 数据的 OpenAI 模型响应趋势 分析将 xAI 的 Grok 3 定位为测试中最不受约束的模型,它对 96.2% 的提示做出了响应,而行业平均响应率为 71.3%。这与马斯克最初将Grok定位为 "清醒 "人工智能系统的不受限制的替代品是一致的。

"SpeechMap开发人员指出:"虽然大多数模型越来越多地限制政治评论,但xAI似乎有意减少对话限制。

尽管马斯克承诺保持中立,但早期的 Grok 版本在性别认同和经济不平等等问题上仍然表现出进步的倾向。首席执行官之前将这些偏见归咎于来自公共网络资源的训练数据的影响。

最近的评估表明,Grok 3 实现了更大程度的政治中立,尽管该系统曾因短暂审查马斯克的负面评论而招致批评。这一演变反映了自由表达原则与人工智能开发者面临的内容审核挑战之间持续存在的紧张关系。

相关文章

ChatGPT 将 LinkedIn 用户变成单调的人工智能克隆人

ChatGPT 图像生成功能的最新版本以吉卜力工作室为灵感的艺术作品掀起了波澜,现在 LinkedIn 用户又催生了一种新现象:将专业肖像变成人工智能生成的玩具公仔。玩具变身潮流平台上出现了对这一创意运动的各种诠释。其中,"AI 动图 "的概念在这一趋势中占据主导地位,在这一概念中,专业人士生成的塑化版自己包装得像收藏品一样--配有笔记本电脑、笔记本电脑和咖啡杯等职业配件,完全符合 LinkedI

ChatGPT 将 LinkedIn 用户变成单调的人工智能克隆人

ChatGPT 图像生成功能的最新版本以吉卜力工作室为灵感的艺术作品掀起了波澜,现在 LinkedIn 用户又催生了一种新现象:将专业肖像变成人工智能生成的玩具公仔。玩具变身潮流平台上出现了对这一创意运动的各种诠释。其中,"AI 动图 "的概念在这一趋势中占据主导地位,在这一概念中,专业人士生成的塑化版自己包装得像收藏品一样--配有笔记本电脑、笔记本电脑和咖啡杯等职业配件,完全符合 LinkedI

ChatGPT 首席执行官考虑引入广告平台的可能性

OpenAI 探索收入来源,考虑在 ChatGPT 上投放广告OpenAI 正在评估各种货币化策略,在 ChatGPT 上投放广告是一个潜在的选择。在最近的一次Decoder采访中,ChatGPT 负责人尼克-特利(Nick Turley)采取了谨慎开放的态度,表示他 "很谦虚,不会断然排除这种可能性",同时强调需要深思熟虑后再实施。收入增长和业务战略这家人工智能公司预计今年的收入将

ChatGPT 首席执行官考虑引入广告平台的可能性

OpenAI 探索收入来源,考虑在 ChatGPT 上投放广告OpenAI 正在评估各种货币化策略,在 ChatGPT 上投放广告是一个潜在的选择。在最近的一次Decoder采访中,ChatGPT 负责人尼克-特利(Nick Turley)采取了谨慎开放的态度,表示他 "很谦虚,不会断然排除这种可能性",同时强调需要深思熟虑后再实施。收入增长和业务战略这家人工智能公司预计今年的收入将

在安全漏洞中利用 ChatGPT 窃取 Gmail 敏感数据

安全警报:研究人员展示人工智能驱动的数据外渗技术网络安全专家最近发现了一个令人担忧的漏洞,即 ChatGPT 的 "深度研究"(Deep Research)功能可被用来悄悄提取 Gmail 的机密数据。虽然 OpenAI 已经修补了这一特定漏洞,但这一事件凸显了自主人工智能系统带来的新安全挑战。影子泄漏漏洞利用机制Radware 的安全分析师开发了这一概念验证攻击,展示了人工智能固有的助人功能如何

评论 (0)

0/200

在安全漏洞中利用 ChatGPT 窃取 Gmail 敏感数据

安全警报:研究人员展示人工智能驱动的数据外渗技术网络安全专家最近发现了一个令人担忧的漏洞,即 ChatGPT 的 "深度研究"(Deep Research)功能可被用来悄悄提取 Gmail 的机密数据。虽然 OpenAI 已经修补了这一特定漏洞,但这一事件凸显了自主人工智能系统带来的新安全挑战。影子泄漏漏洞利用机制Radware 的安全分析师开发了这一概念验证攻击,展示了人工智能固有的助人功能如何

评论 (0)

0/200

一位化名为 "xlr8harder "的开发者推出了 "言论自由评估 "工具 SpeechMap,分析领先的人工智能聊天机器人如何处理有争议的话题。该平台比较了 OpenAI 的 ChatGPT 和 xAI 的 Grok 等模型对政治言论、民权讨论和抗议相关询问的反应。

这一举措是在人工智能公司因其系统中存在政治偏见而面临越来越多审查的情况下出现的。包括埃隆-马斯克(Elon Musk)和大卫-萨克斯(David Sacks)在内的几位白宫盟友和知名科技人士都指责主流聊天机器人表现出进步倾向的审查制度。

虽然人工智能公司还没有直接回应这些指控,但有些公司已经做出了回应。Meta 公司最近调整了其 Llama 模型,以避免在处理有争议的话题时偏向特定的政治观点。

SpeechMap 的创建者解释了他们的动机:"这些对话属于公共领域,而不局限于公司会议室。我的平台让用户能够通过客观测试来检验第一手数据"。

评估方法采用人工智能评委,对聊天机器人的回复进行政治评论、历史解读和国家标志分类等方面的评估。每次互动都会被归类为

- 完全服从(直接回答)

- 回避式回答

- 直接拒绝

Xlr8harder 承认方法上的局限性,包括潜在的法官模型偏差和技术不一致性。不过,收集到的数据揭示了领先人工智能系统中值得注意的行为模式。

值得注意的发现包括 OpenAI 不断演变的政治话语方式。最近的 GPT 迭代显示,尽管 OpenAI 在二月份承诺要对有争议的问题提出更平衡的观点,但在处理敏感话题时却更加克制。

分析将 xAI 的 Grok 3 定位为测试中最不受约束的模型,它对 96.2% 的提示做出了响应,而行业平均响应率为 71.3%。这与马斯克最初将Grok定位为 "清醒 "人工智能系统的不受限制的替代品是一致的。

"SpeechMap开发人员指出:"虽然大多数模型越来越多地限制政治评论,但xAI似乎有意减少对话限制。

尽管马斯克承诺保持中立,但早期的 Grok 版本在性别认同和经济不平等等问题上仍然表现出进步的倾向。首席执行官之前将这些偏见归咎于来自公共网络资源的训练数据的影响。

最近的评估表明,Grok 3 实现了更大程度的政治中立,尽管该系统曾因短暂审查马斯克的负面评论而招致批评。这一演变反映了自由表达原则与人工智能开发者面临的内容审核挑战之间持续存在的紧张关系。

ChatGPT 将 LinkedIn 用户变成单调的人工智能克隆人

ChatGPT 图像生成功能的最新版本以吉卜力工作室为灵感的艺术作品掀起了波澜,现在 LinkedIn 用户又催生了一种新现象:将专业肖像变成人工智能生成的玩具公仔。玩具变身潮流平台上出现了对这一创意运动的各种诠释。其中,"AI 动图 "的概念在这一趋势中占据主导地位,在这一概念中,专业人士生成的塑化版自己包装得像收藏品一样--配有笔记本电脑、笔记本电脑和咖啡杯等职业配件,完全符合 LinkedI

ChatGPT 将 LinkedIn 用户变成单调的人工智能克隆人

ChatGPT 图像生成功能的最新版本以吉卜力工作室为灵感的艺术作品掀起了波澜,现在 LinkedIn 用户又催生了一种新现象:将专业肖像变成人工智能生成的玩具公仔。玩具变身潮流平台上出现了对这一创意运动的各种诠释。其中,"AI 动图 "的概念在这一趋势中占据主导地位,在这一概念中,专业人士生成的塑化版自己包装得像收藏品一样--配有笔记本电脑、笔记本电脑和咖啡杯等职业配件,完全符合 LinkedI

ChatGPT 首席执行官考虑引入广告平台的可能性

OpenAI 探索收入来源,考虑在 ChatGPT 上投放广告OpenAI 正在评估各种货币化策略,在 ChatGPT 上投放广告是一个潜在的选择。在最近的一次Decoder采访中,ChatGPT 负责人尼克-特利(Nick Turley)采取了谨慎开放的态度,表示他 "很谦虚,不会断然排除这种可能性",同时强调需要深思熟虑后再实施。收入增长和业务战略这家人工智能公司预计今年的收入将

ChatGPT 首席执行官考虑引入广告平台的可能性

OpenAI 探索收入来源,考虑在 ChatGPT 上投放广告OpenAI 正在评估各种货币化策略,在 ChatGPT 上投放广告是一个潜在的选择。在最近的一次Decoder采访中,ChatGPT 负责人尼克-特利(Nick Turley)采取了谨慎开放的态度,表示他 "很谦虚,不会断然排除这种可能性",同时强调需要深思熟虑后再实施。收入增长和业务战略这家人工智能公司预计今年的收入将

在安全漏洞中利用 ChatGPT 窃取 Gmail 敏感数据

安全警报:研究人员展示人工智能驱动的数据外渗技术网络安全专家最近发现了一个令人担忧的漏洞,即 ChatGPT 的 "深度研究"(Deep Research)功能可被用来悄悄提取 Gmail 的机密数据。虽然 OpenAI 已经修补了这一特定漏洞,但这一事件凸显了自主人工智能系统带来的新安全挑战。影子泄漏漏洞利用机制Radware 的安全分析师开发了这一概念验证攻击,展示了人工智能固有的助人功能如何

在安全漏洞中利用 ChatGPT 窃取 Gmail 敏感数据

安全警报:研究人员展示人工智能驱动的数据外渗技术网络安全专家最近发现了一个令人担忧的漏洞,即 ChatGPT 的 "深度研究"(Deep Research)功能可被用来悄悄提取 Gmail 的机密数据。虽然 OpenAI 已经修补了这一特定漏洞,但这一事件凸显了自主人工智能系统带来的新安全挑战。影子泄漏漏洞利用机制Radware 的安全分析师开发了这一概念验证攻击,展示了人工智能固有的助人功能如何