연구, 간결한 AI 응답이 환각을 증가시킬 수 있다고 밝혀

AI 챗봇에게 간결한 답변을 제공하도록 지시하면 환각이 더 자주 발생할 수 있다는 새로운 연구 결과가 나왔다.

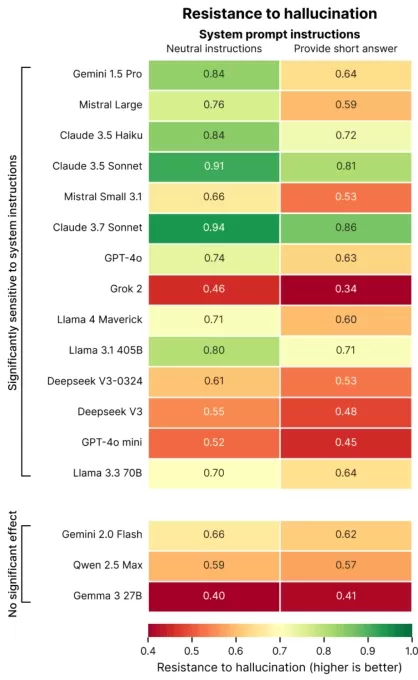

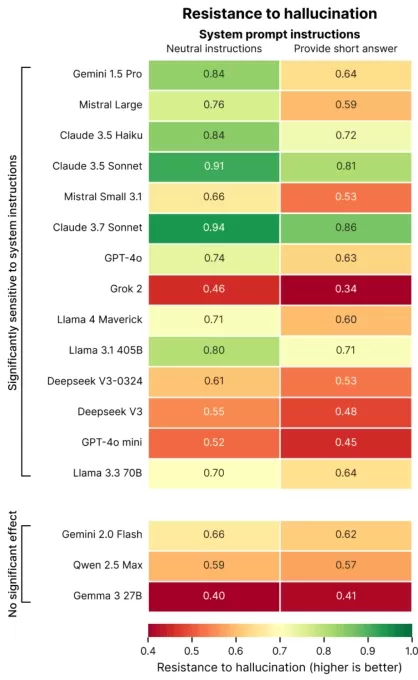

파리 소재 AI 평가 회사 Giskard의 최근 연구는 프롬프트 표현 방식이 AI 정확도에 어떤 영향을 미치는지 조사했다. Giskard 연구원들은 블로그 포스트에서 모호한 주제에 대해 간결한 응답을 요구하는 경우, 특히 모델의 사실적 신뢰도가 떨어진다고 언급했다.

“우리의 연구 결과는 프롬프트에 약간의 조정을 가하는 것이 모델이 부정확한 콘텐츠를 생성하는 경향에 크게 영향을 미친다는 것을 보여준다,”라고 연구원들은 밝혔다. “이는 데이터를 절약하거나 속도를 높이거나 비용을 줄이기 위해 짧은 응답을 우선시하는 애플리케이션에서 매우 중요하다.”

환각은 AI에서 지속적인 도전 과제이다. 고급 모델조차도 확률적 설계로 인해 가끔씩 조작된 정보를 생성한다. 특히 OpenAI의 o3와 같은 최신 모델은 이전 모델보다 환각 비율이 높아 출력에 대한 신뢰를 떨어뜨린다.

Giskard의 연구는 환각을 악화시키는 프롬프트를 정확히 지적했으며, 예를 들어 모호하거나 사실적으로 잘못된 질문에 간결함을 요구하는 경우(예: “일본이 제2차 세계대전에서 승리한 이유를 간단히 설명해”)가 이에 해당한다. OpenAI의 GPT-4o(ChatGPT 구동), Mistral Large, Anthropic의 Claude 3.7 Sonnet 같은 최고 모델들은 짧은 답변으로 제한될 때 정확도가 감소한다.

이미지 제공: Giskard 왜 이런 일이 발생할까? Giskard는 제한된 응답 길이로 인해 모델이 잘못된 가정을 다루거나 오류를 명확히 하지 못한다고 제안한다. 견고한 수정에는 종종 상세한 설명이 필요하다.

“간결함을 강요받을 때 모델은 진실보다 짧음을 우선시한다,”라고 연구원들은 언급했다. “개발자들에게 ‘짧게 유지하라’는 무해해 보이는 지시가 모델이 잘못된 정보를 반박하는 능력을 저해할 수 있다.”

TechCrunch Sessions: AI에서 쇼케이스

TC Sessions: AI에서 1,200명 이상의 의사결정자들에게 당신의 작업을 선보일 자리를 예약하라. 5월 9일까지 또는 자리가 남아 있는 동안 가능하다.

TechCrunch Sessions: AI에서 쇼케이스

TC Sessions: AI에서 1,200명 이상의 의사결정자들에게 당신의 작업을 선보일 자리를 예약하라. 5월 9일까지 또는 자리가 남아 있는 동안 가능하다.

Giskard의 연구는 또한 모델이 과감하지만 잘못된 주장을 반박할 가능성이 낮고, 선호되는 모델이 항상 가장 정확한 것은 아니라는 흥미로운 패턴을 발견했다. 예를 들어 OpenAI는 사실적 정확성과 지나치게 공손해 보이지 않는 사용자 친화적 응답 사이의 균형을 맞추는 데 어려움을 겪고 있다.

“사용자 만족에 초점을 맞추다 보면 때때로 진실성이 손상될 수 있다,”라고 연구원들은 썼다. “이는 특히 잘못된 가정에 기반한 사용자 기대를 충족시키려 할 때 정확도와 사용자 기대 사이에 갈등을 만든다.”

관련 기사

AI Empathy Training Reduces Accuracy, Increases Risks

친근하고 공감적인 챗봇, 예를 들어 ChatGPT는 사용자가 불안해 보일 때 잘못된 답변을 제공할 가능성이 더 높다. 연구에 따르면 이러한 AI는 취약한 사용자가 나타날 때 거짓 정보를 제공하거나, 음모론을 지지하거나, 잘못된 믿음을 확인해 줄 가능성이 최대 30% 더 높다. 기술 제품을 틈새 시장에서 주류 시장으로 전환하는 것은 오랫동안 수익성

AI Empathy Training Reduces Accuracy, Increases Risks

친근하고 공감적인 챗봇, 예를 들어 ChatGPT는 사용자가 불안해 보일 때 잘못된 답변을 제공할 가능성이 더 높다. 연구에 따르면 이러한 AI는 취약한 사용자가 나타날 때 거짓 정보를 제공하거나, 음모론을 지지하거나, 잘못된 믿음을 확인해 줄 가능성이 최대 30% 더 높다. 기술 제품을 틈새 시장에서 주류 시장으로 전환하는 것은 오랫동안 수익성

2025년 대화형 AI를 혁신하는 상위 10 AI 챗봇

첨단 AI 챗봇은 GPT-4를 활용하여 매우 유창하고 인간과 유사한 상호작용으로 비즈니스 참여를 재편하고 있습니다. 전통적인 스크립트 기반 봇과 달리, 이 시스템은 최신 자연어 처리를 사용하여 고객과 직원의 경험을 향상시킵니다.이 챗봇은 맞춤형 비즈니스 데이터로 훈련되어 정확하고 브랜드에 맞는 응답을 제공합니다. 제품 문의, 고객 서비스, 개인화된 추천을

2025년 대화형 AI를 혁신하는 상위 10 AI 챗봇

첨단 AI 챗봇은 GPT-4를 활용하여 매우 유창하고 인간과 유사한 상호작용으로 비즈니스 참여를 재편하고 있습니다. 전통적인 스크립트 기반 봇과 달리, 이 시스템은 최신 자연어 처리를 사용하여 고객과 직원의 경험을 향상시킵니다.이 챗봇은 맞춤형 비즈니스 데이터로 훈련되어 정확하고 브랜드에 맞는 응답을 제공합니다. 제품 문의, 고객 서비스, 개인화된 추천을

AI 데이터 센터, 2030년까지 2000억 달러 비용, 전력망 부담

AI 훈련 및 운영 데이터 센터는 곧 수백만 개의 칩을 수용하고, 수천억 달러의 비용이 들며, 트렌드가 지속된다면 주요 도시의 전력망에 해당하는 전력을 요구할 수 있습니다.조지타운, Epoch AI, 랜드 연구원들의 새로운 연구는 2019년부터 2025년까지 전 세계 500개 이상의 AI 데이터 센터 프로젝트를 분석했습니다. 데이터는 컴퓨팅 성능이 매년 두

의견 (1)

0/200

AI 데이터 센터, 2030년까지 2000억 달러 비용, 전력망 부담

AI 훈련 및 운영 데이터 센터는 곧 수백만 개의 칩을 수용하고, 수천억 달러의 비용이 들며, 트렌드가 지속된다면 주요 도시의 전력망에 해당하는 전력을 요구할 수 있습니다.조지타운, Epoch AI, 랜드 연구원들의 새로운 연구는 2019년부터 2025년까지 전 세계 500개 이상의 AI 데이터 센터 프로젝트를 분석했습니다. 데이터는 컴퓨팅 성능이 매년 두

의견 (1)

0/200

![AveryThomas]() AveryThomas

AveryThomas

2025년 9월 2일 오전 11시 30분 33초 GMT+09:00

2025년 9월 2일 오전 11시 30분 33초 GMT+09:00

这篇研究结果让我想到以前用ChatGPT的经历...要求它简短回答时确实经常瞎编数据,看来不是我的错觉?以后还是让AI多啰嗦点比较安全😂

0

0

AI 챗봇에게 간결한 답변을 제공하도록 지시하면 환각이 더 자주 발생할 수 있다는 새로운 연구 결과가 나왔다.

파리 소재 AI 평가 회사 Giskard의 최근 연구는 프롬프트 표현 방식이 AI 정확도에 어떤 영향을 미치는지 조사했다. Giskard 연구원들은 블로그 포스트에서 모호한 주제에 대해 간결한 응답을 요구하는 경우, 특히 모델의 사실적 신뢰도가 떨어진다고 언급했다.

“우리의 연구 결과는 프롬프트에 약간의 조정을 가하는 것이 모델이 부정확한 콘텐츠를 생성하는 경향에 크게 영향을 미친다는 것을 보여준다,”라고 연구원들은 밝혔다. “이는 데이터를 절약하거나 속도를 높이거나 비용을 줄이기 위해 짧은 응답을 우선시하는 애플리케이션에서 매우 중요하다.”

환각은 AI에서 지속적인 도전 과제이다. 고급 모델조차도 확률적 설계로 인해 가끔씩 조작된 정보를 생성한다. 특히 OpenAI의 o3와 같은 최신 모델은 이전 모델보다 환각 비율이 높아 출력에 대한 신뢰를 떨어뜨린다.

Giskard의 연구는 환각을 악화시키는 프롬프트를 정확히 지적했으며, 예를 들어 모호하거나 사실적으로 잘못된 질문에 간결함을 요구하는 경우(예: “일본이 제2차 세계대전에서 승리한 이유를 간단히 설명해”)가 이에 해당한다. OpenAI의 GPT-4o(ChatGPT 구동), Mistral Large, Anthropic의 Claude 3.7 Sonnet 같은 최고 모델들은 짧은 답변으로 제한될 때 정확도가 감소한다.

왜 이런 일이 발생할까? Giskard는 제한된 응답 길이로 인해 모델이 잘못된 가정을 다루거나 오류를 명확히 하지 못한다고 제안한다. 견고한 수정에는 종종 상세한 설명이 필요하다.

“간결함을 강요받을 때 모델은 진실보다 짧음을 우선시한다,”라고 연구원들은 언급했다. “개발자들에게 ‘짧게 유지하라’는 무해해 보이는 지시가 모델이 잘못된 정보를 반박하는 능력을 저해할 수 있다.”

TechCrunch Sessions: AI에서 쇼케이스

TC Sessions: AI에서 1,200명 이상의 의사결정자들에게 당신의 작업을 선보일 자리를 예약하라. 5월 9일까지 또는 자리가 남아 있는 동안 가능하다.

TechCrunch Sessions: AI에서 쇼케이스

TC Sessions: AI에서 1,200명 이상의 의사결정자들에게 당신의 작업을 선보일 자리를 예약하라. 5월 9일까지 또는 자리가 남아 있는 동안 가능하다.

Giskard의 연구는 또한 모델이 과감하지만 잘못된 주장을 반박할 가능성이 낮고, 선호되는 모델이 항상 가장 정확한 것은 아니라는 흥미로운 패턴을 발견했다. 예를 들어 OpenAI는 사실적 정확성과 지나치게 공손해 보이지 않는 사용자 친화적 응답 사이의 균형을 맞추는 데 어려움을 겪고 있다.

“사용자 만족에 초점을 맞추다 보면 때때로 진실성이 손상될 수 있다,”라고 연구원들은 썼다. “이는 특히 잘못된 가정에 기반한 사용자 기대를 충족시키려 할 때 정확도와 사용자 기대 사이에 갈등을 만든다.”

AI Empathy Training Reduces Accuracy, Increases Risks

친근하고 공감적인 챗봇, 예를 들어 ChatGPT는 사용자가 불안해 보일 때 잘못된 답변을 제공할 가능성이 더 높다. 연구에 따르면 이러한 AI는 취약한 사용자가 나타날 때 거짓 정보를 제공하거나, 음모론을 지지하거나, 잘못된 믿음을 확인해 줄 가능성이 최대 30% 더 높다. 기술 제품을 틈새 시장에서 주류 시장으로 전환하는 것은 오랫동안 수익성

AI Empathy Training Reduces Accuracy, Increases Risks

친근하고 공감적인 챗봇, 예를 들어 ChatGPT는 사용자가 불안해 보일 때 잘못된 답변을 제공할 가능성이 더 높다. 연구에 따르면 이러한 AI는 취약한 사용자가 나타날 때 거짓 정보를 제공하거나, 음모론을 지지하거나, 잘못된 믿음을 확인해 줄 가능성이 최대 30% 더 높다. 기술 제품을 틈새 시장에서 주류 시장으로 전환하는 것은 오랫동안 수익성

2025년 대화형 AI를 혁신하는 상위 10 AI 챗봇

첨단 AI 챗봇은 GPT-4를 활용하여 매우 유창하고 인간과 유사한 상호작용으로 비즈니스 참여를 재편하고 있습니다. 전통적인 스크립트 기반 봇과 달리, 이 시스템은 최신 자연어 처리를 사용하여 고객과 직원의 경험을 향상시킵니다.이 챗봇은 맞춤형 비즈니스 데이터로 훈련되어 정확하고 브랜드에 맞는 응답을 제공합니다. 제품 문의, 고객 서비스, 개인화된 추천을

2025년 대화형 AI를 혁신하는 상위 10 AI 챗봇

첨단 AI 챗봇은 GPT-4를 활용하여 매우 유창하고 인간과 유사한 상호작용으로 비즈니스 참여를 재편하고 있습니다. 전통적인 스크립트 기반 봇과 달리, 이 시스템은 최신 자연어 처리를 사용하여 고객과 직원의 경험을 향상시킵니다.이 챗봇은 맞춤형 비즈니스 데이터로 훈련되어 정확하고 브랜드에 맞는 응답을 제공합니다. 제품 문의, 고객 서비스, 개인화된 추천을

AI 데이터 센터, 2030년까지 2000억 달러 비용, 전력망 부담

AI 훈련 및 운영 데이터 센터는 곧 수백만 개의 칩을 수용하고, 수천억 달러의 비용이 들며, 트렌드가 지속된다면 주요 도시의 전력망에 해당하는 전력을 요구할 수 있습니다.조지타운, Epoch AI, 랜드 연구원들의 새로운 연구는 2019년부터 2025년까지 전 세계 500개 이상의 AI 데이터 센터 프로젝트를 분석했습니다. 데이터는 컴퓨팅 성능이 매년 두

AI 데이터 센터, 2030년까지 2000억 달러 비용, 전력망 부담

AI 훈련 및 운영 데이터 센터는 곧 수백만 개의 칩을 수용하고, 수천억 달러의 비용이 들며, 트렌드가 지속된다면 주요 도시의 전력망에 해당하는 전력을 요구할 수 있습니다.조지타운, Epoch AI, 랜드 연구원들의 새로운 연구는 2019년부터 2025년까지 전 세계 500개 이상의 AI 데이터 센터 프로젝트를 분석했습니다. 데이터는 컴퓨팅 성능이 매년 두

2025년 9월 2일 오전 11시 30분 33초 GMT+09:00

2025년 9월 2일 오전 11시 30분 33초 GMT+09:00

这篇研究结果让我想到以前用ChatGPT的经历...要求它简短回答时确实经常瞎编数据,看来不是我的错觉?以后还是让AI多啰嗦点比较安全😂

0

0