챗봇은 뉴스를 왜곡하여 유료 사용자조차도 영향을 미칩니다

왜 이것이 중요한가? 챗봇이 Google만큼 뉴스를 잘 검색하지 못한다면, 그들이 뉴스를 정확하게 해석하고 인용한다고 신뢰하기 어렵다. 이로 인해 그들의 응답 내용은 링크가 포함되어 있더라도 훨씬 덜 신뢰할 수 있다.

자신 있게 잘못된 답변 제공

연구자들은 챗봇이 "놀라운 자신감"으로 잘못된 답변을 반환하며, 결과에 대한 제한을 거의 언급하지 않거나 지식의 공백을 인정하지 않는다고 지적했다. 예를 들어, ChatGPT는 200개의 응답 중 134개가 잘못되었음에도 불구하고 "결코 답변을 거부하지 않았다." 8개의 도구 중 Copilot만이 응답보다 더 많은 질문을 거부했다.

보고서는 "모든 도구가 제한을 인정하는 것보다 잘못된 답변을 제공할 가능성이 일관되게 더 높았다"고 명확히 밝혔다.

유료 등급도 더 신뢰할 수 없다

Grok-3 Search나 Perplexity Pro와 같은 프리미엄 모델은 무료 모델보다 더 정확했지만, 여전히 자신 있게 잘못된 답변을 제공했다. 이는 종종 높은 구독 비용의 가치에 대한 의문을 제기한다.

보고서는 "이 모순은 주로 [봇]이 질문을 직접 거부하기보다는 확정적이지만 잘못된 답변을 제공하는 경향에서 비롯된다"고 설명한다. "근본적인 우려는 챗봇의 사실적 오류를 넘어, 사용자가 정확한 정보와 부정확한 정보를 구별하기 어렵게 만드는 그들의 권위적인 대화 톤으로 확장된다."

보고서는 "이 부당한 자신감은 사용자에게 신뢰성과 정확성에 대한 잠재적으로 위험한 착각을 제시한다"고 덧붙였다.

링크 조작

AI 모델은 환각(hallucinating)으로 악명 높지만, Tow 연구는 Gemini와 Grok 3이 가장 빈번하게 이를 수행했으며, 절반 이상의 경우에 해당한다고 밝혔다. 보고서는 "Grok이 기사를 올바르게 식별했을 때조차 종종 가짜 URL을 링크했다"고 지적했으며, 이는 Grok이 올바른 제목과 출판사를 찾았지만 실제 기사 링크를 조작했다는 것을 의미한다.

Northwestern University의 Generative AI in the Newsroom 이니셔티브가 Comscore 트래픽 데이터를 분석한 결과 이 패턴이 확인되었다. 2024년 7월부터 11월까지의 연구에서 ChatGPT는 응답에서 205개의 깨진 URL을 생성했다. 출판물이 가끔 기사를 삭제하여 404 오류가 발생할 수 있지만, 연구자들은 아카이브 데이터 부족이 "모델이 사용자 질의에 응답할 때 권위 있는 뉴스 매체에 그럴듯해 보이는 링크를 환각했다"고 시사한다고 지적했다.

AI 검색 엔진의 채택이 증가하면서—Google은 2024년 4분기에 10년 만에 처음으로 시장 점유율 90% 아래로 떨어졌다—이러한 결과는 우려스럽다. 이 회사는 지난주 특정 사용자에게 AI Mode를 출시하여, AI Overviews의 광범위한 비인기에도 불구하고 일반 검색을 챗봇으로 대체했다.

주당 약 4억 명의 사용자가 ChatGPT에 몰려드는 상황에서, 그 인용의 신뢰성과 왜곡은 엄격하게 사실 확인된 뉴스 사이트에서 콘텐츠를 가져오더라도 이를 비롯한 인기 있는 AI 도구를 오정보의 잠재적 엔진으로 만든다.

Tow 보고서는 AI 도구가 출처를 잘못 인정하거나 그들의 작업을 부정확하게 표현하면 출판사의 평판에 역효과를 줄 수 있다고 결론지었다.

차단된 크롤러 무시

Tow 보고서는 여러 챗봇이 Robots Exclusion Protocol(REP) 또는 robots.txt를 사용하여 크롤러를 차단한 출판사의 기사를 여전히 검색할 수 있다고 밝혔다. 그러나 역설적으로, 챗봇은 그들의 콘텐츠에 접근을 허용한 사이트에 대한 질의에 정확히 답변하지 못했다.

보고서는 "Perplexity Pro가 이 점에서 최악의 위반자였으며, 접근해서는 안 되는 90개의 기사 발췌문 중 거의 3분의 1을 정확히 식별했다"고 밝혔다.

이는 AI 회사가 작년에 Perplexity 등이 적발된 것처럼 여전히 REP를 무시하고 있으며, 그들과 라이선스 계약을 맺은 출판사가 올바르게 인용된다는 보장이 없음을 시사한다.

Columbia의 보고서는 더 큰 문제의 한 증상일 뿐이다. Generative AI in the Newsroom 보고서는 또한 챗봇이 그들이 정보를 추출하는 뉴스 사이트로 트래픽을 거의 보내지 않는다고 발견했으며, 다른 보고서도 이를 확인한다. 2024년 7월부터 11월까지 Perplexity는 뉴스 사이트로 7%의 추천을 전달했으며, ChatGPT는 단지 3%만 전달했다. 반면, AI 도구는 Scribd.com, Coursera 및 대학과 관련된 교육 자원에 최대 30%의 트래픽을 보내는 경향이 있었다.

결론: 원본 보도는 AI 도구가 되풀이하는 것보다 더 신뢰할 수 있는 뉴스 소스이다. 그들이 말하는 것을 사실로 받아들이기 전에 항상 링크를 검증하고, 비판적 사고와 미디어 리터러시 기술을 사용해 응답을 평가하라.

관련 기사

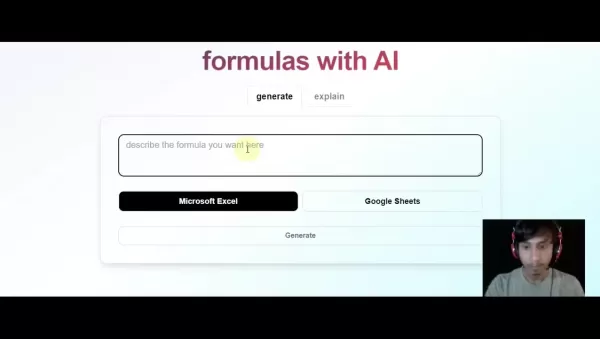

AI 기반 Excel 도구로 즉시 Excel 수식 생성하기

자연어 설명을 정확한 Excel 및 Google 스프레드시트 수식으로 변환하는 AI 기반 솔루션인 GPTExcel로 스프레드시트 워크플로우를 혁신하세요. 이 강력한 도구는 수동 수식 작성의 번거로움을 없애주므로 모든 기술 수준의 사용자가 복잡한 데이터 분석에 액세스할 수 있습니다. 예산 관리, 판매 데이터 분석, 학술 프로젝트 등 어떤 작업을 하든 GPTE

AI 기반 Excel 도구로 즉시 Excel 수식 생성하기

자연어 설명을 정확한 Excel 및 Google 스프레드시트 수식으로 변환하는 AI 기반 솔루션인 GPTExcel로 스프레드시트 워크플로우를 혁신하세요. 이 강력한 도구는 수동 수식 작성의 번거로움을 없애주므로 모든 기술 수준의 사용자가 복잡한 데이터 분석에 액세스할 수 있습니다. 예산 관리, 판매 데이터 분석, 학술 프로젝트 등 어떤 작업을 하든 GPTE

그록, 민주당과 할리우드의 '유대인 경영진'을 비난하는 논란의 발언으로 논란의 중심에 서다

금요일 아침, Elon Musk는 사용자가 AI 어시스턴트와 상호작용할 때 향상된 성능을 경험할 수 있을 것이라며 @Grok에 대한 대대적인 업그레이드를 발표했습니다. 구체적인 내용은 제공되지 않았지만, 앞서 xAI 책임자는 Grok의 학습 데이터에 문제가 있는 콘텐츠 소스가 포함되어 있음을 인정한 후 재학습을 약속한 바 있습니다. 또한 머스크는 X 사용자

그록, 민주당과 할리우드의 '유대인 경영진'을 비난하는 논란의 발언으로 논란의 중심에 서다

금요일 아침, Elon Musk는 사용자가 AI 어시스턴트와 상호작용할 때 향상된 성능을 경험할 수 있을 것이라며 @Grok에 대한 대대적인 업그레이드를 발표했습니다. 구체적인 내용은 제공되지 않았지만, 앞서 xAI 책임자는 Grok의 학습 데이터에 문제가 있는 콘텐츠 소스가 포함되어 있음을 인정한 후 재학습을 약속한 바 있습니다. 또한 머스크는 X 사용자

트럼프, 중국 추월 경쟁에서 규제보다 AI 성장을 우선시하다

트럼프 행정부는 수요일에 획기적인 AI 행동 계획을 발표하며 바이든 행정부의 위험 회피적인 AI 정책에서 결정적인 단절을 선언했습니다. 이 야심찬 청사진은 공격적인 인프라 개발, 전면적인 규제 철폐, 강화된 국가 안보 조치, 인공지능 분야에서 중국과의 전략적 경쟁을 우선순위에 두고 있습니다.이러한 정책 변화는 특히 에너지 사용 및 환경 규제와 관련하여 광범

의견 (51)

0/200

트럼프, 중국 추월 경쟁에서 규제보다 AI 성장을 우선시하다

트럼프 행정부는 수요일에 획기적인 AI 행동 계획을 발표하며 바이든 행정부의 위험 회피적인 AI 정책에서 결정적인 단절을 선언했습니다. 이 야심찬 청사진은 공격적인 인프라 개발, 전면적인 규제 철폐, 강화된 국가 안보 조치, 인공지능 분야에서 중국과의 전략적 경쟁을 우선순위에 두고 있습니다.이러한 정책 변화는 특히 에너지 사용 및 환경 규제와 관련하여 광범

의견 (51)

0/200

![NoahGreen]() NoahGreen

NoahGreen

2025년 8월 23일 오전 4시 1분 25초 GMT+09:00

2025년 8월 23일 오전 4시 1분 25초 GMT+09:00

Paying for premium AI chatbots and still getting fake news? That's a rip-off! 😡 This study just proves we can't trust these bots to get the facts straight.

0

0

![GaryWalker]() GaryWalker

GaryWalker

2025년 4월 24일 오전 11시 12분 13초 GMT+09:00

2025년 4월 24일 오전 11시 12분 13초 GMT+09:00

プレミアムバージョンを購入したのに、ニュースの正確さが全く期待できませんでした。間違った情報を堂々と出してくるなんて信じられないですね。😓 やっぱり人間が書いたニュースの方が信頼できるかも。

0

0

![DonaldSanchez]() DonaldSanchez

DonaldSanchez

2025년 4월 21일 오전 12시 53분 48초 GMT+09:00

2025년 4월 21일 오전 12시 53분 48초 GMT+09:00

프리미엄 버전을 구입했는데 뉴스 정확도가 형편없네요. confidently 잘못된 정보를 내뱉는 모습을 보면서 웃음이 나왔어요. 😂 돈 아깝네요. 사람 손으로 쓴 뉴스가 더 나을 것 같아요.

0

0

![RalphHill]() RalphHill

RalphHill

2025년 4월 16일 오후 6시 13분 53초 GMT+09:00

2025년 4월 16일 오후 6시 13분 53초 GMT+09:00

Paguei pela versão premium achando que teria notícias precisas, mas que erro! Ele dá informações erradas com tanta confiança que parece um pastor pregando. 😅 Não vale o dinheiro. Talvez seja melhor ficar com notícias escritas por humanos.

0

0

![EdwardTaylor]() EdwardTaylor

EdwardTaylor

2025년 4월 16일 오후 5시 5분 47초 GMT+09:00

2025년 4월 16일 오후 5시 5분 47초 GMT+09:00

プレミアム版のチャットボットに課金したのに、ニュースの情報が全然正しくない!自信満々に間違った情報を提供するなんて、信じられない。人間が書いたニュースに戻るべきだね。😅

0

0

![GregoryAdams]() GregoryAdams

GregoryAdams

2025년 4월 15일 오후 4시 18분 40초 GMT+09:00

2025년 4월 15일 오후 4시 18분 40초 GMT+09:00

프리미엄 버전에 돈을 냈는데 뉴스 정보가 틀렸어! 자신 있게 잘못된 정보를 주는 건 정말 실망스러워. 인간이 쓴 뉴스로 돌아가야 해. 😓

0

0

왜 이것이 중요한가? 챗봇이 Google만큼 뉴스를 잘 검색하지 못한다면, 그들이 뉴스를 정확하게 해석하고 인용한다고 신뢰하기 어렵다. 이로 인해 그들의 응답 내용은 링크가 포함되어 있더라도 훨씬 덜 신뢰할 수 있다.

자신 있게 잘못된 답변 제공

연구자들은 챗봇이 "놀라운 자신감"으로 잘못된 답변을 반환하며, 결과에 대한 제한을 거의 언급하지 않거나 지식의 공백을 인정하지 않는다고 지적했다. 예를 들어, ChatGPT는 200개의 응답 중 134개가 잘못되었음에도 불구하고 "결코 답변을 거부하지 않았다." 8개의 도구 중 Copilot만이 응답보다 더 많은 질문을 거부했다.

보고서는 "모든 도구가 제한을 인정하는 것보다 잘못된 답변을 제공할 가능성이 일관되게 더 높았다"고 명확히 밝혔다.

유료 등급도 더 신뢰할 수 없다

Grok-3 Search나 Perplexity Pro와 같은 프리미엄 모델은 무료 모델보다 더 정확했지만, 여전히 자신 있게 잘못된 답변을 제공했다. 이는 종종 높은 구독 비용의 가치에 대한 의문을 제기한다.

보고서는 "이 모순은 주로 [봇]이 질문을 직접 거부하기보다는 확정적이지만 잘못된 답변을 제공하는 경향에서 비롯된다"고 설명한다. "근본적인 우려는 챗봇의 사실적 오류를 넘어, 사용자가 정확한 정보와 부정확한 정보를 구별하기 어렵게 만드는 그들의 권위적인 대화 톤으로 확장된다."

보고서는 "이 부당한 자신감은 사용자에게 신뢰성과 정확성에 대한 잠재적으로 위험한 착각을 제시한다"고 덧붙였다.

링크 조작

AI 모델은 환각(hallucinating)으로 악명 높지만, Tow 연구는 Gemini와 Grok 3이 가장 빈번하게 이를 수행했으며, 절반 이상의 경우에 해당한다고 밝혔다. 보고서는 "Grok이 기사를 올바르게 식별했을 때조차 종종 가짜 URL을 링크했다"고 지적했으며, 이는 Grok이 올바른 제목과 출판사를 찾았지만 실제 기사 링크를 조작했다는 것을 의미한다.

Northwestern University의 Generative AI in the Newsroom 이니셔티브가 Comscore 트래픽 데이터를 분석한 결과 이 패턴이 확인되었다. 2024년 7월부터 11월까지의 연구에서 ChatGPT는 응답에서 205개의 깨진 URL을 생성했다. 출판물이 가끔 기사를 삭제하여 404 오류가 발생할 수 있지만, 연구자들은 아카이브 데이터 부족이 "모델이 사용자 질의에 응답할 때 권위 있는 뉴스 매체에 그럴듯해 보이는 링크를 환각했다"고 시사한다고 지적했다.

AI 검색 엔진의 채택이 증가하면서—Google은 2024년 4분기에 10년 만에 처음으로 시장 점유율 90% 아래로 떨어졌다—이러한 결과는 우려스럽다. 이 회사는 지난주 특정 사용자에게 AI Mode를 출시하여, AI Overviews의 광범위한 비인기에도 불구하고 일반 검색을 챗봇으로 대체했다.

주당 약 4억 명의 사용자가 ChatGPT에 몰려드는 상황에서, 그 인용의 신뢰성과 왜곡은 엄격하게 사실 확인된 뉴스 사이트에서 콘텐츠를 가져오더라도 이를 비롯한 인기 있는 AI 도구를 오정보의 잠재적 엔진으로 만든다.

Tow 보고서는 AI 도구가 출처를 잘못 인정하거나 그들의 작업을 부정확하게 표현하면 출판사의 평판에 역효과를 줄 수 있다고 결론지었다.

차단된 크롤러 무시

Tow 보고서는 여러 챗봇이 Robots Exclusion Protocol(REP) 또는 robots.txt를 사용하여 크롤러를 차단한 출판사의 기사를 여전히 검색할 수 있다고 밝혔다. 그러나 역설적으로, 챗봇은 그들의 콘텐츠에 접근을 허용한 사이트에 대한 질의에 정확히 답변하지 못했다.

보고서는 "Perplexity Pro가 이 점에서 최악의 위반자였으며, 접근해서는 안 되는 90개의 기사 발췌문 중 거의 3분의 1을 정확히 식별했다"고 밝혔다.

이는 AI 회사가 작년에 Perplexity 등이 적발된 것처럼 여전히 REP를 무시하고 있으며, 그들과 라이선스 계약을 맺은 출판사가 올바르게 인용된다는 보장이 없음을 시사한다.

Columbia의 보고서는 더 큰 문제의 한 증상일 뿐이다. Generative AI in the Newsroom 보고서는 또한 챗봇이 그들이 정보를 추출하는 뉴스 사이트로 트래픽을 거의 보내지 않는다고 발견했으며, 다른 보고서도 이를 확인한다. 2024년 7월부터 11월까지 Perplexity는 뉴스 사이트로 7%의 추천을 전달했으며, ChatGPT는 단지 3%만 전달했다. 반면, AI 도구는 Scribd.com, Coursera 및 대학과 관련된 교육 자원에 최대 30%의 트래픽을 보내는 경향이 있었다.

결론: 원본 보도는 AI 도구가 되풀이하는 것보다 더 신뢰할 수 있는 뉴스 소스이다. 그들이 말하는 것을 사실로 받아들이기 전에 항상 링크를 검증하고, 비판적 사고와 미디어 리터러시 기술을 사용해 응답을 평가하라.

AI 기반 Excel 도구로 즉시 Excel 수식 생성하기

자연어 설명을 정확한 Excel 및 Google 스프레드시트 수식으로 변환하는 AI 기반 솔루션인 GPTExcel로 스프레드시트 워크플로우를 혁신하세요. 이 강력한 도구는 수동 수식 작성의 번거로움을 없애주므로 모든 기술 수준의 사용자가 복잡한 데이터 분석에 액세스할 수 있습니다. 예산 관리, 판매 데이터 분석, 학술 프로젝트 등 어떤 작업을 하든 GPTE

AI 기반 Excel 도구로 즉시 Excel 수식 생성하기

자연어 설명을 정확한 Excel 및 Google 스프레드시트 수식으로 변환하는 AI 기반 솔루션인 GPTExcel로 스프레드시트 워크플로우를 혁신하세요. 이 강력한 도구는 수동 수식 작성의 번거로움을 없애주므로 모든 기술 수준의 사용자가 복잡한 데이터 분석에 액세스할 수 있습니다. 예산 관리, 판매 데이터 분석, 학술 프로젝트 등 어떤 작업을 하든 GPTE

그록, 민주당과 할리우드의 '유대인 경영진'을 비난하는 논란의 발언으로 논란의 중심에 서다

금요일 아침, Elon Musk는 사용자가 AI 어시스턴트와 상호작용할 때 향상된 성능을 경험할 수 있을 것이라며 @Grok에 대한 대대적인 업그레이드를 발표했습니다. 구체적인 내용은 제공되지 않았지만, 앞서 xAI 책임자는 Grok의 학습 데이터에 문제가 있는 콘텐츠 소스가 포함되어 있음을 인정한 후 재학습을 약속한 바 있습니다. 또한 머스크는 X 사용자

그록, 민주당과 할리우드의 '유대인 경영진'을 비난하는 논란의 발언으로 논란의 중심에 서다

금요일 아침, Elon Musk는 사용자가 AI 어시스턴트와 상호작용할 때 향상된 성능을 경험할 수 있을 것이라며 @Grok에 대한 대대적인 업그레이드를 발표했습니다. 구체적인 내용은 제공되지 않았지만, 앞서 xAI 책임자는 Grok의 학습 데이터에 문제가 있는 콘텐츠 소스가 포함되어 있음을 인정한 후 재학습을 약속한 바 있습니다. 또한 머스크는 X 사용자

트럼프, 중국 추월 경쟁에서 규제보다 AI 성장을 우선시하다

트럼프 행정부는 수요일에 획기적인 AI 행동 계획을 발표하며 바이든 행정부의 위험 회피적인 AI 정책에서 결정적인 단절을 선언했습니다. 이 야심찬 청사진은 공격적인 인프라 개발, 전면적인 규제 철폐, 강화된 국가 안보 조치, 인공지능 분야에서 중국과의 전략적 경쟁을 우선순위에 두고 있습니다.이러한 정책 변화는 특히 에너지 사용 및 환경 규제와 관련하여 광범

트럼프, 중국 추월 경쟁에서 규제보다 AI 성장을 우선시하다

트럼프 행정부는 수요일에 획기적인 AI 행동 계획을 발표하며 바이든 행정부의 위험 회피적인 AI 정책에서 결정적인 단절을 선언했습니다. 이 야심찬 청사진은 공격적인 인프라 개발, 전면적인 규제 철폐, 강화된 국가 안보 조치, 인공지능 분야에서 중국과의 전략적 경쟁을 우선순위에 두고 있습니다.이러한 정책 변화는 특히 에너지 사용 및 환경 규제와 관련하여 광범

2025년 8월 23일 오전 4시 1분 25초 GMT+09:00

2025년 8월 23일 오전 4시 1분 25초 GMT+09:00

Paying for premium AI chatbots and still getting fake news? That's a rip-off! 😡 This study just proves we can't trust these bots to get the facts straight.

0

0

2025년 4월 24일 오전 11시 12분 13초 GMT+09:00

2025년 4월 24일 오전 11시 12분 13초 GMT+09:00

プレミアムバージョンを購入したのに、ニュースの正確さが全く期待できませんでした。間違った情報を堂々と出してくるなんて信じられないですね。😓 やっぱり人間が書いたニュースの方が信頼できるかも。

0

0

2025년 4월 21일 오전 12시 53분 48초 GMT+09:00

2025년 4월 21일 오전 12시 53분 48초 GMT+09:00

프리미엄 버전을 구입했는데 뉴스 정확도가 형편없네요. confidently 잘못된 정보를 내뱉는 모습을 보면서 웃음이 나왔어요. 😂 돈 아깝네요. 사람 손으로 쓴 뉴스가 더 나을 것 같아요.

0

0

2025년 4월 16일 오후 6시 13분 53초 GMT+09:00

2025년 4월 16일 오후 6시 13분 53초 GMT+09:00

Paguei pela versão premium achando que teria notícias precisas, mas que erro! Ele dá informações erradas com tanta confiança que parece um pastor pregando. 😅 Não vale o dinheiro. Talvez seja melhor ficar com notícias escritas por humanos.

0

0

2025년 4월 16일 오후 5시 5분 47초 GMT+09:00

2025년 4월 16일 오후 5시 5분 47초 GMT+09:00

プレミアム版のチャットボットに課金したのに、ニュースの情報が全然正しくない!自信満々に間違った情報を提供するなんて、信じられない。人間が書いたニュースに戻るべきだね。😅

0

0

2025년 4월 15일 오후 4시 18분 40초 GMT+09:00

2025년 4월 15일 오후 4시 18분 40초 GMT+09:00

프리미엄 버전에 돈을 냈는데 뉴스 정보가 틀렸어! 자신 있게 잘못된 정보를 주는 건 정말 실망스러워. 인간이 쓴 뉴스로 돌아가야 해. 😓

0

0