AIの倫理的開発:責任あるイノベーションのための重要な考慮事項

人工知能(AI)が進化し、日常生活に統合されるにつれ、その開発と使用における倫理的考慮が最も重要です。この記事では、透明性、公平性、プライバシー、説明責任、安全性、そしてAIを社会の利益のために活用することなど、必須の側面を探ります。これらの側面を理解することは、信頼を築き、責任あるイノベーションを促進し、AIの可能性を最大限に引き出しながらリスクを最小限に抑える鍵です。AIの倫理的複雑さをナビゲートして、それが人類に責任を持って効果的に役立つようにしましょう。

主なポイント

透明性と説明可能性は、AIシステムへの信頼を築きます。

公平性とバイアスの軽減は、差別を防ぎ、公平性を促進するために不可欠です。

プライバシーとデータセキュリティの優先は、機密情報を保護します。

説明責任の枠組みは、AIに関連する害に対処するために必要です。

AIの安全性と堅牢性は、意図しない結果を防ぎ、信頼性を確保します。

社会の利益のためのAIの活用は、医療、教育、その他の課題に対処します。

労働市場への影響の軽減は、雇用の喪失と不平等を減らします。

人間の自律性の維持は、主体性と意思決定の制御を保持します。

倫理的AI研究は、利益とリスクの慎重な検討を必要とします。

効果的なAIガバナンスは、責任ある開発と展開を保証します。

AIの倫理的側面の探求

AIの透明性と説明可能性

AIシステムがより高度になるにつれ、その動作を理解することはますます難しくなります。透明性と説明可能性は、信頼と説明責任を育むために重要です。

AIの透明性は、システムがどのように機能するか、データ、アルゴリズム、意思決定プロセスについての明確さを伴います。説明可能性は、AIの意思決定が人間に理解可能であることを保証し、関係者が結果の背後にある理由を理解できるようにします。

説明可能AI(XAI)の役割:

説明可能AI(XAI)は、人間が解釈可能なモデルを開発し、関係者が意思決定の根拠を評価できるようにし、信頼と監督を強化します。主なXAI技術には以下が含まれます:

- ルールベースシステム:透明な意思決定のための明確なルールを使用。

- 意思決定ツリー:視覚的な意思決定経路を提供し、理解を容易に。

- 特徴の重要性:モデル予測を推進する主要なデータ要因を強調。

透明性と説明可能性の利点:

- 信頼の醸成:明確なシステムはユーザーの自信と採用を促進。

- 説明責任の強化:動作の理解はエラーやバイアスの特定と修正を支援。

- 監督の支援:透明性は関係者が倫理的整合性を確保できるように。

- 意思決定の改善:明確な根拠は情報に基づく選択のための洞察を提供。

AIの公平性とバイアス軽減

AIシステムは、トレーニングデータに存在するバイアスを永続化し、不公平な結果を招く可能性があります。公平性は、AIが人種、性別、宗教などの属性に基づく差別を回避することを保証し、バイアス軽減はシステム出力の不平等に対処します。

AIバイアスの原因:

- 歴史的バイアス:トレーニングデータに反映される社会的バイアス。

- サンプリングバイアス:代表性のないデータサンプルに由来。

- 測定バイアス:欠陥のある測定方法に起因。

- アルゴリズムバイアス:アルゴリズムの設計または実装に由来。

バイアス軽減戦略:

- データ前処理:バイアスを最小限に抑えるためにデータをクリーニング。

- アルゴリズム設計:公平性に焦点を当てたアルゴリズムを作成。

- モデル評価:バイアスと公平性を評価するための指標を使用。

- 後処理:差別的な影響を軽減するために出力を調整。

公平性の促進:

- 多様なデータセット:代表的なデータでAIをトレーニング。

- バイアス監査:システムのバイアス行動を定期的にチェック。

- 関係者の関与:開発に多様なグループを巻き込む。

- 透明性と説明責任:明確で責任ある意思決定を保証。

AIのプライバシーとデータセキュリティ

AIは、しばしば機密情報を含む膨大なデータセットに依存します。プライバシーの保護とデータのセキュリティ確保は、ユーザーの信頼にとって重要です。

AIのプライバシーは、個人データを不正アクセスや使用から保護し、データセキュリティは盗難、紛失、または破損を防ぎます。

プライバシーとセキュリティの核心原則:

- データ最小化:必要最小限のデータのみ収集。

- 目的制限:データは意図した目的にのみ使用。

- データセキュリティ:不正アクセスに対する強固な保護を適用。

- 透明性:データ使用についてユーザーに通知。

- ユーザー制御:個人が自分のデータを管理できるように。

プライバシーとセキュリティの技術:

- 匿名化:プライバシーを保護するために識別可能なデータを削除。

- 差分プライバシー:データを分析する際にノイズを追加して個人を保護。

- 連合学習:データを共有せずに分散データでモデルをトレーニング。

- 暗号化:不正アクセスからデータを保護。

プライバシーを通じた信頼の構築:

- プライバシー強化技術:高度なツールでユーザーデータを保護。

- データセキュリティ対策:強力な保護で侵害を防止。

- 規制遵守:GDPRやCCPAなどの法律を遵守。

- 明確なコミュニケーション:プライバシー慣行についてユーザーに通知。

AIの説明責任と責任

AIのエラーや害に対する責任の割り当ては、複数の関係者が関与するため複雑です。明確な枠組みが必要で、説明責任を確保します。

説明責任は、AIを開発・展開する者がその影響に対して責任を負うことを保証し、責任は倫理的監督に焦点を当てます。

説明責任の課題:

- システムの複雑性:複雑なAIシステムでのエラー追跡は困難。

- 複数の関係者:AIのライフサイクルに様々な当事者が関与。

- 法的枠組みの欠如:明確な責任ガイドラインがしばしば不在。

説明責任の促進:

- 明確なガイドライン:AIの開発と使用のための基準を設定。

- 法的枠組み:AIによる結果の責任を定義。

- 監査とモニタリング:エラーやバイアスを検出し対処。

- 説明可能AI:意思決定の根拠を明確にするためにXAIを使用。

倫理的慣行の奨励:

- 倫理トレーニング:開発者に倫理原則を教育。

- 倫理審査委員会:AIプロジェクトの倫理的影響を評価。

- 業界標準:責任あるAIのための規範を確立。

- 関係者の関与:評価に多様なグループを巻き込む。

AIの安全性と堅牢性

AIシステムは、害を避け、攻撃やエラーに対する信頼性を確保するために安全で堅牢でなければなりません。

安全性と堅牢性の主要な考慮事項:

- 意図しない結果:AIの行動による害を防止。

- 敵対的攻撃:悪意のある操作に対する保護。

- 予期しない入力:異常な入力を効果的に処理。

- システムの信頼性:一貫したパフォーマンスを保証。

安全性と堅牢性の強化:

- 形式検証:システムの安全性を数学的に確認。

- 敵対的トレーニング:攻撃に耐えるシステムをトレーニング。

- 異常検知:異常な入力を特定しフラグ立て。

- 冗長性:信頼性のためにフォールトトレラントなシステムを構築。

責任あるイノベーションの推進:

- 安全性研究:AIの安全性研究に投資。

- 安全基準:堅牢なAIのためのガイドラインを開発。

- テストと検証:システムの安全性を厳密にテスト。

- 継続的なモニタリング:問題に対処するためにシステムを追跡。

社会の利益のためのAI

AIは、医療、教育、持続可能性などの社会的課題に取り組み、ターゲットを絞ったソリューションで生活を改善できます。

医療:診断、治療、予防を強化。

教育:学習をパーソナライズし、アクセスを改善。

環境持続可能性:資源を最適化し、汚染を削減。

貧困削減:金融アクセスと雇用機会を拡大。

災害救援:準備と回復を改善。

社会の利益のための倫理的考慮:

- 公平性と包摂性:利益が疎外されたグループに届くことを保証。

- 透明性と説明責任:明確な意思決定プロセスを維持。

- プライバシーとセキュリティ:機密データを保護。

- 人間の自律性:個人の制御を維持。

社会の利益を促進する取り組み:

- 研究の資金提供:社会的影響のためのAIを支援。

- スタートアップの支援:社会的課題に取り組むベンチャーを支援。

- 官民パートナーシップ:影響力のあるソリューションで協力。

- 関係者の関与:開発に多様なグループを巻き込む。

労働と雇用の影響

AIの自動化の可能性は、雇用の喪失と不平等に関する懸念を引き起こし、積極的な労働力戦略が必要です。

AIの労働への影響:

- 雇用の喪失:一部のセクターで自動化が仕事を減らす可能性。

- 雇用の創出:AI関連分野で新たな役割が生まれる。

- スキルギャップ:専門スキルの需要が増加。

- 所得格差:スキルレベル間の格差が拡大。

労働への影響の軽減:

- リスキリングプログラム:新たな役割のための労働者のトレーニング。

- 雇用の創出:AI主導の産業に投資。

- 社会的セーフティネット:影響を受けた労働者を支援。

- 生涯学習:継続的なスキル開発を促進。

公平な移行の確保:

- 再訓練プログラム:労働者が新たな産業に移行するのを支援。

- 失業給付:自動化の影響を受けた人々を支援。

- 普遍的ベーシックインカム:すべての人に対するセーフティネットを検討。

- 労働者のエンパワーメント:AIの意思決定に労働者を巻き込む。

人間の自律性の維持

高度なAIは人間の制御を減らすリスクがあり、主体性と意思決定力を維持することが不可欠です。

人間の自律性は、個人が自分の選択と生活に対する制御を保持し、不当なAIの影響を防ぎます。

自律性へのリスク:

- AIの操作:システムが行動を微妙に左右する可能性。

- 過度な依存:AIへの依存が批判的思考を弱める可能性。

- 制御の喪失:制御されないAIによる意図しない結果。

自律性の維持:

- 透明性:明確で理解可能なAIプロセスを保証。

- 人間の関与:AIシステムでの人間の監督を要求。

- ユーザー制御:AI主導の意思決定からのオプトアウトを許可。

- 批判的思考教育:情報に基づく意思決定を強化。

倫理的AI開発:

- 人間の価値:AIを社会的幸福に整合させる。

- バイアス軽減:差別的な結果を防止。

- データプライバシー:個人情報を保護。

- 説明責任:AIの行動に対して開発者に責任を負わせる。

倫理的AI研究

責任あるAI研究は、イノベーションと社会的・環境的影響の慎重な考慮をバランスさせます。

倫理的研究原則:

- 透明性:コラボレーションを促進するために調査結果を共有。

- 説明責任:研究の結果に対して責任を負う。

- 善意:利益を最大化し、害を最小化。

- 正義:研究が疎外されたグループを含むすべての人に利益をもたらすことを保証。

倫理的研究の促進:

- 倫理審査委員会:研究の影響を評価。

- 倫理ガイドライン:研究者のための基準を設定。

- 関係者の関与:多様な視点を巻き込む。

- 公教育:AIの可能性について社会に知らせる。

イノベーションの推進:

- オープンリサーチ:進歩のためのデータ共有を奨励。

- AI教育:熟練した労働力を育成。

- コラボレーション:セクター間のパートナーシップを促進。

- 倫理的イノベーション:社会的課題に対するソリューションを開発。

AIガバナンスと規制

倫理的懸念に対処し、責任あるAI開発を確保するためには、強固なガバナンスと規制が不可欠です。

ガバナンスの課題:

- 急速な進歩:AIのペースに追いつくこと。

- システムの複雑性:複雑なAI倫理の理解。

- コンセンサスの欠如:倫理基準の合意が難しい。

効果的なガバナンス戦略:

- 倫理基準:責任あるAI原則を定義。

- 規制枠組み:法的ガイドラインを確立。

- 倫理委員会:監督と指導を提供。

- 透明性:明確な意思決定プロセスを要求。

公共の信頼の構築:

- 説明責任:開発者が責任を負うことを保証。

- 人権:個人の自由を保護。

- 社会の利益:社会的ニーズに対処するためにAIを使用。

- 公共の関与:ガバナンスの議論にコミュニティを巻き込む。

サンプルAIガバナンスフレームワーク:

コンポーネント 説明 倫理原則 公平性、透明性、説明責任などの核心的価値観がAI開発を導く。 ポリシーガイドライン AIシステムの設計と展開方法を詳述するルール。 規制枠組み 倫理的遵守と人権保護を保証する法的要件。 監督メカニズム 倫理的使用のためのAIの監視と監査プロセス。 説明責任措置 倫理違反に対するペナルティを含む、開発者に責任を負わせるシステム。

倫理的AIの利点

責任あるAIの未来を形作る

AI倫理に取り組むことは、AIが人類に責任を持って利益をもたらす未来を創るために重要です。倫理を優先することで、AIの可能性を解き放ち、リスクを最小限に抑えます。主な利点には以下が含まれます:

- 信頼の構築:倫理的慣行は関係者の自信を高め、AIの採用を促進。

- イノベーションの促進:倫理的考慮は価値観に合ったイノベーションを刺激し、競争力を強化。

- 公平性の促進:倫理的AIはバイアスを減らし、すべての人に公平な結果を保証。

- 透明性の向上:明確なプロセスは説明責任と信頼を改善。

- 権利の保護:倫理的AIは人間の尊厳と自律性を保護。

- コラボレーションの奨励:共有された倫理的価値観は、責任あるAIのために関係者を団結させる。

最終的に、倫理的AIは道徳的かつ戦略的な必要性であり、AIが人間の幸福を高める未来を保証します。

倫理的AI開発のガイド

ステップ1:倫理原則の定義

組織の価値観と社会的規範を反映した明確な倫理原則を、多様な関係者の意見を取り入れて設定することから始めます。

主要な原則:

- 公平性:バイアスなく公平な扱いを保証。

- 透明性:AIプロセスを関係者に明確にする。

- 説明責任:AIの行動に対する責任を割り当て。

- プライバシー:個人データを保護。

- 安全性:害を防ぐシステムを設計。

ステップ2:倫理的リスクの評価

倫理、法律、AIの専門家を巻き込んで、倫理的懸念を特定するための包括的なリスク評価を実施します。

リスク領域:

- バイアス:データとアルゴリズムのバイアスを検出。

- 差別:不公平な扱いのリスクを評価。

- プライバシー侵害:データ誤使用のリスクを評価。

- セキュリティ脅威:攻撃に対する脆弱性を特定。

- 意図しない結果:潜在的な害を考慮。

ステップ3:設計への倫理の組み込み

AI設計に最初から倫理的考慮を組み込み、公平性、透明性、説明責任を優先します。

設計アプローチ:

- 公平性重視のアルゴリズム:公平な結果を促進。

- 説明可能AI:理解可能な意思決定のためにXAIを使用。

- プライバシー技術:ユーザーデータを保護。

- 人間の監督:AIに人間の介入を要求。

- 透明性ツール:データ使用についてユーザーに通知。

ステップ4:システムの監視と監査

倫理的問題を検出し、原則と規制の遵守を保証するために、監視と監査を実施します。

実践:

- パフォーマンス監視:バイアスの指標を追跡。

- データ監査:バイアスのデータチェック。

- アルゴリズムの透明性:倫理のためのアルゴリズム監視。

- ユーザーからのフィードバック:倫理的懸念に関する意見を収集。

- 遵守:倫理基準の遵守を保証。

ステップ5:説明責任の確保

AIの行動に対する明確な説明責任を確立し、倫理的懸念に迅速に対応するための報告メカニズムを設けます。

措置:

- 倫理担当者:倫理的慣行を監督。

- 審査委員会:AIプロジェクトの倫理を評価。

- 報告チャネル:関係者のフィードバックを可能に。

- 内部告発者保護:問題を報告する者を保護。

- 制裁:倫理違反を罰する。

AI倫理の長所と短所

長所

AIシステムへのより高い信頼と採用

意思決定の説明責任と明確さの向上

バイアスの軽減とより公平な結果

プライバシーとデータセキュリティの保護の強化

社会の利益のためのAIへの注目の増加

短所

開発コストと時間の増加

倫理ガイドラインの施行の複雑さ

倫理とイノベーションのバランス

倫理基準の合意の難しさ

意図しない倫理的結果のリスク

AI倫理FAQ

AIの主な倫理的懸念は何ですか?

主な懸念には、透明性、公平性、プライバシー、説明責任、安全性が含まれ、すべて責任あるAI使用に不可欠です。

AIの公平性をどのように確保できますか?

多様なデータ、公平性重視のアルゴリズム、定期的な監査、関係者の関与を使用して、公平な結果を促進します。

AIでプライバシーをどのように保護できますか?

データ最小化、暗号化、差分プライバシー、連合学習、透明なデータ慣行を採用します。

AIのエラーに対する責任者は誰ですか?

責任を割り当てるために明確なガイドラインと法的枠組みが必要であり、説明責任措置によって支援されます。

AIシステムをどのように安全にできますか?

形式検証、敵対的トレーニング、異常検知、厳格なテストを使用して安全性と堅牢性を確保します。

AIはどのように社会の利益を促進できますか?

AIは、医療、教育、持続可能性の課題に対処し、倫理的ソリューションを通じて生活を改善できます。

関連するAI倫理の質問

AIが人間の自律性に与える影響は何ですか?

AIは自律性を侵食するリスクがあり、透明性、人間の監督、ユーザー制御が必要で、主体性を維持します。

AI開発に倫理をどのように統合できますか?

原則を定義し、リスクを評価し、設計に倫理を組み込み、システムを監視し、説明責任を確保します。

AIガバナンスの課題は何ですか?

急速な進歩、システムの複雑性、コンセンサスの欠如は、効果的な規制の作成を複雑にします。

AIの仕事への影響にどのように備えることができますか?

リスキリング、新たな雇用の創出、セーフティネットの提供、生涯学習を促進して、AI主導の変化に適応します。

関連記事

GoogleがAIモードとVeo 3を発表、検索とビデオ作成を革新

Googleは最近、ウェブ検索とデジタルコンテンツ作成を再構築する2つの革新的な技術、AIモードとVeo 3を発表しました。AIモードは、ユーザーのコンテキスト、意図、好みを理解することで、従来のキーワードベースの検索を上回る、AI強化されたパーソナライズされた検索体験を提供し、より迅速かつ直感的な情報取得を可能にします。一方、Veo 3は最先端のAIを活用してビデオ制作を革新し、対話、サウンドエ

GoogleがAIモードとVeo 3を発表、検索とビデオ作成を革新

Googleは最近、ウェブ検索とデジタルコンテンツ作成を再構築する2つの革新的な技術、AIモードとVeo 3を発表しました。AIモードは、ユーザーのコンテキスト、意図、好みを理解することで、従来のキーワードベースの検索を上回る、AI強化されたパーソナライズされた検索体験を提供し、より迅速かつ直感的な情報取得を可能にします。一方、Veo 3は最先端のAIを活用してビデオ制作を革新し、対話、サウンドエ

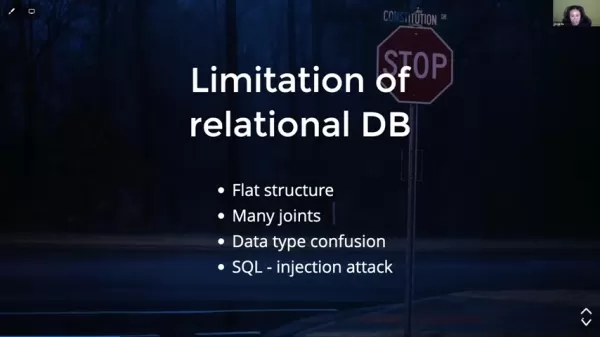

AI産業の改訂管理グラフデータベースの緊急の必要性

AIセクターは急速に進化しており、複雑なデータやワークフローを管理するための高度なツールが必要です。従来のリレーショナルデータベースは、AIの動的なデータニーズ、特に改訂追跡、コラボレーション、ガバナンスに対応するのに不十分な場合が多いです。この記事では、改訂管理グラフデータベースがこれらの課題を克服し、AIのイノベーションを推進するために不可欠な理由を検討します。主なポイントAI開発には堅牢なデ

AI産業の改訂管理グラフデータベースの緊急の必要性

AIセクターは急速に進化しており、複雑なデータやワークフローを管理するための高度なツールが必要です。従来のリレーショナルデータベースは、AIの動的なデータニーズ、特に改訂追跡、コラボレーション、ガバナンスに対応するのに不十分な場合が多いです。この記事では、改訂管理グラフデータベースがこれらの課題を克服し、AIのイノベーションを推進するために不可欠な理由を検討します。主なポイントAI開発には堅牢なデ

「サジャダ・メラ」の愛と義務の解きほぐし

「サジャダ・メラ」という曲は、愛、信仰、そして家族や義務のために払われた犠牲について感動的な物語を紡ぎます。ある男性が、事情により他の男性と結婚した女性を愛していた感情を掘り下げます。歌詞は、献身、精神的なコミットメント、そして家族の期待によって形作られた運命を受け入れるテーマを探求します。この曲は、別離や社会的圧力の中でも持続する愛の永続的な力を鮮やかに捉えています。主なポイント持続する愛:この

コメント (0)

0/200

「サジャダ・メラ」の愛と義務の解きほぐし

「サジャダ・メラ」という曲は、愛、信仰、そして家族や義務のために払われた犠牲について感動的な物語を紡ぎます。ある男性が、事情により他の男性と結婚した女性を愛していた感情を掘り下げます。歌詞は、献身、精神的なコミットメント、そして家族の期待によって形作られた運命を受け入れるテーマを探求します。この曲は、別離や社会的圧力の中でも持続する愛の永続的な力を鮮やかに捉えています。主なポイント持続する愛:この

コメント (0)

0/200

人工知能(AI)が進化し、日常生活に統合されるにつれ、その開発と使用における倫理的考慮が最も重要です。この記事では、透明性、公平性、プライバシー、説明責任、安全性、そしてAIを社会の利益のために活用することなど、必須の側面を探ります。これらの側面を理解することは、信頼を築き、責任あるイノベーションを促進し、AIの可能性を最大限に引き出しながらリスクを最小限に抑える鍵です。AIの倫理的複雑さをナビゲートして、それが人類に責任を持って効果的に役立つようにしましょう。

主なポイント

透明性と説明可能性は、AIシステムへの信頼を築きます。

公平性とバイアスの軽減は、差別を防ぎ、公平性を促進するために不可欠です。

プライバシーとデータセキュリティの優先は、機密情報を保護します。

説明責任の枠組みは、AIに関連する害に対処するために必要です。

AIの安全性と堅牢性は、意図しない結果を防ぎ、信頼性を確保します。

社会の利益のためのAIの活用は、医療、教育、その他の課題に対処します。

労働市場への影響の軽減は、雇用の喪失と不平等を減らします。

人間の自律性の維持は、主体性と意思決定の制御を保持します。

倫理的AI研究は、利益とリスクの慎重な検討を必要とします。

効果的なAIガバナンスは、責任ある開発と展開を保証します。

AIの倫理的側面の探求

AIの透明性と説明可能性

AIシステムがより高度になるにつれ、その動作を理解することはますます難しくなります。透明性と説明可能性は、信頼と説明責任を育むために重要です。

AIの透明性は、システムがどのように機能するか、データ、アルゴリズム、意思決定プロセスについての明確さを伴います。説明可能性は、AIの意思決定が人間に理解可能であることを保証し、関係者が結果の背後にある理由を理解できるようにします。

説明可能AI(XAI)の役割:

説明可能AI(XAI)は、人間が解釈可能なモデルを開発し、関係者が意思決定の根拠を評価できるようにし、信頼と監督を強化します。主なXAI技術には以下が含まれます:

- ルールベースシステム:透明な意思決定のための明確なルールを使用。

- 意思決定ツリー:視覚的な意思決定経路を提供し、理解を容易に。

- 特徴の重要性:モデル予測を推進する主要なデータ要因を強調。

透明性と説明可能性の利点:

- 信頼の醸成:明確なシステムはユーザーの自信と採用を促進。

- 説明責任の強化:動作の理解はエラーやバイアスの特定と修正を支援。

- 監督の支援:透明性は関係者が倫理的整合性を確保できるように。

- 意思決定の改善:明確な根拠は情報に基づく選択のための洞察を提供。

AIの公平性とバイアス軽減

AIシステムは、トレーニングデータに存在するバイアスを永続化し、不公平な結果を招く可能性があります。公平性は、AIが人種、性別、宗教などの属性に基づく差別を回避することを保証し、バイアス軽減はシステム出力の不平等に対処します。

AIバイアスの原因:

- 歴史的バイアス:トレーニングデータに反映される社会的バイアス。

- サンプリングバイアス:代表性のないデータサンプルに由来。

- 測定バイアス:欠陥のある測定方法に起因。

- アルゴリズムバイアス:アルゴリズムの設計または実装に由来。

バイアス軽減戦略:

- データ前処理:バイアスを最小限に抑えるためにデータをクリーニング。

- アルゴリズム設計:公平性に焦点を当てたアルゴリズムを作成。

- モデル評価:バイアスと公平性を評価するための指標を使用。

- 後処理:差別的な影響を軽減するために出力を調整。

公平性の促進:

- 多様なデータセット:代表的なデータでAIをトレーニング。

- バイアス監査:システムのバイアス行動を定期的にチェック。

- 関係者の関与:開発に多様なグループを巻き込む。

- 透明性と説明責任:明確で責任ある意思決定を保証。

AIのプライバシーとデータセキュリティ

AIは、しばしば機密情報を含む膨大なデータセットに依存します。プライバシーの保護とデータのセキュリティ確保は、ユーザーの信頼にとって重要です。

AIのプライバシーは、個人データを不正アクセスや使用から保護し、データセキュリティは盗難、紛失、または破損を防ぎます。

プライバシーとセキュリティの核心原則:

- データ最小化:必要最小限のデータのみ収集。

- 目的制限:データは意図した目的にのみ使用。

- データセキュリティ:不正アクセスに対する強固な保護を適用。

- 透明性:データ使用についてユーザーに通知。

- ユーザー制御:個人が自分のデータを管理できるように。

プライバシーとセキュリティの技術:

- 匿名化:プライバシーを保護するために識別可能なデータを削除。

- 差分プライバシー:データを分析する際にノイズを追加して個人を保護。

- 連合学習:データを共有せずに分散データでモデルをトレーニング。

- 暗号化:不正アクセスからデータを保護。

プライバシーを通じた信頼の構築:

- プライバシー強化技術:高度なツールでユーザーデータを保護。

- データセキュリティ対策:強力な保護で侵害を防止。

- 規制遵守:GDPRやCCPAなどの法律を遵守。

- 明確なコミュニケーション:プライバシー慣行についてユーザーに通知。

AIの説明責任と責任

AIのエラーや害に対する責任の割り当ては、複数の関係者が関与するため複雑です。明確な枠組みが必要で、説明責任を確保します。

説明責任は、AIを開発・展開する者がその影響に対して責任を負うことを保証し、責任は倫理的監督に焦点を当てます。

説明責任の課題:

- システムの複雑性:複雑なAIシステムでのエラー追跡は困難。

- 複数の関係者:AIのライフサイクルに様々な当事者が関与。

- 法的枠組みの欠如:明確な責任ガイドラインがしばしば不在。

説明責任の促進:

- 明確なガイドライン:AIの開発と使用のための基準を設定。

- 法的枠組み:AIによる結果の責任を定義。

- 監査とモニタリング:エラーやバイアスを検出し対処。

- 説明可能AI:意思決定の根拠を明確にするためにXAIを使用。

倫理的慣行の奨励:

- 倫理トレーニング:開発者に倫理原則を教育。

- 倫理審査委員会:AIプロジェクトの倫理的影響を評価。

- 業界標準:責任あるAIのための規範を確立。

- 関係者の関与:評価に多様なグループを巻き込む。

AIの安全性と堅牢性

AIシステムは、害を避け、攻撃やエラーに対する信頼性を確保するために安全で堅牢でなければなりません。

安全性と堅牢性の主要な考慮事項:

- 意図しない結果:AIの行動による害を防止。

- 敵対的攻撃:悪意のある操作に対する保護。

- 予期しない入力:異常な入力を効果的に処理。

- システムの信頼性:一貫したパフォーマンスを保証。

安全性と堅牢性の強化:

- 形式検証:システムの安全性を数学的に確認。

- 敵対的トレーニング:攻撃に耐えるシステムをトレーニング。

- 異常検知:異常な入力を特定しフラグ立て。

- 冗長性:信頼性のためにフォールトトレラントなシステムを構築。

責任あるイノベーションの推進:

- 安全性研究:AIの安全性研究に投資。

- 安全基準:堅牢なAIのためのガイドラインを開発。

- テストと検証:システムの安全性を厳密にテスト。

- 継続的なモニタリング:問題に対処するためにシステムを追跡。

社会の利益のためのAI

AIは、医療、教育、持続可能性などの社会的課題に取り組み、ターゲットを絞ったソリューションで生活を改善できます。

医療:診断、治療、予防を強化。

教育:学習をパーソナライズし、アクセスを改善。

環境持続可能性:資源を最適化し、汚染を削減。

貧困削減:金融アクセスと雇用機会を拡大。

災害救援:準備と回復を改善。

社会の利益のための倫理的考慮:

- 公平性と包摂性:利益が疎外されたグループに届くことを保証。

- 透明性と説明責任:明確な意思決定プロセスを維持。

- プライバシーとセキュリティ:機密データを保護。

- 人間の自律性:個人の制御を維持。

社会の利益を促進する取り組み:

- 研究の資金提供:社会的影響のためのAIを支援。

- スタートアップの支援:社会的課題に取り組むベンチャーを支援。

- 官民パートナーシップ:影響力のあるソリューションで協力。

- 関係者の関与:開発に多様なグループを巻き込む。

労働と雇用の影響

AIの自動化の可能性は、雇用の喪失と不平等に関する懸念を引き起こし、積極的な労働力戦略が必要です。

AIの労働への影響:

- 雇用の喪失:一部のセクターで自動化が仕事を減らす可能性。

- 雇用の創出:AI関連分野で新たな役割が生まれる。

- スキルギャップ:専門スキルの需要が増加。

- 所得格差:スキルレベル間の格差が拡大。

労働への影響の軽減:

- リスキリングプログラム:新たな役割のための労働者のトレーニング。

- 雇用の創出:AI主導の産業に投資。

- 社会的セーフティネット:影響を受けた労働者を支援。

- 生涯学習:継続的なスキル開発を促進。

公平な移行の確保:

- 再訓練プログラム:労働者が新たな産業に移行するのを支援。

- 失業給付:自動化の影響を受けた人々を支援。

- 普遍的ベーシックインカム:すべての人に対するセーフティネットを検討。

- 労働者のエンパワーメント:AIの意思決定に労働者を巻き込む。

人間の自律性の維持

高度なAIは人間の制御を減らすリスクがあり、主体性と意思決定力を維持することが不可欠です。

人間の自律性は、個人が自分の選択と生活に対する制御を保持し、不当なAIの影響を防ぎます。

自律性へのリスク:

- AIの操作:システムが行動を微妙に左右する可能性。

- 過度な依存:AIへの依存が批判的思考を弱める可能性。

- 制御の喪失:制御されないAIによる意図しない結果。

自律性の維持:

- 透明性:明確で理解可能なAIプロセスを保証。

- 人間の関与:AIシステムでの人間の監督を要求。

- ユーザー制御:AI主導の意思決定からのオプトアウトを許可。

- 批判的思考教育:情報に基づく意思決定を強化。

倫理的AI開発:

- 人間の価値:AIを社会的幸福に整合させる。

- バイアス軽減:差別的な結果を防止。

- データプライバシー:個人情報を保護。

- 説明責任:AIの行動に対して開発者に責任を負わせる。

倫理的AI研究

責任あるAI研究は、イノベーションと社会的・環境的影響の慎重な考慮をバランスさせます。

倫理的研究原則:

- 透明性:コラボレーションを促進するために調査結果を共有。

- 説明責任:研究の結果に対して責任を負う。

- 善意:利益を最大化し、害を最小化。

- 正義:研究が疎外されたグループを含むすべての人に利益をもたらすことを保証。

倫理的研究の促進:

- 倫理審査委員会:研究の影響を評価。

- 倫理ガイドライン:研究者のための基準を設定。

- 関係者の関与:多様な視点を巻き込む。

- 公教育:AIの可能性について社会に知らせる。

イノベーションの推進:

- オープンリサーチ:進歩のためのデータ共有を奨励。

- AI教育:熟練した労働力を育成。

- コラボレーション:セクター間のパートナーシップを促進。

- 倫理的イノベーション:社会的課題に対するソリューションを開発。

AIガバナンスと規制

倫理的懸念に対処し、責任あるAI開発を確保するためには、強固なガバナンスと規制が不可欠です。

ガバナンスの課題:

- 急速な進歩:AIのペースに追いつくこと。

- システムの複雑性:複雑なAI倫理の理解。

- コンセンサスの欠如:倫理基準の合意が難しい。

効果的なガバナンス戦略:

- 倫理基準:責任あるAI原則を定義。

- 規制枠組み:法的ガイドラインを確立。

- 倫理委員会:監督と指導を提供。

- 透明性:明確な意思決定プロセスを要求。

公共の信頼の構築:

- 説明責任:開発者が責任を負うことを保証。

- 人権:個人の自由を保護。

- 社会の利益:社会的ニーズに対処するためにAIを使用。

- 公共の関与:ガバナンスの議論にコミュニティを巻き込む。

サンプルAIガバナンスフレームワーク:

| コンポーネント | 説明 |

|---|---|

| 倫理原則 | 公平性、透明性、説明責任などの核心的価値観がAI開発を導く。 |

| ポリシーガイドライン | AIシステムの設計と展開方法を詳述するルール。 |

| 規制枠組み | 倫理的遵守と人権保護を保証する法的要件。 |

| 監督メカニズム | 倫理的使用のためのAIの監視と監査プロセス。 |

| 説明責任措置 | 倫理違反に対するペナルティを含む、開発者に責任を負わせるシステム。 |

倫理的AIの利点

責任あるAIの未来を形作る

AI倫理に取り組むことは、AIが人類に責任を持って利益をもたらす未来を創るために重要です。倫理を優先することで、AIの可能性を解き放ち、リスクを最小限に抑えます。主な利点には以下が含まれます:

- 信頼の構築:倫理的慣行は関係者の自信を高め、AIの採用を促進。

- イノベーションの促進:倫理的考慮は価値観に合ったイノベーションを刺激し、競争力を強化。

- 公平性の促進:倫理的AIはバイアスを減らし、すべての人に公平な結果を保証。

- 透明性の向上:明確なプロセスは説明責任と信頼を改善。

- 権利の保護:倫理的AIは人間の尊厳と自律性を保護。

- コラボレーションの奨励:共有された倫理的価値観は、責任あるAIのために関係者を団結させる。

最終的に、倫理的AIは道徳的かつ戦略的な必要性であり、AIが人間の幸福を高める未来を保証します。

倫理的AI開発のガイド

ステップ1:倫理原則の定義

組織の価値観と社会的規範を反映した明確な倫理原則を、多様な関係者の意見を取り入れて設定することから始めます。

主要な原則:

- 公平性:バイアスなく公平な扱いを保証。

- 透明性:AIプロセスを関係者に明確にする。

- 説明責任:AIの行動に対する責任を割り当て。

- プライバシー:個人データを保護。

- 安全性:害を防ぐシステムを設計。

ステップ2:倫理的リスクの評価

倫理、法律、AIの専門家を巻き込んで、倫理的懸念を特定するための包括的なリスク評価を実施します。

リスク領域:

- バイアス:データとアルゴリズムのバイアスを検出。

- 差別:不公平な扱いのリスクを評価。

- プライバシー侵害:データ誤使用のリスクを評価。

- セキュリティ脅威:攻撃に対する脆弱性を特定。

- 意図しない結果:潜在的な害を考慮。

ステップ3:設計への倫理の組み込み

AI設計に最初から倫理的考慮を組み込み、公平性、透明性、説明責任を優先します。

設計アプローチ:

- 公平性重視のアルゴリズム:公平な結果を促進。

- 説明可能AI:理解可能な意思決定のためにXAIを使用。

- プライバシー技術:ユーザーデータを保護。

- 人間の監督:AIに人間の介入を要求。

- 透明性ツール:データ使用についてユーザーに通知。

ステップ4:システムの監視と監査

倫理的問題を検出し、原則と規制の遵守を保証するために、監視と監査を実施します。

実践:

- パフォーマンス監視:バイアスの指標を追跡。

- データ監査:バイアスのデータチェック。

- アルゴリズムの透明性:倫理のためのアルゴリズム監視。

- ユーザーからのフィードバック:倫理的懸念に関する意見を収集。

- 遵守:倫理基準の遵守を保証。

ステップ5:説明責任の確保

AIの行動に対する明確な説明責任を確立し、倫理的懸念に迅速に対応するための報告メカニズムを設けます。

措置:

- 倫理担当者:倫理的慣行を監督。

- 審査委員会:AIプロジェクトの倫理を評価。

- 報告チャネル:関係者のフィードバックを可能に。

- 内部告発者保護:問題を報告する者を保護。

- 制裁:倫理違反を罰する。

AI倫理の長所と短所

長所

AIシステムへのより高い信頼と採用

意思決定の説明責任と明確さの向上

バイアスの軽減とより公平な結果

プライバシーとデータセキュリティの保護の強化

社会の利益のためのAIへの注目の増加

短所

開発コストと時間の増加

倫理ガイドラインの施行の複雑さ

倫理とイノベーションのバランス

倫理基準の合意の難しさ

意図しない倫理的結果のリスク

AI倫理FAQ

AIの主な倫理的懸念は何ですか?

主な懸念には、透明性、公平性、プライバシー、説明責任、安全性が含まれ、すべて責任あるAI使用に不可欠です。

AIの公平性をどのように確保できますか?

多様なデータ、公平性重視のアルゴリズム、定期的な監査、関係者の関与を使用して、公平な結果を促進します。

AIでプライバシーをどのように保護できますか?

データ最小化、暗号化、差分プライバシー、連合学習、透明なデータ慣行を採用します。

AIのエラーに対する責任者は誰ですか?

責任を割り当てるために明確なガイドラインと法的枠組みが必要であり、説明責任措置によって支援されます。

AIシステムをどのように安全にできますか?

形式検証、敵対的トレーニング、異常検知、厳格なテストを使用して安全性と堅牢性を確保します。

AIはどのように社会の利益を促進できますか?

AIは、医療、教育、持続可能性の課題に対処し、倫理的ソリューションを通じて生活を改善できます。

関連するAI倫理の質問

AIが人間の自律性に与える影響は何ですか?

AIは自律性を侵食するリスクがあり、透明性、人間の監督、ユーザー制御が必要で、主体性を維持します。

AI開発に倫理をどのように統合できますか?

原則を定義し、リスクを評価し、設計に倫理を組み込み、システムを監視し、説明責任を確保します。

AIガバナンスの課題は何ですか?

急速な進歩、システムの複雑性、コンセンサスの欠如は、効果的な規制の作成を複雑にします。

AIの仕事への影響にどのように備えることができますか?

リスキリング、新たな雇用の創出、セーフティネットの提供、生涯学習を促進して、AI主導の変化に適応します。

AI産業の改訂管理グラフデータベースの緊急の必要性

AIセクターは急速に進化しており、複雑なデータやワークフローを管理するための高度なツールが必要です。従来のリレーショナルデータベースは、AIの動的なデータニーズ、特に改訂追跡、コラボレーション、ガバナンスに対応するのに不十分な場合が多いです。この記事では、改訂管理グラフデータベースがこれらの課題を克服し、AIのイノベーションを推進するために不可欠な理由を検討します。主なポイントAI開発には堅牢なデ

AI産業の改訂管理グラフデータベースの緊急の必要性

AIセクターは急速に進化しており、複雑なデータやワークフローを管理するための高度なツールが必要です。従来のリレーショナルデータベースは、AIの動的なデータニーズ、特に改訂追跡、コラボレーション、ガバナンスに対応するのに不十分な場合が多いです。この記事では、改訂管理グラフデータベースがこれらの課題を克服し、AIのイノベーションを推進するために不可欠な理由を検討します。主なポイントAI開発には堅牢なデ

「サジャダ・メラ」の愛と義務の解きほぐし

「サジャダ・メラ」という曲は、愛、信仰、そして家族や義務のために払われた犠牲について感動的な物語を紡ぎます。ある男性が、事情により他の男性と結婚した女性を愛していた感情を掘り下げます。歌詞は、献身、精神的なコミットメント、そして家族の期待によって形作られた運命を受け入れるテーマを探求します。この曲は、別離や社会的圧力の中でも持続する愛の永続的な力を鮮やかに捉えています。主なポイント持続する愛:この

「サジャダ・メラ」の愛と義務の解きほぐし

「サジャダ・メラ」という曲は、愛、信仰、そして家族や義務のために払われた犠牲について感動的な物語を紡ぎます。ある男性が、事情により他の男性と結婚した女性を愛していた感情を掘り下げます。歌詞は、献身、精神的なコミットメント、そして家族の期待によって形作られた運命を受け入れるテーマを探求します。この曲は、別離や社会的圧力の中でも持続する愛の永続的な力を鮮やかに捉えています。主なポイント持続する愛:この