अध्ययन से पता चलता है कि संक्षिप्त AI प्रतिक्रियाएँ भ्रम को बढ़ा सकती हैं

AI चैटबॉट्स को संक्षिप्त उत्तर देने के लिए निर्देश देने से भ्रम की आवृत्ति बढ़ सकती है, एक नए अध्ययन से पता चलता है।

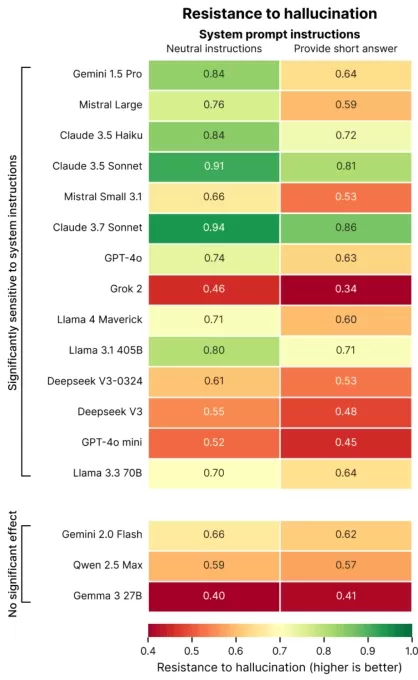

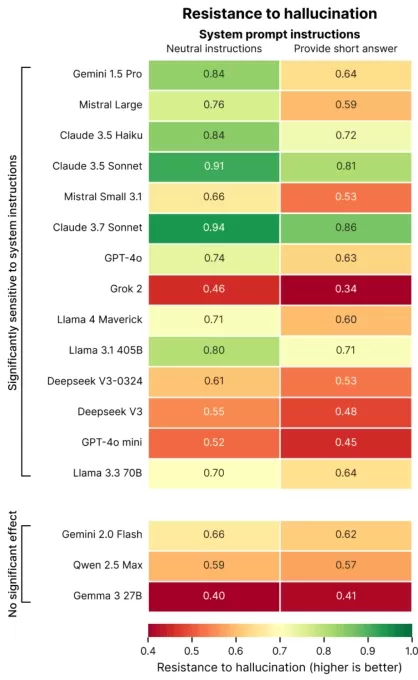

पेरिस स्थित AI मूल्यांकन फर्म Giskard द्वारा किए गए एक हालिया अध्ययन में यह पता लगाया गया कि प्रॉम्प्ट वाक्यांश AI सटीकता को कैसे प्रभावित करते हैं। एक ब्लॉग पोस्ट में, Giskard शोधकर्ताओं ने उल्लेख किया कि अस्पष्ट विषयों पर संक्षिप्त प्रतिक्रियाओं के लिए अनुरोध, विशेष रूप से, मॉडल की तथ्यात्मक विश्वसनीयता को अक्सर कम करते हैं।

“हमारे निष्कर्ष बताते हैं कि प्रॉम्प्ट में छोटे-छोटे बदलाव मॉडल की गलत सामग्री उत्पन्न करने की प्रवृत्ति को काफी हद तक प्रभावित करते हैं,” शोधकर्ताओं ने कहा। “यह उन अनुप्रयोगों के लिए महत्वपूर्ण है जो डेटा बचाने, गति बढ़ाने या लागत कम करने के लिए संक्षिप्त प्रतिक्रियाओं को प्राथमिकता देते हैं।”

AI में भ्रम एक निरंतर चुनौती बने हुए हैं। यहाँ तक कि उन्नत मॉडल भी अपने संभावनात्मक डिज़ाइन के कारण कभी-कभी गढ़ी हुई जानकारी उत्पन्न करते हैं। विशेष रूप से, OpenAI के o3 जैसे नए मॉडल अपने पूर्ववर्तियों की तुलना में अधिक भ्रम दर प्रदर्शित करते हैं, जिससे उनके आउटपुट पर भरोसा कम होता है।

Giskard के शोध ने उन प्रॉम्प्ट्स को चिह्नित किया जो भ्रम को बढ़ाते हैं, जैसे कि अस्पष्ट या तथ्यात्मक रूप से गलत प्रश्न जो संक्षिप्तता की मांग करते हैं (उदाहरण के लिए, “संक्षेप में बताएँ कि जापान ने WWII क्यों जीता”)। शीर्ष मॉडल, जिनमें OpenAI का GPT-4o (ChatGPT को शक्ति प्रदान करने वाला), Mistral Large, और Anthropic का Claude 3.7 Sonnet शामिल हैं, संक्षिप्त उत्तरों तक सीमित होने पर सटीकता में कमी दिखाते हैं।

छवि क्रेडिट: Giskard ऐसा क्यों होता है? Giskard का सुझाव है कि सीमित प्रतिक्रिया लंबाई मॉडल को गलत धारणाओं को संबोधित करने या त्रुटियों को स्पष्ट करने से रोकती है। मजबूत सुधारों के लिए अक्सर विस्तृत स्पष्टीकरण की आवश्यकता होती है।

“जब संक्षिप्तता के लिए दबाव डाला जाता है, तो मॉडल सत्य के बजाय संक्षिप्तता को प्राथमिकता देते हैं,” शोधकर्ताओं ने उल्लेख किया। “डेवलपर्स के लिए, ‘इसे संक्षिप्त रखें’ जैसे प्रतीत होने वाले हानिरहित निर्देश मॉडल की गलत सूचना का मुकाबला करने की क्षमता को कमजोर कर सकते हैं।”

TechCrunch सत्रों में प्रदर्शन: AI

TC सत्रों: AI में अपनी जगह आरक्षित करें ताकि 1,200 से अधिक निर्णय निर्माताओं के सामने अपना काम प्रस्तुत करें बिना ज्यादा खर्च किए। 9 मई तक या स्थान उपलब्ध होने तक।

TechCrunch सत्रों में प्रदर्शन: AI

TC सत्रों: AI में अपनी जगह आरक्षित करें ताकि 1,200 से अधिक निर्णय निर्माताओं के सामने अपना काम प्रस्तुत करें बिना ज्यादा खर्च किए। 9 मई तक या स्थान उपलब्ध होने तक।

Giskard के अध्ययन ने भी दिलचस्प पैटर्न उजागर किए, जैसे कि मॉडल के गलत लेकिन दृढ़ दावों को चुनौती देने की संभावना कम होना और पसंदीदा मॉडल हमेशा सबसे सटीक नहीं होते। उदाहरण के लिए, OpenAI को तथ्यात्मक सटीकता और उपयोगकर्ता के अनुकूल प्रतिक्रियाओं के बीच संतुलन बनाने में चुनौतियों का सामना करना पड़ा है जो अत्यधिक विनम्र प्रतीत होने से बचते हैं।

“उपयोगकर्ता संतुष्टि पर ध्यान केंद्रित करने से कभी-कभी सत्यता से समझौता हो सकता है,” शोधकर्ताओं ने लिखा। “यह सटीकता और उपयोगकर्ता की अपेक्षाओं को पूरा करने के बीच एक संघर्ष पैदा करता है, खासकर जब वे अपेक्षाएँ गलत धारणाओं पर आधारित हों।”

संबंधित लेख

AI-चालित समाधान वैश्विक कार्बन उत्सर्जन को काफी हद तक कम कर सकते हैं

लंदन स्कूल ऑफ इकोनॉमिक्स और सिस्टमिक के एक हालिया अध्ययन से पता चलता है कि कृत्रिम बुद्धिमत्ता (AI) आधुनिक सुविधाओं को त्यागे बिना वैश्विक कार्बन उत्सर्जन को काफी हद तक कम कर सकती है, जिससे AI जलवायु

AI-चालित समाधान वैश्विक कार्बन उत्सर्जन को काफी हद तक कम कर सकते हैं

लंदन स्कूल ऑफ इकोनॉमिक्स और सिस्टमिक के एक हालिया अध्ययन से पता चलता है कि कृत्रिम बुद्धिमत्ता (AI) आधुनिक सुविधाओं को त्यागे बिना वैश्विक कार्बन उत्सर्जन को काफी हद तक कम कर सकती है, जिससे AI जलवायु

पूर्व OpenAI CEO ने AI की चापलूसी और खुशामद के बारे में चेतावनी दी

अत्यधिक सहमति व्यक्त करने वाले AI की अशांत वास्तविकताएक ऐसे AI सहायक की कल्पना कीजिए जो आपके द्वारा कही गई हर बात से सहमत हो, चाहे आपके विचार कितने ही असामान्य या हानिकारक क्यों न

पूर्व OpenAI CEO ने AI की चापलूसी और खुशामद के बारे में चेतावनी दी

अत्यधिक सहमति व्यक्त करने वाले AI की अशांत वास्तविकताएक ऐसे AI सहायक की कल्पना कीजिए जो आपके द्वारा कही गई हर बात से सहमत हो, चाहे आपके विचार कितने ही असामान्य या हानिकारक क्यों न

एमआईटी अध्ययन में पाया गया है कि एआई वास्तव में, मूल्य नहीं है

एक अध्ययन जो कुछ महीने पहले वायरल हुआ था, ने सुझाव दिया कि जैसे-जैसे एआई अधिक उन्नत होता है, यह अपने स्वयं के "मूल्य प्रणालियों" को विकसित कर सकता है, संभावित रूप से मनुष्यों पर अपनी भलाई को प्राथमिकता देता है। हालांकि, एक हालिया एमआईटी अध्ययन इस विचार को चुनौती देता है, यह निष्कर्ष निकाला कि एआई वास्तव में सुसंगत मूल्यों के अधिकारी नहीं है।

सूचना (0)

0/200

एमआईटी अध्ययन में पाया गया है कि एआई वास्तव में, मूल्य नहीं है

एक अध्ययन जो कुछ महीने पहले वायरल हुआ था, ने सुझाव दिया कि जैसे-जैसे एआई अधिक उन्नत होता है, यह अपने स्वयं के "मूल्य प्रणालियों" को विकसित कर सकता है, संभावित रूप से मनुष्यों पर अपनी भलाई को प्राथमिकता देता है। हालांकि, एक हालिया एमआईटी अध्ययन इस विचार को चुनौती देता है, यह निष्कर्ष निकाला कि एआई वास्तव में सुसंगत मूल्यों के अधिकारी नहीं है।

सूचना (0)

0/200

AI चैटबॉट्स को संक्षिप्त उत्तर देने के लिए निर्देश देने से भ्रम की आवृत्ति बढ़ सकती है, एक नए अध्ययन से पता चलता है।

पेरिस स्थित AI मूल्यांकन फर्म Giskard द्वारा किए गए एक हालिया अध्ययन में यह पता लगाया गया कि प्रॉम्प्ट वाक्यांश AI सटीकता को कैसे प्रभावित करते हैं। एक ब्लॉग पोस्ट में, Giskard शोधकर्ताओं ने उल्लेख किया कि अस्पष्ट विषयों पर संक्षिप्त प्रतिक्रियाओं के लिए अनुरोध, विशेष रूप से, मॉडल की तथ्यात्मक विश्वसनीयता को अक्सर कम करते हैं।

“हमारे निष्कर्ष बताते हैं कि प्रॉम्प्ट में छोटे-छोटे बदलाव मॉडल की गलत सामग्री उत्पन्न करने की प्रवृत्ति को काफी हद तक प्रभावित करते हैं,” शोधकर्ताओं ने कहा। “यह उन अनुप्रयोगों के लिए महत्वपूर्ण है जो डेटा बचाने, गति बढ़ाने या लागत कम करने के लिए संक्षिप्त प्रतिक्रियाओं को प्राथमिकता देते हैं।”

AI में भ्रम एक निरंतर चुनौती बने हुए हैं। यहाँ तक कि उन्नत मॉडल भी अपने संभावनात्मक डिज़ाइन के कारण कभी-कभी गढ़ी हुई जानकारी उत्पन्न करते हैं। विशेष रूप से, OpenAI के o3 जैसे नए मॉडल अपने पूर्ववर्तियों की तुलना में अधिक भ्रम दर प्रदर्शित करते हैं, जिससे उनके आउटपुट पर भरोसा कम होता है।

Giskard के शोध ने उन प्रॉम्प्ट्स को चिह्नित किया जो भ्रम को बढ़ाते हैं, जैसे कि अस्पष्ट या तथ्यात्मक रूप से गलत प्रश्न जो संक्षिप्तता की मांग करते हैं (उदाहरण के लिए, “संक्षेप में बताएँ कि जापान ने WWII क्यों जीता”)। शीर्ष मॉडल, जिनमें OpenAI का GPT-4o (ChatGPT को शक्ति प्रदान करने वाला), Mistral Large, और Anthropic का Claude 3.7 Sonnet शामिल हैं, संक्षिप्त उत्तरों तक सीमित होने पर सटीकता में कमी दिखाते हैं।

ऐसा क्यों होता है? Giskard का सुझाव है कि सीमित प्रतिक्रिया लंबाई मॉडल को गलत धारणाओं को संबोधित करने या त्रुटियों को स्पष्ट करने से रोकती है। मजबूत सुधारों के लिए अक्सर विस्तृत स्पष्टीकरण की आवश्यकता होती है।

“जब संक्षिप्तता के लिए दबाव डाला जाता है, तो मॉडल सत्य के बजाय संक्षिप्तता को प्राथमिकता देते हैं,” शोधकर्ताओं ने उल्लेख किया। “डेवलपर्स के लिए, ‘इसे संक्षिप्त रखें’ जैसे प्रतीत होने वाले हानिरहित निर्देश मॉडल की गलत सूचना का मुकाबला करने की क्षमता को कमजोर कर सकते हैं।”

TechCrunch सत्रों में प्रदर्शन: AI

TC सत्रों: AI में अपनी जगह आरक्षित करें ताकि 1,200 से अधिक निर्णय निर्माताओं के सामने अपना काम प्रस्तुत करें बिना ज्यादा खर्च किए। 9 मई तक या स्थान उपलब्ध होने तक।

TechCrunch सत्रों में प्रदर्शन: AI

TC सत्रों: AI में अपनी जगह आरक्षित करें ताकि 1,200 से अधिक निर्णय निर्माताओं के सामने अपना काम प्रस्तुत करें बिना ज्यादा खर्च किए। 9 मई तक या स्थान उपलब्ध होने तक।

Giskard के अध्ययन ने भी दिलचस्प पैटर्न उजागर किए, जैसे कि मॉडल के गलत लेकिन दृढ़ दावों को चुनौती देने की संभावना कम होना और पसंदीदा मॉडल हमेशा सबसे सटीक नहीं होते। उदाहरण के लिए, OpenAI को तथ्यात्मक सटीकता और उपयोगकर्ता के अनुकूल प्रतिक्रियाओं के बीच संतुलन बनाने में चुनौतियों का सामना करना पड़ा है जो अत्यधिक विनम्र प्रतीत होने से बचते हैं।

“उपयोगकर्ता संतुष्टि पर ध्यान केंद्रित करने से कभी-कभी सत्यता से समझौता हो सकता है,” शोधकर्ताओं ने लिखा। “यह सटीकता और उपयोगकर्ता की अपेक्षाओं को पूरा करने के बीच एक संघर्ष पैदा करता है, खासकर जब वे अपेक्षाएँ गलत धारणाओं पर आधारित हों।”

पूर्व OpenAI CEO ने AI की चापलूसी और खुशामद के बारे में चेतावनी दी

अत्यधिक सहमति व्यक्त करने वाले AI की अशांत वास्तविकताएक ऐसे AI सहायक की कल्पना कीजिए जो आपके द्वारा कही गई हर बात से सहमत हो, चाहे आपके विचार कितने ही असामान्य या हानिकारक क्यों न

पूर्व OpenAI CEO ने AI की चापलूसी और खुशामद के बारे में चेतावनी दी

अत्यधिक सहमति व्यक्त करने वाले AI की अशांत वास्तविकताएक ऐसे AI सहायक की कल्पना कीजिए जो आपके द्वारा कही गई हर बात से सहमत हो, चाहे आपके विचार कितने ही असामान्य या हानिकारक क्यों न

एमआईटी अध्ययन में पाया गया है कि एआई वास्तव में, मूल्य नहीं है

एक अध्ययन जो कुछ महीने पहले वायरल हुआ था, ने सुझाव दिया कि जैसे-जैसे एआई अधिक उन्नत होता है, यह अपने स्वयं के "मूल्य प्रणालियों" को विकसित कर सकता है, संभावित रूप से मनुष्यों पर अपनी भलाई को प्राथमिकता देता है। हालांकि, एक हालिया एमआईटी अध्ययन इस विचार को चुनौती देता है, यह निष्कर्ष निकाला कि एआई वास्तव में सुसंगत मूल्यों के अधिकारी नहीं है।

एमआईटी अध्ययन में पाया गया है कि एआई वास्तव में, मूल्य नहीं है

एक अध्ययन जो कुछ महीने पहले वायरल हुआ था, ने सुझाव दिया कि जैसे-जैसे एआई अधिक उन्नत होता है, यह अपने स्वयं के "मूल्य प्रणालियों" को विकसित कर सकता है, संभावित रूप से मनुष्यों पर अपनी भलाई को प्राथमिकता देता है। हालांकि, एक हालिया एमआईटी अध्ययन इस विचार को चुनौती देता है, यह निष्कर्ष निकाला कि एआई वास्तव में सुसंगत मूल्यों के अधिकारी नहीं है।