Google enthüllt neue Kubernetes- und GKE -Verbesserungen für die KI -Innovation

Googles Vorstoß in die KI ist kein Geheimnis, und das aus gutem Grund. Wie CEO Sundar Pichai in einem internen Treffen vor den Feiertagen des letzten Jahres betonte: „Im Jahr 2025 müssen wir uns unermüdlich darauf konzentrieren, die Vorteile der [KI]-Technologie freizusetzen und echte Nutzerprobleme zu lösen.“ Diese Vision treibt Google dazu an, seine Angebote erheblich zu verbessern, insbesondere in den Bereichen Cloud-Dienste und KI-Integration.

Beim Google Cloud Next 2025-Event in Las Vegas stellte Google bedeutende Fortschritte bei Kubernetes und Google Kubernetes Engine (GKE) vor. Diese Updates zielen darauf ab, Plattformteams und Entwickler zu befähigen, KI zu nutzen, während sie ihre bestehenden Kubernetes-Kenntnisse einsetzen. Gabe Monroy, Googles VP of Cloud Runtimes, brachte es prägnant auf den Punkt: „Ihre Kubernetes-Fähigkeiten und Investitionen sind nicht nur relevant; sie sind Ihre KI-Superkraft.“

Also, was genau sind diese neuen Fortschritte? Lassen Sie uns in die Details eintauchen.

Vereinfachtes KI-Cluster-Management: GKE führt ein vereinfachtes KI-Cluster-Management durch Tools wie Cluster Director für GKE ein, früher bekannt als Hypercompute Cluster. Dieses Tool ermöglicht es Nutzern, große Cluster von virtuellen Maschinen (VMs) mit angeschlossenen Nvidia-GPUs bereitzustellen und zu verwalten, was das Skalieren von KI-Workloads effizienter macht.

Ein damit verbundener, bald verfügbarer Dienst ist Cluster Director für Slurm. Slurm, ein Open-Source-Job-Scheduler und Workload-Manager für Linux, wird dank Googles vereinfachter Benutzeroberfläche und APIs einfacher bereitzustellen und zu betreiben sein. Diese werden Blaupausen für typische Workloads mit vorkonfigurierten Softwarepaketen enthalten, die zuverlässige und wiederholbare Bereitstellungen gewährleisten.

Optimiertes KI-Modell-Deployment: Die neuen Funktionen von GKE konzentrieren sich auch auf die Optimierung des KI-Modell-Deployments. Der GKE Inference Quickstart und das GKE Inference Gateway vereinfachen die Auswahl und Bereitstellung von KI-Modellen und gewährleisten eine gute Leistung durch intelligentes Lastenausgleich.

Gabe Monroy hob den Trend der KI-Innovation hervor, die mit traditioneller Rechenleistung, insbesondere im Bereich der Inferenz, zusammenfällt. Er bemerkte: „Wir sehen einen klaren Trend im Zeitalter der KI: erstaunliche Innovationen finden dort statt, wo traditionelle Rechenleistung mit neuronalen Netzen interagiert – auch bekannt als ‚Inferenz‘. Unternehmen, die an der Spitze von Kubernetes und KI operieren, wie LiveX und Moloco, betreiben KI-Inferenz auf GKE.“

Kosteneffiziente Inferenz: GKE macht Fortschritte bei der kosteneffizienten Inferenz mit dem Inference Gateway. Monroy behauptet, dass dieser Ansatz die Bereitstellungskosten um bis zu 30 % senken, die Latenz um bis zu 60 % reduzieren und den Durchsatz im Vergleich zu anderen verwalteten und Open-Source-Kubernetes-Angeboten um 40 % steigern kann. Während dies vielversprechende Zahlen sind, müssen wir sie in Aktion sehen, um ihre Wirkung zu bestätigen.

Modellbewusster Lastenausgleich ist ein zentraler Bestandteil dieser Strategie. Angesichts der variablen Antwortlängen in KI-Modellen können traditionelle Lastenausgleichsmethoden wie Round-Robin ineffizient sein. Das Inference Gateway bietet jedoch ein modellbewusstes Gateway, das für KI optimiert ist, mit fortschrittlichem Routing zu verschiedenen Modellversionen.

Verbesserte Ressourceneffizienz: GKE konzentriert sich auch auf die Verbesserung der Ressourceneffizienz. Der GKE Autopilot bietet jetzt schnellere Pod-Planung, kürzere Skalierungsreaktionszeiten und eine bessere Kapazitätsanpassung. Dies bedeutet, dass Nutzer mehr Traffic mit denselben Ressourcen bewältigen oder den bestehenden Traffic mit weniger Ressourcen aufrechterhalten können. Google behauptet, dass mit dem verbesserten Autopilot die Clusterkapazität immer richtig dimensioniert sein wird.

Derzeit umfasst Autopilot ein Best-Practice-Clusterkonfigurationstool und eine containeroptimierte Rechenplattform, die die Kapazität automatisch an die Workloads anpasst. Allerdings dimensioniert es bestehende Cluster nicht ohne spezifische Konfiguration richtig. Ab dem dritten Quartal wird die containeroptimierte Rechenplattform von Autopilot auch für Standard-GKE-Cluster ohne spezifische Konfiguration verfügbar sein, was bahnbrechend sein könnte.

KI-gestütztes Gemini Cloud Assist: Das Debuggen und Diagnostizieren von Anwendungsproblemen kann Innovationen erheblich verlangsamen. Um dem entgegenzuwirken, hat Google Gemini Cloud Assist eingeführt, das KI-gestützte Unterstützung während des gesamten Anwendungslebenszyklus bietet. Die private Vorschau von Gemini Cloud Assist Investigations hilft Nutzern, Ursachen schnell zu verstehen und Probleme zu lösen.

Das Beste daran? Assist Investigations wird direkt über die GKE-Konsole zugänglich sein, wodurch die Fehlerbehebungszeit reduziert und mehr Zeit für Innovationen freigesetzt wird. Es ermöglicht die Diagnose von Pod- und Clusterproblemen über die GKE-Konsole hinweg für verschiedene Google Cloud-Dienste, einschließlich Knoten, IAM und Lastenausgleicher. Sie können Protokolle und Fehler über mehrere GKE-Dienste, Controller, Pods und zugrunde liegende Knoten hinweg anzeigen. Melden Sie sich für die private Vorschau an, um diese Funktion aus erster Hand zu erleben.

Als Teil seiner umfassenderen Strategie für aufstrebende Technologien positioniert sich Google als führend bei KI-optimierten Plattformen. Diese Entwicklungen ermöglichen es Unternehmen in verschiedenen Branchen, KI effektiver einzusetzen und Innovation sowie Effizienz in Betrieb und Kundenerfahrungen zu fördern.

Zum Beispiel nutzt Intuit Google Clouds Document AI und Gemini, um die Steuervorbereitung für Millionen von TurboTax-Nutzern zu vereinfachen. Reddit verwendet Gemini über Vertex AI, Googles KI-Agenten-Builder, um Reddit Answers zu verbessern, eine neue KI-gestützte Konversationsplattform, die das Erlebnis auf der Homepage verbessern soll.

Kann Google diese KI-gestützten Transformationen erfolgreich umsetzen? Das wird die Zeit zeigen. Wie Pichai im Dezember sagte: „In der Geschichte muss man nicht immer der Erste sein, aber man muss gut ausführen und wirklich der Beste in seiner Klasse als Produkt sein. Ich denke, darum geht es im Jahr 2025.“

Verwandter Artikel

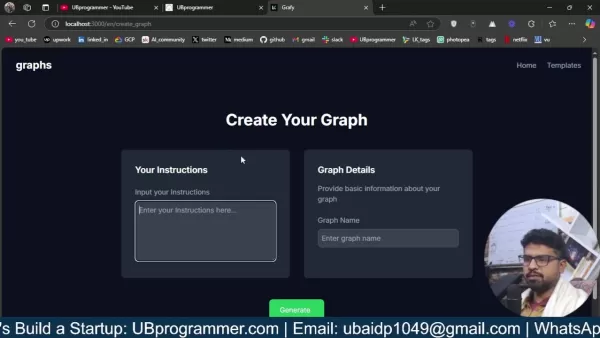

Einfaches Generieren von KI-gestützten Grafiken und Visualisierungen für bessere Dateneinblicke

Die moderne Datenanalyse erfordert eine intuitive Visualisierung komplexer Informationen. KI-gestützte Lösungen zur Diagrammerstellung haben sich als unverzichtbare Hilfsmittel erwiesen und revolution

Einfaches Generieren von KI-gestützten Grafiken und Visualisierungen für bessere Dateneinblicke

Die moderne Datenanalyse erfordert eine intuitive Visualisierung komplexer Informationen. KI-gestützte Lösungen zur Diagrammerstellung haben sich als unverzichtbare Hilfsmittel erwiesen und revolution

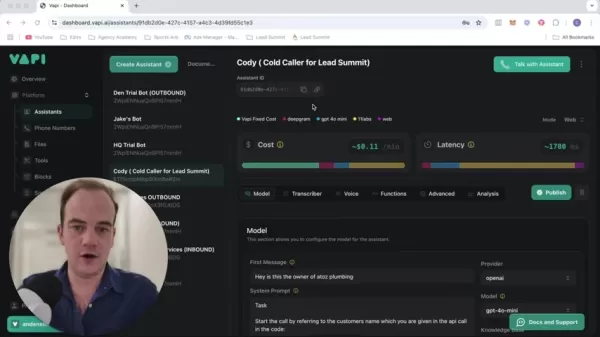

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Kommentare (47)

0/200

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Kommentare (47)

0/200

![MatthewScott]() MatthewScott

MatthewScott

1. Oktober 2025 22:30:35 MESZ

1. Oktober 2025 22:30:35 MESZ

Interesante ver cómo Google sigue integrando Kubernetes con IA 🚀. Pero me pregunto, ¿estas mejoras realmente simplificarán la vida de los desarrolladores o solo añadirán más complejidad? Ojalá incluyan buenos tutoriales para principiantes.

0

0

![JohnGarcia]() JohnGarcia

JohnGarcia

14. September 2025 22:30:38 MESZ

14. September 2025 22:30:38 MESZ

Los avances de Google en Kubernetes y GKE para IA suenan prometedores, pero ¿realmente simplificarán el trabajo de los desarrolladores o solo agregarán más capas de complejidad? 🤔 A veces siento que estas actualizaciones son más para el marketing que para solucionar problemas reales.

0

0

![JasonHarris]() JasonHarris

JasonHarris

22. April 2025 11:46:09 MESZ

22. April 2025 11:46:09 MESZ

Google's Kubernetes and GKE updates for AI are pretty cool! They're really stepping up their game in AI innovation. It's awesome to see them focusing on solving real user problems. Can't wait to see what they come up with next! 🚀

0

0

![RaymondRodriguez]() RaymondRodriguez

RaymondRodriguez

22. April 2025 06:59:07 MESZ

22. April 2025 06:59:07 MESZ

Las actualizaciones de Google para Kubernetes y GKE enfocadas en IA son bastante geniales. Realmente están subiendo el nivel en la innovación de IA. Es genial verlos enfocados en resolver problemas reales de los usuarios. ¡No puedo esperar a ver qué vendrá después! 🚀

0

0

![HarryLewis]() HarryLewis

HarryLewis

21. April 2025 04:25:32 MESZ

21. April 2025 04:25:32 MESZ

구글의 쿠버네티스와 GKE의 AI 관련 업데이트 정말 멋지네요! AI 혁신에 정말 열심히 하고 있는 것 같아요. 사용자의 문제를 해결하는 데 집중하는 것도 훌륭해요. 다음에 어떤 것이 나올지 기대돼요! 🚀

0

0

![StevenNelson]() StevenNelson

StevenNelson

20. April 2025 09:39:43 MESZ

20. April 2025 09:39:43 MESZ

GoogleのKubernetesとGKEの強化はAIイノベーションにはすごいけど、ちょっと難しすぎるかな。😅 ユーザーの問題を解決しようとする努力は評価するけど、もっとユーザーフレンドリーな説明が欲しいな。でも、AIとテクノロジーに興味があるなら、チェックする価値はあるよ!👀

0

0

Googles Vorstoß in die KI ist kein Geheimnis, und das aus gutem Grund. Wie CEO Sundar Pichai in einem internen Treffen vor den Feiertagen des letzten Jahres betonte: „Im Jahr 2025 müssen wir uns unermüdlich darauf konzentrieren, die Vorteile der [KI]-Technologie freizusetzen und echte Nutzerprobleme zu lösen.“ Diese Vision treibt Google dazu an, seine Angebote erheblich zu verbessern, insbesondere in den Bereichen Cloud-Dienste und KI-Integration.

Beim Google Cloud Next 2025-Event in Las Vegas stellte Google bedeutende Fortschritte bei Kubernetes und Google Kubernetes Engine (GKE) vor. Diese Updates zielen darauf ab, Plattformteams und Entwickler zu befähigen, KI zu nutzen, während sie ihre bestehenden Kubernetes-Kenntnisse einsetzen. Gabe Monroy, Googles VP of Cloud Runtimes, brachte es prägnant auf den Punkt: „Ihre Kubernetes-Fähigkeiten und Investitionen sind nicht nur relevant; sie sind Ihre KI-Superkraft.“

Also, was genau sind diese neuen Fortschritte? Lassen Sie uns in die Details eintauchen.

Vereinfachtes KI-Cluster-Management: GKE führt ein vereinfachtes KI-Cluster-Management durch Tools wie Cluster Director für GKE ein, früher bekannt als Hypercompute Cluster. Dieses Tool ermöglicht es Nutzern, große Cluster von virtuellen Maschinen (VMs) mit angeschlossenen Nvidia-GPUs bereitzustellen und zu verwalten, was das Skalieren von KI-Workloads effizienter macht.

Ein damit verbundener, bald verfügbarer Dienst ist Cluster Director für Slurm. Slurm, ein Open-Source-Job-Scheduler und Workload-Manager für Linux, wird dank Googles vereinfachter Benutzeroberfläche und APIs einfacher bereitzustellen und zu betreiben sein. Diese werden Blaupausen für typische Workloads mit vorkonfigurierten Softwarepaketen enthalten, die zuverlässige und wiederholbare Bereitstellungen gewährleisten.

Optimiertes KI-Modell-Deployment: Die neuen Funktionen von GKE konzentrieren sich auch auf die Optimierung des KI-Modell-Deployments. Der GKE Inference Quickstart und das GKE Inference Gateway vereinfachen die Auswahl und Bereitstellung von KI-Modellen und gewährleisten eine gute Leistung durch intelligentes Lastenausgleich.

Gabe Monroy hob den Trend der KI-Innovation hervor, die mit traditioneller Rechenleistung, insbesondere im Bereich der Inferenz, zusammenfällt. Er bemerkte: „Wir sehen einen klaren Trend im Zeitalter der KI: erstaunliche Innovationen finden dort statt, wo traditionelle Rechenleistung mit neuronalen Netzen interagiert – auch bekannt als ‚Inferenz‘. Unternehmen, die an der Spitze von Kubernetes und KI operieren, wie LiveX und Moloco, betreiben KI-Inferenz auf GKE.“

Kosteneffiziente Inferenz: GKE macht Fortschritte bei der kosteneffizienten Inferenz mit dem Inference Gateway. Monroy behauptet, dass dieser Ansatz die Bereitstellungskosten um bis zu 30 % senken, die Latenz um bis zu 60 % reduzieren und den Durchsatz im Vergleich zu anderen verwalteten und Open-Source-Kubernetes-Angeboten um 40 % steigern kann. Während dies vielversprechende Zahlen sind, müssen wir sie in Aktion sehen, um ihre Wirkung zu bestätigen.

Modellbewusster Lastenausgleich ist ein zentraler Bestandteil dieser Strategie. Angesichts der variablen Antwortlängen in KI-Modellen können traditionelle Lastenausgleichsmethoden wie Round-Robin ineffizient sein. Das Inference Gateway bietet jedoch ein modellbewusstes Gateway, das für KI optimiert ist, mit fortschrittlichem Routing zu verschiedenen Modellversionen.

Verbesserte Ressourceneffizienz: GKE konzentriert sich auch auf die Verbesserung der Ressourceneffizienz. Der GKE Autopilot bietet jetzt schnellere Pod-Planung, kürzere Skalierungsreaktionszeiten und eine bessere Kapazitätsanpassung. Dies bedeutet, dass Nutzer mehr Traffic mit denselben Ressourcen bewältigen oder den bestehenden Traffic mit weniger Ressourcen aufrechterhalten können. Google behauptet, dass mit dem verbesserten Autopilot die Clusterkapazität immer richtig dimensioniert sein wird.

Derzeit umfasst Autopilot ein Best-Practice-Clusterkonfigurationstool und eine containeroptimierte Rechenplattform, die die Kapazität automatisch an die Workloads anpasst. Allerdings dimensioniert es bestehende Cluster nicht ohne spezifische Konfiguration richtig. Ab dem dritten Quartal wird die containeroptimierte Rechenplattform von Autopilot auch für Standard-GKE-Cluster ohne spezifische Konfiguration verfügbar sein, was bahnbrechend sein könnte.

KI-gestütztes Gemini Cloud Assist: Das Debuggen und Diagnostizieren von Anwendungsproblemen kann Innovationen erheblich verlangsamen. Um dem entgegenzuwirken, hat Google Gemini Cloud Assist eingeführt, das KI-gestützte Unterstützung während des gesamten Anwendungslebenszyklus bietet. Die private Vorschau von Gemini Cloud Assist Investigations hilft Nutzern, Ursachen schnell zu verstehen und Probleme zu lösen.

Das Beste daran? Assist Investigations wird direkt über die GKE-Konsole zugänglich sein, wodurch die Fehlerbehebungszeit reduziert und mehr Zeit für Innovationen freigesetzt wird. Es ermöglicht die Diagnose von Pod- und Clusterproblemen über die GKE-Konsole hinweg für verschiedene Google Cloud-Dienste, einschließlich Knoten, IAM und Lastenausgleicher. Sie können Protokolle und Fehler über mehrere GKE-Dienste, Controller, Pods und zugrunde liegende Knoten hinweg anzeigen. Melden Sie sich für die private Vorschau an, um diese Funktion aus erster Hand zu erleben.

Als Teil seiner umfassenderen Strategie für aufstrebende Technologien positioniert sich Google als führend bei KI-optimierten Plattformen. Diese Entwicklungen ermöglichen es Unternehmen in verschiedenen Branchen, KI effektiver einzusetzen und Innovation sowie Effizienz in Betrieb und Kundenerfahrungen zu fördern.

Zum Beispiel nutzt Intuit Google Clouds Document AI und Gemini, um die Steuervorbereitung für Millionen von TurboTax-Nutzern zu vereinfachen. Reddit verwendet Gemini über Vertex AI, Googles KI-Agenten-Builder, um Reddit Answers zu verbessern, eine neue KI-gestützte Konversationsplattform, die das Erlebnis auf der Homepage verbessern soll.

Kann Google diese KI-gestützten Transformationen erfolgreich umsetzen? Das wird die Zeit zeigen. Wie Pichai im Dezember sagte: „In der Geschichte muss man nicht immer der Erste sein, aber man muss gut ausführen und wirklich der Beste in seiner Klasse als Produkt sein. Ich denke, darum geht es im Jahr 2025.“

Einfaches Generieren von KI-gestützten Grafiken und Visualisierungen für bessere Dateneinblicke

Die moderne Datenanalyse erfordert eine intuitive Visualisierung komplexer Informationen. KI-gestützte Lösungen zur Diagrammerstellung haben sich als unverzichtbare Hilfsmittel erwiesen und revolution

Einfaches Generieren von KI-gestützten Grafiken und Visualisierungen für bessere Dateneinblicke

Die moderne Datenanalyse erfordert eine intuitive Visualisierung komplexer Informationen. KI-gestützte Lösungen zur Diagrammerstellung haben sich als unverzichtbare Hilfsmittel erwiesen und revolution

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

1. Oktober 2025 22:30:35 MESZ

1. Oktober 2025 22:30:35 MESZ

Interesante ver cómo Google sigue integrando Kubernetes con IA 🚀. Pero me pregunto, ¿estas mejoras realmente simplificarán la vida de los desarrolladores o solo añadirán más complejidad? Ojalá incluyan buenos tutoriales para principiantes.

0

0

14. September 2025 22:30:38 MESZ

14. September 2025 22:30:38 MESZ

Los avances de Google en Kubernetes y GKE para IA suenan prometedores, pero ¿realmente simplificarán el trabajo de los desarrolladores o solo agregarán más capas de complejidad? 🤔 A veces siento que estas actualizaciones son más para el marketing que para solucionar problemas reales.

0

0

22. April 2025 11:46:09 MESZ

22. April 2025 11:46:09 MESZ

Google's Kubernetes and GKE updates for AI are pretty cool! They're really stepping up their game in AI innovation. It's awesome to see them focusing on solving real user problems. Can't wait to see what they come up with next! 🚀

0

0

22. April 2025 06:59:07 MESZ

22. April 2025 06:59:07 MESZ

Las actualizaciones de Google para Kubernetes y GKE enfocadas en IA son bastante geniales. Realmente están subiendo el nivel en la innovación de IA. Es genial verlos enfocados en resolver problemas reales de los usuarios. ¡No puedo esperar a ver qué vendrá después! 🚀

0

0

21. April 2025 04:25:32 MESZ

21. April 2025 04:25:32 MESZ

구글의 쿠버네티스와 GKE의 AI 관련 업데이트 정말 멋지네요! AI 혁신에 정말 열심히 하고 있는 것 같아요. 사용자의 문제를 해결하는 데 집중하는 것도 훌륭해요. 다음에 어떤 것이 나올지 기대돼요! 🚀

0

0

20. April 2025 09:39:43 MESZ

20. April 2025 09:39:43 MESZ

GoogleのKubernetesとGKEの強化はAIイノベーションにはすごいけど、ちょっと難しすぎるかな。😅 ユーザーの問題を解決しようとする努力は評価するけど、もっとユーザーフレンドリーな説明が欲しいな。でも、AIとテクノロジーに興味があるなら、チェックする価値はあるよ!👀

0

0