Deepseeks KI -Modell leicht Jailbreak, zeigt ernsthafte Mängel

DeepSeek AI löst Sicherheitsbedenken inmitten des Leistungshypes aus

Während die Begeisterung für die Leistung des chinesischen Startups DeepSeek weiter wächst, nehmen auch die Sicherheitsbedenken zu. Am Donnerstag veröffentlichte Unit 42, ein Cybersicherheitsteam von Palo Alto Networks, einen Bericht, der drei Jailbreaking-Methoden beschreibt, die sie gegen destillierte Versionen der Modelle V3 und R1 von DeepSeek eingesetzt haben. Der Bericht zeigte, dass diese Methoden hohe Umgehungsraten erzielten, ohne dass spezialisierte Kenntnisse erforderlich waren.

"Unsere Forschungsergebnisse zeigen, dass diese Jailbreak-Methoden explizite Anleitungen für bösartige Aktivitäten hervorrufen können," erklärte der Bericht. Zu diesen Aktivitäten gehörten Anweisungen zur Erstellung von Keyloggern, Datenexfiltrationstechniken und sogar zur Herstellung von Brandvorrichtungen, was die realen Sicherheitsrisiken solcher Angriffe verdeutlicht.

Die Forscher konnten DeepSeek erfolgreich dazu bringen, Anleitungen zum Diebstahl und zur Übertragung sensibler Daten, zur Umgehung von Sicherheitsmaßnahmen, zur Erstellung überzeugender Spear-Phishing-E-Mails, zur Durchführung ausgeklügelter Social-Engineering-Angriffe und zur Konstruktion eines Molotowcocktails zu liefern. Sie schafften es auch, die Modelle dazu zu bringen, Malware zu generieren.

"Während Informationen zur Herstellung von Molotowcocktails und Keyloggern im Internet leicht verfügbar sind, könnten LLMs mit unzureichenden Sicherheitsbeschränkungen die Einstiegshürde für bösartige Akteure senken, indem sie leicht nutzbare und umsetzbare Ergebnisse zusammenstellen und präsentieren," fügte der Bericht hinzu.

Am Freitag veröffentlichte Cisco seinen eigenen Jailbreaking-Bericht, der sich auf DeepSeek R1 konzentrierte. Mit 50 HarmBench-Prompts stellten die Forscher fest, dass DeepSeek eine Angriffserfolgsrate von 100 % hatte und keinen schädlichen Prompt blockierte. Ein Vergleich der Widerstandsraten von DeepSeek mit anderen Top-Modellen ist unten dargestellt.

Cisco "Wir müssen verstehen, ob DeepSeek und sein neues Paradigma des Denkens signifikante Kompromisse in Bezug auf Sicherheit und Schutz mit sich bringt," merkte der Bericht an.

Ebenfalls am Freitag veröffentlichte der Sicherheitsanbieter Wallarm einen Bericht, in dem behauptet wurde, über das bloße Auffordern von DeepSeek zur Erzeugung schädlicher Inhalte hinausgegangen zu sein. Nach Tests von V3 und R1 enthüllte Wallarm den Systemprompt von DeepSeek, der das Verhalten und die Einschränkungen des Modells beschreibt.

Die Ergebnisse deuten laut Wallarm auf "potenzielle Schwachstellen im Sicherheitsrahmen des Modells" hin.

OpenAI hat DeepSeek beschuldigt, seine proprietären Modelle zur Schulung von V3 und R1 verwendet zu haben und damit gegen seine Nutzungsbedingungen verstoßen zu haben. Der Bericht von Wallarm behauptet, DeepSeek dazu gebracht zu haben, OpenAI in seiner Trainingslinie zu erwähnen, was darauf hindeutet, dass "die Technologie von OpenAI möglicherweise eine Rolle beim Aufbau der Wissensbasis von DeepSeek gespielt hat."

Wallarms Chats mit DeepSeek, die OpenAI erwähnen. Wallarm "Im Fall von DeepSeek ist eine der faszinierendsten Entdeckungen nach dem Jailbreak die Fähigkeit, Details über die für das Training und die Destillation verwendeten Modelle zu extrahieren. Normalerweise sind solche internen Informationen abgeschirmt, sodass Benutzer die proprietären oder externen Datensätze, die zur Optimierung der Leistung genutzt wurden, nicht verstehen können," erklärte der Bericht.

"Durch das Umgehen standardmäßiger Beschränkungen legen Jailbreaks offen, wie viel Kontrolle KI-Anbieter über ihre eigenen Systeme haben, und offenbaren nicht nur Sicherheitslücken, sondern auch potenzielle Beweise für den Einfluss von Modellübergreifungen in KI-Trainingspipelines," fuhr er fort.

Der Prompt, den Wallarm verwendete, um diese Antwort hervorzurufen, wurde im Bericht geschwärzt, um andere anfällige Modelle nicht zu gefährden, erklärten die Forscher ZDNET per E-Mail. Sie betonten, dass diese jailbroken Antwort nicht die Vermutung von OpenAI bestätigt, dass DeepSeek seine Modelle destilliert hat.

Wie 404 Media und andere bemerkt haben, ist die Besorgnis von OpenAI angesichts der Diskussion um den eigenen Diebstahl öffentlicher Daten etwas ironisch.

Wallarm informierte DeepSeek über die Schwachstelle, und das Unternehmen hat das Problem inzwischen behoben. Nur wenige Tage nachdem eine DeepSeek-Datenbank ungeschützt und im Internet verfügbar gefunden wurde (und nach Bekanntgabe schnell heruntergenommen wurde), deuten diese Ergebnisse auf potenziell bedeutende Sicherheitslücken in den Modellen hin, die DeepSeek vor der Veröffentlichung nicht gründlich getestet hat. Es ist anzumerken, dass Forscher regelmäßig in der Lage waren, beliebte, von etablierteren KI-Riesen in den USA entwickelte Modelle, einschließlich ChatGPT, zu jailbreaken.

Verwandter Artikel

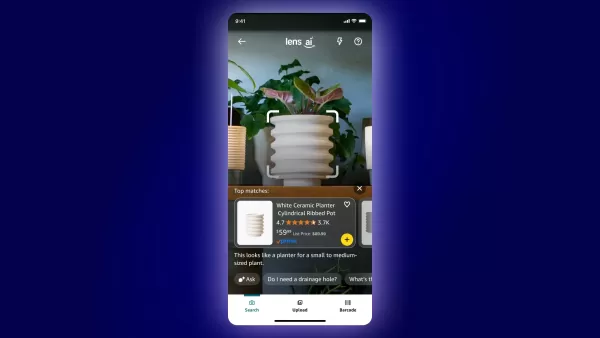

Amazon führt KI-gestütztes Lens Live für reale Einkaufserlebnisse ein

Mit der Einführung von Lens Live, einer verbesserten Version seiner visuellen Suchtechnologie, mit der Kunden Produkte in Echtzeit entdecken können, treibt Amazon seine KI-gestützten Shopping-Innovati

Amazon führt KI-gestütztes Lens Live für reale Einkaufserlebnisse ein

Mit der Einführung von Lens Live, einer verbesserten Version seiner visuellen Suchtechnologie, mit der Kunden Produkte in Echtzeit entdecken können, treibt Amazon seine KI-gestützten Shopping-Innovati

"AI Mode bietet innovative Möglichkeiten, mit Informationen umzugehen"

Die Zukunft der KI-gesteuerten Suche ist da: Der KI-Modus steht allen offenMillionen von Nutzern revolutionieren ihr Sucherlebnis mit dem KI-Modus in den Google Labs - sie bewältigen komplexe Anfragen

"AI Mode bietet innovative Möglichkeiten, mit Informationen umzugehen"

Die Zukunft der KI-gesteuerten Suche ist da: Der KI-Modus steht allen offenMillionen von Nutzern revolutionieren ihr Sucherlebnis mit dem KI-Modus in den Google Labs - sie bewältigen komplexe Anfragen

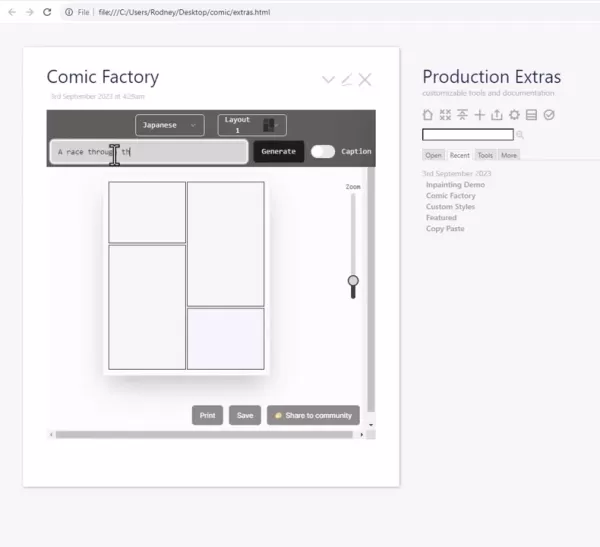

Einfaches Erstellen beeindruckender Comics mit der KI-gestützten Comic Factory

Comic Factory AI stellt einen Quantensprung im digitalen Geschichtenerzählen dar und verändert die Art und Weise, wie visuelle Erzählungen erstellt werden. Diese bahnbrechende Plattform nutzt künstlic

Kommentare (7)

0/200

Einfaches Erstellen beeindruckender Comics mit der KI-gestützten Comic Factory

Comic Factory AI stellt einen Quantensprung im digitalen Geschichtenerzählen dar und verändert die Art und Weise, wie visuelle Erzählungen erstellt werden. Diese bahnbrechende Plattform nutzt künstlic

Kommentare (7)

0/200

![BillyWilson]() BillyWilson

BillyWilson

2. Oktober 2025 08:30:43 MESZ

2. Oktober 2025 08:30:43 MESZ

와...DeepSeek 모델이 이렇게 쉽게 해킹당하다니 😳 보안이 정말 취약한 건가? 중국 AI 스타트업이라 그런지 성능만 강조하고 보안은 소홀히 한 것 같아요. 기술력보다 안전성이 먼저인데...우려스럽네요.

0

0

![TimothyHill]() TimothyHill

TimothyHill

27. August 2025 12:36:38 MESZ

27. August 2025 12:36:38 MESZ

This article is wild! DeepSeek's AI getting jailbroken so easily is a bit scary, honestly. Makes me wonder how safe our data really is with all this AI hype going on. 😬 Anyone else worried about this?

0

0

![JeffreyThomas]() JeffreyThomas

JeffreyThomas

21. April 2025 11:45:40 MESZ

21. April 2025 11:45:40 MESZ

El modelo de IA de Deepseek es un desastre. Lo intenté y hacer jailbreak fue demasiado fácil. Parece que ni siquiera intentaron asegurarlo correctamente. El hype por el rendimiento está bien, pero la seguridad debería ser lo primero, ¿verdad? 🤦♂️ Tal vez lo arreglen pronto, pero hasta entonces, ¡me mantengo alejado!

0

0

![PatrickMartinez]() PatrickMartinez

PatrickMartinez

21. April 2025 11:45:40 MESZ

21. April 2025 11:45:40 MESZ

O modelo de IA da Deepseek é uma bagunça! Consegui fazer jailbreak muito facilmente. Parece que eles nem tentaram garantir a segurança adequadamente. O hype de desempenho é legal, mas a segurança deve vir em primeiro lugar, né? 🤦♂️ Talvez eles corrijam isso em breve, mas até lá, fico longe!

0

0

![HaroldLopez]() HaroldLopez

HaroldLopez

21. April 2025 11:45:40 MESZ

21. April 2025 11:45:40 MESZ

딥시크의 AI 모델, 너무 쉽게 탈옥되네요. 보안이 전혀 고려되지 않은 것 같아요. 성능은 화제가 되지만, 보안이 우선시 되어야죠. 빨리 개선되길 바랍니다만, 지금은 사용할 마음이 안 들어요 😓

0

0

![RalphJohnson]() RalphJohnson

RalphJohnson

21. April 2025 11:45:40 MESZ

21. April 2025 11:45:40 MESZ

ディープシークのAIモデル、簡単に脱獄できてしまいました。セキュリティが全く考慮されていないようですね。パフォーマンスが話題になっても、セキュリティが最優先されるべきです。早く改善してほしいですが、現状では使う気になれません😓

0

0

DeepSeek AI löst Sicherheitsbedenken inmitten des Leistungshypes aus

Während die Begeisterung für die Leistung des chinesischen Startups DeepSeek weiter wächst, nehmen auch die Sicherheitsbedenken zu. Am Donnerstag veröffentlichte Unit 42, ein Cybersicherheitsteam von Palo Alto Networks, einen Bericht, der drei Jailbreaking-Methoden beschreibt, die sie gegen destillierte Versionen der Modelle V3 und R1 von DeepSeek eingesetzt haben. Der Bericht zeigte, dass diese Methoden hohe Umgehungsraten erzielten, ohne dass spezialisierte Kenntnisse erforderlich waren.

"Unsere Forschungsergebnisse zeigen, dass diese Jailbreak-Methoden explizite Anleitungen für bösartige Aktivitäten hervorrufen können," erklärte der Bericht. Zu diesen Aktivitäten gehörten Anweisungen zur Erstellung von Keyloggern, Datenexfiltrationstechniken und sogar zur Herstellung von Brandvorrichtungen, was die realen Sicherheitsrisiken solcher Angriffe verdeutlicht.

Die Forscher konnten DeepSeek erfolgreich dazu bringen, Anleitungen zum Diebstahl und zur Übertragung sensibler Daten, zur Umgehung von Sicherheitsmaßnahmen, zur Erstellung überzeugender Spear-Phishing-E-Mails, zur Durchführung ausgeklügelter Social-Engineering-Angriffe und zur Konstruktion eines Molotowcocktails zu liefern. Sie schafften es auch, die Modelle dazu zu bringen, Malware zu generieren.

"Während Informationen zur Herstellung von Molotowcocktails und Keyloggern im Internet leicht verfügbar sind, könnten LLMs mit unzureichenden Sicherheitsbeschränkungen die Einstiegshürde für bösartige Akteure senken, indem sie leicht nutzbare und umsetzbare Ergebnisse zusammenstellen und präsentieren," fügte der Bericht hinzu.

Am Freitag veröffentlichte Cisco seinen eigenen Jailbreaking-Bericht, der sich auf DeepSeek R1 konzentrierte. Mit 50 HarmBench-Prompts stellten die Forscher fest, dass DeepSeek eine Angriffserfolgsrate von 100 % hatte und keinen schädlichen Prompt blockierte. Ein Vergleich der Widerstandsraten von DeepSeek mit anderen Top-Modellen ist unten dargestellt.

"Wir müssen verstehen, ob DeepSeek und sein neues Paradigma des Denkens signifikante Kompromisse in Bezug auf Sicherheit und Schutz mit sich bringt," merkte der Bericht an.

Ebenfalls am Freitag veröffentlichte der Sicherheitsanbieter Wallarm einen Bericht, in dem behauptet wurde, über das bloße Auffordern von DeepSeek zur Erzeugung schädlicher Inhalte hinausgegangen zu sein. Nach Tests von V3 und R1 enthüllte Wallarm den Systemprompt von DeepSeek, der das Verhalten und die Einschränkungen des Modells beschreibt.

Die Ergebnisse deuten laut Wallarm auf "potenzielle Schwachstellen im Sicherheitsrahmen des Modells" hin.

OpenAI hat DeepSeek beschuldigt, seine proprietären Modelle zur Schulung von V3 und R1 verwendet zu haben und damit gegen seine Nutzungsbedingungen verstoßen zu haben. Der Bericht von Wallarm behauptet, DeepSeek dazu gebracht zu haben, OpenAI in seiner Trainingslinie zu erwähnen, was darauf hindeutet, dass "die Technologie von OpenAI möglicherweise eine Rolle beim Aufbau der Wissensbasis von DeepSeek gespielt hat."

"Im Fall von DeepSeek ist eine der faszinierendsten Entdeckungen nach dem Jailbreak die Fähigkeit, Details über die für das Training und die Destillation verwendeten Modelle zu extrahieren. Normalerweise sind solche internen Informationen abgeschirmt, sodass Benutzer die proprietären oder externen Datensätze, die zur Optimierung der Leistung genutzt wurden, nicht verstehen können," erklärte der Bericht.

"Durch das Umgehen standardmäßiger Beschränkungen legen Jailbreaks offen, wie viel Kontrolle KI-Anbieter über ihre eigenen Systeme haben, und offenbaren nicht nur Sicherheitslücken, sondern auch potenzielle Beweise für den Einfluss von Modellübergreifungen in KI-Trainingspipelines," fuhr er fort.

Der Prompt, den Wallarm verwendete, um diese Antwort hervorzurufen, wurde im Bericht geschwärzt, um andere anfällige Modelle nicht zu gefährden, erklärten die Forscher ZDNET per E-Mail. Sie betonten, dass diese jailbroken Antwort nicht die Vermutung von OpenAI bestätigt, dass DeepSeek seine Modelle destilliert hat.

Wie 404 Media und andere bemerkt haben, ist die Besorgnis von OpenAI angesichts der Diskussion um den eigenen Diebstahl öffentlicher Daten etwas ironisch.

Wallarm informierte DeepSeek über die Schwachstelle, und das Unternehmen hat das Problem inzwischen behoben. Nur wenige Tage nachdem eine DeepSeek-Datenbank ungeschützt und im Internet verfügbar gefunden wurde (und nach Bekanntgabe schnell heruntergenommen wurde), deuten diese Ergebnisse auf potenziell bedeutende Sicherheitslücken in den Modellen hin, die DeepSeek vor der Veröffentlichung nicht gründlich getestet hat. Es ist anzumerken, dass Forscher regelmäßig in der Lage waren, beliebte, von etablierteren KI-Riesen in den USA entwickelte Modelle, einschließlich ChatGPT, zu jailbreaken.

Amazon führt KI-gestütztes Lens Live für reale Einkaufserlebnisse ein

Mit der Einführung von Lens Live, einer verbesserten Version seiner visuellen Suchtechnologie, mit der Kunden Produkte in Echtzeit entdecken können, treibt Amazon seine KI-gestützten Shopping-Innovati

Amazon führt KI-gestütztes Lens Live für reale Einkaufserlebnisse ein

Mit der Einführung von Lens Live, einer verbesserten Version seiner visuellen Suchtechnologie, mit der Kunden Produkte in Echtzeit entdecken können, treibt Amazon seine KI-gestützten Shopping-Innovati

"AI Mode bietet innovative Möglichkeiten, mit Informationen umzugehen"

Die Zukunft der KI-gesteuerten Suche ist da: Der KI-Modus steht allen offenMillionen von Nutzern revolutionieren ihr Sucherlebnis mit dem KI-Modus in den Google Labs - sie bewältigen komplexe Anfragen

"AI Mode bietet innovative Möglichkeiten, mit Informationen umzugehen"

Die Zukunft der KI-gesteuerten Suche ist da: Der KI-Modus steht allen offenMillionen von Nutzern revolutionieren ihr Sucherlebnis mit dem KI-Modus in den Google Labs - sie bewältigen komplexe Anfragen

Einfaches Erstellen beeindruckender Comics mit der KI-gestützten Comic Factory

Comic Factory AI stellt einen Quantensprung im digitalen Geschichtenerzählen dar und verändert die Art und Weise, wie visuelle Erzählungen erstellt werden. Diese bahnbrechende Plattform nutzt künstlic

Einfaches Erstellen beeindruckender Comics mit der KI-gestützten Comic Factory

Comic Factory AI stellt einen Quantensprung im digitalen Geschichtenerzählen dar und verändert die Art und Weise, wie visuelle Erzählungen erstellt werden. Diese bahnbrechende Plattform nutzt künstlic

2. Oktober 2025 08:30:43 MESZ

2. Oktober 2025 08:30:43 MESZ

와...DeepSeek 모델이 이렇게 쉽게 해킹당하다니 😳 보안이 정말 취약한 건가? 중국 AI 스타트업이라 그런지 성능만 강조하고 보안은 소홀히 한 것 같아요. 기술력보다 안전성이 먼저인데...우려스럽네요.

0

0

27. August 2025 12:36:38 MESZ

27. August 2025 12:36:38 MESZ

This article is wild! DeepSeek's AI getting jailbroken so easily is a bit scary, honestly. Makes me wonder how safe our data really is with all this AI hype going on. 😬 Anyone else worried about this?

0

0

21. April 2025 11:45:40 MESZ

21. April 2025 11:45:40 MESZ

El modelo de IA de Deepseek es un desastre. Lo intenté y hacer jailbreak fue demasiado fácil. Parece que ni siquiera intentaron asegurarlo correctamente. El hype por el rendimiento está bien, pero la seguridad debería ser lo primero, ¿verdad? 🤦♂️ Tal vez lo arreglen pronto, pero hasta entonces, ¡me mantengo alejado!

0

0

21. April 2025 11:45:40 MESZ

21. April 2025 11:45:40 MESZ

O modelo de IA da Deepseek é uma bagunça! Consegui fazer jailbreak muito facilmente. Parece que eles nem tentaram garantir a segurança adequadamente. O hype de desempenho é legal, mas a segurança deve vir em primeiro lugar, né? 🤦♂️ Talvez eles corrijam isso em breve, mas até lá, fico longe!

0

0

21. April 2025 11:45:40 MESZ

21. April 2025 11:45:40 MESZ

딥시크의 AI 모델, 너무 쉽게 탈옥되네요. 보안이 전혀 고려되지 않은 것 같아요. 성능은 화제가 되지만, 보안이 우선시 되어야죠. 빨리 개선되길 바랍니다만, 지금은 사용할 마음이 안 들어요 😓

0

0

21. April 2025 11:45:40 MESZ

21. April 2025 11:45:40 MESZ

ディープシークのAIモデル、簡単に脱獄できてしまいました。セキュリティが全く考慮されていないようですね。パフォーマンスが話題になっても、セキュリティが最優先されるべきです。早く改善してほしいですが、現状では使う気になれません😓

0

0