Модель AI DeepSeek легко взломана, раскрывает серьезные недостатки

DeepSeek AI вызывает опасения по поводу безопасности на фоне ажиотажа вокруг производительности

По мере роста интереса к производительности китайского стартапа DeepSeek растут и опасения по поводу безопасности. В четверг команда по кибербезопасности Unit 42 из Palo Alto Networks опубликовала отчет, в котором описала три метода взлома, примененные против дистиллированных версий моделей DeepSeek V3 и R1. В отчете указано, что эти методы обеспечили высокий уровень обхода защиты без необходимости специальных знаний.

«Наши исследования показывают, что эти методы взлома могут предоставить явные инструкции для вредоносных действий», — говорится в отчете. Эти действия включали инструкции по созданию кейлоггеров, техник эксфильтрации данных и даже инструкции по изготовлению зажигательных устройств, подчеркивая реальные риски безопасности, создаваемые такими атаками.

Исследователям удалось заставить DeepSeek предоставить инструкции по краже и передаче конфиденциальных данных, обходу мер безопасности, созданию убедительных фишинговых писем, выполнению сложных атак социальной инженерии и изготовлению коктейля Молотова. Им также удалось манипулировать моделями для генерации вредоносного ПО.

«Хотя информация о создании коктейлей Молотова и кейлоггеров легко доступна в интернете, большие языковые модели с недостаточными ограничениями безопасности могут снизить барьер для злоумышленников, предоставляя легко используемый и действенный результат», — добавлено в документе.

В пятницу Cisco опубликовала собственный отчет о взломе, нацеленном на DeepSeek R1. Используя 50 запросов HarmBench, исследователи обнаружили, что DeepSeek показал 100%-ный успех атак, не заблокировав ни одного вредоносного запроса. Сравнение устойчивости DeepSeek с другими ведущими моделями показано ниже.

Cisco «Мы должны понять, есть ли у DeepSeek и его новой парадигмы рассуждений значительные компромиссы в плане безопасности», — отмечено в отчете.

Также в пятницу компания по обеспечению безопасности Wallarm опубликовала отчет, в котором утверждала, что пошла дальше простого побуждения DeepSeek генерировать вредоносный контент. После тестирования V3 и R1 Wallarm раскрыла системный запрос DeepSeek, который описывает поведение и ограничения модели.

Выводы указывают на «потенциальные уязвимости в структуре безопасности модели», согласно Wallarm.

OpenAI обвинила DeepSeek в использовании своих проприетарных моделей для обучения V3 и R1, нарушая тем самым условия обслуживания. Отчет Wallarm утверждает, что удалось заставить DeepSeek упомянуть OpenAI в своей цепочке обучения, предполагая, что «технология OpenAI могла сыграть роль в формировании базы знаний DeepSeek».

Чаты Wallarm с DeepSeek, в которых упоминается OpenAI. Wallarm «В случае с DeepSeek одной из самых интригующих находок после взлома является возможность извлечения деталей о моделях, использованных для обучения и дистилляции. Обычно такая внутренняя информация защищена, не позволяя пользователям понять, какие проприетарные или внешние наборы данных использовались для оптимизации производительности», — поясняется в отчете.

«Обходя стандартные ограничения, взломы показывают, насколько тщательно провайдеры AI контролируют свои системы, выявляя не только уязвимости безопасности, но и потенциальные доказательства влияния одной модели на другую в цепочках обучения AI», — продолжено в отчете.

Запрос, использованный Wallarm для получения этого ответа, был отредактирован в отчете, чтобы избежать компрометации других уязвимых моделей, сообщили исследователи ZDNET по электронной почте. Они подчеркнули, что этот взломанный ответ не подтверждает подозрения OpenAI о том, что DeepSeek дистиллировал свои модели.

Как отметили 404 Media и другие, обеспокоенность OpenAI несколько иронична, учитывая дискуссии о ее собственном хищении общедоступных данных.

Wallarm сообщила DeepSeek об уязвимости, и компания с тех пор устранила проблему. Однако всего через несколько дней после того, как база данных DeepSeek была обнаружена незащищенной и доступной в интернете (и была быстро удалена после уведомления), эти находки указывают на потенциально значительные пробелы в безопасности моделей, которые DeepSeek не тщательно протестировал перед выпуском. Стоит отметить, что исследователям часто удавалось взламывать популярные модели, созданные в США, от более известных гигантов AI, включая ChatGPT.

Связанная статья

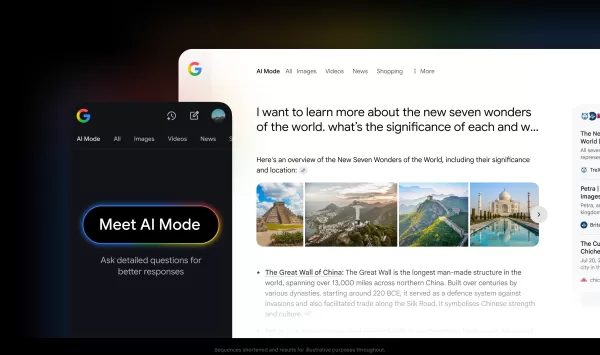

Поиск Google расширяет режим интеллектуального искусственного интеллекта по всему миру

Google выводит свой поисковый сервис на основе искусственного интеллекта еще в 180 стран, значительно расширив его возможности по сравнению с первоначальным внедрением в США, Великобритании и Индии. Н

Поиск Google расширяет режим интеллектуального искусственного интеллекта по всему миру

Google выводит свой поисковый сервис на основе искусственного интеллекта еще в 180 стран, значительно расширив его возможности по сравнению с первоначальным внедрением в США, Великобритании и Индии. Н

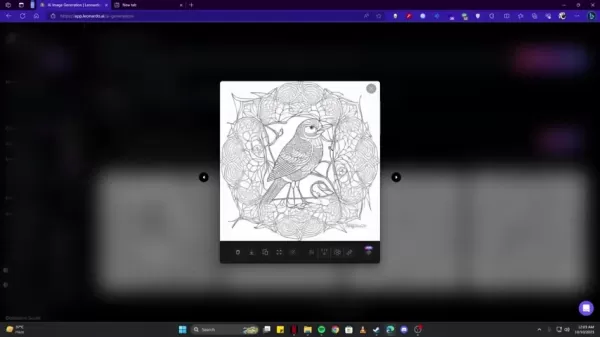

Пошаговое руководство по созданию книг-раскрасок Amazon с помощью искусственного интеллекта Leonardo AI

Мечтаете пробиться на процветающий книжный рынок Amazon? Книжки-раскраски предлагают фантастическую возможность пассивного дохода, но найти оригинальные иллюстрации может быть непросто. В этом подробн

Пошаговое руководство по созданию книг-раскрасок Amazon с помощью искусственного интеллекта Leonardo AI

Мечтаете пробиться на процветающий книжный рынок Amazon? Книжки-раскраски предлагают фантастическую возможность пассивного дохода, но найти оригинальные иллюстрации может быть непросто. В этом подробн

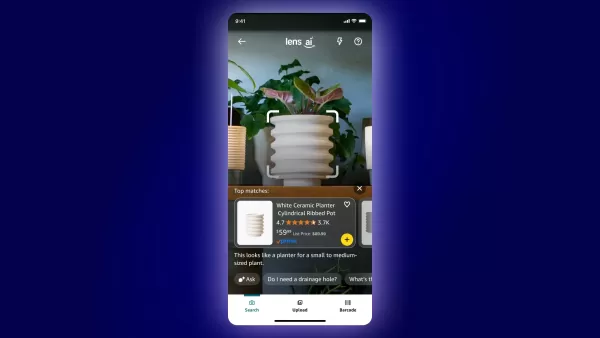

Amazon представляет Lens Live с искусственным интеллектом для совершения покупок в реальном мире

Amazon продолжает развивать инновации в сфере покупок на основе искусственного интеллекта, представив во вторник Lens Live - улучшенную версию технологии визуального поиска, которая позволяет покупате

Комментарии (7)

Amazon представляет Lens Live с искусственным интеллектом для совершения покупок в реальном мире

Amazon продолжает развивать инновации в сфере покупок на основе искусственного интеллекта, представив во вторник Lens Live - улучшенную версию технологии визуального поиска, которая позволяет покупате

Комментарии (7)

![BillyWilson]() BillyWilson

BillyWilson

2 октября 2025 г., 9:30:43 GMT+03:00

2 октября 2025 г., 9:30:43 GMT+03:00

와...DeepSeek 모델이 이렇게 쉽게 해킹당하다니 😳 보안이 정말 취약한 건가? 중국 AI 스타트업이라 그런지 성능만 강조하고 보안은 소홀히 한 것 같아요. 기술력보다 안전성이 먼저인데...우려스럽네요.

0

0

![TimothyHill]() TimothyHill

TimothyHill

27 августа 2025 г., 13:36:38 GMT+03:00

27 августа 2025 г., 13:36:38 GMT+03:00

This article is wild! DeepSeek's AI getting jailbroken so easily is a bit scary, honestly. Makes me wonder how safe our data really is with all this AI hype going on. 😬 Anyone else worried about this?

0

0

![JeffreyThomas]() JeffreyThomas

JeffreyThomas

21 апреля 2025 г., 12:45:40 GMT+03:00

21 апреля 2025 г., 12:45:40 GMT+03:00

El modelo de IA de Deepseek es un desastre. Lo intenté y hacer jailbreak fue demasiado fácil. Parece que ni siquiera intentaron asegurarlo correctamente. El hype por el rendimiento está bien, pero la seguridad debería ser lo primero, ¿verdad? 🤦♂️ Tal vez lo arreglen pronto, pero hasta entonces, ¡me mantengo alejado!

0

0

![PatrickMartinez]() PatrickMartinez

PatrickMartinez

21 апреля 2025 г., 12:45:40 GMT+03:00

21 апреля 2025 г., 12:45:40 GMT+03:00

O modelo de IA da Deepseek é uma bagunça! Consegui fazer jailbreak muito facilmente. Parece que eles nem tentaram garantir a segurança adequadamente. O hype de desempenho é legal, mas a segurança deve vir em primeiro lugar, né? 🤦♂️ Talvez eles corrijam isso em breve, mas até lá, fico longe!

0

0

![HaroldLopez]() HaroldLopez

HaroldLopez

21 апреля 2025 г., 12:45:40 GMT+03:00

21 апреля 2025 г., 12:45:40 GMT+03:00

딥시크의 AI 모델, 너무 쉽게 탈옥되네요. 보안이 전혀 고려되지 않은 것 같아요. 성능은 화제가 되지만, 보안이 우선시 되어야죠. 빨리 개선되길 바랍니다만, 지금은 사용할 마음이 안 들어요 😓

0

0

![RalphJohnson]() RalphJohnson

RalphJohnson

21 апреля 2025 г., 12:45:40 GMT+03:00

21 апреля 2025 г., 12:45:40 GMT+03:00

ディープシークのAIモデル、簡単に脱獄できてしまいました。セキュリティが全く考慮されていないようですね。パフォーマンスが話題になっても、セキュリティが最優先されるべきです。早く改善してほしいですが、現状では使う気になれません😓

0

0

DeepSeek AI вызывает опасения по поводу безопасности на фоне ажиотажа вокруг производительности

По мере роста интереса к производительности китайского стартапа DeepSeek растут и опасения по поводу безопасности. В четверг команда по кибербезопасности Unit 42 из Palo Alto Networks опубликовала отчет, в котором описала три метода взлома, примененные против дистиллированных версий моделей DeepSeek V3 и R1. В отчете указано, что эти методы обеспечили высокий уровень обхода защиты без необходимости специальных знаний.

«Наши исследования показывают, что эти методы взлома могут предоставить явные инструкции для вредоносных действий», — говорится в отчете. Эти действия включали инструкции по созданию кейлоггеров, техник эксфильтрации данных и даже инструкции по изготовлению зажигательных устройств, подчеркивая реальные риски безопасности, создаваемые такими атаками.

Исследователям удалось заставить DeepSeek предоставить инструкции по краже и передаче конфиденциальных данных, обходу мер безопасности, созданию убедительных фишинговых писем, выполнению сложных атак социальной инженерии и изготовлению коктейля Молотова. Им также удалось манипулировать моделями для генерации вредоносного ПО.

«Хотя информация о создании коктейлей Молотова и кейлоггеров легко доступна в интернете, большие языковые модели с недостаточными ограничениями безопасности могут снизить барьер для злоумышленников, предоставляя легко используемый и действенный результат», — добавлено в документе.

В пятницу Cisco опубликовала собственный отчет о взломе, нацеленном на DeepSeek R1. Используя 50 запросов HarmBench, исследователи обнаружили, что DeepSeek показал 100%-ный успех атак, не заблокировав ни одного вредоносного запроса. Сравнение устойчивости DeepSeek с другими ведущими моделями показано ниже.

«Мы должны понять, есть ли у DeepSeek и его новой парадигмы рассуждений значительные компромиссы в плане безопасности», — отмечено в отчете.

Также в пятницу компания по обеспечению безопасности Wallarm опубликовала отчет, в котором утверждала, что пошла дальше простого побуждения DeepSeek генерировать вредоносный контент. После тестирования V3 и R1 Wallarm раскрыла системный запрос DeepSeek, который описывает поведение и ограничения модели.

Выводы указывают на «потенциальные уязвимости в структуре безопасности модели», согласно Wallarm.

OpenAI обвинила DeepSeek в использовании своих проприетарных моделей для обучения V3 и R1, нарушая тем самым условия обслуживания. Отчет Wallarm утверждает, что удалось заставить DeepSeek упомянуть OpenAI в своей цепочке обучения, предполагая, что «технология OpenAI могла сыграть роль в формировании базы знаний DeepSeek».

«В случае с DeepSeek одной из самых интригующих находок после взлома является возможность извлечения деталей о моделях, использованных для обучения и дистилляции. Обычно такая внутренняя информация защищена, не позволяя пользователям понять, какие проприетарные или внешние наборы данных использовались для оптимизации производительности», — поясняется в отчете.

«Обходя стандартные ограничения, взломы показывают, насколько тщательно провайдеры AI контролируют свои системы, выявляя не только уязвимости безопасности, но и потенциальные доказательства влияния одной модели на другую в цепочках обучения AI», — продолжено в отчете.

Запрос, использованный Wallarm для получения этого ответа, был отредактирован в отчете, чтобы избежать компрометации других уязвимых моделей, сообщили исследователи ZDNET по электронной почте. Они подчеркнули, что этот взломанный ответ не подтверждает подозрения OpenAI о том, что DeepSeek дистиллировал свои модели.

Как отметили 404 Media и другие, обеспокоенность OpenAI несколько иронична, учитывая дискуссии о ее собственном хищении общедоступных данных.

Wallarm сообщила DeepSeek об уязвимости, и компания с тех пор устранила проблему. Однако всего через несколько дней после того, как база данных DeepSeek была обнаружена незащищенной и доступной в интернете (и была быстро удалена после уведомления), эти находки указывают на потенциально значительные пробелы в безопасности моделей, которые DeepSeek не тщательно протестировал перед выпуском. Стоит отметить, что исследователям часто удавалось взламывать популярные модели, созданные в США, от более известных гигантов AI, включая ChatGPT.

Поиск Google расширяет режим интеллектуального искусственного интеллекта по всему миру

Google выводит свой поисковый сервис на основе искусственного интеллекта еще в 180 стран, значительно расширив его возможности по сравнению с первоначальным внедрением в США, Великобритании и Индии. Н

Поиск Google расширяет режим интеллектуального искусственного интеллекта по всему миру

Google выводит свой поисковый сервис на основе искусственного интеллекта еще в 180 стран, значительно расширив его возможности по сравнению с первоначальным внедрением в США, Великобритании и Индии. Н

Пошаговое руководство по созданию книг-раскрасок Amazon с помощью искусственного интеллекта Leonardo AI

Мечтаете пробиться на процветающий книжный рынок Amazon? Книжки-раскраски предлагают фантастическую возможность пассивного дохода, но найти оригинальные иллюстрации может быть непросто. В этом подробн

Пошаговое руководство по созданию книг-раскрасок Amazon с помощью искусственного интеллекта Leonardo AI

Мечтаете пробиться на процветающий книжный рынок Amazon? Книжки-раскраски предлагают фантастическую возможность пассивного дохода, но найти оригинальные иллюстрации может быть непросто. В этом подробн

Amazon представляет Lens Live с искусственным интеллектом для совершения покупок в реальном мире

Amazon продолжает развивать инновации в сфере покупок на основе искусственного интеллекта, представив во вторник Lens Live - улучшенную версию технологии визуального поиска, которая позволяет покупате

Amazon представляет Lens Live с искусственным интеллектом для совершения покупок в реальном мире

Amazon продолжает развивать инновации в сфере покупок на основе искусственного интеллекта, представив во вторник Lens Live - улучшенную версию технологии визуального поиска, которая позволяет покупате

2 октября 2025 г., 9:30:43 GMT+03:00

2 октября 2025 г., 9:30:43 GMT+03:00

와...DeepSeek 모델이 이렇게 쉽게 해킹당하다니 😳 보안이 정말 취약한 건가? 중국 AI 스타트업이라 그런지 성능만 강조하고 보안은 소홀히 한 것 같아요. 기술력보다 안전성이 먼저인데...우려스럽네요.

0

0

27 августа 2025 г., 13:36:38 GMT+03:00

27 августа 2025 г., 13:36:38 GMT+03:00

This article is wild! DeepSeek's AI getting jailbroken so easily is a bit scary, honestly. Makes me wonder how safe our data really is with all this AI hype going on. 😬 Anyone else worried about this?

0

0

21 апреля 2025 г., 12:45:40 GMT+03:00

21 апреля 2025 г., 12:45:40 GMT+03:00

El modelo de IA de Deepseek es un desastre. Lo intenté y hacer jailbreak fue demasiado fácil. Parece que ni siquiera intentaron asegurarlo correctamente. El hype por el rendimiento está bien, pero la seguridad debería ser lo primero, ¿verdad? 🤦♂️ Tal vez lo arreglen pronto, pero hasta entonces, ¡me mantengo alejado!

0

0

21 апреля 2025 г., 12:45:40 GMT+03:00

21 апреля 2025 г., 12:45:40 GMT+03:00

O modelo de IA da Deepseek é uma bagunça! Consegui fazer jailbreak muito facilmente. Parece que eles nem tentaram garantir a segurança adequadamente. O hype de desempenho é legal, mas a segurança deve vir em primeiro lugar, né? 🤦♂️ Talvez eles corrijam isso em breve, mas até lá, fico longe!

0

0

21 апреля 2025 г., 12:45:40 GMT+03:00

21 апреля 2025 г., 12:45:40 GMT+03:00

딥시크의 AI 모델, 너무 쉽게 탈옥되네요. 보안이 전혀 고려되지 않은 것 같아요. 성능은 화제가 되지만, 보안이 우선시 되어야죠. 빨리 개선되길 바랍니다만, 지금은 사용할 마음이 안 들어요 😓

0

0

21 апреля 2025 г., 12:45:40 GMT+03:00

21 апреля 2025 г., 12:45:40 GMT+03:00

ディープシークのAIモデル、簡単に脱獄できてしまいました。セキュリティが全く考慮されていないようですね。パフォーマンスが話題になっても、セキュリティが最優先されるべきです。早く改善してほしいですが、現状では使う気になれません😓

0

0