Apple -Forscher enthüllen das Geheimnis von Deepseek Ai: Sparsity erklärt

Die Schönheit der Sparsamkeit liegt in ihrer Vielseitigkeit: Sie steigert nicht nur die Effizienz bei kleineren Budgets, sondern skaliert auch, um mit erhöhter Rechenleistung bessere Ergebnisse zu liefern. Forscher von Apple stellten fest, dass „mit zunehmender Sparsamkeit der Validierungsverlust für alle Rechenbudgets abnimmt, wobei größere Budgets bei jedem Sparsamkeitsniveau geringere Verluste erzielen.“ Dies deutet darauf hin, dass mit zunehmender Rechenleistung die Genauigkeit des AI-Modells verbessert wird, was die Entwicklung größerer Modelle ermöglicht, die einen besseren Wert bieten.

Der Erfolg von DeepSeek ist nur ein Beispiel in einem breiteren Forschungsfeld, das viele Labore aktiv erforschen. Angesichts der nachgewiesenen Vorteile werden wahrscheinlich mehr Forscher diesem Beispiel folgen, um die Erfolge von DeepSeek zu replizieren und darauf aufzubauen.

Verwandter Artikel

ORCHIS entsteht als KI-gesteuerte K-Pop-Gruppe, die die Musikindustrie verändert

Die digitale Renaissance: ORCHIS definiert den K-Pop durch KI-Innovation neuMit ORCHIS, der bahnbrechenden KI-gesteuerten K-Pop-Sensation, bricht eine neue Ära in der Musikindustrie an, in der moderns

ORCHIS entsteht als KI-gesteuerte K-Pop-Gruppe, die die Musikindustrie verändert

Die digitale Renaissance: ORCHIS definiert den K-Pop durch KI-Innovation neuMit ORCHIS, der bahnbrechenden KI-gesteuerten K-Pop-Sensation, bricht eine neue Ära in der Musikindustrie an, in der moderns

Topaz Photo AI wertet Ihre Fotos mit fortschrittlicher AI-Technologie auf

Sie möchten Fotos in professioneller Qualität verbessern, ohne die steile Lernkurve zu durchlaufen? Topaz Photo AI revolutioniert die Bildbearbeitung durch die Kombination leistungsstarker KI-Technolo

Topaz Photo AI wertet Ihre Fotos mit fortschrittlicher AI-Technologie auf

Sie möchten Fotos in professioneller Qualität verbessern, ohne die steile Lernkurve zu durchlaufen? Topaz Photo AI revolutioniert die Bildbearbeitung durch die Kombination leistungsstarker KI-Technolo

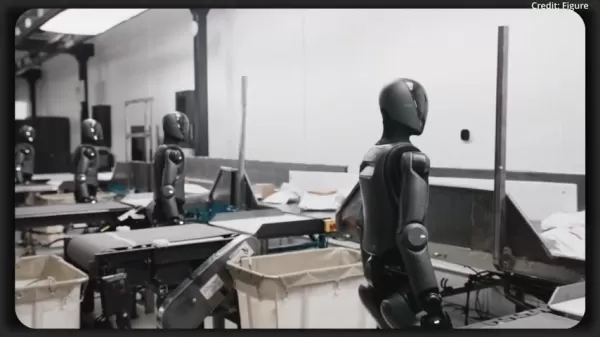

Helix AI System von Figure wird die Roboterindustrie bis 2025 verändern

Die Robotik befindet sich in einem beispiellosen Wandel, da künstliche Intelligenz die Einsatzmöglichkeiten neu definiert. Das bahnbrechende Helix-System von Figure AI zeigt eine Leistung, die in best

Kommentare (16)

0/200

Helix AI System von Figure wird die Roboterindustrie bis 2025 verändern

Die Robotik befindet sich in einem beispiellosen Wandel, da künstliche Intelligenz die Einsatzmöglichkeiten neu definiert. Das bahnbrechende Helix-System von Figure AI zeigt eine Leistung, die in best

Kommentare (16)

0/200

![WalterGonzález]() WalterGonzález

WalterGonzález

28. Juli 2025 03:19:30 MESZ

28. Juli 2025 03:19:30 MESZ

DeepSeek's rise is wild! A hedge fund outsmarting OpenAI? That’s like a small startup schooling Big Tech. Loving the sparsity angle—makes me wonder how much leaner AI can get! 😎

0

0

![JackMartin]() JackMartin

JackMartin

22. April 2025 16:37:14 MESZ

22. April 2025 16:37:14 MESZ

ディープシークAIの秘密が明らかに!スパーシティのおかげで、中国のオープンソースモデルがOpenAIを超えているなんて驚きです。これからの展開が楽しみですが、技術用語が難しすぎてよくわからない...もっと分かりやすく説明してほしいですね😅

0

0

![MatthewBaker]() MatthewBaker

MatthewBaker

20. April 2025 21:31:27 MESZ

20. April 2025 21:31:27 MESZ

DeepSeek AI's secret is out and it's all about sparsity! It's mind-blowing how this open-source model from China is beating the big dogs at OpenAI. I'm excited to see where this goes, but honestly, the tech jargon is a bit over my head. Can someone break it down for the rest of us? 🤓

0

0

![WillieJones]() WillieJones

WillieJones

20. April 2025 21:16:45 MESZ

20. April 2025 21:16:45 MESZ

アップルのディープシークAIのスパーシティについての解説は驚きです!中国のヘッジファンドが開発したモデルがOpenAIを上回るなんて面白いですね。説明が少し技術的すぎて難しかったけど、これからどうなるか楽しみです。アップル、技術的な話をもっと簡単に説明してください!🤓💡

0

0

![GeorgeWilson]() GeorgeWilson

GeorgeWilson

20. April 2025 12:29:09 MESZ

20. April 2025 12:29:09 MESZ

애플의 딥시크 AI의 희소성에 대한 설명은 정말 놀랍습니다! 중국의 헤지펀드가 개발한 모델이 OpenAI를 능가한다니 흥미롭네요. 설명이 조금 너무 기술적이어서 어려웠지만, 앞으로 어떻게 될지 기대됩니다. 애플, 기술적인 이야기를 더 쉽게 설명해주세요! 🤓💡

0

0

![WilliamAllen]() WilliamAllen

WilliamAllen

19. April 2025 21:36:25 MESZ

19. April 2025 21:36:25 MESZ

Apple's take on DeepSeek AI's sparsity is mind-blowing! It's fascinating to see how a China-based hedge fund's model can outperform OpenAI. The explanation was a bit too technical for me, but I'm excited to see where this goes. Keep simplifying the tech talk, Apple! 🤓💡

0

0

Die Schönheit der Sparsamkeit liegt in ihrer Vielseitigkeit: Sie steigert nicht nur die Effizienz bei kleineren Budgets, sondern skaliert auch, um mit erhöhter Rechenleistung bessere Ergebnisse zu liefern. Forscher von Apple stellten fest, dass „mit zunehmender Sparsamkeit der Validierungsverlust für alle Rechenbudgets abnimmt, wobei größere Budgets bei jedem Sparsamkeitsniveau geringere Verluste erzielen.“ Dies deutet darauf hin, dass mit zunehmender Rechenleistung die Genauigkeit des AI-Modells verbessert wird, was die Entwicklung größerer Modelle ermöglicht, die einen besseren Wert bieten.

Der Erfolg von DeepSeek ist nur ein Beispiel in einem breiteren Forschungsfeld, das viele Labore aktiv erforschen. Angesichts der nachgewiesenen Vorteile werden wahrscheinlich mehr Forscher diesem Beispiel folgen, um die Erfolge von DeepSeek zu replizieren und darauf aufzubauen.

ORCHIS entsteht als KI-gesteuerte K-Pop-Gruppe, die die Musikindustrie verändert

Die digitale Renaissance: ORCHIS definiert den K-Pop durch KI-Innovation neuMit ORCHIS, der bahnbrechenden KI-gesteuerten K-Pop-Sensation, bricht eine neue Ära in der Musikindustrie an, in der moderns

ORCHIS entsteht als KI-gesteuerte K-Pop-Gruppe, die die Musikindustrie verändert

Die digitale Renaissance: ORCHIS definiert den K-Pop durch KI-Innovation neuMit ORCHIS, der bahnbrechenden KI-gesteuerten K-Pop-Sensation, bricht eine neue Ära in der Musikindustrie an, in der moderns

Topaz Photo AI wertet Ihre Fotos mit fortschrittlicher AI-Technologie auf

Sie möchten Fotos in professioneller Qualität verbessern, ohne die steile Lernkurve zu durchlaufen? Topaz Photo AI revolutioniert die Bildbearbeitung durch die Kombination leistungsstarker KI-Technolo

Topaz Photo AI wertet Ihre Fotos mit fortschrittlicher AI-Technologie auf

Sie möchten Fotos in professioneller Qualität verbessern, ohne die steile Lernkurve zu durchlaufen? Topaz Photo AI revolutioniert die Bildbearbeitung durch die Kombination leistungsstarker KI-Technolo

Helix AI System von Figure wird die Roboterindustrie bis 2025 verändern

Die Robotik befindet sich in einem beispiellosen Wandel, da künstliche Intelligenz die Einsatzmöglichkeiten neu definiert. Das bahnbrechende Helix-System von Figure AI zeigt eine Leistung, die in best

Helix AI System von Figure wird die Roboterindustrie bis 2025 verändern

Die Robotik befindet sich in einem beispiellosen Wandel, da künstliche Intelligenz die Einsatzmöglichkeiten neu definiert. Das bahnbrechende Helix-System von Figure AI zeigt eine Leistung, die in best

28. Juli 2025 03:19:30 MESZ

28. Juli 2025 03:19:30 MESZ

DeepSeek's rise is wild! A hedge fund outsmarting OpenAI? That’s like a small startup schooling Big Tech. Loving the sparsity angle—makes me wonder how much leaner AI can get! 😎

0

0

22. April 2025 16:37:14 MESZ

22. April 2025 16:37:14 MESZ

ディープシークAIの秘密が明らかに!スパーシティのおかげで、中国のオープンソースモデルがOpenAIを超えているなんて驚きです。これからの展開が楽しみですが、技術用語が難しすぎてよくわからない...もっと分かりやすく説明してほしいですね😅

0

0

20. April 2025 21:31:27 MESZ

20. April 2025 21:31:27 MESZ

DeepSeek AI's secret is out and it's all about sparsity! It's mind-blowing how this open-source model from China is beating the big dogs at OpenAI. I'm excited to see where this goes, but honestly, the tech jargon is a bit over my head. Can someone break it down for the rest of us? 🤓

0

0

20. April 2025 21:16:45 MESZ

20. April 2025 21:16:45 MESZ

アップルのディープシークAIのスパーシティについての解説は驚きです!中国のヘッジファンドが開発したモデルがOpenAIを上回るなんて面白いですね。説明が少し技術的すぎて難しかったけど、これからどうなるか楽しみです。アップル、技術的な話をもっと簡単に説明してください!🤓💡

0

0

20. April 2025 12:29:09 MESZ

20. April 2025 12:29:09 MESZ

애플의 딥시크 AI의 희소성에 대한 설명은 정말 놀랍습니다! 중국의 헤지펀드가 개발한 모델이 OpenAI를 능가한다니 흥미롭네요. 설명이 조금 너무 기술적이어서 어려웠지만, 앞으로 어떻게 될지 기대됩니다. 애플, 기술적인 이야기를 더 쉽게 설명해주세요! 🤓💡

0

0

19. April 2025 21:36:25 MESZ

19. April 2025 21:36:25 MESZ

Apple's take on DeepSeek AI's sparsity is mind-blowing! It's fascinating to see how a China-based hedge fund's model can outperform OpenAI. The explanation was a bit too technical for me, but I'm excited to see where this goes. Keep simplifying the tech talk, Apple! 🤓💡

0

0