Công ty chính sách Openai chính sách đã thay đổi tường thuật an toàn của AI

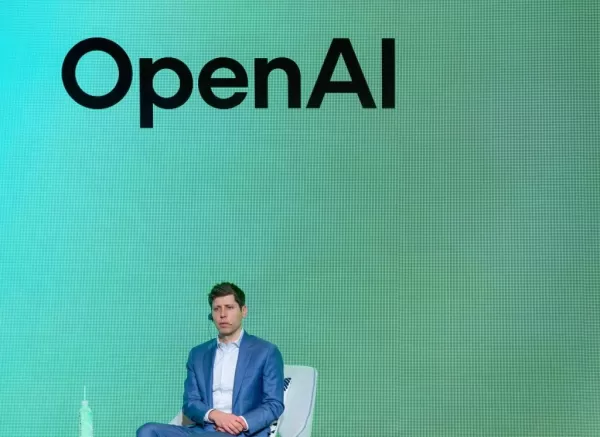

Một cựu nhà nghiên cứu chính sách của Openai, Miles Brundage, gần đây đã lên phương tiện truyền thông xã hội để gọi Openai cho những gì ông coi là một nỗ lực để "viết lại lịch sử" của cách tiếp cận của nó để triển khai các hệ thống AI có khả năng gặp rủi ro. Tuần này, OpenAI đã phát hành một tài liệu chi tiết lập trường hiện tại về sự an toàn và căn chỉnh của AI, quá trình đảm bảo các hệ thống AI hoạt động theo những cách có thể dự đoán và có lợi. Trong đó, Openai đã mô tả sự phát triển của AGI hoặc các hệ thống AI có khả năng của bất kỳ nhiệm vụ nào mà con người có thể làm, như một "con đường liên tục" liên quan đến "triển khai và học hỏi" từ các công nghệ AI. "Trong một thế giới không liên tục [...] Các bài học về an toàn đến từ việc đối xử với các hệ thống ngày nay với sự thận trọng xa hơn so với sức mạnh rõ ràng của chúng, [mà] là cách tiếp cận chúng tôi đã thực hiện cho [mô hình AI của chúng tôi] GPT-2", Openai tuyên bố trong tài liệu. "Bây giờ chúng tôi xem AGI đầu tiên chỉ là một điểm dọc theo một loạt các hệ thống tăng tính hữu ích [...] trong thế giới liên tục, cách để làm cho hệ thống tiếp theo an toàn và có lợi là học hỏi từ hệ thống hiện tại." Tuy nhiên, Brundage lập luận rằng cách tiếp cận thận trọng được thực hiện với GPT-2 hoàn toàn phù hợp với chiến lược triển khai lặp lại hiện tại của Openai. "Phát hành GPT-2 của Openai, mà tôi đã tham gia, là nhất quán 100% [với và] báo trước triết lý triển khai lặp lại của Openai," Brundage đăng trên X. "Mô hình đã được phát hành tăng dần, với các bài học được chia sẻ ở mỗi bước. Nhiều chuyên gia bảo mật đã cảm ơn chúng tôi." Brundage, người đã gia nhập Openai với tư cách là một nhà khoa học nghiên cứu vào năm 2018 và sau đó trở thành người đứng đầu nghiên cứu chính sách của công ty, tập trung vào việc triển khai có trách nhiệm các hệ thống tạo ngôn ngữ như Chatgpt trong khi tham gia nhóm "sẵn sàng" của Openai. GPT-2, được OpenAI công bố vào năm 2019, là tiền thân của các hệ thống AI đằng sau TATGPT. Nó có thể trả lời các câu hỏi, tóm tắt các bài báo và tạo văn bản đôi khi không thể phân biệt được với văn bản của con người. Mặc dù GPT-2 có vẻ cơ bản, nhưng nó đã đột phá vào thời điểm đó. Do lo ngại về việc lạm dụng tiềm năng, OpenAI ban đầu giữ lại mã nguồn của mô hình, thay vào đó cho phép chọn các cơ quan tin tức được giới hạn truy cập vào bản demo. Quyết định nhận được phản hồi hỗn hợp từ cộng đồng AI. Một số người lập luận rằng những rủi ro liên quan đến GPT-2 đã bị cường điệu hóa và không có bằng chứng nào để hỗ trợ cho mối quan tâm của Openai về việc lạm dụng. Ấn phẩm tập trung AI The Gradient thậm chí đã xuất bản một bức thư ngỏ kêu gọi Openai phát hành mô hình, trích dẫn ý nghĩa công nghệ của nó. Openai cuối cùng đã phát hành một phiên bản một phần của GPT-2 sáu tháng sau khi công bố, sau đó là toàn bộ hệ thống vài tháng sau đó. Brundage tin rằng đây là cách tiếp cận chính xác. "Phần nào của [bản phát hành GPT-2] đã được thúc đẩy bởi hoặc tiền đề khi nghĩ về AGI là không liên tục? Không ai trong số đó", ông nói trên X. "Bằng chứng là sự thận trọng này là 'không cân xứng' Brundage lo ngại rằng tài liệu của Openai nhằm mục đích thiết lập một gánh nặng chứng minh cao, nơi những lo ngại bị coi là người báo động trừ khi có bằng chứng áp đảo về những nguy hiểm sắp xảy ra. Anh ta thấy suy nghĩ này "rất nguy hiểm" cho các hệ thống AI tiên tiến. "Nếu tôi vẫn đang làm việc tại Openai, tôi sẽ hỏi tại sao [tài liệu] này được viết theo cách của nó, và chính xác những gì Openai hy vọng sẽ đạt được bằng cách thận trọng theo cách như vậy", Brundage nói thêm. Openai đã phải đối mặt với những lời chỉ trích trong quá khứ vì đã ưu tiên "các sản phẩm sáng bóng" hơn so với các bản phát hành an toàn và vội vã cho các đối thủ cạnh tranh. Năm ngoái, công ty đã giải tán nhóm sẵn sàng AGI của mình và một số nhà nghiên cứu chính sách và an toàn AI đã rời đi cho các công ty đối thủ. Bối cảnh cạnh tranh đã tăng cường, với mô hình R1 của AI Lab Deepseek, có sẵn công khai và phù hợp với mô hình "Lý luận" O1 của Openai trên các điểm chuẩn chính, thu hút sự chú ý toàn cầu. Giám đốc điều hành Openai Sam Altman đã thừa nhận rằng Deepseek đã thu hẹp lãnh đạo công nghệ của Openai, khiến Openai xem xét việc tăng tốc lịch phát hành. Với Openai được báo cáo là mất hàng tỷ hàng năm và dự báo lỗ gấp ba lần lên 14 tỷ đô la vào năm 2026, chu kỳ phát hành sản phẩm nhanh hơn có thể tăng lợi nhuận ngắn hạn nhưng có khả năng thỏa hiệp an toàn dài hạn. Các chuyên gia như Brundage đang đặt câu hỏi liệu sự đánh đổi này có đáng không.

Bài viết liên quan

Cựu Kỹ sư OpenAI Chia sẻ Thông tin về Văn hóa Công ty và Tăng trưởng Nhanh chóng

Ba tuần trước, Calvin French-Owen, một kỹ sư đã đóng góp vào một sản phẩm chủ chốt của OpenAI, đã rời công ty.Gần đây, anh ấy đã chia sẻ một bài đăng blog hấp dẫn, mô tả chi tiết một năm làm việc tại

Cựu Kỹ sư OpenAI Chia sẻ Thông tin về Văn hóa Công ty và Tăng trưởng Nhanh chóng

Ba tuần trước, Calvin French-Owen, một kỹ sư đã đóng góp vào một sản phẩm chủ chốt của OpenAI, đã rời công ty.Gần đây, anh ấy đã chia sẻ một bài đăng blog hấp dẫn, mô tả chi tiết một năm làm việc tại

Người dùng Apple có thể yêu cầu phần chia từ khoản dàn xếp bảo mật Siri 95 triệu USD

Chủ sở hữu thiết bị Apple tại Mỹ giờ đây có thể nộp đơn yêu cầu một phần từ khoản dàn xếp 95 triệu USD liên quan đến các vấn đề bảo mật của Siri. Một trang web chuyên dụng hỗ trợ phân phối quỹ cho nhữ

Người dùng Apple có thể yêu cầu phần chia từ khoản dàn xếp bảo mật Siri 95 triệu USD

Chủ sở hữu thiết bị Apple tại Mỹ giờ đây có thể nộp đơn yêu cầu một phần từ khoản dàn xếp 95 triệu USD liên quan đến các vấn đề bảo mật của Siri. Một trang web chuyên dụng hỗ trợ phân phối quỹ cho nhữ

Google Ra Mắt Các Mô Hình AI Gemini 2.5 Sẵn Sàng Sản Xuất để Cạnh Tranh với OpenAI trên Thị Trường Doanh Nghiệp

Google tăng cường chiến lược AI vào thứ Hai, ra mắt các mô hình Gemini 2.5 tiên tiến cho doanh nghiệp và giới thiệu biến thể tiết kiệm chi phí để cạnh tranh về giá và hiệu suất.Công ty thuộc sở hữu củ

Nhận xét (36)

0/200

Google Ra Mắt Các Mô Hình AI Gemini 2.5 Sẵn Sàng Sản Xuất để Cạnh Tranh với OpenAI trên Thị Trường Doanh Nghiệp

Google tăng cường chiến lược AI vào thứ Hai, ra mắt các mô hình Gemini 2.5 tiên tiến cho doanh nghiệp và giới thiệu biến thể tiết kiệm chi phí để cạnh tranh về giá và hiệu suất.Công ty thuộc sở hữu củ

Nhận xét (36)

0/200

![LiamCarter]() LiamCarter

LiamCarter

14:00:59 GMT+07:00 Ngày 05 tháng 8 năm 2025

14:00:59 GMT+07:00 Ngày 05 tháng 8 năm 2025

It's wild how OpenAI's getting called out by their own ex-policy lead! 😮 Miles Brundage isn't holding back, accusing them of spinning their AI safety story. Makes you wonder what's really going on behind the scenes at these big AI companies. Are they prioritizing safety or just playing PR games?

0

0

![TimothyMitchell]() TimothyMitchell

TimothyMitchell

00:18:15 GMT+07:00 Ngày 21 tháng 4 năm 2025

00:18:15 GMT+07:00 Ngày 21 tháng 4 năm 2025

マイルズ・ブルンダージがオープンAIを批判したのは正しいと思う。彼らはAI安全性の物語をねじ曲げようとしているが、それは受け入れられない。彼らがリスクのあるAIを扱っているとき、透明性を求めることは重要だ。マイルズ、引き続き透明性を求めてください!👍

0

0

![JackPerez]() JackPerez

JackPerez

06:40:06 GMT+07:00 Ngày 17 tháng 4 năm 2025

06:40:06 GMT+07:00 Ngày 17 tháng 4 năm 2025

A crítica de Miles Brundage à OpenAI é totalmente justa! Eles estão tentando reescrever a história da segurança do AI, mas não estamos comprando isso. É crucial mantê-los responsáveis, especialmente quando lidam com sistemas de IA arriscados. Continue pressionando por transparência, Miles! 👍

0

0

![StevenGonzalez]() StevenGonzalez

StevenGonzalez

03:38:43 GMT+07:00 Ngày 17 tháng 4 năm 2025

03:38:43 GMT+07:00 Ngày 17 tháng 4 năm 2025

마일즈 브런데이지가 OpenAI의 새로운 AI 안전성 서사를 비판하는 것을 보고 정말 드라마를 보는 것 같아요. 그는 회사가 역사를 다시 쓰고 있다고 비난하고 있어서, 그의 강력한 태도에 감탄했어요. 큰 기술 기업의 안전성 주장을 믿기 전에 두 번 생각하게 만드네요. 마일즈, 고마워요! 👏

0

0

![AlbertWilson]() AlbertWilson

AlbertWilson

02:07:30 GMT+07:00 Ngày 17 tháng 4 năm 2025

02:07:30 GMT+07:00 Ngày 17 tháng 4 năm 2025

Just listened to Miles Brundage's take on OpenAI's new AI safety narrative and wow, it's like watching a soap opera unfold! He's not holding back, calling out the company for rewriting history. It's intense but also kinda refreshing to see someone stand up like this. Definitely makes you think twice about trusting big tech's safety claims. Keep it real, Miles! 👏

0

0

![DonaldBrown]() DonaldBrown

DonaldBrown

14:05:24 GMT+07:00 Ngày 16 tháng 4 năm 2025

14:05:24 GMT+07:00 Ngày 16 tháng 4 năm 2025

Я ценю честность Майлса Брандажа о смене нарратива OpenAI в отношении безопасности ИИ. Важно держать компании ответственными, но хотелось бы больше конструктивной критики. Тем не менее, это сигнал тревоги для отрасли! 🚨

0

0

Cựu Kỹ sư OpenAI Chia sẻ Thông tin về Văn hóa Công ty và Tăng trưởng Nhanh chóng

Ba tuần trước, Calvin French-Owen, một kỹ sư đã đóng góp vào một sản phẩm chủ chốt của OpenAI, đã rời công ty.Gần đây, anh ấy đã chia sẻ một bài đăng blog hấp dẫn, mô tả chi tiết một năm làm việc tại

Cựu Kỹ sư OpenAI Chia sẻ Thông tin về Văn hóa Công ty và Tăng trưởng Nhanh chóng

Ba tuần trước, Calvin French-Owen, một kỹ sư đã đóng góp vào một sản phẩm chủ chốt của OpenAI, đã rời công ty.Gần đây, anh ấy đã chia sẻ một bài đăng blog hấp dẫn, mô tả chi tiết một năm làm việc tại

Người dùng Apple có thể yêu cầu phần chia từ khoản dàn xếp bảo mật Siri 95 triệu USD

Chủ sở hữu thiết bị Apple tại Mỹ giờ đây có thể nộp đơn yêu cầu một phần từ khoản dàn xếp 95 triệu USD liên quan đến các vấn đề bảo mật của Siri. Một trang web chuyên dụng hỗ trợ phân phối quỹ cho nhữ

Người dùng Apple có thể yêu cầu phần chia từ khoản dàn xếp bảo mật Siri 95 triệu USD

Chủ sở hữu thiết bị Apple tại Mỹ giờ đây có thể nộp đơn yêu cầu một phần từ khoản dàn xếp 95 triệu USD liên quan đến các vấn đề bảo mật của Siri. Một trang web chuyên dụng hỗ trợ phân phối quỹ cho nhữ

Google Ra Mắt Các Mô Hình AI Gemini 2.5 Sẵn Sàng Sản Xuất để Cạnh Tranh với OpenAI trên Thị Trường Doanh Nghiệp

Google tăng cường chiến lược AI vào thứ Hai, ra mắt các mô hình Gemini 2.5 tiên tiến cho doanh nghiệp và giới thiệu biến thể tiết kiệm chi phí để cạnh tranh về giá và hiệu suất.Công ty thuộc sở hữu củ

Google Ra Mắt Các Mô Hình AI Gemini 2.5 Sẵn Sàng Sản Xuất để Cạnh Tranh với OpenAI trên Thị Trường Doanh Nghiệp

Google tăng cường chiến lược AI vào thứ Hai, ra mắt các mô hình Gemini 2.5 tiên tiến cho doanh nghiệp và giới thiệu biến thể tiết kiệm chi phí để cạnh tranh về giá và hiệu suất.Công ty thuộc sở hữu củ

14:00:59 GMT+07:00 Ngày 05 tháng 8 năm 2025

14:00:59 GMT+07:00 Ngày 05 tháng 8 năm 2025

It's wild how OpenAI's getting called out by their own ex-policy lead! 😮 Miles Brundage isn't holding back, accusing them of spinning their AI safety story. Makes you wonder what's really going on behind the scenes at these big AI companies. Are they prioritizing safety or just playing PR games?

0

0

00:18:15 GMT+07:00 Ngày 21 tháng 4 năm 2025

00:18:15 GMT+07:00 Ngày 21 tháng 4 năm 2025

マイルズ・ブルンダージがオープンAIを批判したのは正しいと思う。彼らはAI安全性の物語をねじ曲げようとしているが、それは受け入れられない。彼らがリスクのあるAIを扱っているとき、透明性を求めることは重要だ。マイルズ、引き続き透明性を求めてください!👍

0

0

06:40:06 GMT+07:00 Ngày 17 tháng 4 năm 2025

06:40:06 GMT+07:00 Ngày 17 tháng 4 năm 2025

A crítica de Miles Brundage à OpenAI é totalmente justa! Eles estão tentando reescrever a história da segurança do AI, mas não estamos comprando isso. É crucial mantê-los responsáveis, especialmente quando lidam com sistemas de IA arriscados. Continue pressionando por transparência, Miles! 👍

0

0

03:38:43 GMT+07:00 Ngày 17 tháng 4 năm 2025

03:38:43 GMT+07:00 Ngày 17 tháng 4 năm 2025

마일즈 브런데이지가 OpenAI의 새로운 AI 안전성 서사를 비판하는 것을 보고 정말 드라마를 보는 것 같아요. 그는 회사가 역사를 다시 쓰고 있다고 비난하고 있어서, 그의 강력한 태도에 감탄했어요. 큰 기술 기업의 안전성 주장을 믿기 전에 두 번 생각하게 만드네요. 마일즈, 고마워요! 👏

0

0

02:07:30 GMT+07:00 Ngày 17 tháng 4 năm 2025

02:07:30 GMT+07:00 Ngày 17 tháng 4 năm 2025

Just listened to Miles Brundage's take on OpenAI's new AI safety narrative and wow, it's like watching a soap opera unfold! He's not holding back, calling out the company for rewriting history. It's intense but also kinda refreshing to see someone stand up like this. Definitely makes you think twice about trusting big tech's safety claims. Keep it real, Miles! 👏

0

0

14:05:24 GMT+07:00 Ngày 16 tháng 4 năm 2025

14:05:24 GMT+07:00 Ngày 16 tháng 4 năm 2025

Я ценю честность Майлса Брандажа о смене нарратива OpenAI в отношении безопасности ИИ. Важно держать компании ответственными, но хотелось бы больше конструктивной критики. Тем не менее, это сигнал тревоги для отрасли! 🚨

0

0