पूर्व-ओपेनाई पॉलिसी लीड स्लैम कंपनी एआई सुरक्षा कथा को बदलने के लिए

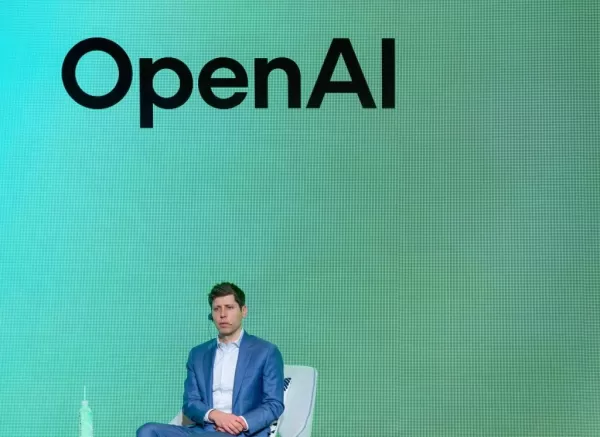

एक पूर्व Openai नीति शोधकर्ता, माइल्स ब्रूंडेज, ने हाल ही में सोशल मीडिया पर ओपनई को कॉल करने के लिए लिया, जो वह संभावित जोखिम भरे एआई सिस्टम को तैनात करने के लिए अपने दृष्टिकोण के "इतिहास को फिर से लिखने" के प्रयास के रूप में देखता है। इस हफ्ते, Openai ने AI सुरक्षा और संरेखण पर अपने वर्तमान रुख का विवरण देते हुए एक दस्तावेज जारी किया, AI सिस्टम्स को सुनिश्चित करने की प्रक्रिया पूर्वानुमान और लाभकारी तरीकों से कार्य करती है। इसमें, Openai ने AGI के विकास का वर्णन किया, या AI सिस्टम जो किसी भी कार्य के लिए सक्षम हो सकता है, एक "निरंतर पथ" के रूप में, जिसमें AI प्रौद्योगिकियों से "पुनरावृत्त रूप से तैनात और सीखना" शामिल है। "एक असंतोषजनक दुनिया में [...] सुरक्षा सबक आज की प्रणालियों के इलाज से आते हैं, जो उनकी स्पष्ट शक्ति के सापेक्ष बाहरी सावधानी के साथ, [जो] वह दृष्टिकोण है जिसे हमने [हमारे एआई मॉडल] जीपीटी -2 के लिए लिया है," ओपनई ने दस्तावेज़ में कहा। "अब हम पहले एजीआई को बढ़ती उपयोगिता की प्रणालियों की एक श्रृंखला के साथ सिर्फ एक बिंदु के रूप में देखते हैं [...] निरंतर दुनिया में, अगले सिस्टम को सुरक्षित और लाभकारी बनाने का तरीका वर्तमान प्रणाली से सीखना है।" हालांकि, ब्रूंडेज का तर्क है कि जीपीटी -2 के साथ लिया गया सतर्क दृष्टिकोण पूरी तरह से ओपनईआई की वर्तमान पुनरावृत्ति तैनाती रणनीति के अनुरूप था। "जीपीटी -2 की ओपनईआई की रिहाई, जिसमें मैं शामिल था, 100% सुसंगत था [के साथ और] ने ओपनईआई के वर्तमान दर्शन को पुनरावृत्ति की तैनाती के मौजूदा दर्शन के साथ पूर्वाभ्यास किया," एक्स पर पोस्ट किया गया था। ब्रुन्डेज, जो 2018 में एक शोध वैज्ञानिक के रूप में ओपनआईए में शामिल हुए और बाद में कंपनी के नीति अनुसंधान के प्रमुख बन गए, ने ओपनईएआई की "एजीआई रेडीनेस" टीम के दौरान चटप्ट जैसी भाषा उत्पादन प्रणालियों की जिम्मेदार तैनाती पर ध्यान केंद्रित किया। GPT-2, 2019 में Openai द्वारा घोषित, CHATGPT के पीछे AI सिस्टम के लिए एक अग्रदूत था। यह सवालों का जवाब दे सकता है, लेखों को संक्षेप में प्रस्तुत कर सकता है, और पाठ उत्पन्न कर सकता है जो कभी -कभी मानव लेखन से अप्रभेद्य था। हालांकि GPT-2 अब बुनियादी लग सकता है, यह उस समय ग्राउंडब्रेकिंग था। संभावित दुरुपयोग के बारे में चिंताओं के कारण, Openai ने शुरू में मॉडल के स्रोत कोड को रोक दिया, इसके बजाय एक डेमो तक सीमित समाचार आउटलेट्स को सीमित करने की अनुमति दी। निर्णय को एआई समुदाय से मिश्रित प्रतिक्रिया मिली। कुछ लोगों ने तर्क दिया कि जीपीटी -2 से जुड़े जोखिमों को खत्म कर दिया गया था, और दुरुपयोग के बारे में ओपनईआई की चिंताओं का समर्थन करने के लिए कोई सबूत नहीं था। एआई-केंद्रित प्रकाशन द ग्रैडिएंट ने एक खुला पत्र भी प्रकाशित किया, जिसमें ओपनईआई ने अपने तकनीकी महत्व का हवाला देते हुए मॉडल जारी करने का आग्रह किया। Openai ने अंततः अपनी घोषणा के बाद GPT-2 का एक आंशिक संस्करण जारी किया, इसके बाद कई महीनों बाद पूर्ण प्रणाली हुई। ब्रुन्डेज का मानना है कि यह सही दृष्टिकोण था। उन्होंने एक्स पर कहा, "[जीपीटी -2 रिलीज़] के किस हिस्से को प्रेरित किया गया था या एजीआई के बारे में सोचने के लिए प्रेरित किया गया था। इसमें से कोई भी नहीं था।" ब्रुन्डेज चिंतित है कि ओपनईआई के दस्तावेज़ का उद्देश्य सबूत का एक उच्च बोझ स्थापित करना है, जहां चिंताओं को अलार्म के रूप में खारिज कर दिया जाता है जब तक कि आसन्न खतरों का भारी सबूत नहीं होता। वह उन्नत एआई सिस्टम के लिए इस मानसिकता को "बहुत खतरनाक" पाता है। "अगर मैं अभी भी Openai में काम कर रहा था, तो मैं पूछ रहा हूँ कि यह [दस्तावेज़] जिस तरह से लिखा गया था, और वास्तव में ओपनई ने पू-पू-सावधानी से सावधानी बरतने की उम्मीद की थी," ब्रुन्डेज ने कहा। Openai ने अतीत में सुरक्षा पर "चमकदार उत्पादों" को प्राथमिकता देने के लिए अतीत में आलोचना का सामना किया है और प्रतियोगियों को बाहर करने के लिए रिलीज की दौड़ लगाई है। पिछले साल, कंपनी ने अपनी एजीआई तत्परता टीम को भंग कर दिया, और कई एआई सुरक्षा और नीति शोधकर्ताओं ने प्रतिद्वंद्वी फर्मों के लिए छोड़ दिया। प्रतिस्पर्धी परिदृश्य तेज हो गया है, चीनी एआई लैब डीपसेक के आर 1 मॉडल के साथ, जो खुले तौर पर उपलब्ध है और ओपनईआई के ओ 1 "रीजनिंग" मॉडल को प्रमुख बेंचमार्क पर, वैश्विक ध्यान आकर्षित करता है। Openai के सीईओ सैम अल्टमैन ने स्वीकार किया है कि दीपसेक ने ओपनईआई की तकनीकी लीड को संकुचित कर दिया है, जिससे ओपनआईएआई ने अपने रिलीज़ शेड्यूल को तेज करने पर विचार किया। Openai ने कथित तौर पर सालाना अरबों की कमी और 2026 तक 2026 तक $ 14 बिलियन तक नुकसान पहुंचाने के साथ, एक तेज़ उत्पाद रिलीज चक्र अल्पकालिक मुनाफे को बढ़ावा दे सकता है, लेकिन संभावित रूप से दीर्घकालिक सुरक्षा से समझौता कर सकता है। ब्रूंडेज जैसे विशेषज्ञ सवाल कर रहे हैं कि क्या यह व्यापार-बंद सार्थक है।

संबंधित लेख

पूर्व OpenAI इंजीनियर ने कंपनी संस्कृति और तेजी से विकास पर अंतर्दृष्टि साझा की

तीन सप्ताह पहले, कैल्विन फ्रेंच-ओवेन, एक इंजीनियर जिन्होंने OpenAI के एक प्रमुख उत्पाद में योगदान दिया, ने कंपनी छोड़ दी।उन्होंने हाल ही में एक आकर्षक ब्लॉग पोस्ट साझा किया जिसमें OpenAI में उनके एक स

पूर्व OpenAI इंजीनियर ने कंपनी संस्कृति और तेजी से विकास पर अंतर्दृष्टि साझा की

तीन सप्ताह पहले, कैल्विन फ्रेंच-ओवेन, एक इंजीनियर जिन्होंने OpenAI के एक प्रमुख उत्पाद में योगदान दिया, ने कंपनी छोड़ दी।उन्होंने हाल ही में एक आकर्षक ब्लॉग पोस्ट साझा किया जिसमें OpenAI में उनके एक स

Apple उपयोगकर्ता $95M Siri गोपनीयता निपटान का हिस्सा दावा कर सकते हैं

अमेरिका में Apple डिवाइस मालिक अब Siri गोपनीयता चिंताओं को संबोधित करने वाले $95 मिलियन के निपटान का हिस्सा प्राप्त करने के लिए आवेदन कर सकते हैं। एक समर्पित वेबसाइट 17 सितंबर, 2014 से 31 दिसंबर, 2024

Apple उपयोगकर्ता $95M Siri गोपनीयता निपटान का हिस्सा दावा कर सकते हैं

अमेरिका में Apple डिवाइस मालिक अब Siri गोपनीयता चिंताओं को संबोधित करने वाले $95 मिलियन के निपटान का हिस्सा प्राप्त करने के लिए आवेदन कर सकते हैं। एक समर्पित वेबसाइट 17 सितंबर, 2014 से 31 दिसंबर, 2024

Google ने उद्यम बाजार में OpenAI के साथ प्रतिस्पर्धा करने के लिए उत्पादन-तैयार Gemini 2.5 AI मॉडल्स का अनावरण किया

Google ने सोमवार को अपनी AI रणनीति को और मजबूत किया, उद्यम उपयोग के लिए अपने उन्नत Gemini 2.5 मॉडल्स को लॉन्च किया और कीमत व प्रदर्शन पर प्रतिस्पर्धा करने के लिए एक लागत-कुशल संस्करण पेश किया।Alphabet

सूचना (36)

0/200

Google ने उद्यम बाजार में OpenAI के साथ प्रतिस्पर्धा करने के लिए उत्पादन-तैयार Gemini 2.5 AI मॉडल्स का अनावरण किया

Google ने सोमवार को अपनी AI रणनीति को और मजबूत किया, उद्यम उपयोग के लिए अपने उन्नत Gemini 2.5 मॉडल्स को लॉन्च किया और कीमत व प्रदर्शन पर प्रतिस्पर्धा करने के लिए एक लागत-कुशल संस्करण पेश किया।Alphabet

सूचना (36)

0/200

![LiamCarter]() LiamCarter

LiamCarter

5 अगस्त 2025 12:30:59 अपराह्न IST

5 अगस्त 2025 12:30:59 अपराह्न IST

It's wild how OpenAI's getting called out by their own ex-policy lead! 😮 Miles Brundage isn't holding back, accusing them of spinning their AI safety story. Makes you wonder what's really going on behind the scenes at these big AI companies. Are they prioritizing safety or just playing PR games?

0

0

![TimothyMitchell]() TimothyMitchell

TimothyMitchell

20 अप्रैल 2025 10:48:15 अपराह्न IST

20 अप्रैल 2025 10:48:15 अपराह्न IST

マイルズ・ブルンダージがオープンAIを批判したのは正しいと思う。彼らはAI安全性の物語をねじ曲げようとしているが、それは受け入れられない。彼らがリスクのあるAIを扱っているとき、透明性を求めることは重要だ。マイルズ、引き続き透明性を求めてください!👍

0

0

![JackPerez]() JackPerez

JackPerez

17 अप्रैल 2025 5:10:06 पूर्वाह्न IST

17 अप्रैल 2025 5:10:06 पूर्वाह्न IST

A crítica de Miles Brundage à OpenAI é totalmente justa! Eles estão tentando reescrever a história da segurança do AI, mas não estamos comprando isso. É crucial mantê-los responsáveis, especialmente quando lidam com sistemas de IA arriscados. Continue pressionando por transparência, Miles! 👍

0

0

![StevenGonzalez]() StevenGonzalez

StevenGonzalez

17 अप्रैल 2025 2:08:43 पूर्वाह्न IST

17 अप्रैल 2025 2:08:43 पूर्वाह्न IST

마일즈 브런데이지가 OpenAI의 새로운 AI 안전성 서사를 비판하는 것을 보고 정말 드라마를 보는 것 같아요. 그는 회사가 역사를 다시 쓰고 있다고 비난하고 있어서, 그의 강력한 태도에 감탄했어요. 큰 기술 기업의 안전성 주장을 믿기 전에 두 번 생각하게 만드네요. 마일즈, 고마워요! 👏

0

0

![AlbertWilson]() AlbertWilson

AlbertWilson

17 अप्रैल 2025 12:37:30 पूर्वाह्न IST

17 अप्रैल 2025 12:37:30 पूर्वाह्न IST

Just listened to Miles Brundage's take on OpenAI's new AI safety narrative and wow, it's like watching a soap opera unfold! He's not holding back, calling out the company for rewriting history. It's intense but also kinda refreshing to see someone stand up like this. Definitely makes you think twice about trusting big tech's safety claims. Keep it real, Miles! 👏

0

0

![DonaldBrown]() DonaldBrown

DonaldBrown

16 अप्रैल 2025 12:35:24 अपराह्न IST

16 अप्रैल 2025 12:35:24 अपराह्न IST

Я ценю честность Майлса Брандажа о смене нарратива OpenAI в отношении безопасности ИИ. Важно держать компании ответственными, но хотелось бы больше конструктивной критики. Тем не менее, это сигнал тревоги для отрасли! 🚨

0

0

पूर्व OpenAI इंजीनियर ने कंपनी संस्कृति और तेजी से विकास पर अंतर्दृष्टि साझा की

तीन सप्ताह पहले, कैल्विन फ्रेंच-ओवेन, एक इंजीनियर जिन्होंने OpenAI के एक प्रमुख उत्पाद में योगदान दिया, ने कंपनी छोड़ दी।उन्होंने हाल ही में एक आकर्षक ब्लॉग पोस्ट साझा किया जिसमें OpenAI में उनके एक स

पूर्व OpenAI इंजीनियर ने कंपनी संस्कृति और तेजी से विकास पर अंतर्दृष्टि साझा की

तीन सप्ताह पहले, कैल्विन फ्रेंच-ओवेन, एक इंजीनियर जिन्होंने OpenAI के एक प्रमुख उत्पाद में योगदान दिया, ने कंपनी छोड़ दी।उन्होंने हाल ही में एक आकर्षक ब्लॉग पोस्ट साझा किया जिसमें OpenAI में उनके एक स

Apple उपयोगकर्ता $95M Siri गोपनीयता निपटान का हिस्सा दावा कर सकते हैं

अमेरिका में Apple डिवाइस मालिक अब Siri गोपनीयता चिंताओं को संबोधित करने वाले $95 मिलियन के निपटान का हिस्सा प्राप्त करने के लिए आवेदन कर सकते हैं। एक समर्पित वेबसाइट 17 सितंबर, 2014 से 31 दिसंबर, 2024

Apple उपयोगकर्ता $95M Siri गोपनीयता निपटान का हिस्सा दावा कर सकते हैं

अमेरिका में Apple डिवाइस मालिक अब Siri गोपनीयता चिंताओं को संबोधित करने वाले $95 मिलियन के निपटान का हिस्सा प्राप्त करने के लिए आवेदन कर सकते हैं। एक समर्पित वेबसाइट 17 सितंबर, 2014 से 31 दिसंबर, 2024

Google ने उद्यम बाजार में OpenAI के साथ प्रतिस्पर्धा करने के लिए उत्पादन-तैयार Gemini 2.5 AI मॉडल्स का अनावरण किया

Google ने सोमवार को अपनी AI रणनीति को और मजबूत किया, उद्यम उपयोग के लिए अपने उन्नत Gemini 2.5 मॉडल्स को लॉन्च किया और कीमत व प्रदर्शन पर प्रतिस्पर्धा करने के लिए एक लागत-कुशल संस्करण पेश किया।Alphabet

Google ने उद्यम बाजार में OpenAI के साथ प्रतिस्पर्धा करने के लिए उत्पादन-तैयार Gemini 2.5 AI मॉडल्स का अनावरण किया

Google ने सोमवार को अपनी AI रणनीति को और मजबूत किया, उद्यम उपयोग के लिए अपने उन्नत Gemini 2.5 मॉडल्स को लॉन्च किया और कीमत व प्रदर्शन पर प्रतिस्पर्धा करने के लिए एक लागत-कुशल संस्करण पेश किया।Alphabet

5 अगस्त 2025 12:30:59 अपराह्न IST

5 अगस्त 2025 12:30:59 अपराह्न IST

It's wild how OpenAI's getting called out by their own ex-policy lead! 😮 Miles Brundage isn't holding back, accusing them of spinning their AI safety story. Makes you wonder what's really going on behind the scenes at these big AI companies. Are they prioritizing safety or just playing PR games?

0

0

20 अप्रैल 2025 10:48:15 अपराह्न IST

20 अप्रैल 2025 10:48:15 अपराह्न IST

マイルズ・ブルンダージがオープンAIを批判したのは正しいと思う。彼らはAI安全性の物語をねじ曲げようとしているが、それは受け入れられない。彼らがリスクのあるAIを扱っているとき、透明性を求めることは重要だ。マイルズ、引き続き透明性を求めてください!👍

0

0

17 अप्रैल 2025 5:10:06 पूर्वाह्न IST

17 अप्रैल 2025 5:10:06 पूर्वाह्न IST

A crítica de Miles Brundage à OpenAI é totalmente justa! Eles estão tentando reescrever a história da segurança do AI, mas não estamos comprando isso. É crucial mantê-los responsáveis, especialmente quando lidam com sistemas de IA arriscados. Continue pressionando por transparência, Miles! 👍

0

0

17 अप्रैल 2025 2:08:43 पूर्वाह्न IST

17 अप्रैल 2025 2:08:43 पूर्वाह्न IST

마일즈 브런데이지가 OpenAI의 새로운 AI 안전성 서사를 비판하는 것을 보고 정말 드라마를 보는 것 같아요. 그는 회사가 역사를 다시 쓰고 있다고 비난하고 있어서, 그의 강력한 태도에 감탄했어요. 큰 기술 기업의 안전성 주장을 믿기 전에 두 번 생각하게 만드네요. 마일즈, 고마워요! 👏

0

0

17 अप्रैल 2025 12:37:30 पूर्वाह्न IST

17 अप्रैल 2025 12:37:30 पूर्वाह्न IST

Just listened to Miles Brundage's take on OpenAI's new AI safety narrative and wow, it's like watching a soap opera unfold! He's not holding back, calling out the company for rewriting history. It's intense but also kinda refreshing to see someone stand up like this. Definitely makes you think twice about trusting big tech's safety claims. Keep it real, Miles! 👏

0

0

16 अप्रैल 2025 12:35:24 अपराह्न IST

16 अप्रैल 2025 12:35:24 अपराह्न IST

Я ценю честность Майлса Брандажа о смене нарратива OpenAI в отношении безопасности ИИ. Важно держать компании ответственными, но хотелось бы больше конструктивной критики. Тем не менее, это сигнал тревоги для отрасли! 🚨

0

0