AI採用システムが採用決定に影響する隠れた偏見を暴く

AI採用における隠れたバイアス:採用アルゴリズムにおける組織的差別への取り組み

はじめに

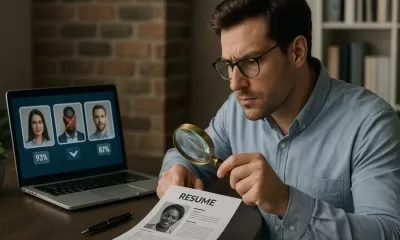

AIを活用した採用ツールは、効率的な候補者スクリーニング、標準化された面接プロセス、データ駆動型の選考により、採用活動の変革を約束する。これらのシステムは、何千もの応募を数分で処理するなど、採用を合理化することで称賛される一方で、制度的差別を永続させる根深いバイアスを秘めている。

ワシントン大学の調査によると、主要なAI採用モデルには驚くべき人種と性別の偏りがあり、白人に関連する名前の履歴書が優遇されていることが明らかになった。同様に、ブルッキングス研究所の研究では、3つの主要な言語モデルを使用した9つの職業における差別の証拠を発見した。

現在、雇用者の87%が採用においてAIを使用しており、こうした偏見は孤立した事件ではなく、制度化され、差別が大規模に自動化されている。この分析では、AI採用システムがなぜバイアスを内包するのか、その現実世界への影響、そしてより公正な採用のための実行可能な戦略を探る。

AI採用システムが差別を強化する理由

アルゴリズム・バイアスの根源

AIバイアスは、機械学習モデルが過去のデータに埋め込まれた人間の偏見を複製し、増幅することで発生する。個人の偏見とは異なり、アルゴリズムによる差別は組織的に行われ、人間の介入なしに応募者全体に影響を及ぼします。

バイアスの主な原因は以下の通りです:

- 欠陥のあるトレーニングデータ- 過去の採用決定に基づいてトレーニングされたシステムは、偏ったパターンを受け継ぐ(例えば、アマゾンの廃止されたAIリクルーターに見られるように、男性の候補者を優遇する)。

- 開発チームの多様性の制限- エンジニアはしばしば、暗黙のバイアスを持ったツールを設計し、それがチェックされない。

- 代理差別- 「中立的な」要素(郵便番号や大学名など)が、人種や経済的バイアスを覆い隠してしまうことがある。

顕著な例としては、採用で使用される顔分析ツールがあり、肌の色の濃い候補者を低いランクにすることが多い。

採用AIにおけるバイアス

ビデオ面接分析

- 口調、表情、ボディランゲージを評価するが、神経障害のある候補者、アクセント、文化的なスピーチパターンにはペナルティを課す。

- 研究によると、女性、非ネイティブスピーカー、宗教的な服装の候補者は、「自信」の指標で低いスコアを示している。

履歴書スクリーニングアルゴリズム

- 名前(少数民族に不釣り合いな影響を与える)、雇用格差(介護者を傷つける)、または時代遅れの技術スキル(高齢労働者を不利にする)に基づいて応募者をフィルタリングする。

- しばしば恣意的な理由(趣味の記載や型にはまった書式など)で候補者を切り捨てる。

自動アセスメント

- 現在の従業員に似た候補者を優先し、多様性を促進する代わりに同質性を強化する。

- 透明性に欠け、不採用の理由が応募者に伝わらない。

AI採用バイアスの現実世界での結果

候補者組織的排除

- 疎外されたグループからの有資格の応募者は、散発的な人間の偏見とは異なり、複数の雇用主にわたって一律の排除に直面する。

- 不服申し立ての手段がない-AIツールが不採用の説明を提供することはほとんどなく、候補者は混乱し、無力になる。

雇用主にとって法的リスクと風評リスク

- コンプライアンス違反- 規制の増加(EU AI法、ニューヨーク市地方法144など)により、AI採用ツールはバイアス監査を受ける必要がある。

- 訴訟- 注目を集める事件(例:AI差別をめぐる集団訴訟請求に直面するWorkday)は、法的脆弱性を浮き彫りにする。

- 均質な労働力- AI採用に過度に依存すると、多様性が低下し、イノベーションが阻害され、優秀な人材が不足する。

システムを修正する:公正なAI採用のためのフレームワーク

予防策監査と多様なデータ

学際的な監査チームの結成

- 倫理学者、社会学者、DEI専門家、影響を受ける地域社会を含め、AIモデルを精査する。

代表的なトレーニングデータの使用

- 人種、性別、年齢、社会経済的背景によるデータセットのバランスを積極的にとる。合成データは、十分に代表されていないグループを補足することができる。

バイアスメトリクスの採用

- 機会均等(適格な候補者が同じような割合で成功しているか)と人口統計学的平等(選考率はグループ間で公平か)を追跡する。

技術的・政策的解決策

人間によるレビュー- AIは雇用管理者に取って代わるものではなく、支援するものであるべき。最終決定には人間の監視が必要。

透明性の義務付け- AIが使用された場合、候補者に情報を提供し、自動的な不採用に対する不服申し立てを認める。

定期的なストレステスト- 特にモデル更新後は、新たなバイアスがないか継続的に評価する。

新たなベストプラクティス

- 「バイアス報奨金」-差別的な欠陥を発見した研究者に報奨金を支払う。

- Algorithmic Impact Assessments- EU AI Actで義務付けられている監査。

今後の展望

採用におけるAIの有望性は、組織が自動化のスピードよりも公平性を優先する場合にのみ実現できる。これは次のことを意味する:

✅積極的な監査- 偏見によって応募者が傷つけられたり、訴訟を起こされたりする前に。

✅多様な開発チーム- AI設計の盲点を見つける。

✅候補者との透明性- 誰も "ブラックボックス "によって選別されるべきではない。

責任あるAI市場が成長するにつれ、偏見に正面から取り組む企業は規制を遵守するだけでなく、より優秀な人材を惹きつけることができる。この問題を無視する企業は、法的な影響や風評被害、労働力の多様性の停滞といったリスクを負うことになる。

AI採用ツールは私たちの偏見を反映するのか、それとも偏見を克服する手助けをするのか。

よくある質問

Q: AI採用は偏りがないのでしょうか?

A.完全に中立なシステムはありませんが、厳格なテスト、多様なデータ、継続的な監視によって差別を劇的に減らすことができます。

Q: 候補者はAIツールが自分を不採用にしたかどうかを知っていますか?

A.めったにありません。透明性の欠如は大きな倫理的懸念であり、ニューヨーク市の地方法144のような規制は現在、情報開示を義務付けている。

Q: 求職者はどのようにして身を守ることができますか?

A.ATSに適した書式を使用し、可能な限り履歴書の空白を避け、雇用主がAIの使用を開示するよう主張すること。

Q:(ChatGPTのような)ジェネレーティブAIは採用バイアスを悪化させますか?

A.Potentially-GPT-4は履歴書の採点に人種的バイアスを示しています。このようなツールが普及するにつれ、注意深い監査が重要になります。

未来の採用は、過去の偏見を再現すべきではありません。公正なAI採用は可能であるだけでなく、不可欠である。

関連記事

信仰を通して強さを見つける:平和な力を探る

現代生活の混乱と重圧の中で、内なる静けさと永続的な回復力を発見することは不可欠である。信仰は、数え切れないほどの人々の支柱としてしっかりと立っている。不確実な状況の中で導きを与え、苦悩の中で安らぎを与え、混乱の中で明晰さを与えてくれる。この探求は、スピリチュアルな信仰がいかにシェルターとコンパスの両方の役割を果たし、有意義なつながりを育みながら人生の最も激動の季節を乗り切る力を人々に与えているかを

信仰を通して強さを見つける:平和な力を探る

現代生活の混乱と重圧の中で、内なる静けさと永続的な回復力を発見することは不可欠である。信仰は、数え切れないほどの人々の支柱としてしっかりと立っている。不確実な状況の中で導きを与え、苦悩の中で安らぎを与え、混乱の中で明晰さを与えてくれる。この探求は、スピリチュアルな信仰がいかにシェルターとコンパスの両方の役割を果たし、有意義なつながりを育みながら人生の最も激動の季節を乗り切る力を人々に与えているかを

PLRコンテンツでAIリスト構築を強化しよう:究極のガイド

質の高いEメールリストの構築は、成功するデジタルマーケティング戦略の基盤を形成します。最新のAIツールとプライベート・レーベル・ライツ(PLR)コンテンツの組み合わせは、このプロセスに革命をもたらし、これまで以上に迅速かつ効果的になりました。この完全なウォークスルーでは、Lead CreatorのようなAIを活用したソリューションと、再利用可能なPLR素材を組み合わせて、コンバージョンにつながる反

PLRコンテンツでAIリスト構築を強化しよう:究極のガイド

質の高いEメールリストの構築は、成功するデジタルマーケティング戦略の基盤を形成します。最新のAIツールとプライベート・レーベル・ライツ(PLR)コンテンツの組み合わせは、このプロセスに革命をもたらし、これまで以上に迅速かつ効果的になりました。この完全なウォークスルーでは、Lead CreatorのようなAIを活用したソリューションと、再利用可能なPLR素材を組み合わせて、コンバージョンにつながる反

AI広告のスケーリング革命:2025年にクリエイティビティを10倍高める

デジタル広告の状況は急速な進化を続けており、競争上の成功にはイノベーションが不可欠です。2025年に近づくにつれ、人工知能とクリエイティブマーケティングの融合は、キャンペーンパフォーマンスに革命をもたらす画期的な機会を提示している。この詳細な分析では、AIを導入することでクリエイティブなアウトプットを10倍に増幅させる実践的な方法を明らかにし、マーケターに実行可能な戦略と最先端のツールを提供するこ

コメント (0)

0/200

AI広告のスケーリング革命:2025年にクリエイティビティを10倍高める

デジタル広告の状況は急速な進化を続けており、競争上の成功にはイノベーションが不可欠です。2025年に近づくにつれ、人工知能とクリエイティブマーケティングの融合は、キャンペーンパフォーマンスに革命をもたらす画期的な機会を提示している。この詳細な分析では、AIを導入することでクリエイティブなアウトプットを10倍に増幅させる実践的な方法を明らかにし、マーケターに実行可能な戦略と最先端のツールを提供するこ

コメント (0)

0/200

AI採用における隠れたバイアス:採用アルゴリズムにおける組織的差別への取り組み

はじめに

AIを活用した採用ツールは、効率的な候補者スクリーニング、標準化された面接プロセス、データ駆動型の選考により、採用活動の変革を約束する。これらのシステムは、何千もの応募を数分で処理するなど、採用を合理化することで称賛される一方で、制度的差別を永続させる根深いバイアスを秘めている。

ワシントン大学の調査によると、主要なAI採用モデルには驚くべき人種と性別の偏りがあり、白人に関連する名前の履歴書が優遇されていることが明らかになった。同様に、ブルッキングス研究所の研究では、3つの主要な言語モデルを使用した9つの職業における差別の証拠を発見した。

現在、雇用者の87%が採用においてAIを使用しており、こうした偏見は孤立した事件ではなく、制度化され、差別が大規模に自動化されている。この分析では、AI採用システムがなぜバイアスを内包するのか、その現実世界への影響、そしてより公正な採用のための実行可能な戦略を探る。

AI採用システムが差別を強化する理由

アルゴリズム・バイアスの根源

AIバイアスは、機械学習モデルが過去のデータに埋め込まれた人間の偏見を複製し、増幅することで発生する。個人の偏見とは異なり、アルゴリズムによる差別は組織的に行われ、人間の介入なしに応募者全体に影響を及ぼします。

バイアスの主な原因は以下の通りです:

- 欠陥のあるトレーニングデータ- 過去の採用決定に基づいてトレーニングされたシステムは、偏ったパターンを受け継ぐ(例えば、アマゾンの廃止されたAIリクルーターに見られるように、男性の候補者を優遇する)。

- 開発チームの多様性の制限- エンジニアはしばしば、暗黙のバイアスを持ったツールを設計し、それがチェックされない。

- 代理差別- 「中立的な」要素(郵便番号や大学名など)が、人種や経済的バイアスを覆い隠してしまうことがある。

顕著な例としては、採用で使用される顔分析ツールがあり、肌の色の濃い候補者を低いランクにすることが多い。

採用AIにおけるバイアス

ビデオ面接分析

- 口調、表情、ボディランゲージを評価するが、神経障害のある候補者、アクセント、文化的なスピーチパターンにはペナルティを課す。

- 研究によると、女性、非ネイティブスピーカー、宗教的な服装の候補者は、「自信」の指標で低いスコアを示している。

履歴書スクリーニングアルゴリズム

- 名前(少数民族に不釣り合いな影響を与える)、雇用格差(介護者を傷つける)、または時代遅れの技術スキル(高齢労働者を不利にする)に基づいて応募者をフィルタリングする。

- しばしば恣意的な理由(趣味の記載や型にはまった書式など)で候補者を切り捨てる。

自動アセスメント

- 現在の従業員に似た候補者を優先し、多様性を促進する代わりに同質性を強化する。

- 透明性に欠け、不採用の理由が応募者に伝わらない。

AI採用バイアスの現実世界での結果

候補者組織的排除

- 疎外されたグループからの有資格の応募者は、散発的な人間の偏見とは異なり、複数の雇用主にわたって一律の排除に直面する。

- 不服申し立ての手段がない-AIツールが不採用の説明を提供することはほとんどなく、候補者は混乱し、無力になる。

雇用主にとって法的リスクと風評リスク

- コンプライアンス違反- 規制の増加(EU AI法、ニューヨーク市地方法144など)により、AI採用ツールはバイアス監査を受ける必要がある。

- 訴訟- 注目を集める事件(例:AI差別をめぐる集団訴訟請求に直面するWorkday)は、法的脆弱性を浮き彫りにする。

- 均質な労働力- AI採用に過度に依存すると、多様性が低下し、イノベーションが阻害され、優秀な人材が不足する。

システムを修正する:公正なAI採用のためのフレームワーク

予防策監査と多様なデータ

学際的な監査チームの結成

- 倫理学者、社会学者、DEI専門家、影響を受ける地域社会を含め、AIモデルを精査する。

代表的なトレーニングデータの使用

- 人種、性別、年齢、社会経済的背景によるデータセットのバランスを積極的にとる。合成データは、十分に代表されていないグループを補足することができる。

バイアスメトリクスの採用

- 機会均等(適格な候補者が同じような割合で成功しているか)と人口統計学的平等(選考率はグループ間で公平か)を追跡する。

技術的・政策的解決策

人間によるレビュー- AIは雇用管理者に取って代わるものではなく、支援するものであるべき。最終決定には人間の監視が必要。

透明性の義務付け- AIが使用された場合、候補者に情報を提供し、自動的な不採用に対する不服申し立てを認める。

定期的なストレステスト- 特にモデル更新後は、新たなバイアスがないか継続的に評価する。

新たなベストプラクティス

- 「バイアス報奨金」-差別的な欠陥を発見した研究者に報奨金を支払う。

- Algorithmic Impact Assessments- EU AI Actで義務付けられている監査。

今後の展望

採用におけるAIの有望性は、組織が自動化のスピードよりも公平性を優先する場合にのみ実現できる。これは次のことを意味する:

✅積極的な監査- 偏見によって応募者が傷つけられたり、訴訟を起こされたりする前に。

✅多様な開発チーム- AI設計の盲点を見つける。

✅候補者との透明性- 誰も "ブラックボックス "によって選別されるべきではない。

責任あるAI市場が成長するにつれ、偏見に正面から取り組む企業は規制を遵守するだけでなく、より優秀な人材を惹きつけることができる。この問題を無視する企業は、法的な影響や風評被害、労働力の多様性の停滞といったリスクを負うことになる。

AI採用ツールは私たちの偏見を反映するのか、それとも偏見を克服する手助けをするのか。

よくある質問

Q: AI採用は偏りがないのでしょうか?

A.完全に中立なシステムはありませんが、厳格なテスト、多様なデータ、継続的な監視によって差別を劇的に減らすことができます。

Q: 候補者はAIツールが自分を不採用にしたかどうかを知っていますか?

A.めったにありません。透明性の欠如は大きな倫理的懸念であり、ニューヨーク市の地方法144のような規制は現在、情報開示を義務付けている。

Q: 求職者はどのようにして身を守ることができますか?

A.ATSに適した書式を使用し、可能な限り履歴書の空白を避け、雇用主がAIの使用を開示するよう主張すること。

Q:(ChatGPTのような)ジェネレーティブAIは採用バイアスを悪化させますか?

A.Potentially-GPT-4は履歴書の採点に人種的バイアスを示しています。このようなツールが普及するにつれ、注意深い監査が重要になります。

未来の採用は、過去の偏見を再現すべきではありません。公正なAI採用は可能であるだけでなく、不可欠である。

信仰を通して強さを見つける:平和な力を探る

現代生活の混乱と重圧の中で、内なる静けさと永続的な回復力を発見することは不可欠である。信仰は、数え切れないほどの人々の支柱としてしっかりと立っている。不確実な状況の中で導きを与え、苦悩の中で安らぎを与え、混乱の中で明晰さを与えてくれる。この探求は、スピリチュアルな信仰がいかにシェルターとコンパスの両方の役割を果たし、有意義なつながりを育みながら人生の最も激動の季節を乗り切る力を人々に与えているかを

信仰を通して強さを見つける:平和な力を探る

現代生活の混乱と重圧の中で、内なる静けさと永続的な回復力を発見することは不可欠である。信仰は、数え切れないほどの人々の支柱としてしっかりと立っている。不確実な状況の中で導きを与え、苦悩の中で安らぎを与え、混乱の中で明晰さを与えてくれる。この探求は、スピリチュアルな信仰がいかにシェルターとコンパスの両方の役割を果たし、有意義なつながりを育みながら人生の最も激動の季節を乗り切る力を人々に与えているかを

PLRコンテンツでAIリスト構築を強化しよう:究極のガイド

質の高いEメールリストの構築は、成功するデジタルマーケティング戦略の基盤を形成します。最新のAIツールとプライベート・レーベル・ライツ(PLR)コンテンツの組み合わせは、このプロセスに革命をもたらし、これまで以上に迅速かつ効果的になりました。この完全なウォークスルーでは、Lead CreatorのようなAIを活用したソリューションと、再利用可能なPLR素材を組み合わせて、コンバージョンにつながる反

PLRコンテンツでAIリスト構築を強化しよう:究極のガイド

質の高いEメールリストの構築は、成功するデジタルマーケティング戦略の基盤を形成します。最新のAIツールとプライベート・レーベル・ライツ(PLR)コンテンツの組み合わせは、このプロセスに革命をもたらし、これまで以上に迅速かつ効果的になりました。この完全なウォークスルーでは、Lead CreatorのようなAIを活用したソリューションと、再利用可能なPLR素材を組み合わせて、コンバージョンにつながる反

AI広告のスケーリング革命:2025年にクリエイティビティを10倍高める

デジタル広告の状況は急速な進化を続けており、競争上の成功にはイノベーションが不可欠です。2025年に近づくにつれ、人工知能とクリエイティブマーケティングの融合は、キャンペーンパフォーマンスに革命をもたらす画期的な機会を提示している。この詳細な分析では、AIを導入することでクリエイティブなアウトプットを10倍に増幅させる実践的な方法を明らかにし、マーケターに実行可能な戦略と最先端のツールを提供するこ

AI広告のスケーリング革命:2025年にクリエイティビティを10倍高める

デジタル広告の状況は急速な進化を続けており、競争上の成功にはイノベーションが不可欠です。2025年に近づくにつれ、人工知能とクリエイティブマーケティングの融合は、キャンペーンパフォーマンスに革命をもたらす画期的な機会を提示している。この詳細な分析では、AIを導入することでクリエイティブなアウトプットを10倍に増幅させる実践的な方法を明らかにし、マーケターに実行可能な戦略と最先端のツールを提供するこ