OpenAI के o3 AI मॉडल को अंतर्निहित परीक्षण में पहले से कम स्कोर मिला

AI में बेंचमार्क विषमताएं क्यों महत्वपूर्ण हैं

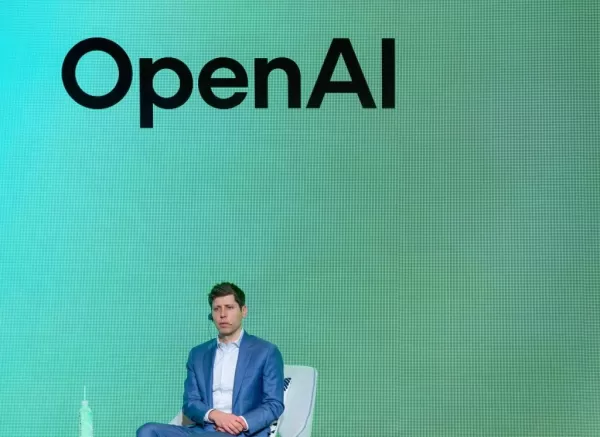

AI में, संख्याएं कहानी सुनाती हैं—and कभी-कभी, ये संख्याएं वास्तविकता से कुछ अलग हो जाती हैं। उदाहरण के लिए, OpenAI के o3 मॉडल के बारे में पहले कहानी बहुत ही अद्भुत थी: o3 कहा जा रहा था कि यह लगभग 25% से अधिक FrontierMath के विशिष्ट रूप से कठिन समस्याओं को हासिल कर सकता है। संदर्भ के लिए, प्रतिद्वंद्वियों को लगभग अंकों के कुछ कम का प्रदर्शन मिला था। लेकिन वर्तमान समय में, Epoch AI—एक प्रभावशाली अनुसंधान संस्था—ने इस कथन को खराब कर दिया है। उनके अनुसंधान के अनुसार, o3 का वास्तविक प्रदर्शन लगभग 10% तक ही है। यह अच्छा है, लेकिन निश्चित रूप से OpenAI द्वारा पहले प्रस्तुत की गई वाहने वाली संख्या नहीं थी।

वास्तव में क्या हो रहा है?

इसे विचार करने पर देखें। OpenAI का पहला स्कोर संभवतः आदर्श परिस्थितियों के तहत प्राप्त किया गया था—जो कि वास्तविक दुनिया में ठीक उल्टे नहीं हो सकते। Epoch ने सुझाव दिया कि उनका परीक्षण वातावरण OpenAI के वातावरण से थोड़ा अलग हो सकता है, और उन्होंने भी FrontierMath का एक नया संस्करण इस्तेमाल किया था। यह नहीं कहता कि OpenAI ने सीधे झूठे अपार्टी की, उनके प्रारंभिक कथनों ने अंदरोंदर की परीक्षणों के साथ संगति रखी थी, लेकिन इस विषमता ने एक बड़ी समस्या को प्रदर्शित किया। बेंचमार्क अक्सर एक-दूसरे के साथ सीधे तुलना नहीं कर सकते हैं। और चलो सच कहें, कंपनियां अपनी सबसे बेहतरीन प्रदर्शन को प्रदर्शित करने के लिए उत्सुक होती हैं।

तौलीनेस की भूमिका

इस स्थिति ने एक महत्वपूर्ण प्रश्न उठाया है: AI कंपनियों को परिणाम शेयर करते समय कितना तौलीनेस करना चाहिए? जबकि OpenAI ने सीधे झूठा नहीं बोला, उनका संदेश उम्मीदों को निरंतर करने पर जोर दिया था जो पूरी तरह से पूरा नहीं हुआ। यह एक असंतुलित संतुलन है। कंपनियां अपनी उन्नतियों को दिखाना चाहती हैं, लेकिन वे भी ये सच्चाई समझानी चाहिए कि ये संख्याएं क्या वास्तव में कहती हैं। जैसे-जैसे AI दैनिक जीवन में अधिक व्यापक रूप से शामिल हो रहा है, उपभोक्ताओं और शोधकर्ताओं दोनों की जानकारी के लिए स्पष्टता की आवश्यकता होगी।

उद्योग में अन्य विवाद

बेंचमार्किंग की त्रुटियां OpenAI के लिए ही नहीं हैं। AI स्पेस में अन्य खिताबदारों को भी समान जांच करनी पड़ी है। जनवरी में, Epoch को OpenAI से गुप्त वित्तीय सहायता प्राप्त करने के बाद जल्दी में जल्दी गिर गया था। तब एलन मस्क के xAI ने भी संदेह किया कि उन्होंने अपने बेंचमार्क चार्ट को तकनीकी रूप से बदल कर Grok 3 को अधिक अच्छा दिखाने का प्रयास किया। यहां तक कि Meta, एक टेक्नोलॉजी विशाल शक्ति, ने हाल ही में अपने प्रदर्शन को

संबंधित लेख

पूर्व OpenAI इंजीनियर ने कंपनी संस्कृति और तेजी से विकास पर अंतर्दृष्टि साझा की

तीन सप्ताह पहले, कैल्विन फ्रेंच-ओवेन, एक इंजीनियर जिन्होंने OpenAI के एक प्रमुख उत्पाद में योगदान दिया, ने कंपनी छोड़ दी।उन्होंने हाल ही में एक आकर्षक ब्लॉग पोस्ट साझा किया जिसमें OpenAI में उनके एक स

पूर्व OpenAI इंजीनियर ने कंपनी संस्कृति और तेजी से विकास पर अंतर्दृष्टि साझा की

तीन सप्ताह पहले, कैल्विन फ्रेंच-ओवेन, एक इंजीनियर जिन्होंने OpenAI के एक प्रमुख उत्पाद में योगदान दिया, ने कंपनी छोड़ दी।उन्होंने हाल ही में एक आकर्षक ब्लॉग पोस्ट साझा किया जिसमें OpenAI में उनके एक स

Google ने उद्यम बाजार में OpenAI के साथ प्रतिस्पर्धा करने के लिए उत्पादन-तैयार Gemini 2.5 AI मॉडल्स का अनावरण किया

Google ने सोमवार को अपनी AI रणनीति को और मजबूत किया, उद्यम उपयोग के लिए अपने उन्नत Gemini 2.5 मॉडल्स को लॉन्च किया और कीमत व प्रदर्शन पर प्रतिस्पर्धा करने के लिए एक लागत-कुशल संस्करण पेश किया।Alphabet

Google ने उद्यम बाजार में OpenAI के साथ प्रतिस्पर्धा करने के लिए उत्पादन-तैयार Gemini 2.5 AI मॉडल्स का अनावरण किया

Google ने सोमवार को अपनी AI रणनीति को और मजबूत किया, उद्यम उपयोग के लिए अपने उन्नत Gemini 2.5 मॉडल्स को लॉन्च किया और कीमत व प्रदर्शन पर प्रतिस्पर्धा करने के लिए एक लागत-कुशल संस्करण पेश किया।Alphabet

मेटा AI प्रतिभा के लिए उच्च वेतन प्रदान करता है, 100 मिलियन डॉलर के साइनिंग बोनस से इनकार

मेटा अपने नए सुपरइंटेलिजेंस लैब में AI शोधकर्ताओं को आकर्षित करने के लिए लाखों डॉलर के मुआवजे पैकेज प्रदान कर रहा है। हालांकि, एक भर्ती किए गए शोधकर्ता और लीक हुई आंतरिक बैठक की टिप्पणियों के अनुसार,

सूचना (2)

0/200

मेटा AI प्रतिभा के लिए उच्च वेतन प्रदान करता है, 100 मिलियन डॉलर के साइनिंग बोनस से इनकार

मेटा अपने नए सुपरइंटेलिजेंस लैब में AI शोधकर्ताओं को आकर्षित करने के लिए लाखों डॉलर के मुआवजे पैकेज प्रदान कर रहा है। हालांकि, एक भर्ती किए गए शोधकर्ता और लीक हुई आंतरिक बैठक की टिप्पणियों के अनुसार,

सूचना (2)

0/200

![FrankLewis]() FrankLewis

FrankLewis

7 अगस्त 2025 8:11:14 पूर्वाह्न IST

7 अगस्त 2025 8:11:14 पूर्वाह्न IST

The o3 model's benchmark slip-up is a bit of a letdown. 😕 I was hyped for OpenAI's big claims, but now I’m wondering if they’re overselling. Numbers don’t lie, but they can sure be misleading!

0

0

![NicholasCarter]() NicholasCarter

NicholasCarter

29 जुलाई 2025 5:55:16 अपराह्न IST

29 जुलाई 2025 5:55:16 अपराह्न IST

The o3 model's benchmark slip-up is wild! I was hyped for those big claims, but now it’s like finding out your favorite superhero has a weak spot. Still, AI’s moving so fast, I wonder if these benchmarks even keep up with real-world use. 🤔 Anyone else feel like we’re chasing numbers instead of actual progress?

0

0

AI में बेंचमार्क विषमताएं क्यों महत्वपूर्ण हैं

AI में, संख्याएं कहानी सुनाती हैं—and कभी-कभी, ये संख्याएं वास्तविकता से कुछ अलग हो जाती हैं। उदाहरण के लिए, OpenAI के o3 मॉडल के बारे में पहले कहानी बहुत ही अद्भुत थी: o3 कहा जा रहा था कि यह लगभग 25% से अधिक FrontierMath के विशिष्ट रूप से कठिन समस्याओं को हासिल कर सकता है। संदर्भ के लिए, प्रतिद्वंद्वियों को लगभग अंकों के कुछ कम का प्रदर्शन मिला था। लेकिन वर्तमान समय में, Epoch AI—एक प्रभावशाली अनुसंधान संस्था—ने इस कथन को खराब कर दिया है। उनके अनुसंधान के अनुसार, o3 का वास्तविक प्रदर्शन लगभग 10% तक ही है। यह अच्छा है, लेकिन निश्चित रूप से OpenAI द्वारा पहले प्रस्तुत की गई वाहने वाली संख्या नहीं थी।

वास्तव में क्या हो रहा है?

इसे विचार करने पर देखें। OpenAI का पहला स्कोर संभवतः आदर्श परिस्थितियों के तहत प्राप्त किया गया था—जो कि वास्तविक दुनिया में ठीक उल्टे नहीं हो सकते। Epoch ने सुझाव दिया कि उनका परीक्षण वातावरण OpenAI के वातावरण से थोड़ा अलग हो सकता है, और उन्होंने भी FrontierMath का एक नया संस्करण इस्तेमाल किया था। यह नहीं कहता कि OpenAI ने सीधे झूठे अपार्टी की, उनके प्रारंभिक कथनों ने अंदरोंदर की परीक्षणों के साथ संगति रखी थी, लेकिन इस विषमता ने एक बड़ी समस्या को प्रदर्शित किया। बेंचमार्क अक्सर एक-दूसरे के साथ सीधे तुलना नहीं कर सकते हैं। और चलो सच कहें, कंपनियां अपनी सबसे बेहतरीन प्रदर्शन को प्रदर्शित करने के लिए उत्सुक होती हैं।

तौलीनेस की भूमिका

इस स्थिति ने एक महत्वपूर्ण प्रश्न उठाया है: AI कंपनियों को परिणाम शेयर करते समय कितना तौलीनेस करना चाहिए? जबकि OpenAI ने सीधे झूठा नहीं बोला, उनका संदेश उम्मीदों को निरंतर करने पर जोर दिया था जो पूरी तरह से पूरा नहीं हुआ। यह एक असंतुलित संतुलन है। कंपनियां अपनी उन्नतियों को दिखाना चाहती हैं, लेकिन वे भी ये सच्चाई समझानी चाहिए कि ये संख्याएं क्या वास्तव में कहती हैं। जैसे-जैसे AI दैनिक जीवन में अधिक व्यापक रूप से शामिल हो रहा है, उपभोक्ताओं और शोधकर्ताओं दोनों की जानकारी के लिए स्पष्टता की आवश्यकता होगी।

उद्योग में अन्य विवाद

बेंचमार्किंग की त्रुटियां OpenAI के लिए ही नहीं हैं। AI स्पेस में अन्य खिताबदारों को भी समान जांच करनी पड़ी है। जनवरी में, Epoch को OpenAI से गुप्त वित्तीय सहायता प्राप्त करने के बाद जल्दी में जल्दी गिर गया था। तब एलन मस्क के xAI ने भी संदेह किया कि उन्होंने अपने बेंचमार्क चार्ट को तकनीकी रूप से बदल कर Grok 3 को अधिक अच्छा दिखाने का प्रयास किया। यहां तक कि Meta, एक टेक्नोलॉजी विशाल शक्ति, ने हाल ही में अपने प्रदर्शन को

पूर्व OpenAI इंजीनियर ने कंपनी संस्कृति और तेजी से विकास पर अंतर्दृष्टि साझा की

तीन सप्ताह पहले, कैल्विन फ्रेंच-ओवेन, एक इंजीनियर जिन्होंने OpenAI के एक प्रमुख उत्पाद में योगदान दिया, ने कंपनी छोड़ दी।उन्होंने हाल ही में एक आकर्षक ब्लॉग पोस्ट साझा किया जिसमें OpenAI में उनके एक स

पूर्व OpenAI इंजीनियर ने कंपनी संस्कृति और तेजी से विकास पर अंतर्दृष्टि साझा की

तीन सप्ताह पहले, कैल्विन फ्रेंच-ओवेन, एक इंजीनियर जिन्होंने OpenAI के एक प्रमुख उत्पाद में योगदान दिया, ने कंपनी छोड़ दी।उन्होंने हाल ही में एक आकर्षक ब्लॉग पोस्ट साझा किया जिसमें OpenAI में उनके एक स

Google ने उद्यम बाजार में OpenAI के साथ प्रतिस्पर्धा करने के लिए उत्पादन-तैयार Gemini 2.5 AI मॉडल्स का अनावरण किया

Google ने सोमवार को अपनी AI रणनीति को और मजबूत किया, उद्यम उपयोग के लिए अपने उन्नत Gemini 2.5 मॉडल्स को लॉन्च किया और कीमत व प्रदर्शन पर प्रतिस्पर्धा करने के लिए एक लागत-कुशल संस्करण पेश किया।Alphabet

Google ने उद्यम बाजार में OpenAI के साथ प्रतिस्पर्धा करने के लिए उत्पादन-तैयार Gemini 2.5 AI मॉडल्स का अनावरण किया

Google ने सोमवार को अपनी AI रणनीति को और मजबूत किया, उद्यम उपयोग के लिए अपने उन्नत Gemini 2.5 मॉडल्स को लॉन्च किया और कीमत व प्रदर्शन पर प्रतिस्पर्धा करने के लिए एक लागत-कुशल संस्करण पेश किया।Alphabet

मेटा AI प्रतिभा के लिए उच्च वेतन प्रदान करता है, 100 मिलियन डॉलर के साइनिंग बोनस से इनकार

मेटा अपने नए सुपरइंटेलिजेंस लैब में AI शोधकर्ताओं को आकर्षित करने के लिए लाखों डॉलर के मुआवजे पैकेज प्रदान कर रहा है। हालांकि, एक भर्ती किए गए शोधकर्ता और लीक हुई आंतरिक बैठक की टिप्पणियों के अनुसार,

मेटा AI प्रतिभा के लिए उच्च वेतन प्रदान करता है, 100 मिलियन डॉलर के साइनिंग बोनस से इनकार

मेटा अपने नए सुपरइंटेलिजेंस लैब में AI शोधकर्ताओं को आकर्षित करने के लिए लाखों डॉलर के मुआवजे पैकेज प्रदान कर रहा है। हालांकि, एक भर्ती किए गए शोधकर्ता और लीक हुई आंतरिक बैठक की टिप्पणियों के अनुसार,

7 अगस्त 2025 8:11:14 पूर्वाह्न IST

7 अगस्त 2025 8:11:14 पूर्वाह्न IST

The o3 model's benchmark slip-up is a bit of a letdown. 😕 I was hyped for OpenAI's big claims, but now I’m wondering if they’re overselling. Numbers don’t lie, but they can sure be misleading!

0

0

29 जुलाई 2025 5:55:16 अपराह्न IST

29 जुलाई 2025 5:55:16 अपराह्न IST

The o3 model's benchmark slip-up is wild! I was hyped for those big claims, but now it’s like finding out your favorite superhero has a weak spot. Still, AI’s moving so fast, I wonder if these benchmarks even keep up with real-world use. 🤔 Anyone else feel like we’re chasing numbers instead of actual progress?

0

0