MIPS से लेकर एक्साफ्लॉप्स तक कुछ ही दशकों में: कंप्यूटिंग शक्ति का विस्फोट हो रहा है, और यह AI को बदल देगा

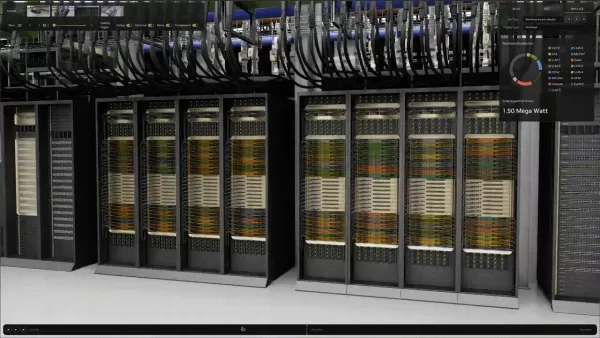

हाल ही में Nvidia GTC सम्मेलन में, टेक दिग्गज ने एक अभूतपूर्व उपलब्धि का अनावरण किया: सर्वरों की पहली एकल-रैक प्रणाली जो एक एक्साफ्लॉप तक पहुंचने में सक्षम है। यह एक अकल्पनीय एक अरब अरब फ्लोटिंग-पॉइंट ऑपरेशंस (FLOPS) प्रति सेकंड है। यह उपलब्धि Nvidia के नवीनतम GB200 NVL72 सिस्टम द्वारा संचालित है, जिसमें अत्याधुनिक ब्लैकवेल ग्राफिक्स प्रोसेसिंग यूनिट्स (GPUs) शामिल हैं। इसे परिप्रेक्ष्य में रखने के लिए, यह सिस्टम एक मानक कंप्यूटर रैक में फिट होता है जो लगभग 6 फीट ऊंचा, थोड़ा सा 3 फीट गहरा, और 2 फीट से कम चौड़ा है।

एक्साफ्लॉप को छोटा करना: फ्रंटियर से ब्लैकवेल तक

इस घोषणा ने मुझे सोचने पर मजबूर कर दिया कि हम कुछ ही वर्षों में कितना आगे आ गए हैं। दुनिया का पहला एक्साफ्लॉप-सक्षम कंप्यूटर, "Frontier," 2022 में ओक रिज नेशनल लेबोरेटरी में स्थापित किया गया था। HPE द्वारा निर्मित और AMD GPUs और CPUs द्वारा संचालित, यह 74 रैक तक फैला हुआ था। इसके विपरीत, Nvidia का नया सिस्टम एक ही रैक में 73 गुना अधिक प्रदर्शन पैक करता है। यह हर साल तीन साल तक प्रदर्शन को तीन गुना करने जैसा है! यह कंप्यूटिंग घनत्व, ऊर्जा दक्षता, और वास्तुशिल्प डिजाइन में की गई अविश्वसनीय प्रगति का प्रमाण है।

यह भी ध्यान देने योग्य है कि हालांकि दोनों सिस्टम एक्सास्केल मील का पत्थर तक पहुंचते हैं, वे विभिन्न उद्देश्यों के लिए डिज़ाइन किए गए हैं। Nvidia का एक्साफ्लॉप रेटिंग निम्न-परिशुद्धता गणित पर आधारित है—4-बिट और 8-बिट फ्लोटिंग-पॉइंट ऑपरेशंस—जो AI वर्कलोड जैसे बड़े भाषा मॉडल (LLMs) को प्रशिक्षित करने और चलाने के लिए आदर्श हैं। ये गणनाएं सटीकता से अधिक गति को प्राथमिकता देती हैं। दूसरी ओर, फ्रंटियर का एक्साफ्लॉप रेटिंग 64-बिट डबल-प्रिसिजन गणित से आता है, जो वैज्ञानिक सिमुलेशन के लिए स्वर्ण मानक है जहां सटीकता सर्वोपरि है।

हम बहुत तेजी से बहुत आगे आ गए हैं

इस प्रगति की गति लगभग अविश्वसनीय है, खासकर जब मैं अपने कंप्यूटिंग करियर के शुरुआती दिनों को याद करता हूं। मेरा पहला काम DEC KL 1090 पर प्रोग्रामर के रूप में था, जो DEC के PDP-10 सीरीज के टाइमशेयर मेनफ्रेम का हिस्सा था। वह मशीन 1.8 मिलियन निर्देश प्रति सेकंड (MIPS) की मामूली गति से चलती थी। यह कैथोड रे ट्यूब (CRT) डिस्प्ले से हार्डवायर्ड केबल के माध्यम से जुड़ती थी, जिसमें कोई ग्राफिक्स नहीं था—बस स्क्रीन पर टेक्स्ट। और निश्चित रूप से, कोई इंटरनेट नहीं था। दूरस्थ उपयोगकर्ताओं को 1,200 बिट्स प्रति सेकंड की अधिकतम गति वाले मॉडेम के साथ फोन लाइनों पर कनेक्ट करना पड़ता था।

500 अरब गुना अधिक कंप्यूटिंग शक्ति

हालांकि MIPS और FLOPS की तुलना करना सीधे तौर पर सेब की सेब से तुलना नहीं है, यह हमें कंप्यूटिंग शक्ति में हुई अविश्वसनीय छलांग का अंदाजा देता है। MIPS पूर्णांक प्रसंस्करण गति को मापता है, जो सामान्य-उद्देश्यीय कंप्यूटिंग और व्यावसायिक अनुप्रयोगों के लिए बढ़िया है। दूसरी ओर, FLOPS फ्लोटिंग-पॉइंट प्रदर्शन को मापता है, जो वैज्ञानिक वर्कलोड और आधुनिक AI के पीछे भारी काम के लिए महत्वपूर्ण है, जैसे कि मशीन लर्निंग (ML) मॉडल को प्रशिक्षित करने और चलाने के लिए आवश्यक मैट्रिक्स गणित और रैखिक बीजगणित।

इनका उपयोग एक मोटे मार्गदर्शक के रूप में करने पर, नया Nvidia सिस्टम पुरानी DEC मशीन की तुलना में लगभग 500 अरब गुना अधिक शक्तिशाली है। यह एक ही करियर में कंप्यूटिंग शक्ति में घातीय वृद्धि का एक आश्चर्यजनक उदाहरण है। यह आपको सोचने पर मजबूर करता है: अगर हमने 40 वर्षों में इतना कुछ हासिल कर लिया है, तो अगले पांच वर्ष क्या ला सकते हैं?

Nvidia ने हमें कुछ संकेत दिए हैं। GTC में, उन्होंने एक रोडमैप साझा किया जिसमें भविष्यवाणी की गई कि उनकी अगली पीढ़ी का पूर्ण-रैक सिस्टम, "Vera Rubin" Ultra आर्किटेक्चर पर आधारित, वर्तमान ब्लैकवेल Ultra रैक के प्रदर्शन का 14 गुना प्रदान करेगा। हम अगले एक या दो वर्षों में AI-अनुकूलित कार्य में 14 से 15 एक्साफ्लॉप्स के बीच कहीं देख रहे हैं।

यह केवल कच्ची शक्ति के बारे में नहीं है। इस प्रदर्शन को एक ही रैक में समेटने का मतलब है कम भौतिक स्थान, कम सामग्री, और प्रति ऑपरेशन संभावित रूप से कम ऊर्जा उपयोग। हालांकि, यह नहीं भूलना चाहिए कि इन सिस्टमों की पूर्ण ऊर्जा मांग अभी भी बहुत अधिक है।

क्या AI को वाकई इतनी कंप्यूटिंग शक्ति की आवश्यकता है?

हालांकि ये प्रदर्शन लाभ प्रभावशाली हैं, AI उद्योग अब एक बड़े सवाल से जूझ रहा है: हमें वास्तव में कितनी कंप्यूटिंग शक्ति की आवश्यकता है, और इसकी कीमत क्या है? विशाल नए AI डेटा सेंटर बनाने की दौड़ एक्सास्केल कंप्यूटिंग और तेजी से सक्षम AI मॉडल की मांगों से प्रेरित है।

सबसे महत्वाकांक्षी परियोजना है $500 बिलियन की प्रोजेक्ट स्टारगेट, जो अमेरिका में 20 डेटा सेंटर की योजना बना रही है, प्रत्येक आधा मिलियन वर्ग फीट का। दुनिया भर में अन्य हाइपरस्केल परियोजनाओं की लहर चल रही है या योजना में है क्योंकि कंपनियां और देश भविष्य के AI वर्कलोड के लिए बुनियादी ढांचा बनाने की जल्दी में हैं।

कुछ विश्लेषकों को चिंता है कि हम अतिनिर्माण कर रहे हैं। चिंताएं तब बढ़ीं जब चीन के डीपसीक से R1, एक तर्क मॉडल जारी हुआ, जो अपने समकक्षों की तुलना में काफी कम कंप्यूट का उपयोग करता है। माइक्रोसॉफ्ट द्वारा हाल ही में कई डेटा सेंटर प्रदाताओं के साथ लीज रद्द करने से यह अटकलें बढ़ी हैं कि वे अपनी AI बुनियादी ढांचे की जरूरतों पर पुनर्विचार कर रहे हैं।

हालांकि, The Register ने सुझाव दिया कि यह पीछे हटना शायद इसलिए हो सकता है क्योंकि नियोजित डेटा सेंटर अगली पीढ़ी के AI सिस्टमों की बिजली और कूलिंग जरूरतों को संभालने में सक्षम नहीं हैं। AI मॉडल पहले से ही वर्तमान बुनियादी ढांचे की सीमाओं को धक्का दे रहे हैं। MIT टेक्नोलॉजी रिव्यू ने बताया कि चीन में कई डेटा सेंटर पुराने विनिर्देशों के लिए बनाए गए होने के कारण संघर्ष कर रहे हैं और असफल हो रहे हैं।

AI अनुमान को और अधिक FLOPS की आवश्यकता

तर्क मॉडल रनटाइम पर अनुमान प्रक्रिया के माध्यम से अपना अधिकांश भारी काम करते हैं। ये मॉडल कुछ सबसे उन्नत और संसाधन-गहन अनुप्रयोगों को शक्ति प्रदान करते हैं, जैसे गहरे शोध सहायक और उभरती हुई एजेंटिक AI सिस्टम की लहर।

हालांकि डीपसीक-R1 ने शुरू में उद्योग को यह सोचने के लिए प्रेरित किया कि भविष्य के AI को कम कंप्यूटिंग शक्ति की आवश्यकता हो सकती है, Nvidia के CEO जेन्सेन हुआंग ने इसका कड़ा विरोध किया। CNBC को दिए एक साक्षात्कार में, उन्होंने इसके विपरीत तर्क दिया: "यह वह निष्कर्ष था जो सभी के पास था।" उन्होंने कहा कि तर्क AI गैर-तर्क AI की तुलना में 100 गुना अधिक कंप्यूटिंग खपत करता है।

जैसे-जैसे AI तर्क मॉडल से स्वायत्त एजेंट्स और उससे आगे विकसित होता है, कंप्यूटिंग शक्ति की मांग फिर से बढ़ने की संभावना है। अगली सफलताएं AI एजेंट समन्वय, फ्यूजन सिमुलेशन, या बड़े पैमाने पर डिजिटल ट्विन्स जैसे क्षेत्रों में आ सकती हैं—जो सभी हाल ही में देखी गई कंप्यूटिंग छलांग से संभव हुई हैं।

बिल्कुल सही समय पर, OpenAI ने $40 बिलियन के नए फंडिंग की घोषणा की, जो निजी टेक फंडिंग का सबसे बड़ा रिकॉर्ड है। एक ब्लॉग पोस्ट में, उन्होंने कहा कि यह फंडिंग "हमें AI अनुसंधान की सीमाओं को और आगे बढ़ाने, हमारे कंप्यूट बुनियादी ढांचे को स्केल करने और हर हफ्ते चैटGPT का उपयोग करने वाले 500 मिलियन लोगों के लिए तेजी से शक्तिशाली उपकरण प्रदान करने में सक्षम बनाती है।"

इतना पूंजी AI में क्यों बह रही है? कारण प्रतिस्पर्धा से लेकर राष्ट्रीय सुरक्षा तक हैं, लेकिन एक कारक सबसे अलग है: मैकिन्से के अनुसार, AI कॉर्पोरेट मुनाफे को प्रति वर्ष $4.4 ट्रिलियन तक बढ़ा सकता है।

आगे क्या होगा? यह किसी का भी अनुमान है

अपने मूल में, सूचना प्रणालियां जटिलता को सरल बनाने के बारे में हैं, चाहे वह फोरट्रान में लिखा गया एक आपातकालीन वाहन रूटिंग सिस्टम हो, COBOL में निर्मित एक छात्र उपलब्धि रिपोर्टिंग टूल हो, या आधुनिक AI सिस्टम जो दवा खोज को तेज कर रहे हों। लक्ष्य हमेशा एक ही रहा है: दुनिया को समझने में मदद करना।

अब, शक्तिशाली AI के क्षितिज पर होने के साथ, हम एक नई सीमा पार कर रहे हैं। पहली बार, हमारे पास उन समस्याओं से निपटने के लिए कंप्यूटिंग शक्ति और बुद्धिमत्ता हो सकती है जो कभी मानव पहुंच से बाहर थीं।

न्यूयॉर्क टाइम्स के कॉलमिस्ट केविन रूज ने इस क्षण को अच्छी तरह से कैद किया: "हर हफ्ते, मैं AI पर काम करने वाले इंजीनियरों और उद्यमियों से मिलता हूं जो मुझे बताते हैं कि परिवर्तन—बड़ा परिवर्तन, विश्व को हिला देने वाला परिवर्तन, वह परिवर्तन जो हमने पहले कभी नहीं देखा—बस कोने के आसपास है।" और यह उन सफलताओं को नहीं गिन रहा जो हर हफ्ते आ रही हैं।

पिछले कुछ दिनों में ही, हमने देखा है कि OpenAI का GPT-4o टेक्स्ट से लगभग पूर्ण छवियां उत्पन्न करता है, Google ने Gemini 2.5 Pro में शायद अब तक का सबसे उन्नत तर्क मॉडल जारी किया, और Runway ने एक वीडियो मॉडल का अनावरण किया जिसमें शॉट-टू-शॉट कैरेक्टर और सीन कंसिस्टेंसी है, जो वेंचरबीट के अनुसार अब तक अधिकांश AI वीडियो जनरेटरों के लिए असंभव रहा है।

आगे क्या होगा, यह वास्तव में किसी का भी अनुमान है। हमें नहीं पता कि शक्तिशाली AI एक सफलता होगी या टूटन, क्या यह फ्यूजन ऊर्जा को हल करने में मदद करेगा या नए जैविक जोखिमों को जन्म देगा। लेकिन अगले पांच वर्षों में और अधिक FLOPS ऑनलाइन आने के साथ, एक बात निश्चित लगती है: नवाचार तेजी से आएगा—और बल के साथ। जैसे-जैसे FLOPS स्केल करता है, वैसे ही जिम्मेदारी, विनियमन, और संयम के बारे में हमारी बातचीत को भी बढ़ाना होगा।

गैरी ग्रॉसमैन Edelman में प्रौद्योगिकी अभ्यास के EVP और Edelman AI Center of Excellence के वैश्विक प्रमुख हैं।

संबंधित लेख

नई अध्ययन से पता चलता है कि LLM वास्तव में कितना डेटा याद करते हैं

AI मॉडल वास्तव में कितना याद करते हैं? नया शोध आश्चर्यजनक जानकारी देता हैहम सभी जानते हैं कि बड़े भाषा मॉडल (LLM) जैसे ChatGPT, Claude, और Gemini को किताबों, वेबसाइटों, कोड और यहां तक कि चित्रों और ऑड

नई अध्ययन से पता चलता है कि LLM वास्तव में कितना डेटा याद करते हैं

AI मॉडल वास्तव में कितना याद करते हैं? नया शोध आश्चर्यजनक जानकारी देता हैहम सभी जानते हैं कि बड़े भाषा मॉडल (LLM) जैसे ChatGPT, Claude, और Gemini को किताबों, वेबसाइटों, कोड और यहां तक कि चित्रों और ऑड

एनवीडिया ने एआई फैक्ट्री डिजिटल ट्विन्स के लिए ओम्निवर्स ब्लूप्रिंट प्रदान किया

एनवीडिया ने एआई फैक्ट्री डिजिटल ट्विन्स के लिए ओम्निवर्स ब्लूप्रिंट का प्रमुख विस्तार कियाताइपे में Computex 2025 में एक प्रमुख घोषणा में, एनवीडिया ने अपने ओम्निवर्स ब्लूप्रिंट फॉर एआई फैक्ट्री डिजिटल

एनवीडिया ने एआई फैक्ट्री डिजिटल ट्विन्स के लिए ओम्निवर्स ब्लूप्रिंट प्रदान किया

एनवीडिया ने एआई फैक्ट्री डिजिटल ट्विन्स के लिए ओम्निवर्स ब्लूप्रिंट का प्रमुख विस्तार कियाताइपे में Computex 2025 में एक प्रमुख घोषणा में, एनवीडिया ने अपने ओम्निवर्स ब्लूप्रिंट फॉर एआई फैक्ट्री डिजिटल

ह्यूएव्ही सुपरनोड 384, न्विडिया के AI बाजार पर अधिपत्य को बदल देता है

ह्यूएवेई की AI प्रोसेसिंग आर्किटेक्चर में तकनीकी विजय: सपरनोड 384 आर्टिफिशियल इंटेलिजेंस के बदलते रूप में, ह्यूएवेई ने अपनी सपरनोड 384 आर्किटेक्चर के साथ विश्वासघात लाए हैं, प्रोस

सूचना (2)

0/200

ह्यूएव्ही सुपरनोड 384, न्विडिया के AI बाजार पर अधिपत्य को बदल देता है

ह्यूएवेई की AI प्रोसेसिंग आर्किटेक्चर में तकनीकी विजय: सपरनोड 384 आर्टिफिशियल इंटेलिजेंस के बदलते रूप में, ह्यूएवेई ने अपनी सपरनोड 384 आर्किटेक्चर के साथ विश्वासघात लाए हैं, प्रोस

सूचना (2)

0/200

![MarkGonzalez]() MarkGonzalez

MarkGonzalez

28 जुलाई 2025 6:50:21 पूर्वाह्न IST

28 जुलाई 2025 6:50:21 पूर्वाह्न IST

Mind blown! An exaflop in a single rack? Nvidia's pushing AI into hyperspace. Can't wait to see what crazy applications come next. 🚀

0

0

![MatthewHill]() MatthewHill

MatthewHill

22 जुलाई 2025 6:55:03 पूर्वाह्न IST

22 जुलाई 2025 6:55:03 पूर्वाह्न IST

Mind blown by this exaflop server rack! Nvidia's pushing AI compute to insane levels. Can't wait to see what crazy applications come out of this power. 🚀

0

0

हाल ही में Nvidia GTC सम्मेलन में, टेक दिग्गज ने एक अभूतपूर्व उपलब्धि का अनावरण किया: सर्वरों की पहली एकल-रैक प्रणाली जो एक एक्साफ्लॉप तक पहुंचने में सक्षम है। यह एक अकल्पनीय एक अरब अरब फ्लोटिंग-पॉइंट ऑपरेशंस (FLOPS) प्रति सेकंड है। यह उपलब्धि Nvidia के नवीनतम GB200 NVL72 सिस्टम द्वारा संचालित है, जिसमें अत्याधुनिक ब्लैकवेल ग्राफिक्स प्रोसेसिंग यूनिट्स (GPUs) शामिल हैं। इसे परिप्रेक्ष्य में रखने के लिए, यह सिस्टम एक मानक कंप्यूटर रैक में फिट होता है जो लगभग 6 फीट ऊंचा, थोड़ा सा 3 फीट गहरा, और 2 फीट से कम चौड़ा है।

एक्साफ्लॉप को छोटा करना: फ्रंटियर से ब्लैकवेल तक

इस घोषणा ने मुझे सोचने पर मजबूर कर दिया कि हम कुछ ही वर्षों में कितना आगे आ गए हैं। दुनिया का पहला एक्साफ्लॉप-सक्षम कंप्यूटर, "Frontier," 2022 में ओक रिज नेशनल लेबोरेटरी में स्थापित किया गया था। HPE द्वारा निर्मित और AMD GPUs और CPUs द्वारा संचालित, यह 74 रैक तक फैला हुआ था। इसके विपरीत, Nvidia का नया सिस्टम एक ही रैक में 73 गुना अधिक प्रदर्शन पैक करता है। यह हर साल तीन साल तक प्रदर्शन को तीन गुना करने जैसा है! यह कंप्यूटिंग घनत्व, ऊर्जा दक्षता, और वास्तुशिल्प डिजाइन में की गई अविश्वसनीय प्रगति का प्रमाण है।

यह भी ध्यान देने योग्य है कि हालांकि दोनों सिस्टम एक्सास्केल मील का पत्थर तक पहुंचते हैं, वे विभिन्न उद्देश्यों के लिए डिज़ाइन किए गए हैं। Nvidia का एक्साफ्लॉप रेटिंग निम्न-परिशुद्धता गणित पर आधारित है—4-बिट और 8-बिट फ्लोटिंग-पॉइंट ऑपरेशंस—जो AI वर्कलोड जैसे बड़े भाषा मॉडल (LLMs) को प्रशिक्षित करने और चलाने के लिए आदर्श हैं। ये गणनाएं सटीकता से अधिक गति को प्राथमिकता देती हैं। दूसरी ओर, फ्रंटियर का एक्साफ्लॉप रेटिंग 64-बिट डबल-प्रिसिजन गणित से आता है, जो वैज्ञानिक सिमुलेशन के लिए स्वर्ण मानक है जहां सटीकता सर्वोपरि है।

हम बहुत तेजी से बहुत आगे आ गए हैं

इस प्रगति की गति लगभग अविश्वसनीय है, खासकर जब मैं अपने कंप्यूटिंग करियर के शुरुआती दिनों को याद करता हूं। मेरा पहला काम DEC KL 1090 पर प्रोग्रामर के रूप में था, जो DEC के PDP-10 सीरीज के टाइमशेयर मेनफ्रेम का हिस्सा था। वह मशीन 1.8 मिलियन निर्देश प्रति सेकंड (MIPS) की मामूली गति से चलती थी। यह कैथोड रे ट्यूब (CRT) डिस्प्ले से हार्डवायर्ड केबल के माध्यम से जुड़ती थी, जिसमें कोई ग्राफिक्स नहीं था—बस स्क्रीन पर टेक्स्ट। और निश्चित रूप से, कोई इंटरनेट नहीं था। दूरस्थ उपयोगकर्ताओं को 1,200 बिट्स प्रति सेकंड की अधिकतम गति वाले मॉडेम के साथ फोन लाइनों पर कनेक्ट करना पड़ता था।

500 अरब गुना अधिक कंप्यूटिंग शक्ति

हालांकि MIPS और FLOPS की तुलना करना सीधे तौर पर सेब की सेब से तुलना नहीं है, यह हमें कंप्यूटिंग शक्ति में हुई अविश्वसनीय छलांग का अंदाजा देता है। MIPS पूर्णांक प्रसंस्करण गति को मापता है, जो सामान्य-उद्देश्यीय कंप्यूटिंग और व्यावसायिक अनुप्रयोगों के लिए बढ़िया है। दूसरी ओर, FLOPS फ्लोटिंग-पॉइंट प्रदर्शन को मापता है, जो वैज्ञानिक वर्कलोड और आधुनिक AI के पीछे भारी काम के लिए महत्वपूर्ण है, जैसे कि मशीन लर्निंग (ML) मॉडल को प्रशिक्षित करने और चलाने के लिए आवश्यक मैट्रिक्स गणित और रैखिक बीजगणित।

इनका उपयोग एक मोटे मार्गदर्शक के रूप में करने पर, नया Nvidia सिस्टम पुरानी DEC मशीन की तुलना में लगभग 500 अरब गुना अधिक शक्तिशाली है। यह एक ही करियर में कंप्यूटिंग शक्ति में घातीय वृद्धि का एक आश्चर्यजनक उदाहरण है। यह आपको सोचने पर मजबूर करता है: अगर हमने 40 वर्षों में इतना कुछ हासिल कर लिया है, तो अगले पांच वर्ष क्या ला सकते हैं?

Nvidia ने हमें कुछ संकेत दिए हैं। GTC में, उन्होंने एक रोडमैप साझा किया जिसमें भविष्यवाणी की गई कि उनकी अगली पीढ़ी का पूर्ण-रैक सिस्टम, "Vera Rubin" Ultra आर्किटेक्चर पर आधारित, वर्तमान ब्लैकवेल Ultra रैक के प्रदर्शन का 14 गुना प्रदान करेगा। हम अगले एक या दो वर्षों में AI-अनुकूलित कार्य में 14 से 15 एक्साफ्लॉप्स के बीच कहीं देख रहे हैं।

यह केवल कच्ची शक्ति के बारे में नहीं है। इस प्रदर्शन को एक ही रैक में समेटने का मतलब है कम भौतिक स्थान, कम सामग्री, और प्रति ऑपरेशन संभावित रूप से कम ऊर्जा उपयोग। हालांकि, यह नहीं भूलना चाहिए कि इन सिस्टमों की पूर्ण ऊर्जा मांग अभी भी बहुत अधिक है।

क्या AI को वाकई इतनी कंप्यूटिंग शक्ति की आवश्यकता है?

हालांकि ये प्रदर्शन लाभ प्रभावशाली हैं, AI उद्योग अब एक बड़े सवाल से जूझ रहा है: हमें वास्तव में कितनी कंप्यूटिंग शक्ति की आवश्यकता है, और इसकी कीमत क्या है? विशाल नए AI डेटा सेंटर बनाने की दौड़ एक्सास्केल कंप्यूटिंग और तेजी से सक्षम AI मॉडल की मांगों से प्रेरित है।

सबसे महत्वाकांक्षी परियोजना है $500 बिलियन की प्रोजेक्ट स्टारगेट, जो अमेरिका में 20 डेटा सेंटर की योजना बना रही है, प्रत्येक आधा मिलियन वर्ग फीट का। दुनिया भर में अन्य हाइपरस्केल परियोजनाओं की लहर चल रही है या योजना में है क्योंकि कंपनियां और देश भविष्य के AI वर्कलोड के लिए बुनियादी ढांचा बनाने की जल्दी में हैं।

कुछ विश्लेषकों को चिंता है कि हम अतिनिर्माण कर रहे हैं। चिंताएं तब बढ़ीं जब चीन के डीपसीक से R1, एक तर्क मॉडल जारी हुआ, जो अपने समकक्षों की तुलना में काफी कम कंप्यूट का उपयोग करता है। माइक्रोसॉफ्ट द्वारा हाल ही में कई डेटा सेंटर प्रदाताओं के साथ लीज रद्द करने से यह अटकलें बढ़ी हैं कि वे अपनी AI बुनियादी ढांचे की जरूरतों पर पुनर्विचार कर रहे हैं।

हालांकि, The Register ने सुझाव दिया कि यह पीछे हटना शायद इसलिए हो सकता है क्योंकि नियोजित डेटा सेंटर अगली पीढ़ी के AI सिस्टमों की बिजली और कूलिंग जरूरतों को संभालने में सक्षम नहीं हैं। AI मॉडल पहले से ही वर्तमान बुनियादी ढांचे की सीमाओं को धक्का दे रहे हैं। MIT टेक्नोलॉजी रिव्यू ने बताया कि चीन में कई डेटा सेंटर पुराने विनिर्देशों के लिए बनाए गए होने के कारण संघर्ष कर रहे हैं और असफल हो रहे हैं।

AI अनुमान को और अधिक FLOPS की आवश्यकता

तर्क मॉडल रनटाइम पर अनुमान प्रक्रिया के माध्यम से अपना अधिकांश भारी काम करते हैं। ये मॉडल कुछ सबसे उन्नत और संसाधन-गहन अनुप्रयोगों को शक्ति प्रदान करते हैं, जैसे गहरे शोध सहायक और उभरती हुई एजेंटिक AI सिस्टम की लहर।

हालांकि डीपसीक-R1 ने शुरू में उद्योग को यह सोचने के लिए प्रेरित किया कि भविष्य के AI को कम कंप्यूटिंग शक्ति की आवश्यकता हो सकती है, Nvidia के CEO जेन्सेन हुआंग ने इसका कड़ा विरोध किया। CNBC को दिए एक साक्षात्कार में, उन्होंने इसके विपरीत तर्क दिया: "यह वह निष्कर्ष था जो सभी के पास था।" उन्होंने कहा कि तर्क AI गैर-तर्क AI की तुलना में 100 गुना अधिक कंप्यूटिंग खपत करता है।

जैसे-जैसे AI तर्क मॉडल से स्वायत्त एजेंट्स और उससे आगे विकसित होता है, कंप्यूटिंग शक्ति की मांग फिर से बढ़ने की संभावना है। अगली सफलताएं AI एजेंट समन्वय, फ्यूजन सिमुलेशन, या बड़े पैमाने पर डिजिटल ट्विन्स जैसे क्षेत्रों में आ सकती हैं—जो सभी हाल ही में देखी गई कंप्यूटिंग छलांग से संभव हुई हैं।

बिल्कुल सही समय पर, OpenAI ने $40 बिलियन के नए फंडिंग की घोषणा की, जो निजी टेक फंडिंग का सबसे बड़ा रिकॉर्ड है। एक ब्लॉग पोस्ट में, उन्होंने कहा कि यह फंडिंग "हमें AI अनुसंधान की सीमाओं को और आगे बढ़ाने, हमारे कंप्यूट बुनियादी ढांचे को स्केल करने और हर हफ्ते चैटGPT का उपयोग करने वाले 500 मिलियन लोगों के लिए तेजी से शक्तिशाली उपकरण प्रदान करने में सक्षम बनाती है।"

इतना पूंजी AI में क्यों बह रही है? कारण प्रतिस्पर्धा से लेकर राष्ट्रीय सुरक्षा तक हैं, लेकिन एक कारक सबसे अलग है: मैकिन्से के अनुसार, AI कॉर्पोरेट मुनाफे को प्रति वर्ष $4.4 ट्रिलियन तक बढ़ा सकता है।

आगे क्या होगा? यह किसी का भी अनुमान है

अपने मूल में, सूचना प्रणालियां जटिलता को सरल बनाने के बारे में हैं, चाहे वह फोरट्रान में लिखा गया एक आपातकालीन वाहन रूटिंग सिस्टम हो, COBOL में निर्मित एक छात्र उपलब्धि रिपोर्टिंग टूल हो, या आधुनिक AI सिस्टम जो दवा खोज को तेज कर रहे हों। लक्ष्य हमेशा एक ही रहा है: दुनिया को समझने में मदद करना।

अब, शक्तिशाली AI के क्षितिज पर होने के साथ, हम एक नई सीमा पार कर रहे हैं। पहली बार, हमारे पास उन समस्याओं से निपटने के लिए कंप्यूटिंग शक्ति और बुद्धिमत्ता हो सकती है जो कभी मानव पहुंच से बाहर थीं।

न्यूयॉर्क टाइम्स के कॉलमिस्ट केविन रूज ने इस क्षण को अच्छी तरह से कैद किया: "हर हफ्ते, मैं AI पर काम करने वाले इंजीनियरों और उद्यमियों से मिलता हूं जो मुझे बताते हैं कि परिवर्तन—बड़ा परिवर्तन, विश्व को हिला देने वाला परिवर्तन, वह परिवर्तन जो हमने पहले कभी नहीं देखा—बस कोने के आसपास है।" और यह उन सफलताओं को नहीं गिन रहा जो हर हफ्ते आ रही हैं।

पिछले कुछ दिनों में ही, हमने देखा है कि OpenAI का GPT-4o टेक्स्ट से लगभग पूर्ण छवियां उत्पन्न करता है, Google ने Gemini 2.5 Pro में शायद अब तक का सबसे उन्नत तर्क मॉडल जारी किया, और Runway ने एक वीडियो मॉडल का अनावरण किया जिसमें शॉट-टू-शॉट कैरेक्टर और सीन कंसिस्टेंसी है, जो वेंचरबीट के अनुसार अब तक अधिकांश AI वीडियो जनरेटरों के लिए असंभव रहा है।

आगे क्या होगा, यह वास्तव में किसी का भी अनुमान है। हमें नहीं पता कि शक्तिशाली AI एक सफलता होगी या टूटन, क्या यह फ्यूजन ऊर्जा को हल करने में मदद करेगा या नए जैविक जोखिमों को जन्म देगा। लेकिन अगले पांच वर्षों में और अधिक FLOPS ऑनलाइन आने के साथ, एक बात निश्चित लगती है: नवाचार तेजी से आएगा—और बल के साथ। जैसे-जैसे FLOPS स्केल करता है, वैसे ही जिम्मेदारी, विनियमन, और संयम के बारे में हमारी बातचीत को भी बढ़ाना होगा।

गैरी ग्रॉसमैन Edelman में प्रौद्योगिकी अभ्यास के EVP और Edelman AI Center of Excellence के वैश्विक प्रमुख हैं।

नई अध्ययन से पता चलता है कि LLM वास्तव में कितना डेटा याद करते हैं

AI मॉडल वास्तव में कितना याद करते हैं? नया शोध आश्चर्यजनक जानकारी देता हैहम सभी जानते हैं कि बड़े भाषा मॉडल (LLM) जैसे ChatGPT, Claude, और Gemini को किताबों, वेबसाइटों, कोड और यहां तक कि चित्रों और ऑड

नई अध्ययन से पता चलता है कि LLM वास्तव में कितना डेटा याद करते हैं

AI मॉडल वास्तव में कितना याद करते हैं? नया शोध आश्चर्यजनक जानकारी देता हैहम सभी जानते हैं कि बड़े भाषा मॉडल (LLM) जैसे ChatGPT, Claude, और Gemini को किताबों, वेबसाइटों, कोड और यहां तक कि चित्रों और ऑड

एनवीडिया ने एआई फैक्ट्री डिजिटल ट्विन्स के लिए ओम्निवर्स ब्लूप्रिंट प्रदान किया

एनवीडिया ने एआई फैक्ट्री डिजिटल ट्विन्स के लिए ओम्निवर्स ब्लूप्रिंट का प्रमुख विस्तार कियाताइपे में Computex 2025 में एक प्रमुख घोषणा में, एनवीडिया ने अपने ओम्निवर्स ब्लूप्रिंट फॉर एआई फैक्ट्री डिजिटल

एनवीडिया ने एआई फैक्ट्री डिजिटल ट्विन्स के लिए ओम्निवर्स ब्लूप्रिंट प्रदान किया

एनवीडिया ने एआई फैक्ट्री डिजिटल ट्विन्स के लिए ओम्निवर्स ब्लूप्रिंट का प्रमुख विस्तार कियाताइपे में Computex 2025 में एक प्रमुख घोषणा में, एनवीडिया ने अपने ओम्निवर्स ब्लूप्रिंट फॉर एआई फैक्ट्री डिजिटल

28 जुलाई 2025 6:50:21 पूर्वाह्न IST

28 जुलाई 2025 6:50:21 पूर्वाह्न IST

Mind blown! An exaflop in a single rack? Nvidia's pushing AI into hyperspace. Can't wait to see what crazy applications come next. 🚀

0

0

22 जुलाई 2025 6:55:03 पूर्वाह्न IST

22 जुलाई 2025 6:55:03 पूर्वाह्न IST

Mind blown by this exaflop server rack! Nvidia's pushing AI compute to insane levels. Can't wait to see what crazy applications come out of this power. 🚀

0

0