विशेषज्ञों द्वारा पूछे गए एआई स्केलिंग सफलता

सोशल मीडिया पर कुछ चर्चा हुई है कि शोधकर्ताओं ने एक नया AI "स्केलिंग लॉ" खोजा है, लेकिन विशेषज्ञ इसे संदेह के साथ ले रहे हैं। AI स्केलिंग लॉ, जो अधिकतर अनौपचारिक दिशानिर्देशों की तरह हैं, दिखाते हैं कि AI मॉडल अधिक डेटा और कम्प्यूटिंग शक्ति देने पर बेहतर होते हैं। लगभग एक साल पहले तक, बड़ा रुझान "प्री-ट्रेनिंग" के बारे में था – यानी, बड़े मॉडलों को बड़े डेटासेट पर प्रशिक्षित करना। यह अभी भी प्रचलित है, लेकिन अब हमारे पास दो और स्केलिंग लॉ हैं: पोस्ट-ट्रेनिंग स्केलिंग, जो मॉडल के व्यवहार को ठीक करने के बारे में है, और टेस्ट-टाइम स्केलिंग, जिसमें अनुमान के दौरान अधिक कम्प्यूटिंग शक्ति का उपयोग करके मॉडल की "रीजनिंग" क्षमताओं को बढ़ाया जाता है (जैसे R1 मॉडल)।

हाल ही में, Google और UC Berkeley के शोधकर्ताओं ने एक पेपर प्रकाशित किया, जिसे कुछ लोग ऑनलाइन चौथा लॉ कह रहे हैं: "इन्फरेंस-टाइम सर्च।" इस विधि में मॉडल एक सवाल के लिए कई संभावित जवाब एक साथ देता है और फिर सबसे अच्छा चुनता है। शोधकर्ताओं का दावा है कि यह किसी पुराने मॉडल, जैसे Google का Gemini 1.5 Pro, के प्रदर्शन को बढ़ाकर OpenAI के o1-preview "रीजनिंग" मॉडल को विज्ञान और गणित बेंचमार्क में हरा सकता है।

एरिक झाओ, Google के डॉक्टरेट फेलो और पेपर के सह-लेखकों में से एक, ने X पर साझा किया कि 200 जवाबों को रैंडमली सैंपल करके और मॉडल को स्वयं-जांच करने देकर, Gemini 1.5 – जिसे उन्होंने मजाक में "प्राचीन 2024 की शुरुआत का मॉडल" कहा – o1-preview को मात दे सकता है और o1 के करीब भी पहुंच सकता है। उन्होंने बताया कि स्वयं-जांच स्केल बढ़ाने पर आसान हो जाती है, जो थोड़ा उल्टा लेकिन रोचक है।

लेकिन हर कोई सहमत नहीं है। मैथ्यू गुज़डियाल, एक AI शोधकर्ता और यूनिवर्सिटी ऑफ अल्बर्टा में सहायक प्रोफेसर, ने TechCrunch को बताया कि यह दृष्टिकोण तब सबसे अच्छा काम करता है जब आपके पास जवाबों को आंकने का ठोस तरीका हो। ज्यादातर सवाल इतने सीधे नहीं होते। उन्होंने कहा, "अगर हम यह परिभाषित करने के लिए कोड नहीं लिख सकते कि हम क्या चाहते हैं, तो हम [इन्फरेंस-टाइम] सर्च का उपयोग नहीं कर सकते। सामान्य भाषा संवाद के लिए, हम यह नहीं कर सकते... यह आमतौर पर ज्यादातर समस्याओं को हल करने का अच्छा तरीका नहीं है।"

झाओ ने जवाब दिया कि उनका पेपर उन मामलों को देखता है जहां जवाबों को आंकने का स्पष्ट तरीका नहीं है, और मॉडल को खुद ही इसका पता लगाना पड़ता है। उन्होंने तर्क दिया कि स्पष्ट आंकने के तरीके और इसके अभाव के बीच का अंतर स्केल बढ़ाने पर कम हो सकता है।

माइक कुक, किंग्स कॉलेज लंदन में रिसर्च फेलो, ने गुज़डियाल के विचार का समर्थन किया, यह कहते हुए कि इन्फरेंस-टाइम सर्च वास्तव में मॉडल की रीजनिंग को बेहतर नहीं बनाता। यह मॉडल की आत्मविश्वास के साथ गलतियां करने की प्रवृत्ति का एक समाधान है। उन्होंने बताया कि अगर आपका मॉडल 5% बार गलती करता है, तो 200 कोशिशों की जांच करने से उन गलतियों को पकड़ना आसान हो जाता है।

यह खबर AI उद्योग के लिए थोड़ी निराशाजनक हो सकती है, जो हमेशा मॉडल की "रीजनिंग" को बढ़ाने के तरीकों की तलाश में रहता है बिना ज्यादा खर्च किए। जैसा कि पेपर के लेखकों ने उल्लेख किया, रीजनिंग मॉडल एक गणित समस्या को हल करने के लिए हजारों डॉलर की कम्प्यूटिंग लागत जमा कर सकते हैं।

नए स्केलिंग तकनीकों की खोज अभी खत्म नहीं हुई है।

अपडेट 3/20 5:12 सुबह प्रशांत: अध्ययन के सह-लेखक एरिक झाओ के टिप्पणियां जोड़ी गईं, जो एक स्वतंत्र शोधकर्ता द्वारा की गई आलोचना पर आपत्ति जताते हैं।

संबंधित लेख

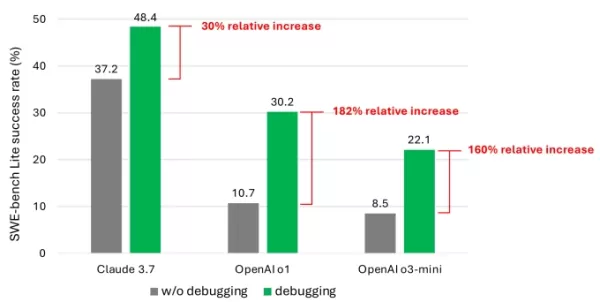

Microsoft Study Reveals AI Models' Limitations in Software Debugging

OpenAI, Anthropic और अन्य प्रमुख AI लैब्स के AI मॉडल कोडिंग कार्यों के लिए तेजी से उपयोग किए जा रहे हैं। Google CEO Sundar Pichai ने अक्टूबर में नोट किया कि AI कंपनी में 25% नए कोड जनरेट करता है, जबकि

Microsoft Study Reveals AI Models' Limitations in Software Debugging

OpenAI, Anthropic और अन्य प्रमुख AI लैब्स के AI मॉडल कोडिंग कार्यों के लिए तेजी से उपयोग किए जा रहे हैं। Google CEO Sundar Pichai ने अक्टूबर में नोट किया कि AI कंपनी में 25% नए कोड जनरेट करता है, जबकि

AI-चालित समाधान वैश्विक कार्बन उत्सर्जन को काफी हद तक कम कर सकते हैं

लंदन स्कूल ऑफ इकोनॉमिक्स और सिस्टमिक के एक हालिया अध्ययन से पता चलता है कि कृत्रिम बुद्धिमत्ता (AI) आधुनिक सुविधाओं को त्यागे बिना वैश्विक कार्बन उत्सर्जन को काफी हद तक कम कर सकती है, जिससे AI जलवायु

AI-चालित समाधान वैश्विक कार्बन उत्सर्जन को काफी हद तक कम कर सकते हैं

लंदन स्कूल ऑफ इकोनॉमिक्स और सिस्टमिक के एक हालिया अध्ययन से पता चलता है कि कृत्रिम बुद्धिमत्ता (AI) आधुनिक सुविधाओं को त्यागे बिना वैश्विक कार्बन उत्सर्जन को काफी हद तक कम कर सकती है, जिससे AI जलवायु

नई अध्ययन से पता चलता है कि LLM वास्तव में कितना डेटा याद करते हैं

AI मॉडल वास्तव में कितना याद करते हैं? नया शोध आश्चर्यजनक जानकारी देता हैहम सभी जानते हैं कि बड़े भाषा मॉडल (LLM) जैसे ChatGPT, Claude, और Gemini को किताबों, वेबसाइटों, कोड और यहां तक कि चित्रों और ऑड

सूचना (35)

0/200

नई अध्ययन से पता चलता है कि LLM वास्तव में कितना डेटा याद करते हैं

AI मॉडल वास्तव में कितना याद करते हैं? नया शोध आश्चर्यजनक जानकारी देता हैहम सभी जानते हैं कि बड़े भाषा मॉडल (LLM) जैसे ChatGPT, Claude, और Gemini को किताबों, वेबसाइटों, कोड और यहां तक कि चित्रों और ऑड

सूचना (35)

0/200

![DanielThomas]() DanielThomas

DanielThomas

24 अप्रैल 2025 5:19:41 पूर्वाह्न IST

24 अप्रैल 2025 5:19:41 पूर्वाह्न IST

AI 스케일링 돌파구는 멋지게 들리지만, 전문가들은 회의적이에요. 🤔 이제 뭘 믿어야 할지 모르겠어요. 그냥 과대광고일까요? 지켜볼게요, 하지만 기대는 하지 않을게요. 😴

0

0

![BenRoberts]() BenRoberts

BenRoberts

23 अप्रैल 2025 11:42:49 अपराह्न IST

23 अप्रैल 2025 11:42:49 अपराह्न IST

This AI scaling law thing sounds cool, but it's hard to get excited when experts are so skeptical. It's like they're saying, 'Sure, it's interesting, but let's not get carried away.' I guess we'll see if it's the real deal or just another hype train. 🤔

0

0

![PatrickMartinez]() PatrickMartinez

PatrickMartinez

22 अप्रैल 2025 1:01:56 पूर्वाह्न IST

22 अप्रैल 2025 1:01:56 पूर्वाह्न IST

Essa história de lei de escalabilidade de IA parece legal, mas é difícil se empolgar quando os especialistas são tão céticos. Parece que eles estão dizendo, 'Sim, é interessante, mas não vamos nos empolgar muito'. Vamos ver se é verdade ou só mais um hype. 🤔

0

0

![JohnYoung]() JohnYoung

JohnYoung

20 अप्रैल 2025 6:06:43 पूर्वाह्न IST

20 अप्रैल 2025 6:06:43 पूर्वाह्न IST

AI 스케일링 법칙에 대한 소식은 흥미롭지만, 전문가들이 회의적이라서 흥분하기 어려워. '재미있지만 너무 기대하지 마세요'라는 느낌이야. 실제로 어떻게 될지 지켜봐야겠네. 🤔

0

0

![HaroldMoore]() HaroldMoore

HaroldMoore

17 अप्रैल 2025 4:54:24 अपराह्न IST

17 अप्रैल 2025 4:54:24 अपराह्न IST

AIのスケーリングブレイクスルーは面白そうだけど、専門家は懐疑的。🤔 もう何を信じればいいのかわからない。ただの誇大広告かも?注目はするけど、期待はしないよ。😴

0

0

![AlbertLee]() AlbertLee

AlbertLee

16 अप्रैल 2025 8:55:29 अपराह्न IST

16 अप्रैल 2025 8:55:29 अपराह्न IST

El avance en la escala de IA suena genial, pero todavía no lo compro. Es todo un hype en las redes sociales, pero los expertos son escépticos. Esperaré más pruebas sólidas antes de subirme al carro. 🤔

0

0

सोशल मीडिया पर कुछ चर्चा हुई है कि शोधकर्ताओं ने एक नया AI "स्केलिंग लॉ" खोजा है, लेकिन विशेषज्ञ इसे संदेह के साथ ले रहे हैं। AI स्केलिंग लॉ, जो अधिकतर अनौपचारिक दिशानिर्देशों की तरह हैं, दिखाते हैं कि AI मॉडल अधिक डेटा और कम्प्यूटिंग शक्ति देने पर बेहतर होते हैं। लगभग एक साल पहले तक, बड़ा रुझान "प्री-ट्रेनिंग" के बारे में था – यानी, बड़े मॉडलों को बड़े डेटासेट पर प्रशिक्षित करना। यह अभी भी प्रचलित है, लेकिन अब हमारे पास दो और स्केलिंग लॉ हैं: पोस्ट-ट्रेनिंग स्केलिंग, जो मॉडल के व्यवहार को ठीक करने के बारे में है, और टेस्ट-टाइम स्केलिंग, जिसमें अनुमान के दौरान अधिक कम्प्यूटिंग शक्ति का उपयोग करके मॉडल की "रीजनिंग" क्षमताओं को बढ़ाया जाता है (जैसे R1 मॉडल)।

हाल ही में, Google और UC Berkeley के शोधकर्ताओं ने एक पेपर प्रकाशित किया, जिसे कुछ लोग ऑनलाइन चौथा लॉ कह रहे हैं: "इन्फरेंस-टाइम सर्च।" इस विधि में मॉडल एक सवाल के लिए कई संभावित जवाब एक साथ देता है और फिर सबसे अच्छा चुनता है। शोधकर्ताओं का दावा है कि यह किसी पुराने मॉडल, जैसे Google का Gemini 1.5 Pro, के प्रदर्शन को बढ़ाकर OpenAI के o1-preview "रीजनिंग" मॉडल को विज्ञान और गणित बेंचमार्क में हरा सकता है।

एरिक झाओ, Google के डॉक्टरेट फेलो और पेपर के सह-लेखकों में से एक, ने X पर साझा किया कि 200 जवाबों को रैंडमली सैंपल करके और मॉडल को स्वयं-जांच करने देकर, Gemini 1.5 – जिसे उन्होंने मजाक में "प्राचीन 2024 की शुरुआत का मॉडल" कहा – o1-preview को मात दे सकता है और o1 के करीब भी पहुंच सकता है। उन्होंने बताया कि स्वयं-जांच स्केल बढ़ाने पर आसान हो जाती है, जो थोड़ा उल्टा लेकिन रोचक है।

लेकिन हर कोई सहमत नहीं है। मैथ्यू गुज़डियाल, एक AI शोधकर्ता और यूनिवर्सिटी ऑफ अल्बर्टा में सहायक प्रोफेसर, ने TechCrunch को बताया कि यह दृष्टिकोण तब सबसे अच्छा काम करता है जब आपके पास जवाबों को आंकने का ठोस तरीका हो। ज्यादातर सवाल इतने सीधे नहीं होते। उन्होंने कहा, "अगर हम यह परिभाषित करने के लिए कोड नहीं लिख सकते कि हम क्या चाहते हैं, तो हम [इन्फरेंस-टाइम] सर्च का उपयोग नहीं कर सकते। सामान्य भाषा संवाद के लिए, हम यह नहीं कर सकते... यह आमतौर पर ज्यादातर समस्याओं को हल करने का अच्छा तरीका नहीं है।"

झाओ ने जवाब दिया कि उनका पेपर उन मामलों को देखता है जहां जवाबों को आंकने का स्पष्ट तरीका नहीं है, और मॉडल को खुद ही इसका पता लगाना पड़ता है। उन्होंने तर्क दिया कि स्पष्ट आंकने के तरीके और इसके अभाव के बीच का अंतर स्केल बढ़ाने पर कम हो सकता है।

माइक कुक, किंग्स कॉलेज लंदन में रिसर्च फेलो, ने गुज़डियाल के विचार का समर्थन किया, यह कहते हुए कि इन्फरेंस-टाइम सर्च वास्तव में मॉडल की रीजनिंग को बेहतर नहीं बनाता। यह मॉडल की आत्मविश्वास के साथ गलतियां करने की प्रवृत्ति का एक समाधान है। उन्होंने बताया कि अगर आपका मॉडल 5% बार गलती करता है, तो 200 कोशिशों की जांच करने से उन गलतियों को पकड़ना आसान हो जाता है।

यह खबर AI उद्योग के लिए थोड़ी निराशाजनक हो सकती है, जो हमेशा मॉडल की "रीजनिंग" को बढ़ाने के तरीकों की तलाश में रहता है बिना ज्यादा खर्च किए। जैसा कि पेपर के लेखकों ने उल्लेख किया, रीजनिंग मॉडल एक गणित समस्या को हल करने के लिए हजारों डॉलर की कम्प्यूटिंग लागत जमा कर सकते हैं।

नए स्केलिंग तकनीकों की खोज अभी खत्म नहीं हुई है।

अपडेट 3/20 5:12 सुबह प्रशांत: अध्ययन के सह-लेखक एरिक झाओ के टिप्पणियां जोड़ी गईं, जो एक स्वतंत्र शोधकर्ता द्वारा की गई आलोचना पर आपत्ति जताते हैं।

Microsoft Study Reveals AI Models' Limitations in Software Debugging

OpenAI, Anthropic और अन्य प्रमुख AI लैब्स के AI मॉडल कोडिंग कार्यों के लिए तेजी से उपयोग किए जा रहे हैं। Google CEO Sundar Pichai ने अक्टूबर में नोट किया कि AI कंपनी में 25% नए कोड जनरेट करता है, जबकि

Microsoft Study Reveals AI Models' Limitations in Software Debugging

OpenAI, Anthropic और अन्य प्रमुख AI लैब्स के AI मॉडल कोडिंग कार्यों के लिए तेजी से उपयोग किए जा रहे हैं। Google CEO Sundar Pichai ने अक्टूबर में नोट किया कि AI कंपनी में 25% नए कोड जनरेट करता है, जबकि

नई अध्ययन से पता चलता है कि LLM वास्तव में कितना डेटा याद करते हैं

AI मॉडल वास्तव में कितना याद करते हैं? नया शोध आश्चर्यजनक जानकारी देता हैहम सभी जानते हैं कि बड़े भाषा मॉडल (LLM) जैसे ChatGPT, Claude, और Gemini को किताबों, वेबसाइटों, कोड और यहां तक कि चित्रों और ऑड

नई अध्ययन से पता चलता है कि LLM वास्तव में कितना डेटा याद करते हैं

AI मॉडल वास्तव में कितना याद करते हैं? नया शोध आश्चर्यजनक जानकारी देता हैहम सभी जानते हैं कि बड़े भाषा मॉडल (LLM) जैसे ChatGPT, Claude, और Gemini को किताबों, वेबसाइटों, कोड और यहां तक कि चित्रों और ऑड

24 अप्रैल 2025 5:19:41 पूर्वाह्न IST

24 अप्रैल 2025 5:19:41 पूर्वाह्न IST

AI 스케일링 돌파구는 멋지게 들리지만, 전문가들은 회의적이에요. 🤔 이제 뭘 믿어야 할지 모르겠어요. 그냥 과대광고일까요? 지켜볼게요, 하지만 기대는 하지 않을게요. 😴

0

0

23 अप्रैल 2025 11:42:49 अपराह्न IST

23 अप्रैल 2025 11:42:49 अपराह्न IST

This AI scaling law thing sounds cool, but it's hard to get excited when experts are so skeptical. It's like they're saying, 'Sure, it's interesting, but let's not get carried away.' I guess we'll see if it's the real deal or just another hype train. 🤔

0

0

22 अप्रैल 2025 1:01:56 पूर्वाह्न IST

22 अप्रैल 2025 1:01:56 पूर्वाह्न IST

Essa história de lei de escalabilidade de IA parece legal, mas é difícil se empolgar quando os especialistas são tão céticos. Parece que eles estão dizendo, 'Sim, é interessante, mas não vamos nos empolgar muito'. Vamos ver se é verdade ou só mais um hype. 🤔

0

0

20 अप्रैल 2025 6:06:43 पूर्वाह्न IST

20 अप्रैल 2025 6:06:43 पूर्वाह्न IST

AI 스케일링 법칙에 대한 소식은 흥미롭지만, 전문가들이 회의적이라서 흥분하기 어려워. '재미있지만 너무 기대하지 마세요'라는 느낌이야. 실제로 어떻게 될지 지켜봐야겠네. 🤔

0

0

17 अप्रैल 2025 4:54:24 अपराह्न IST

17 अप्रैल 2025 4:54:24 अपराह्न IST

AIのスケーリングブレイクスルーは面白そうだけど、専門家は懐疑的。🤔 もう何を信じればいいのかわからない。ただの誇大広告かも?注目はするけど、期待はしないよ。😴

0

0

16 अप्रैल 2025 8:55:29 अपराह्न IST

16 अप्रैल 2025 8:55:29 अपराह्न IST

El avance en la escala de IA suena genial, pero todavía no lo compro. Es todo un hype en las redes sociales, pero los expertos son escépticos. Esperaré más pruebas sólidas antes de subirme al carro. 🤔

0

0