AI的认知能力测试了:机器可以匹配人类智能吗?

人工智能通过人类认知测试的挑战

人工智能(AI)已取得显著进步,从自动驾驶汽车到辅助医疗诊断。然而,一个问题依然存在:*人工智能能通过为人类设计的认知测试吗?* 尽管人工智能在语言处理和问题解决方面表现出色,但它仍难以应对人类思维的复杂网络。

以ChatGPT等人工智能模型为例。它们能轻松生成文本和解决问题,但在蒙特利尔认知评估(MoCA)等旨在衡量人类智力的认知测试中表现不佳。人工智能的技术能力与其认知短板之间的差距凸显了其发展中的重大障碍。

人工智能可能擅长某些任务,但它难以模仿人类认知的全部范围,特别是在需要抽象推理、情感理解和语境感知的领域。

理解认知测试及其在人工智能评估中的作用

蒙特利尔认知评估(MoCA)等认知测试对于评估人类智力的各个方面至关重要,包括记忆、推理、问题解决和空间感知。这些测试常用于临床环境中诊断阿尔茨海默病和痴呆等疾病,揭示不同条件下的大脑功能。单词回忆、画钟和模式识别等任务评估大脑处理复杂场景的能力——这些技能对日常生活至关重要。

然而,当这些测试应用于人工智能时,结果截然不同。ChatGPT或Google的Gemini等人工智能模型可能在模式识别和文本生成方面表现出色,但它们在更深层次的认知方面存在困难。例如,尽管人工智能能遵循明确指令完成任务,但它在抽象推理、情感解读或语境应用——人类思维的核心组成部分——方面常常失败。

因此,认知测试在评估人工智能时具有双重作用。它们突显了人工智能在数据处理和解决结构化问题方面的优势,同时也揭示了人工智能在模仿人类全部认知功能方面的重大差距,特别是在涉及复杂决策、情感智力和语境感知的领域。

随着人工智能在医疗和自动驾驶系统等领域的日益融合,其处理超越简单任务的能力至关重要。认知测试为评估人工智能是否能胜任需要抽象推理和情感理解的任务提供了标尺,这些品质是人类智力的核心。在医疗领域,人工智能可以分析医疗数据并预测疾病,但无法提供情感支持或根据患者独特情况作出细致决策。类似地,在自动驾驶车辆中,解读不可预测场景通常需要类人直觉,这是当前人工智能模型所缺乏的。

通过使用为人类设计的认知测试,研究人员可以确定人工智能需要改进的领域,并开发更复杂的系统。这些评估还有助于设定人工智能能力的现实期望,并强调在某些领域人类参与的必要性。

人工智能在认知测试中的局限性

人工智能模型在数据处理和模式识别方面取得了令人瞩目的进步,但在需要抽象推理、空间感知和情感理解的任务中面临显著局限。近期一项使用蒙特利尔认知评估(MoCA)测试多种人工智能系统的研究揭示了人工智能在结构化任务上的熟练与更复杂认知功能上的困难之间的明显分歧。

在该研究中,ChatGPT 4o得分26/30,表明轻度认知障碍,而Google的Gemini仅得16/30,反映出严重认知障碍。人工智能面临的最大挑战之一是视觉空间任务,如画钟或复制几何形状。这些任务需要理解空间关系和组织视觉信息,是人类直觉擅长的领域。尽管接收到明确指令,人工智能模型仍难以准确完成这些任务。

人类认知无缝整合感官输入、记忆和情感,实现适应性决策。人类在解决问题时依靠直觉、创造力和语境,尤其是在模糊情境中。抽象思考和在决策中使用情感智力的能力是人类认知的关键特征,使个体能够应对复杂和动态的场景。

相比之下,人工智能通过算法和统计模式处理数据。虽然它能根据学习到的模式生成响应,但无法真正理解数据的语境或意义。这种理解的缺失使得人工智能难以完成需要抽象思维或情感理解的任务,这些是认知测试的基本要求。

有趣的是,人工智能模型在认知测试中的局限与阿尔茨海默病等神经退行性疾病中的认知障碍有相似之处。在研究中,当询问人工智能关于空间感知的问题时,其响应过于简单且依赖语境,类似于认知衰退个体的表现。这些发现强调,尽管人工智能在处理结构化数据和预测方面表现出色,但它缺乏更细致决策所需的理解深度。这种局限在医疗和自动驾驶系统中尤为令人担忧,因为这些领域需要判断和推理能力。

尽管存在这些局限,人工智能仍有改进潜力。较新版本的人工智能模型,如ChatGPT 4o,在推理和决策任务中显示出进步。然而,要复制类人认知仍需人工智能设计上的进步,可能通过量子计算或更高级的神经网络实现。

人工智能在复杂认知功能上的挣扎

尽管技术进步,人工智能仍远未通过为人类设计的认知测试。虽然人工智能在解决结构化问题方面表现出色,但在更细致的认知功能上表现不足。

例如,人工智能模型常在绘制几何形状或解读空间数据等任务中遇到困难。人类自然理解并组织视觉信息,而人工智能难以有效匹配这一能力。这凸显了一个根本问题:人工智能的数据处理能力并不等同于人类思维的理解能力。

人工智能局限的核心在于其基于算法的本质。人工智能模型通过识别数据中的模式运行,但缺乏人类用于决策的语境感知和情感智力。虽然人工智能能根据训练高效生成输出,但它无法像人类那样理解这些输出的意义。这种无法进行抽象思考和缺乏同理心的问题,使人工智能难以完成需要更深层认知功能的任务。

医疗领域中这一差距尤为明显。人工智能可协助分析医疗扫描或预测疾病,但无法在涉及患者独特情况的复杂决策中替代人类判断。类似地,在自动驾驶系统中,人工智能可处理大量数据以检测障碍物,但无法复制人类在意外情况下作出瞬时决策的直觉。

尽管面临这些挑战,人工智能显示出改进潜力。较新的人工智能模型开始处理涉及推理和基本决策的更高级任务。然而,即便这些模型进步,它们仍远未匹配通过为人类设计的认知测试所需的广泛人类认知能力。

结论

总之,人工智能在许多领域取得了令人瞩目的进步,但要通过为人类设计的认知测试仍有很长的路要走。虽然它能处理数据处理和问题解决等任务,但人工智能在需要抽象思考、同理心和语境理解的任务上表现不佳。

尽管有所改进,人工智能在空间感知和决策等任务上仍面临困难。虽然人工智能展现了未来潜力,尤其是随着技术进步,但它远未复制人类认知。

相关文章

苹果可能推迟下一代 iPhone 上市时间,以发布可折叠机型

据The Information 报道,苹果公司正准备对其 2026 年的 iPhone 发布日程进行重大调整,在推出新计划的 "Air "机型的同时,还将推出该公司的首款可折叠 iPhone。据报道,这一战略转变将标准的 iPhone 18 发布时间从传统的秋季推迟到了 2027 年春季,届时它将与更新的 iPhone 16E 变体同时亮相。重组的目的是精简 iPhone 的六款机型组合,尤其是

苹果可能推迟下一代 iPhone 上市时间,以发布可折叠机型

据The Information 报道,苹果公司正准备对其 2026 年的 iPhone 发布日程进行重大调整,在推出新计划的 "Air "机型的同时,还将推出该公司的首款可折叠 iPhone。据报道,这一战略转变将标准的 iPhone 18 发布时间从传统的秋季推迟到了 2027 年春季,届时它将与更新的 iPhone 16E 变体同时亮相。重组的目的是精简 iPhone 的六款机型组合,尤其是

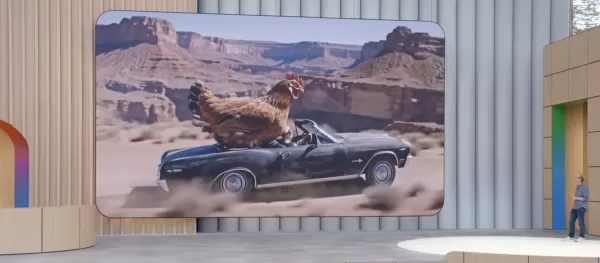

Veo 3 采用人工智能技术生成视频和配乐

以下是根据您的指导原则重新编写的 HTML 内容:谷歌推出 Veo 3:带有同步音频的人工智能视频生成技术谷歌在 2025 年 I/O 大会上推出了 Veo 3,标志着人工智能视频生成技术的重大进步。最新的迭代版本增加了同步音频生成功能,包括对话、音效和环境噪音,以补充其视觉输出。新一代视频创作与 Veo 2 相比,升级版在输出质量和能力方面都有了显著提高。谷歌 DeepMind 首席执行官 De

Veo 3 采用人工智能技术生成视频和配乐

以下是根据您的指导原则重新编写的 HTML 内容:谷歌推出 Veo 3:带有同步音频的人工智能视频生成技术谷歌在 2025 年 I/O 大会上推出了 Veo 3,标志着人工智能视频生成技术的重大进步。最新的迭代版本增加了同步音频生成功能,包括对话、音效和环境噪音,以补充其视觉输出。新一代视频创作与 Veo 2 相比,升级版在输出质量和能力方面都有了显著提高。谷歌 DeepMind 首席执行官 De

Instagram 更新包括转贴 Feed 和 Snap 地图启发功能

Instagram 推出受竞争对手启发的更新,同时完善有争议的功能Instagram 平台正在推出借鉴竞争对手服务的多项创新,同时加强了 2024 年早些时候推出的一项极具争议性的功能。分享内容的新方式用户现在获得了更强的分享功能,可以在不同账户间转发公共 Reels 和标准 feed 帖子。与 TikTok 的功能类似,这些共享项目将显示在专用的个人资料部分,并发布到关注者的 feed 中。这是

评论 (7)

0/200

Instagram 更新包括转贴 Feed 和 Snap 地图启发功能

Instagram 推出受竞争对手启发的更新,同时完善有争议的功能Instagram 平台正在推出借鉴竞争对手服务的多项创新,同时加强了 2024 年早些时候推出的一项极具争议性的功能。分享内容的新方式用户现在获得了更强的分享功能,可以在不同账户间转发公共 Reels 和标准 feed 帖子。与 TikTok 的功能类似,这些共享项目将显示在专用的个人资料部分,并发布到关注者的 feed 中。这是

评论 (7)

0/200

![LarryMartin]() LarryMartin

LarryMartin

2025-09-09 12:30:38

2025-09-09 12:30:38

생각보다 AI의 인지 테스트 결과가 흥미롭네요. 인간 수준에 도달한 영역도 있지만 여전히 한계가 명확하더라구요. 의료 진단 같은 분야서는 이미 인간을 뛰어넘는 성과를 보이는데, 창의력이나 공감 능력은 아직 부족한 것 같아요. 🤔

0

0

![MatthewCarter]() MatthewCarter

MatthewCarter

2025-08-22 15:01:18

2025-08-22 15:01:18

AI matching human intelligence? Wild! It's like teaching a robot to dream. But can it really get human quirks right? 🤔

0

0

![SebastianAnderson]() SebastianAnderson

SebastianAnderson

2025-04-28 22:07:47

2025-04-28 22:07:47

El artículo sobre las capacidades cognitivas de la IA es intrigante, pero me dejó con más preguntas que respuestas. Es genial ver a la IA enfrentando pruebas humanas, pero los ejemplos parecieron un poco demasiado básicos. ¡Quiero ver a la IA desafiada con tareas cognitivas más complejas! Aún así, es un buen comienzo. 🤔

0

0

![GaryWilson]() GaryWilson

GaryWilson

2025-04-28 21:05:02

2025-04-28 21:05:02

AI의 인지 능력에 관한 기사는 흥미롭지만, 질문이 더 많아졌어요. AI가 인간의 테스트에 도전하는 건 멋지지만, 예시들이 너무 기본적인 느낌이 들었어요. 더 복잡한 인지 과제에 AI를 도전させ고 싶어요! 그래도 좋은 시작이라고 생각해요. 🤔

0

0

![EricJohnson]() EricJohnson

EricJohnson

2025-04-28 07:12:16

2025-04-28 07:12:16

AIの認知能力に関する記事は興味深いですが、質問が増えるばかりでした。AIが人間のテストに挑戦するのはクールですが、例が少し基本的すぎると感じました。もっと複雑な認知タスクにAIを挑戦させてほしいです!それでも良いスタートだと思います。🤔

0

0

![LawrenceGarcía]() LawrenceGarcía

LawrenceGarcía

2025-04-27 15:05:40

2025-04-27 15:05:40

The article on AI's cognitive capabilities is intriguing but left me with more questions than answers. It's cool to see AI tackling human tests, but the examples felt a bit too basic. I want to see AI challenged with more complex cognitive tasks! Still, it's a good start. 🤔

0

0

人工智能通过人类认知测试的挑战

人工智能(AI)已取得显著进步,从自动驾驶汽车到辅助医疗诊断。然而,一个问题依然存在:*人工智能能通过为人类设计的认知测试吗?* 尽管人工智能在语言处理和问题解决方面表现出色,但它仍难以应对人类思维的复杂网络。

以ChatGPT等人工智能模型为例。它们能轻松生成文本和解决问题,但在蒙特利尔认知评估(MoCA)等旨在衡量人类智力的认知测试中表现不佳。人工智能的技术能力与其认知短板之间的差距凸显了其发展中的重大障碍。

人工智能可能擅长某些任务,但它难以模仿人类认知的全部范围,特别是在需要抽象推理、情感理解和语境感知的领域。

理解认知测试及其在人工智能评估中的作用

蒙特利尔认知评估(MoCA)等认知测试对于评估人类智力的各个方面至关重要,包括记忆、推理、问题解决和空间感知。这些测试常用于临床环境中诊断阿尔茨海默病和痴呆等疾病,揭示不同条件下的大脑功能。单词回忆、画钟和模式识别等任务评估大脑处理复杂场景的能力——这些技能对日常生活至关重要。

然而,当这些测试应用于人工智能时,结果截然不同。ChatGPT或Google的Gemini等人工智能模型可能在模式识别和文本生成方面表现出色,但它们在更深层次的认知方面存在困难。例如,尽管人工智能能遵循明确指令完成任务,但它在抽象推理、情感解读或语境应用——人类思维的核心组成部分——方面常常失败。

因此,认知测试在评估人工智能时具有双重作用。它们突显了人工智能在数据处理和解决结构化问题方面的优势,同时也揭示了人工智能在模仿人类全部认知功能方面的重大差距,特别是在涉及复杂决策、情感智力和语境感知的领域。

随着人工智能在医疗和自动驾驶系统等领域的日益融合,其处理超越简单任务的能力至关重要。认知测试为评估人工智能是否能胜任需要抽象推理和情感理解的任务提供了标尺,这些品质是人类智力的核心。在医疗领域,人工智能可以分析医疗数据并预测疾病,但无法提供情感支持或根据患者独特情况作出细致决策。类似地,在自动驾驶车辆中,解读不可预测场景通常需要类人直觉,这是当前人工智能模型所缺乏的。

通过使用为人类设计的认知测试,研究人员可以确定人工智能需要改进的领域,并开发更复杂的系统。这些评估还有助于设定人工智能能力的现实期望,并强调在某些领域人类参与的必要性。

人工智能在认知测试中的局限性

人工智能模型在数据处理和模式识别方面取得了令人瞩目的进步,但在需要抽象推理、空间感知和情感理解的任务中面临显著局限。近期一项使用蒙特利尔认知评估(MoCA)测试多种人工智能系统的研究揭示了人工智能在结构化任务上的熟练与更复杂认知功能上的困难之间的明显分歧。

在该研究中,ChatGPT 4o得分26/30,表明轻度认知障碍,而Google的Gemini仅得16/30,反映出严重认知障碍。人工智能面临的最大挑战之一是视觉空间任务,如画钟或复制几何形状。这些任务需要理解空间关系和组织视觉信息,是人类直觉擅长的领域。尽管接收到明确指令,人工智能模型仍难以准确完成这些任务。

人类认知无缝整合感官输入、记忆和情感,实现适应性决策。人类在解决问题时依靠直觉、创造力和语境,尤其是在模糊情境中。抽象思考和在决策中使用情感智力的能力是人类认知的关键特征,使个体能够应对复杂和动态的场景。

相比之下,人工智能通过算法和统计模式处理数据。虽然它能根据学习到的模式生成响应,但无法真正理解数据的语境或意义。这种理解的缺失使得人工智能难以完成需要抽象思维或情感理解的任务,这些是认知测试的基本要求。

有趣的是,人工智能模型在认知测试中的局限与阿尔茨海默病等神经退行性疾病中的认知障碍有相似之处。在研究中,当询问人工智能关于空间感知的问题时,其响应过于简单且依赖语境,类似于认知衰退个体的表现。这些发现强调,尽管人工智能在处理结构化数据和预测方面表现出色,但它缺乏更细致决策所需的理解深度。这种局限在医疗和自动驾驶系统中尤为令人担忧,因为这些领域需要判断和推理能力。

尽管存在这些局限,人工智能仍有改进潜力。较新版本的人工智能模型,如ChatGPT 4o,在推理和决策任务中显示出进步。然而,要复制类人认知仍需人工智能设计上的进步,可能通过量子计算或更高级的神经网络实现。

人工智能在复杂认知功能上的挣扎

尽管技术进步,人工智能仍远未通过为人类设计的认知测试。虽然人工智能在解决结构化问题方面表现出色,但在更细致的认知功能上表现不足。

例如,人工智能模型常在绘制几何形状或解读空间数据等任务中遇到困难。人类自然理解并组织视觉信息,而人工智能难以有效匹配这一能力。这凸显了一个根本问题:人工智能的数据处理能力并不等同于人类思维的理解能力。

人工智能局限的核心在于其基于算法的本质。人工智能模型通过识别数据中的模式运行,但缺乏人类用于决策的语境感知和情感智力。虽然人工智能能根据训练高效生成输出,但它无法像人类那样理解这些输出的意义。这种无法进行抽象思考和缺乏同理心的问题,使人工智能难以完成需要更深层认知功能的任务。

医疗领域中这一差距尤为明显。人工智能可协助分析医疗扫描或预测疾病,但无法在涉及患者独特情况的复杂决策中替代人类判断。类似地,在自动驾驶系统中,人工智能可处理大量数据以检测障碍物,但无法复制人类在意外情况下作出瞬时决策的直觉。

尽管面临这些挑战,人工智能显示出改进潜力。较新的人工智能模型开始处理涉及推理和基本决策的更高级任务。然而,即便这些模型进步,它们仍远未匹配通过为人类设计的认知测试所需的广泛人类认知能力。

结论

总之,人工智能在许多领域取得了令人瞩目的进步,但要通过为人类设计的认知测试仍有很长的路要走。虽然它能处理数据处理和问题解决等任务,但人工智能在需要抽象思考、同理心和语境理解的任务上表现不佳。

尽管有所改进,人工智能在空间感知和决策等任务上仍面临困难。虽然人工智能展现了未来潜力,尤其是随着技术进步,但它远未复制人类认知。

苹果可能推迟下一代 iPhone 上市时间,以发布可折叠机型

据The Information 报道,苹果公司正准备对其 2026 年的 iPhone 发布日程进行重大调整,在推出新计划的 "Air "机型的同时,还将推出该公司的首款可折叠 iPhone。据报道,这一战略转变将标准的 iPhone 18 发布时间从传统的秋季推迟到了 2027 年春季,届时它将与更新的 iPhone 16E 变体同时亮相。重组的目的是精简 iPhone 的六款机型组合,尤其是

苹果可能推迟下一代 iPhone 上市时间,以发布可折叠机型

据The Information 报道,苹果公司正准备对其 2026 年的 iPhone 发布日程进行重大调整,在推出新计划的 "Air "机型的同时,还将推出该公司的首款可折叠 iPhone。据报道,这一战略转变将标准的 iPhone 18 发布时间从传统的秋季推迟到了 2027 年春季,届时它将与更新的 iPhone 16E 变体同时亮相。重组的目的是精简 iPhone 的六款机型组合,尤其是

Veo 3 采用人工智能技术生成视频和配乐

以下是根据您的指导原则重新编写的 HTML 内容:谷歌推出 Veo 3:带有同步音频的人工智能视频生成技术谷歌在 2025 年 I/O 大会上推出了 Veo 3,标志着人工智能视频生成技术的重大进步。最新的迭代版本增加了同步音频生成功能,包括对话、音效和环境噪音,以补充其视觉输出。新一代视频创作与 Veo 2 相比,升级版在输出质量和能力方面都有了显著提高。谷歌 DeepMind 首席执行官 De

Veo 3 采用人工智能技术生成视频和配乐

以下是根据您的指导原则重新编写的 HTML 内容:谷歌推出 Veo 3:带有同步音频的人工智能视频生成技术谷歌在 2025 年 I/O 大会上推出了 Veo 3,标志着人工智能视频生成技术的重大进步。最新的迭代版本增加了同步音频生成功能,包括对话、音效和环境噪音,以补充其视觉输出。新一代视频创作与 Veo 2 相比,升级版在输出质量和能力方面都有了显著提高。谷歌 DeepMind 首席执行官 De

Instagram 更新包括转贴 Feed 和 Snap 地图启发功能

Instagram 推出受竞争对手启发的更新,同时完善有争议的功能Instagram 平台正在推出借鉴竞争对手服务的多项创新,同时加强了 2024 年早些时候推出的一项极具争议性的功能。分享内容的新方式用户现在获得了更强的分享功能,可以在不同账户间转发公共 Reels 和标准 feed 帖子。与 TikTok 的功能类似,这些共享项目将显示在专用的个人资料部分,并发布到关注者的 feed 中。这是

Instagram 更新包括转贴 Feed 和 Snap 地图启发功能

Instagram 推出受竞争对手启发的更新,同时完善有争议的功能Instagram 平台正在推出借鉴竞争对手服务的多项创新,同时加强了 2024 年早些时候推出的一项极具争议性的功能。分享内容的新方式用户现在获得了更强的分享功能,可以在不同账户间转发公共 Reels 和标准 feed 帖子。与 TikTok 的功能类似,这些共享项目将显示在专用的个人资料部分,并发布到关注者的 feed 中。这是

2025-09-09 12:30:38

2025-09-09 12:30:38

생각보다 AI의 인지 테스트 결과가 흥미롭네요. 인간 수준에 도달한 영역도 있지만 여전히 한계가 명확하더라구요. 의료 진단 같은 분야서는 이미 인간을 뛰어넘는 성과를 보이는데, 창의력이나 공감 능력은 아직 부족한 것 같아요. 🤔

0

0

2025-08-22 15:01:18

2025-08-22 15:01:18

AI matching human intelligence? Wild! It's like teaching a robot to dream. But can it really get human quirks right? 🤔

0

0

2025-04-28 22:07:47

2025-04-28 22:07:47

El artículo sobre las capacidades cognitivas de la IA es intrigante, pero me dejó con más preguntas que respuestas. Es genial ver a la IA enfrentando pruebas humanas, pero los ejemplos parecieron un poco demasiado básicos. ¡Quiero ver a la IA desafiada con tareas cognitivas más complejas! Aún así, es un buen comienzo. 🤔

0

0

2025-04-28 21:05:02

2025-04-28 21:05:02

AI의 인지 능력에 관한 기사는 흥미롭지만, 질문이 더 많아졌어요. AI가 인간의 테스트에 도전하는 건 멋지지만, 예시들이 너무 기본적인 느낌이 들었어요. 더 복잡한 인지 과제에 AI를 도전させ고 싶어요! 그래도 좋은 시작이라고 생각해요. 🤔

0

0

2025-04-28 07:12:16

2025-04-28 07:12:16

AIの認知能力に関する記事は興味深いですが、質問が増えるばかりでした。AIが人間のテストに挑戦するのはクールですが、例が少し基本的すぎると感じました。もっと複雑な認知タスクにAIを挑戦させてほしいです!それでも良いスタートだと思います。🤔

0

0

2025-04-27 15:05:40

2025-04-27 15:05:40

The article on AI's cognitive capabilities is intriguing but left me with more questions than answers. It's cool to see AI tackling human tests, but the examples felt a bit too basic. I want to see AI challenged with more complex cognitive tasks! Still, it's a good start. 🤔

0

0